Künstliche Intelligenz

Missing Link: Machtzentrale Palantir – eine Software lenkt Organisationen

Kaum ein Technologieunternehmen polarisiert so stark wie Palantir Technologies. Das 2003 gegründete US-Unternehmen hat sich vom geheimnisvollen Start-up mit CIA-Verbindungen zu einem börsennotierten Konzern entwickelt, der Regierungen und Großkonzerne weltweit beliefert. Palantir verspricht, aus den Daten moderner Organisationen verwertbare Erkenntnisse zu gewinnen. Während Befürworter die Software als revolutionäres Werkzeug für datenbasierte Entscheidungen preisen, warnen Kritiker vor Überwachung, Intransparenz und Vendor-Lock-in-Effekten. Doch was steckt technisch dahinter?

„Palantir ist keine Datenfirma, sondern eine Softwarefirma“ betont das US-Technologie-Unternehmen seit Jahren. Dabei will Palantir mit seiner Software die zentrale Infrastruktur zur Entscheidungsunterstützung für jede Organisation sein. Um das zu erreichen, müsse man „Ordnung ins Datenchaos“ bei den Kunden bringen und eine vernetzte Organisation schaffen. Das Geschäftsmodell von Palantir beruht auf Software-as-a-Service, zu den Lizenzkosten kommen Servicegebühren und Schulungskosten. Wer sich für Palantir entscheidet, macht sich abhängig und verlagert seine digitale Infrastruktur in ein proprietäres Ökosystem.

Der Einsatz von Palantir bedeutet nicht nur eine technische, sondern auch eine strukturelle Bindung der eigenen Organisation an das US-Unternehmen. Ein späterer Systemwechsel ist aufwendig. Zwar bietet Palantir zahlreiche Schnittstellen, um bestehende Systeme und Datenquellen zu integrieren, aber keine Möglichkeit das einmal aufgebaute System zu einem anderen Anbieter umzuziehen. Bestimmte Daten lassen sich exportieren, doch das eigentliche Kapital – die semantischen Strukturen, Logiken, Interaktionen – sind tief mit Palantirs System verknüpft und funktionieren nur dort. Im Zentrum der Architektur steht eine einheitliche Ontologie – ein formales Bedeutungsmodell, das festlegt, wie Daten der Organisation verstanden, verknüpft und operational nutzbar gemacht werden. Auf einem solchen System basierende datengetriebene Entscheidungen und Prozesse können die Arbeitsweise einer Organisation verändern.

Was fehlt: In der rapiden Technikwelt häufig die Zeit, die vielen News und Hintergründe neu zu sortieren. Am Wochenende wollen wir sie uns nehmen, die Seitenwege abseits des Aktuellen verfolgen, andere Blickwinkel probieren und Zwischentöne hörbar machen.

Palantir verändert Organisationen

Ob sich Palantir als bundesweite Interimslösung für die Polizei eignet und eingeführt werden soll, wie es der Bundesrat im März 2025 gefordert hat und sich einige Innenminister wünschen, erscheint fraglich. Inzwischen zeigt sich wachsender Widerstand gegen die US-Big-Data-Software für die Polizei und bei der Innenministerkonferenz (IMK) konnte keine Einigung für die bundesweite Einführung von Palantir erzielt werden. Stattdessen stellte die IMK in ihrem Beschluss vom 18. Juni 25 fest, „dass die Fähigkeit der automatisierten Datenanalyse als ein Schlüsselelement der künftigen digitalen Sicherheitsinfrastruktur hinsichtlich Verfügbarkeit, Vertraulichkeit, Integrität und ihrer Rechtskonformität keiner strukturellen Einflussmöglichkeit durch außereuropäische Staaten ausgesetzt sein darf“ und „vor diesem Hintergrund die Entwicklung einer digital souveränen Lösung anzustreben ist“.

Den Bundesländern steht es nach wie vor frei, (weiter) mit Palantir zusammenzuarbeiten. Baden-Württemberg plant bereits seit Längerem die Einführung einer Landes-VeRA und hat dafür nach Rücksprache mit Bayern 18,5 Millionen Euro an Haushaltsmittel für 2025/2026 veranschlagt. Auch Sachsen-Anhalt möchte Palantir einführen, berichtet der MDR.

Wie sich die Arbeitsweise mit Palantir ändert, zeigen die Erfahrungen bei der Landespolizei Hessen, die Palantir Gotham als „HessenData“ seit 2017 einsetzt. Jährlich werden mehrere Tausend Abfragen mit dem System durchgeführt, das von jedem Arbeitsplatz aus erreichbar ist. Als im Februar 2023 das Bundesverfassungsgericht die Regeln zur Datenanalyse bei der Polizei beanstandete, wurde dem Land Hessen eine Frist für die Gesetzesänderung eingeräumt, in der die Nutzung von HessenData unter Auflagen weiter erlaubt war. Hessen passte seine Rechtsgrundlage an, weshalb HessenData weiter in Betrieb ist. Das System sorge für mehr Effizienz und „eigentlich ist jede Nutzung im Alltag der Kollegen schon ein Riesenerfolg“, zitiert die SZ in einem aktuellen Beitrag eine Polizistin aus dem Innovation Hub 110, die für den Betrieb der Plattform verantwortlich ist. Palantir scheint fester Bestandteil der hessischen Ermittlungsarbeit zu sein und Hessen ist auch an einem Ausbau der Analysefähigkeiten mit KI interessiert. So nahmen Mitarbeiter des Innovation Hub 110 im Mai 2025 mit einer eigenen Live-Demo an einer AIP Expo von Palantir in München teil, wie sie auf LinkedIn mitteilten. Palantir veranstaltet solche AIP Expos als geschlossenes Networking-Event für Führungskräfte aus seinem Kundenstamm, um die Integration von KI in seine Produkte in der Praxis durch einzelne Kunden selbst vorführen zu lassen.

Um die dahinterliegende Systemarchitektur besser einordnen zu können, lohnt sich ein Blick auf die zentralen Palantir-Produkte – insbesondere auf die modular aufgebauten Plattformen Foundry und Gotham. Sie bilden die technische Grundlage für Anwendungen wie HessenData , DAR (NRW) oder VeRA (Bayern), die sich mittels AIP (Artificial Intelligence Platform) leicht mit KI-Funktionalitäten ergänzen lassen könnten.

Keine Datenplattform, sondern ein Betriebssystem

Die Hauptprodukte sind Palantir Foundry und Palantir Gotham, dazu kommen Palantir AIP und Palantir Apollo. Alle Produkte werden als „Plattformen“ beworben, wobei betont wird, dass sie keine Datenplattform, sondern eine modular aufgebaute Betriebsplattform sind, und als OS dienen sollen.

Foundry wird als „Ontologie-basierte Betriebssystem für das moderne Unternehmen“ beworben; während der Slogan „Deine Software ist das Waffensystem“ für Gotham als „Betriebssystem für die globale Entscheidungsfindung“ bei Behörden und Organisationen im Sicherheitsbereich wirbt.

Das Betriebssystem setzt sich in seiner Basis aus dem „Palantir Data Store“ als physische/technische Ebene der Speicherstruktur für Roh- und Transformationsdaten und der Ontologie als logischer Bedeutungsebene für die Daten zusammen. Der „Palantir Data Store“ ist Bestandteil von Foundry. In Foundry erfolgt die Datenintegration, -modellierung und -analyse.

Von 100 fragmentierten zu einem Palantir-System

Die Ontologie ist als zentrales Struktur- und Organisationsprinzip das Herzstück des Palantir-Systems, das zum semantischen Rückgrat der das System nutzenden Organisation wird.

Eine Ontologie ist ein formales Modell, das Konzepte, Entitäten und ihre Eigenschaften und Beziehungen zueinander einheitlich und strukturiert beschreibt.

So wird eine gemeinsame Bedeutungswelt in einem zentralen System geschaffen, in dem Daten quer über Systeme hinweg aus unterschiedlichsten Quellen und Formaten zusammenfließen, vereinheitlicht, kontextualisiert und analysierbar werden.

Über heterogene IT-Systemlandschaften einer Organisation und ihrer Daten hinweg wird mit der Ontologie eine gemeinsame Sprache als semantische Zwischenebene (Semantic Layer) geschaffen. Und diese Sprache kann auch in der Zusammenarbeit mit anderen Organisationen genutzt werden, wenn sie dieselbe Ontologie nutzen.

Mit Palantirs Ontologie wird ein digitaler Zwilling einer Organisation erstellt. Daten, Prozesse, Regeln und Nutzerinteraktionen werden in einem einheitlichen Modell strukturiert zentral zusammengeführt – dieses Wissen lässt sich maschinell verarbeiten, durchsuchen und logisch verknüpfen. Es lassen sich nicht nur Zusammenhänge verstehen und Rückschlüsse ziehen, sondern auch steuerbare Aktionen durchführen.

Diese Ontologie ist vollständig anpassbar und erweiterbar – sie bildet die Struktur, auf der alle Analysen, Datenflüsse und Benutzeroberflächen in Palantir-Produkten aufbauen. Über die Ontologie wird bestimmt, was sichtbar wird, was verknüpft wird, was als relevant gilt.

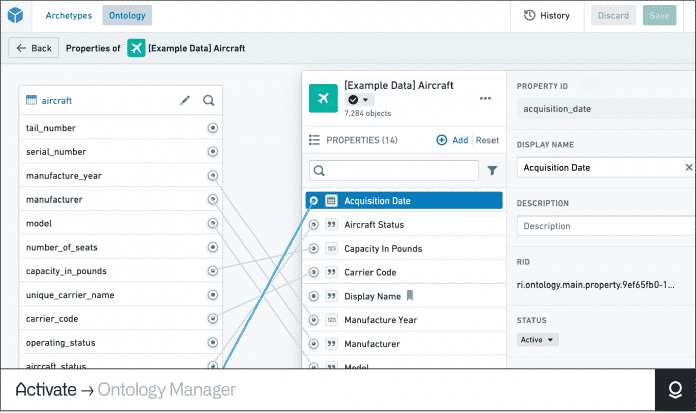

Im „Ontology Manager“ definiert man Entitäten – im Beispiel ein Passagierflugzeug – und weist ihnen Eigenschaften zu. Die Ontologie verknüpft diese mit (Echtzeit-)Daten, Prozessen, Regeln und führt sie in einem einheitlichen Modell strukturiert zentral zusammen.

(Bild: Screenshot/Palantir)

Die Kern-Komponenten der Palantir-Ontologie

- Object Types – definieren Entitäten wie zum Beispiel „Person“, „Sache“, „Ereignis“, „Vorfall“, „Produktionslinie“, „Konzept“

- Properties – beschreiben Eigenschaften/Attribute dieser Entitäten, etwa „Name“, „Kennzeichen“, „Ort“, „Datum“, „Zeitstempel“

- Shared Properties – beschreibt eine Eigenschaft, die auf mehreren Objekttypen verwendet wird, so lassen sich Eigenschaftsmetadaten zentral verwalten

- Link Types – repräsentieren Beziehungen zwischen Entitäten, zum Beispiel „enthält“, „war bei“, „kennt“, „verwendet“, „wohnt“, „Fahrer“, „Mitfahrer“, „ist Mitglied bei“, „Zeuge“, „Beschuldigter“, „Tatverdächtiger“

- Action Types – ermöglicht Änderungen an den Entitäten, ihren Eigenschaften und Beziehungen. Dabei können nach Durchführung der Aktion auch (automatisiert) weitere Aktionen folgen, die in den jeweiligen Aktions-Schemata hinterlegt sind.

- Functions – ermöglichen die Interaktion mit den Entitäten in Form von Logiken, die ausgeführt werden

- Object Views – Darstellung von Informationen und Arbeitsabläufen, die sich auf ein bestimmtes Objekt beziehen, es könnte etwa ein Steckbrief angezeigt werden oder eine detaillierte Darstellung aller mit einem Objekt zusammenhängenden Informationen

- Rollen – die direkte Anwendung von Rollen auf jede Ontologie-Ressource, unabhängig von den Berechtigungen auf die ursprüngliche Datenquelle

- Interfaces – abstraktes Schema für Schnittstellen ist ein Ontologietyp, der die Form eines Objekttyps und seine Funktionen beschreibt. Schnittstellen ermöglichen eine konsistente Modellierung und Interaktion mit Objekttypen, die eine gemeinsame Form haben.

Künstliche Intelligenz

Elektronische Patientenakte: So funktioniert die ePA für Versicherte

Seit spätestens Mitte Februar verfügt jeder gesetzlich Versicherte, der nicht widersprochen hat, über eine elektronische Patientenakte. Gesetzliche Krankenkassen sind bereits seit 2021 dazu verpflichtet, ihren Kunden eine elektronische Patientenakte anzubieten. Weil sie jedoch kaum genutzt wurde, haben sie jetzt fast alle automatisch erhalten.

Daten- und Verbraucherschützer fordern zum Pflichtstart für Ärzte und Apotheker erneut, dass Versicherte wieder einstellen können, wer welche Daten sieht. Kassenärzte und Verbraucherschützer drängen zudem auch darauf, dass Abrechnungsdaten nicht automatisch für alle, sondern nur für die Versicherten selbst einsehbar sind.

Um selbst zu sehen, welche Daten in der ePA-Akte hinterlegt und für alle sichtbar sind und auch, um selbst Daten zu speichern oder zu löschen, benötigen Versicherte die ePA-App ihrer Krankenkasse. Wir haben erste Funktionen der App getestet, die sich noch im Aufbau befindet.

Privat Versicherte müssen sich aktiv für eine ePA-App entscheiden, sofern es bei ihrer Krankenkasse die Möglichkeit gibt. Bis Ende des Jahres wollen auch die meisten privaten Versicherungen diese Möglichkeit anbieten.

Hinweis: Dieser Ratgeber wird bei neuen Erkenntnissen aktualisiert. Es kann sein, dass Ihre App manche hier aufgeführten Funktionen nicht bereitstellt. Immer wieder gibt es auch Einschränkungen im Betrieb und teilweise unfertige Funktionen innerhalb der Apps.

Was benötige ich, um die elektronische Patientenakte zu nutzen?

Um die elektronische Patientenakte zu nutzen, benötigen Sie entweder Ihren Personalausweis samt sechsstelliger PIN oder die Gesundheitskarte samt PIN. Auch mit dem Reisepass ist eine Anmeldung möglich. Ferner benötigen Sie ein NFC-fähiges Smartphone samt der ePA-App, die von Ihrer Krankenkasse angeboten wird. In der Regel funktioniert die App ab Android-Version 8.1 oder iOS 15, das hängt aber von der Software Ihrer jeweiligen Krankenkasse ab. Patientenakten von Personen unter 15 Jahren müssen von deren Erziehungsberechtigten verwaltet werden. Wichtig ist auch aus Sicherheitsgründen, die richtige App der Krankenkasse herunterzuladen, die auf der Website der Gematik, aber auch auf den meisten Websites der jeweiligen Krankenkassen zu finden ist.

Fast alle Krankenkassen bieten die elektronische Patientenakte als eigene App an, die Techniker Krankenkasse hat die Patientenakte in ihre allgemeine Service-App integriert. Nach dem Download müssen sie sich eine GesundheitsID erstellen. Bei manchen Krankenkassen wie Die Techniker oder bei der App der 11 AOKen ist eine weitere Ident-App zur Nutzung der GesundheitID nötig. Für den Anmeldeprozess können Sie wählen, ob sie diesen mit dem elektronischen Personalausweis samt PIN oder der Gesundheitskarte samt PIN durchlaufen wollen. Die jeweilige Karte müssen Sie für die Anmeldung an die NFC-Schnittstelle Ihres Smartphones halten. Wird die Karte erkannt, ist das in der Regel in der App sichtbar, dann müssen Sie einen Moment warten.

Die GesundheitsID muss in der Regel nach sechs Monaten erneuert werden. Für den erneuten Login nach der Erstanmeldung können Sie zwischen Biometrie, beispielsweise Ihrem Fingerabdruck, dem Personalausweis mit PIN oder der Gesundheitskarte samt PIN wählen.

Kann ich Daten aus der Vergangenheit in die ePA laden?

Krankenkassen sind verpflichtet, einen Teil der Dokumente in Ihre App zu laden. Falls Sie die Krankenkasse gewechselt haben, können Sie die Daten aus Ihrer bisherigen Patientenakte exportieren, dazu fragen Sie aber am besten bei Ihrer Krankenkasse nach.

Kann ich die E-Rezepte in der ePA-App speichern?

Ja, Krankenkassen wie die AOK oder Die Techniker erlauben das direkte Speichern von E-Rezepten in der elektronischen Patientenakte, allerdings können Versicherte Dokumente auch selbst in der App hochladen, zulässig sind PDF, JPEG, PNG und TIFF, die anschließend in PDF-Dateien umgewandelt werden.

Wie lade ich Daten in die ePA?

Sobald Sie in Ihrer Patientenakte eingeloggt sind, können Sie beispielsweise über ein „+“-Symbol ein Foto aus einer Galerie oder ein PDF-Dokument hochladen oder ein Foto schießen und hinzufügen. Das kann je nach Krankenkasse variieren. Die Dateigröße darf 25 MByte nicht überschreiten, davon können Sie aber so viele Dateien hochladen, bis Sie von Ihrer Krankenkasse kontaktiert werden. Dann können Sie das Dokument um weitere Angaben ergänzen, etwa den Dateinamen ändern oder eintragen, wer das Dokument erstellt hat – dazu kann neben dem Namen auch das jeweilige Fachgebiet, die Rolle, E-Mail-Adresse und Ähnliches angegeben werden. Zudem lassen sich Angaben zur behandelnden medizinischen Einrichtung ergänzen.

Kann ich die Daten aus meiner digitalen Gesundheitsanwendung (DiGA) importieren?

Das sollte funktionieren. Dazu können Sie in Ihrer ePA-App eine DiGA auswählen, mit der Sie Ihre ePA verbinden wollen. Anschließend können Sie die Verbindung auch wieder auflösen.

Gelangen die Abrechnungsdaten automatisch in meine ePA?

Ja, allerdings können Sie das in Ihrer App auch abstellen und jederzeit wieder einstellen.

Welche Daten werden von mir erfasst?

In der ePA können verschiedene Gesundheitsdaten erfasst werden, darunter Diagnosen, Befunde und weitere medizinische Informationen. Manche Ärzte können auch Eintragungen im Zahnbonusheft vornehmen, das hängt von der Software des Arztes ab. Auch der Mutterpass und das U-Untersuchungsheft für Kinder sollen befüllt werden. Welche konkreten Daten erfasst werden, hängt auch davon ab, welche Informationen die behandelnden Ärzte eintragen. Bei besonders heiklen Daten, etwa zur psychischen Gesundheit, soll der Arzt vorher eine Einwilligung einholen, andere Daten sollen automatisch befüllt werden. Notfalldaten lassen sich ebenfalls hinterlegen, allerdings ist das beispielsweise auch über die elektronische Gesundheitskarte möglich. Darüber hinaus können Versicherte selbst Daten hochladen und sie ihren Ärzten zur Verfügung stellen.

Welche Vertraulichkeitsstufen kann ich bei der ePA einstellen?

Sie können mit der neuen ePA nur noch zwischen „Zugriff erlauben“ und „Zugriff verbieten“ wählen – bei letzterem ist das Dokument nur für einen selbst sichtbar. Sie können aber auch einzelne Ärzte von Ihrer ePA ausschließen oder Dokumente löschen.

Sind meine Abrechnungsdaten automatisch für alle sichtbar?

Ja. Sie können aber auch einstellen, dass Ihre Abrechnungsdaten nicht in die ePA eingestellt werden. Dennoch können standardmäßig alle Zugriffsberechtigten diese Daten sehen.

Erhält der Arzt automatisch die Erlaubnis zum Speichern von Daten in der ePA?

Der Arzt erhält automatisch mit dem Stecken der elektronischen Gesundheitskarte eine Erlaubnis, Daten in der ePA zu sehen und zu speichern. Aktuell können Ärzte die ePA freiwillig nutzen, ab Oktober sind sie verpflichtet. Sobald die technischen Voraussetzungen stimmen, müssen sie Daten in die ePA speichern. Nur bei besonders heiklen Daten sollen Ärzte nachfragen, bevor diese zentral gespeichert werden.

Perspektivisch sollen die Daten automatisch aus den Praxisverwaltungssystemen in die ePA und künftig auch an das Forschungsdatenzentrum Gesundheit gelangen, wo Pharmaunternehmen und Forscher – je nach Zweck – Zugang zu einem Teil der Daten aus der ePA erhalten. Speziell, wenn es sich um besonders sensible Daten handelt, muss der Arzt aber immer nachfragen. Bereits jetzt werden viele Daten ohne Zustimmung der Patienten an Dritte weitergegeben. Die Abrechnungsdaten der Krankenkassen werden beispielsweise pseudonymisiert an das Forschungsdatenzentrum Gesundheit übermittelt, das beim Bundesinstitut für Arzneimittel und Medizinprodukte angesiedelt ist.

Weiterhin bestehen Meldepflichten, etwa beim Krebsregister – einem von mehr als 400 medizinischen Registern. In Zukunft sollen möglichst viele Daten an das Forschungsdatenzentrum Gesundheit gehen und perspektivisch auch in einem europäischen Gesundheitsdatenraum auf Anfrage zur Verfügung stehen.

Wie lange können Ärzte und Apotheker auf die ePA zugreifen?

Standardmäßig können Ärzte 90 Tage lang auf die ePA zugreifen, allerdings können Versicherte den Zugriff auch beliebig einstellen. Apotheker haben standardmäßig drei Tage lang Zugriff und auch das lässt sich beliebig einstellen.

Daten können nur diejenigen sehen, die auch berechtigt sind. Die Berechtigung wird in der Regel durch das Stecken der elektronischen Gesundheitskarte erteilt. Alternativ können Sie zum Beispiel selbst eine Praxis oder eine Apotheke für den Zugriff berechtigen. Wer einen detaillierten Überblick über die Zugriffsberechtigungen erhalten möchte, findet diese bei der für die Digitalisierung des Gesundheitswesens zuständigen Gematik. Die meisten Rechte haben in der Regel Ärzte.

Kann ich sehen, wer auf die ePA zugegriffen hat?

Ja, in der ePA-App können Sie sehen, welche Einrichtung auf die Daten zugegriffen hat. Dazu können Sie etwa unter Zugriffen verschiedene Protokollarten einsehen. So können Sie nicht nur sehen, welche Praxis zugegriffen hat, sondern auch, wann Anmeldungen in Ihrer Akte erfolgten und wann Daten exportiert oder weitergeleitet wurden. Da auch Ihre eigenen Aktivitäten protokolliert werden, kann das Ganze etwas unübersichtlich werden. Ab 2030 soll zudem auch protokolliert werden, welche Person Ihre Daten gelesen hat.

Werden meine Daten automatisch für die Forschung freigegeben?

Bisher nicht. Die Pläne zur Datenweitergabe an das Forschungsdatenzentrum Gesundheit wurden weiter verschoben. In Zukunft sollen Patienten dann beispielsweise in ihrer ePA-App darüber informiert werden, dass ihre Daten der Forschung zur Verfügung stehen – sofern sie dem nicht widersprechen.

Kann jemand anders die ePA für mich verwalten?

Versicherte können bei den Ombudsstellen ihrer Krankenkassen einen Vertreter auswählen, diesem dort aber auch wieder die Rechte entziehen. Bei Jugendlichen bis 15 Jahren ist es ohnehin so, dass diese ihre ePA nicht selbst verwalten können. Das müssen die Erziehungsberechtigten übernehmen. Auch über die ePA-App ist es möglich, Daten für andere, beispielsweise für Kinder, zu verwalten.

Wie kann ich die Vertreterregelung einrichten?

Falls die Person, die Sie vertreten wollen, bereits über eine ePA-App verfügt, können Sie in Ihrer Krankenkassen-App etwa unter „Weitere Dienste“ die „Vertretung für Angehörige“ auswählen und sich als Vertretung in einer anderen Akte anmelden. Dafür müssen Sie eine Person hinzufügen und den Namen, die Versichertennummer und bei welcher Krankenkasse die Person versichert ist, angeben. Die zu vertretende Person muss Sie in Ihrer App als Vertreter hinterlegen. Das ist bei manchen Krankenkassen in der elektronischen Patientenakte direkt unter „Zugriffe“ möglich. Dann muss die Person bestätigen, dass Sie eine Vertretung anlegen möchte und den Namen, die Versichertennummer und eine E-Mail-Adresse des Vertreters eingeben. Für jede Person können bis zu fünf Vertreter hinterlegt werden. Aktuell gibt es jedoch bei manchen Krankenkassen eine Störung, wodurch die Vertreterfunktion für einen Teil der Krankenkassen nicht funktioniert.

Falls die Person keine ePA-App nutzt, können Sie zum Beispiel unter „Weitere Dienste“ eine „Vertretung für Angehörige“ einrichten. Falls das funktioniert, benötigen Sie allerdings die Gesundheitskarte samt PIN der zu vertretenden Person und müssen sich so anmelden, wie Sie es möglicherweise zu Beginn bei Ihrer eigenen Akte getan haben. Zuerst geben Sie die Zugangsnummer der Karte ein und dann die PIN der Gesundheitskarte. Dazu benötigen Sie die Versichertennummer, die Postleitzahl und die sechsstellige Kartenzugangsnummer (Card Access Number, CAN). Danach müssen Sie auch die Daten des Vertreters eintragen.

Digital Health abonnieren

Alle 14 Tage bieten wir Ihnen eine Übersicht der neuesten Entwicklungen in der Digitalisierung des Gesundheitswesens und beleuchten deren Auswirkungen.

E-Mail-Adresse

Ausführliche Informationen zum Versandverfahren und zu Ihren Widerrufsmöglichkeiten erhalten Sie in unserer Datenschutzerklärung.

Kann ich die elektronische Patientenakte auch in der Desktop-Version nutzen?

Inzwischen sollte das bei allen gesetzlichen Krankenkassen wieder möglich sein. Der Funktionsumfang ist allerdings eingeschränkt.

Kann ich die elektronische Patientenakte auch ohne Smartphone nutzen?

Ja, sofern Sie über ein Kartenlesegerät verfügen.

Was mache ich, wenn ich mich in meiner ePA nicht anmelden kann?

Meistens hilft es abzuwarten, die App neu zu starten oder den Cache zu löschen. Falls Sie den Verdacht haben, dass jemand Unbefugter auf Ihre ePA zugreift, können Sie bei Ihrer Krankenkasse um die Sperrung Ihres Zugangs bitten. Vereinzelt haben Krankenkassen dafür extra Hotlines eingerichtet. Allerdings kann das Gefühl, dass etwas nicht mit rechten Dingen zugeht, auch bei der Anmeldung in manchen Krankenkassen-Apps auftreten.

Wenn Sie sich über Störungen der Telematikinfrastruktur informieren möchten, können Sie das über den WhatsApp-Kanal der Gematik machen. Dort wird angezeigt, ob die ePA Ihrer Versicherung gestört ist – etwa aufgrund von Wartungsarbeiten.

Spart mir die ePA den Gang zu verschiedenen Ärzten?

Die ePA ersetzt nicht den Arztbesuch, aber sie kann dazu beitragen, dass Informationen schneller übermittelt werden, was eventuell einige unnötige Besuche oder Untersuchungen vermeiden kann. Zudem müssen Versicherte bisher noch alle drei Monate zum Arzt, um ihre Gesundheitskarte einlesen zu lassen. Das soll sich in Zukunft ändern. Für Folgerezepte kann die E-Rezept-Funktion in der ePA, sofern vorhanden, allerdings praktisch sein.

Welche Vorteile soll die elektronische Patientenakte bieten?

Alle für die Behandlung relevanten medizinischen Informationen wie Befunde, Diagnosen, Impfungen und das Zahnbonusheft können zentral gespeichert werden, was die Koordination zwischen verschiedenen Ärzten erleichtern kann. Ärzte sollen schneller und einfacher auf wichtige Informationen zugreifen können, was die Behandlung effizienter und sicherer macht. Die Medikationsliste soll beispielsweise helfen, die Arzneimitteltherapiesicherheit zu erhöhen.

Welche Funktionen hat die elektronische Patientenakte noch?

Es gibt noch weitere Funktionen in der ePA-App, beziehungsweise den Apps, in denen auch der Zugang zur ePA möglich ist. Versicherte können etwa mit Ihrer ePA-App eine Erklärung zur Organspende im Online-Portal abgeben. Zudem können auch Einträge zu Impfungen vorgenommen werden. Ebenso ist beispielsweise das Informationsportal des Gesundheitsministeriums „gesund.bund.de“ verknüpft. Zusätzlich können Sie in vielen ePA-Apps der Krankenkassen den TI-Messenger TIM nutzen. Künftig werden noch weitere Angebote hinzukommen, auch KI-Agenten wurden bereits angekündigt.

Kann ich der ePA widersprechen?

Ja, Sie können der ePA widersprechen. Sie können aber beispielsweise auch dagegen widersprechen, dass die elektronische Medikationsliste automatisch erstellt wird. Zu einem späteren Zeitpunkt können Sie jederzeit wieder zustimmen.

Woher weiß ich, ob mein Widerspruch gegen die elektronische Patientenakte funktioniert hat?

Sie können bei Ihrer Krankenkasse oder deren eigens für solche Zwecke eingerichtete Ombudsstelle nachfragen, ob Sie eine ePA haben. Alternativ können Sie sich auch die ePA-App der Krankenkasse herunterladen, wofür Sie jedoch ebenfalls eine GesundheitsID erstellen müssen. Dafür benötigen Sie die Gesundheitskarte samt PIN oder den Personalausweis samt PIN.

Kann ich die ePA einfach löschen?

Ja, Sie können die ePA jederzeit löschen, allerdings werden die Akten nicht bei jeder Krankenkasse unverzüglich gelöscht.

Update

29.09.2025,

20:22

Uhr

(mack)

Künstliche Intelligenz

Top 10: Der beste Offroad-E-Scooter – Segway Ninebot Max G3 D ist Testsieger

Epowerfun EPF-Pulse

Der Epowerfun EPF-Pulse ist ein vollgefederter E-Scooter mit starkem Motor, großem Akku, Blinker vorn und hinten sowie toller Verarbeitung. Wir testen, ob er hält, was das Datenblatt verspricht und für wen sich der Kauf lohnt.

- Vollfederung, Motor, Bremse

- Blinker vorn und hinten, 140 kg Zuladung, Diebstahlschutz

- variable Akkukapazität bis zu 960 Wh

- Aufhängung des Frontlichts wirkt zerbrechlich

- Display bei Sonne schwer ablesbar

Epowerfun EPF-Pulse im Test

Der Epowerfun EPF-Pulse ist ein vollgefederter E-Scooter mit starkem Motor, großem Akku, Blinker vorn und hinten sowie toller Verarbeitung. Wir testen, ob er hält, was das Datenblatt verspricht und für wen sich der Kauf lohnt.

Bei über 65 getesteten E-Scootern haben wir festgestellt, dass die elektrischen Tretroller immer besser werden. Immer mehr Modelle kommen mit Federung vorn und hinten, starken Motoren, guten Lichtanlagen, Blinkern, hochwertiger Verarbeitung und leistungsfähigen Bremsen daher. Auch der Epowerfun EPF-Pulse mit Straßenzulassung bildet hier keine Ausnahme. Bereits in der Vergangenheit konnten uns E-Scooter des Herstellers überzeugen.

Dazu zählt etwa der Epowerfun EPF-1 Pro (Testbericht), der mit seinem starken Motor und der hohen Reichweite punktet, allerdings ohne Luftreifen auskommen muss. Der Epowerfun EPF-2 XT (Testbericht) bessert an vielen Stellen nach. Auch er überzeugt mit kräftigem Antrieb und großem Akku, bietet darüber hinaus aber Luftbereifung und einen Blinker am Lenker. Ebenfalls hervorragend gefiel uns der Epowerfun EPF-2 City (Testbericht), dessen größter Nachteil das Fehlen einer Federung an Vorder- und Hinterrad war.

Hier setzt der Epowerfun EPF-Pulse an, den wir in diesem Testbericht genauer unter die Lupe nehmen. Er verfügt nämlich über eine Vollfederung und bietet darüber hinaus viele weitere sinnvolle Features. Dabei kommt er in drei Varianten, welche sich lediglich in der Akkukapazität und damit einhergehend, im Gewicht und Preis unterscheiden. Folgende Varianten zeigt Epowerfun:

Ob er die hohen Erwartungen erfüllen kann, die das vielversprechende Datenblatt weckt, soll dieser Test klären.

Versicherung

Für E-Scooter gibt es eine Haftpflicht-Versicherungspflicht, aber auch andere Versicherungen können wichtig sein. Selbst die vorsichtigsten Fahrer können die Gefahr eines Unfalls nie zu 100 Prozent ausschließen. Wir empfehlen deshalb Zusatzversicherungen, um die möglichen negativen Konsequenzen abzumildern.

Bei vielen Versicherungen lohnt sich das Vergleichen wirklich. Denn wer regelmäßig vergleicht, spart gut und gerne mehrere hundert Euro im Jahr. Wo man am meisten spart, zeigen die Tarifrechner von heise online.

Highlights am Epowerfun EPF-Pulse

- Federung vorn und hinten

- starker Motor

- Akku mit bis zu 960 Wh

- helle Lichtanlage mit Blinker vorn und hinten

- hochwertige Verarbeitung

- Scheibenbremsen an beiden Rädern

- selbstheilende, schlauchlose 10-Zoll-Reifen

- hohe Zuladung von 140 kg

- NFC-Wegfahrsperre

Aufbau: Kaum Kunststoff bei der Verpackung

Schon beim Auspacken punktet Epowerfun mit dem Verzicht auf unnötiges Plastik. Der EPF-Pulse ist fast komplett in Pappe und Papier gewickelt – vorbildlich, da deutlich umweltverträglicher als die sonst üblichen Kunststoffe. Nach dem Auspacken muss nur noch der Lenker mit wenigen Schrauben befestigt werden. Ein abschließender Rundum-Check, bei dem alle Schrauben auf festen Sitz und die Reifen auf den korrekten Luftdruck geprüft werden, ist wie bei allen E-Scootern ratsam. Dann steht der ersten Fahrt nichts mehr im Wege – am Besten mit Helm. Smarte Empfehlungen dazu finden sich in unserer Bestenliste Top 7: Der beste smarte Fahrradhelm.

Epowerfun EPF-Pulse Bilder

Optik: Wie gut schaut der Epowerfun EPF-Pulse aus?

Optisch zeigt sich der Epowerfun EPF-Pulse im dezenten Matt-Grau mit blauen Akzenten an Vorderradaufhängung und Lenkerlager. Die filigran, aber robust wirkende Vorderradfederung sticht optisch positiv ins Auge. Auch der Aufbau am Heck mit erhöhtem Trittbrett zum Schutz des Schutzblechs vor versehentlichen Tritten wirkt durchdacht und bietet bei Bedarf einen komfortablen Abstellplatz für den hinteren Fuß. Auffällig unauffällig verläuft die Kabelführung – es sind lediglich die beiden Bremszüge sichtbar, die von den Bremsgriffen in die Lenkstange führen.

Qualität: Ist der Epowerfun EPF-Pulse robust?

Qualitativ macht der E-Scooter einen hochwertigen Eindruck. Die Lenkstange sitzt bombenfest und wackelt nicht, die massiven Schutzbleche sollten auch einen versehentlichen Tritt problemlos wegstecken. Einzig die Befestigung des Frontlichts wirkt ein wenig fragil, dafür sind die Blinker am Heck vorbildlich stabil angebracht. Mit einer Zuladung von bis zu 140 kg ist der EPF-Pulse auch für schwerere Fahrer oder viel Gepäck geeignet.

Klappmechanismus: Wie klappt’s beim Epowerfun EPF-Pulse?

Der EPF-Pulse verfügt über einen klassischen Klappmechanismus am unteren Ende der Lenkstange. Ein Sicherungshebel hält die Stange aufrecht. Öffnet man ihn, klappt die Lenkstange nach hinten und rastet an einem Haken ein, sodass der Roller an der Stange getragen werden kann. Bei einem Gewicht von rund 23,5 kg bis 25 kg je nach Akkuversion macht das auf Dauer aber nur bedingt Spaß. Aufgeklappt misst der EPF-Pulse 129 cm in der Länge, 65 cm in der Breite und 130 cm in der Höhe. Zusammengeklappt reduziert sich die Höhe auf 62 cm, sodass er in die meisten Kofferräume passen sollte. Als zusammengeklappter E-Scooter benötigt der EPF-Pulse in öffentlichen Verkehrsmitteln kein extra Ticket.

Lenker: extra-breit, extra-bequem

Der üppig dimensionierte Lenker misst satte 65 cm in der Breite, was zusammen mit den ergonomisch geformten Griffen auch bei längeren Fahrten für entspanntes und sicheres Handling sorgt. Rechts befinden sich der Ein-/Aus-Taster, der Lichtschalter sowie der etwas straffe Daumengas-Hebel, der bei ausgedehnten Touren eventuell für einen müden Daumen sorgen könnte. Links sitzen die Taster für den Blinker, eine kleine Glocke und der Hebel für die elektrische Bremse.

Display: Minimalistisch mit Leuchtschwäche

Das mittig platzierte LED-Display fügt sich nahtlos in den Lenker ein und informiert über Geschwindigkeit ohne Nachkommastelle, gewählte Unterstützungsstufe und Akkukapazität in fünf Balken. Die Ablesbarkeit bei direkter Sonneneinstrahlung könnte besser sein.

Wegfahrsperre mit NFC-Karte

Als praktischer Diebstahlschutz erweist sich die NFC-Wegfahrsperre: Nach dem Einschalten lässt sich der Roller erst mit einer der drei beiliegenden NFC-Karten (Lesepunkt unterhalb des Displays) entsperren. Im gesperrten Zustand aktiviert jeder Bewegungsversuch die Motorbremse und löst ein akustisches Warnsignal aus. Ein Wegtragen des Rollers verhindert das natürlich nicht – wer auf Nummer sicher gehen will, sollte ein gutes Schloss verwenden. Auf Wunsch lässt sich diese automatische Wegfahrsperre deaktivieren. Hier geht es zu unseren Ratgeber Fahrradschloss für E-Bike & E-Scooter: Smart, mit App, Alarm & GPS.

Licht & Blinker: Wie gut ist die Lichtanlage am Epowerfun EPF-Pulse?

Die Beleuchtungsanlage des EPF-Pulse weiß zu gefallen: Neben den gut platzierten Blinkern an den Lenkerenden und am Heck verfügt er über ein mit 80 Lux angenehm helles Frontlicht mit gutem Lichtkegel, das sich in der Höhe verstellen lässt. Auch das Rücklicht ist hell genug, um rechtzeitig gesehen zu werden und leuchtet beim Bremsen zusätzlich auf – ein weiteres Plus für die Sicherheit. Beim Aktivieren ertönt ein akustisches Signal, das sich über die App deaktivieren lässt. Der Blinker schaltet sich nicht automatisch aus, sondern erfordert eine manuelle Deaktivierung durch den Fahrer.

App: Was kann die App des Epowerfun EPF-Pulse?

Der E-Scooter kommt außerdem mit einer App. Die App benötigt keine Registrierung und findet in unserem Fall den E-Scooter auf Anhieb. Dort kann unter anderem die maximale Geschwindigkeit gedrosselt, Tageskilometer eingesehen und der Blinkerton ausgeschaltet werden. Außerdem sieht man die Gesamtkilometer und einige weitere Metriken. Nett, dass es eine App gibt. Wirklich wichtig ist sie jedoch nicht.

Epowerfun EPF-Pulse Screenshots

Fahren: So fährt sich der Epowerfun EPF-Pulse?

Mit dem EPF-Pulse steht einer bequemen und sicheren Fahrt nichts im Wege. Er reagiert direkt auf Lenkeingaben und meistert dank großzügiger Bodenfreiheit auch höhere Bordsteinkanten problemlos. Die Federung wirkt auf den ersten Blick eher straff, entpuppt sich beim Fahren aber als gut abgestimmt. Kleinere Unebenheiten wie Kopfsteinpflaster oder kürzere Feldwege bügelt sie souverän aus. Auf längeren, unebenen Passagen ist man als Fahrer aber dennoch gefordert.

Für viel Fahrspaß sorgt der leistungsstarke Heckmotor mit 500 Watt Nennleistung und 1200 Watt Peak-Power – einer der stärksten bisher von uns getesteten legalen Antriebe. Er beschleunigt den Roller in Windeseile auf die zulässige Höchstgeschwindigkeit von 20 km/h plus Toleranz, die wir per GPS-Messung mit sehr guten 21 bis 22 km/h bestätigen können. Hier könnten sich viele andere, zögerlicher ausgelegte E-Scooter etwa von Xiaomi oder Segway Ninebot eine Scheibe abschneiden.

Sicher unterwegs ist man auch dank der vorbildlichen Bremsanlage mit Scheibenbremsen an beiden Rädern, die über Bremshebel am Lenker verzögern. Zusätzlich sorgt die über einen Daumengriff ansteuerbare Motorbremse für verlustfreie Verzögerung. Diese Kombination macht sowohl beim sanften Abbremsen als auch bei einer Vollbremsung eine gute Figur.

Zum guten Gesamteindruck tragen auch die 10 Zoll großen, schlauchlosen Luftreifen mit selbstheilender Spezialbeschichtung bei, die kleinere Einstiche etwa durch Dornen selbstständig abdichten können.

Akku: Wie ist die Reichweite des Epowerfun EPF-Pulse?

Käufer haben beim EPF-Pulse die Wahl zwischen drei Akkuvarianten: 480 Wh, 720 Wh oder üppige 960 Wh Kapazität, für die der Hersteller Reichweiten von 52, 78 oder 104 km angibt – gemessen unter optimalen Bedingungen.

In der Praxis liegen die erzielbaren Reichweiten erfahrungsgemäß darunter. Faktoren wie Fahrergewicht, Außentemperatur, Topografie, Fahrbahnbeschaffenheit und Fahrstil (etwa viel Stop-and-Go im Stadtverkehr) haben großen Einfluss auf die tatsächliche Reichweite. Wir haben die 960-Wh-Variante getestet und kamen bei 80 kg Fahrergewicht im sommerlichen Stadtverkehr mit vielen Ampelstopps auf gute 60 km Reichweite. Pauschale Angaben zur Reichweite sind aber schwierig, da die individuellen Einflussfaktoren stark variieren.

Preis: Was kostet der Epowerfun EPF-Pulse?

In der 480 Wh-Version kostet der Epowerfun EPF-Pulse 989 Euro, mit 720-Wh-Akku werden 1199 Euro fällig und die große 960-Wh-Variante schlägt mit 1349 Euro zu Buche. Dafür bekommt der Käufer einen leistungsstarken, komfortablen und hochwertigen E-Scooter mit Straßenzulassung, der auch für Ausflüge abseits befestigter Wege geeignet ist.

Fazit: Wie gut ist der Epowerfun EPF-Pulse?

Mit dem EPF-Pulse hat Epowerfun einen rundum gelungenen E-Scooter im Programm, der dank seiner hervorragenden Vollfederung, dem kraftvollen Antrieb und der guten Ausstattung kaum Wünsche offen lässt. Die hochwertige Verarbeitung und die üppige Zuladungskapazität prädestinieren ihn auch für große und schwere Fahrer, die auf der Suche nach einem zuverlässigen Begleiter für Stadt und Gelände sind.

Erfreulich ist die Auswahl zwischen drei Akkugrößen. In Kombination mit der hellen Lichtanlage und der praktischen NFC-Diebstahlsicherung bietet der EPF-Pulse ein stimmiges Gesamtpaket, das die meisten Konkurrenten alt aussehen lässt.

Kleinere Kritikpunkte wie die in der Höhe nicht verstellbare Lenkstange, ein nur mit Werkzeug wechselbarer Akku, die fragil wirkende Befestigung des Frontlichts und der bei Sonne schwer ablesbaren Geschwindigkeitsanzeige fallen da nur wenig ins Gewicht. Unter dem Strich ist der Epowerfun EPF-Pulse einer der besten E-Scooter, der die Messlatte für Komfort, Sicherheit und Fahrleistungen ein gutes Stück nach oben verschiebt – und damit trotz des stolzen Preises eine klare Kaufempfehlung verdient.

Künstliche Intelligenz

Forschungspreis „Wissen der Vielen“ würdigt wissenschaftliche Leistungen

Der 2023 ins Leben gerufene „Wissen der Vielen – Forschungspreis für Citizen Science“ zeichnet herausragende wissenschaftliche Beiträge von Projekten im Bereich Bürgerwissenschaften (Citizen Science) mit Preisgeldern von insgesamt 35.000 Euro aus. Er fördert die Anerkennung von Citizen Science in der Forschung und motiviert Bürgerinnen und Bürger, sich aktiv an wissenschaftlichen Projekten zu beteiligen.

Bei Citizen Science kann jeder Mensch mitmachen. Weltweit laden zahlreiche Projekte aus verschiedenen Lebensbereichen zum Mitforschen ein, viele davon kommen aus Deutschland, Österreich und der Schweiz. Jeder kann dabei aktiv an wissenschaftlichen Projekten teilnehmen.

Die besten drei Projekte 2025

Drei zukunftsweisende Projekte gewinnen 2025 den Forschungspreis „Wissen der Vielen“: Ein Team untersucht Birken als Habitat für Baumpilze, ein anderes entwickelt 3D-gedruckte Prothesen für Kinder, und ein drittes schafft eine Plattform für den Austausch zwischen Forschern und DIY-Wissenschaftlern. Die Preisträger erhalten zusammen 35.000 Euro für ihre erstklassigen Arbeiten, die durch Citizen Science – also Wissenschaft mit Bürgerbeteiligung – entstanden sind. Wissenschaft im Dialog und das Museum für Naturkunde Berlin verleihen die Preise im Rahmen des Projekts „mit:forschen!“ zum dritten Mal.

1. Platz

Dr. Dirk Knoche vom Forschungsinstitut für Bergbaufolgelandschaften e.V. in Finsterwalde (Brandenburg) landete auf dem 1. Platz (Preisgeld: 20.000 Euro) für die Publikation „Gemeinsam die Birke erforschen: Bürgerforschung zum Waldwandel: Wasserhaushalt, Biodiversität & Klimawirksamkeit“. Im Projekt „PlanBirke plus C“ sammelten Citizen Scientists eigenständig Messdaten oder nahmen an Bürgerlabor-Tagen im Wald teil. So verglichen Forscher erstmals den Wasserhaushalt verschiedener Birkenmischwälder in Mitteleuropa. Zudem erfassten sie umfassende Daten zur Kohlenstoffspeicherung – vom Stamm bis zu den Blättern. Ein weiteres zentrales Ergebnis: Die Birke bietet gefährdeten Baumpilzarten in Deutschland einen wichtigen Lebensraum.

2. Platz

Diplom-Wirtschaftsinformatiker Sven Bittenbinder nahm den mit 10.000 Euro dotierten Preis für den zweiten Platz für sein Team mit der Publikation „Research Buddy – From a Framework for Overcoming Language Barriers to the Development of a Qualitative Citizen Science Platform“ entgegen. Die Forschungsarbeit aus der Mensch-Computer-Interaktion zeigt, wie Studierende, Senioren und Forscher gemeinsam technische Anforderungen für eine Citizen-Science-Plattform erarbeiten. Ihr Ergebnis: ein Prototyp einer kollaborativ entwickelten Plattform, die Forschern und Bürgern ermöglicht, Projektideen auszutauschen oder Mitforschende zu finden.

3. Platz

Dr. Melike Şahinol, Soziologin, sicherte sich und dem Team den mit 5000 Euro dotierten dritten Platz mit der Publikation „3D-gedruckte Kinderprothesen als befähigende Technologie? Erfahrungen von Kindern mit Oberkörperunterschieden“. Sie zeigt, wie partizipative Ansätze vulnerable Gruppen erfolgreich in die Technikentwicklung einbinden. Im Fokus steht die Frage, ob 3D-gedruckte Prothesen Kindern neue Handlungsmöglichkeiten eröffnen. Dafür arbeitete Şahinol mit Familien, Kindern und Ehrenamtlichen zusammen. Mit einem eigens entwickelten Erkundungs-Toolkit dokumentierten die Kinder ihre körperlichen, emotionalen und sozialen Erfahrungen mit den Prothesen. Die Ergebnisse zeigen, dass die Prothesen die Identität und soziale Teilhabe der Kinder stärken, aber auch Herausforderungen bei der Nutzung aufzeigen.

Die Preisverleihung findet am 12. November während der Konferenz PartWiss in Leipzig statt. Die Preise sollen die Bürgerwissenschaft würdigen und DIY-Enthusiasten motivieren, aktiv an Forschungsprojekten teilzunehmen. Das Bundesministerium für Forschung, Technologie und Raumfahrt unterstützt die Initiative. Weitere Details, auch zu vergangenen Wettbewerben, bietet die Veranstaltungswebseite.

(usz)

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen