Künstliche Intelligenz

Nvidia Rubin CPX: Spezialbeschleuniger für KI-Inferencing kommt Ende 2026

Nvidia will Ende 2026 einen speziellen Beschleunigerchip auf den Markt bringen, den Rubin CPX. Er soll speziell KI-Anwendungen mit enormen Context-Anforderungen (siehe unten) beschleunigen, denen wiederum eine besonders hohe Profitabilität unterstellt wird. Darunter sind KIs, die Programmcode liefern oder KI-Filme aus dem Nichts erstellen. Rubin CPX soll die spezifischen Flaschenhälse bei der Verarbeitung solcher KI-Modelle gezielt angehen.

Der Chip gehört zu Nvidias 2026 kommender Vera-Rubin-Generation von Rechenzentrumsbeschleunigern, die bereits ihren Tape-Out hinter sich hat. Er ist entweder direkt im Rackeinschub integriert oder als Zusatz-Beschleuniger in separaten Einschüben zu bekommen.

Mixture-of-Experts und Context-Länge

Die aktuell angesagten KI-Modelle wie DeepSeek R1, Llama4 Maverick, gpt-ossm, Qwen3 oder auch Kimi K2 verwenden eine Technik, die man Mixture-of-Experts nennt. Dabei kommen verschieden spezialisierte neuronale Netze (die Experts) für unterschiedliche Anfragen(teile) zum Einsatz. Das wiederum führt bei den einzelnen Experten zu geringeren Anforderungen an Speicher und Rechenleistung.

Der Trick ist, die optimale Mixtur von Experten für jede Anfrage hinzubekommen; die Verteilung der Anfragen auf die Experten wird entscheidend. Gerade in Verbindung mit Reasoning müssen die einzelnen Experten miteinander kommunizieren und das MoE-Modell als Ganzes wird aufwendiger.

Zugleich werden die Antworten von KI-Anwendungen um Größenordnungen komplexer, etwa durch die Ausgabe ganzer Programmcode-Sequenzen oder künstlich erzeugter Filme. Das lässt die Anzahl der Token, die ständig berücksichtigt werden müssen, exponentiell ansteigen. Ein Token ist dabei die kleinste Informationseinheit, die innerhalb einer KI eine numerische ID zugewiesen bekommt, um die Berechnungen zu vereinfachen. Ein Token kann Informationen von einem Buchstaben bis hin zu kurzen Phrasen repräsentieren. Schätzungen setzen ein englisches Wort im Durchschnitt mit 1,5 Token gleich.

Nvidias Vera Rubin-Beschleuniger in einer künstlerischen Darstellung. Damit ausgerüstete Systeme sollen 2026 in Rechenzentren ankommen.

Damit die Antwort in sich konsistent ist, muss die KI intern noch weitaus mehr Token bei der Gewichtung berücksichtigen als im Antwortfenster ausgegeben werden, das nennt man Context. Chat-GPT 3.5 hatte anfangs ein Context-Window von 4096 Token. GPT-4o ist schon bei 128.000 Token, Google Gemini 1.5 Pro bei 2 Millionen Token.

Disaggregated Serving

Ein dadurch entstandener Optimierungsansatz ist das entkoppelte Beantworten der Anfragen (disaggregated serving). Dabei werden Context- und Prefill-Stufen bei der Beantwortung einer Anfrage verschiedenen Beschleunigern zugewiesen. Nvidia nutzt das bereits mit aktuellen GB200-Blackwell-Systemen. So arbeiten etwa in den optimierten Einreichungen zu den KI-Benchmarks der MLCommons MLPerf Inference v5.1 von den 72 Blackwell-GPUs eines NVL72-Racks 56 GPUs nur am Context und nur die restlichen 16 erzeugen die Inhalte. Diese Optimierung bringt geschätzt anhand eines ungenau beschrifteten Diagramms einen Performance-Sprung von 40 bis 45 Prozent auf Blackwell.

Nvidia macht sich dabei noch eine Eigenschaft dieser LLMs zunutze: Sie kommen mit entsprechendem Feintuning auch mit recht niedriger Rechengenauigkeit aus, sodass das hauseigene, 4-bittige Floating-Point-Format NVFP4 mit blockweise geteiltem Exponenten für die erforderliche Antwortgenauigkeit bei MLPerf Inference ausreicht.

Von Blackwell zu Rubin (CPX)

Bereits Blackwell Ultra (GB300) hat Nvidia auf maximalen Durchsatz bei diesem Format optimiert. Dafür haben die Ingenieure die Exponent-2-Funktion aufgebohrt, die im Attention-Layer aller KI-Modelle mit Transformer-Technik eine große Rolle spielt. Da diese außerhalb der auf KI-Durchsatz spezialisierten Tensorkerne in den SFU-Einheiten (Special Function Units) laufen, sind sie in Blackwell bereits zum Flaschenhals geworden, denn die EX2-Leistung gegenüber Hopper ist kaum gewachsen. Blackwell Ultra verdoppelt den EX2-Durchsatz gegenüber Blackwell von 5 auf 10,7 Billionen Exponential-Berechnungen pro Sekunde.

Ein NVL72-Schrank GB300 schafft rund 1,1 ExaFLOPS in NVFP4, Rubin NVL144 wird von Nvidia auf 3,6 EFlops projektiert und ein Rubin-CPX-Rack auf satte 8 EFlops.

Ein Rubin CPX soll Ende 2026 gegenüber dem heutigen GB300 den dreifachen Exponential-Durchsatz von 30 PFlops NVFP4 schaffen. Da die Context-Phase weniger schnellen RAM benötigt und hauptsächlich von den Berechnungen limitiert wird, setzt Nvidia bei Rubin CPX auf 128 GByte GDDR7-Speicher.

(csp)

Künstliche Intelligenz

Studie: Echtzeit-Kommunikation stresst deutsche Büroangestellte

Über die Hälfte der deutschen Büroangestellten (56 Prozent) fühlt sich zumindest gelegentlich durch Benachrichtigungen oder den Druck, sofort reagieren zu müssen, überfordert. Das zeigt eine aktuelle Studie von Atlassian. 59 Prozent der Befragten verbringen täglich zwei oder mehr Stunden damit, E-Mails oder Chat-Nachrichten zu beantworten. In einer Atlassian-Untersuchung aus dem Jahr 2024 gaben 78 Prozent an, dass sie ihrer Kernarbeit kaum nachgehen können, wenn sie an allen geplanten Besprechungen teilnehmen.

Weiterlesen nach der Anzeige

Dabei hat sich Gleitzeit in deutschen Büros längst als Standard etabliert: 69 Prozent der Befragten genießen einen gewissen Grad an Freiheit bei der Einteilung ihrer Arbeitszeit. Doch diese Flexibilität führt nicht automatisch zu weniger Belastung. Der Arbeitsalltag ist in vielen Unternehmen so gestaltet, dass Beschäftigte nahezu jederzeit für kurzfristige Meetings oder zur Beantwortung von Nachrichten erreichbar sein müssen.

Zeitversetztes Arbeiten als Ausweg

Atlassian empfiehlt in der Auswertung der Studienergebnisse asynchrone Arbeitsmodelle: Hier erfolgt die Zusammenarbeit zeitversetzt, ohne dass alle Beteiligten gleichzeitig online sein müssen. Angestellte leisten ihren Beitrag dann, wenn es in ihren individuellen Arbeitsrhythmus passt – etwa über aufgezeichnete Videos, Kommentare in Dokumenten oder Projektmanagement-Tools statt in Live-Meetings oder Chats. Laut der Studie sparen Mitarbeiter, die bereits asynchron arbeiten, durchschnittlich mehr als zwei zusätzliche Stunden (etwa 140 Minuten) pro Woche ein, die sie stattdessen fokussiert arbeiten können.

Die in Deutschland am häufigsten genutzten Methoden asynchroner Zusammenarbeit sind schriftliche Antworten über Kommentarfunktionen (46 Prozent) sowie der Einsatz von Sprachnachrichten oder aufgezeichneten Video-Updates anstelle von Live-Meetings (32 Prozent). Mehr als ein Drittel der Befragten (35 Prozent) arbeitet regelmäßig über verschiedene Zeitzonen hinweg.

Vorbehalte und positive Erfahrungen

Nicht alle Büroangestellten stehen asynchronen Methoden offen gegenüber: 30 Prozent befürchten, dass Vorgesetzte diese Arbeitsweise als geringere Verfügbarkeit werten könnten. 27 Prozent sorgen sich, dass Entscheidungen verzögert oder Prozesse verlangsamt werden könnten. Die Erfahrungen derjenigen, die bereits asynchron arbeiten, zeichnen jedoch ein positives Bild: Knapp zwei Drittel (65 Prozent) berichten von höherer Produktivität, 54 Prozent erleben weniger Stress und 63 Prozent geben an, durch asynchrones Arbeiten zufriedener in ihrem Job zu sein.

Weiterlesen nach der Anzeige

Für die Studie befragte Atlassian in Zusammenarbeit mit Censuswide vom 1. bis 4. Juli 2025 insgesamt 4.000 Büroangestellte, darunter 1.000 aus Deutschland, zu ihren Erfahrungen mit flexiblen und asynchronen Arbeitsmodellen.

Lesen Sie auch

(fo)

Künstliche Intelligenz

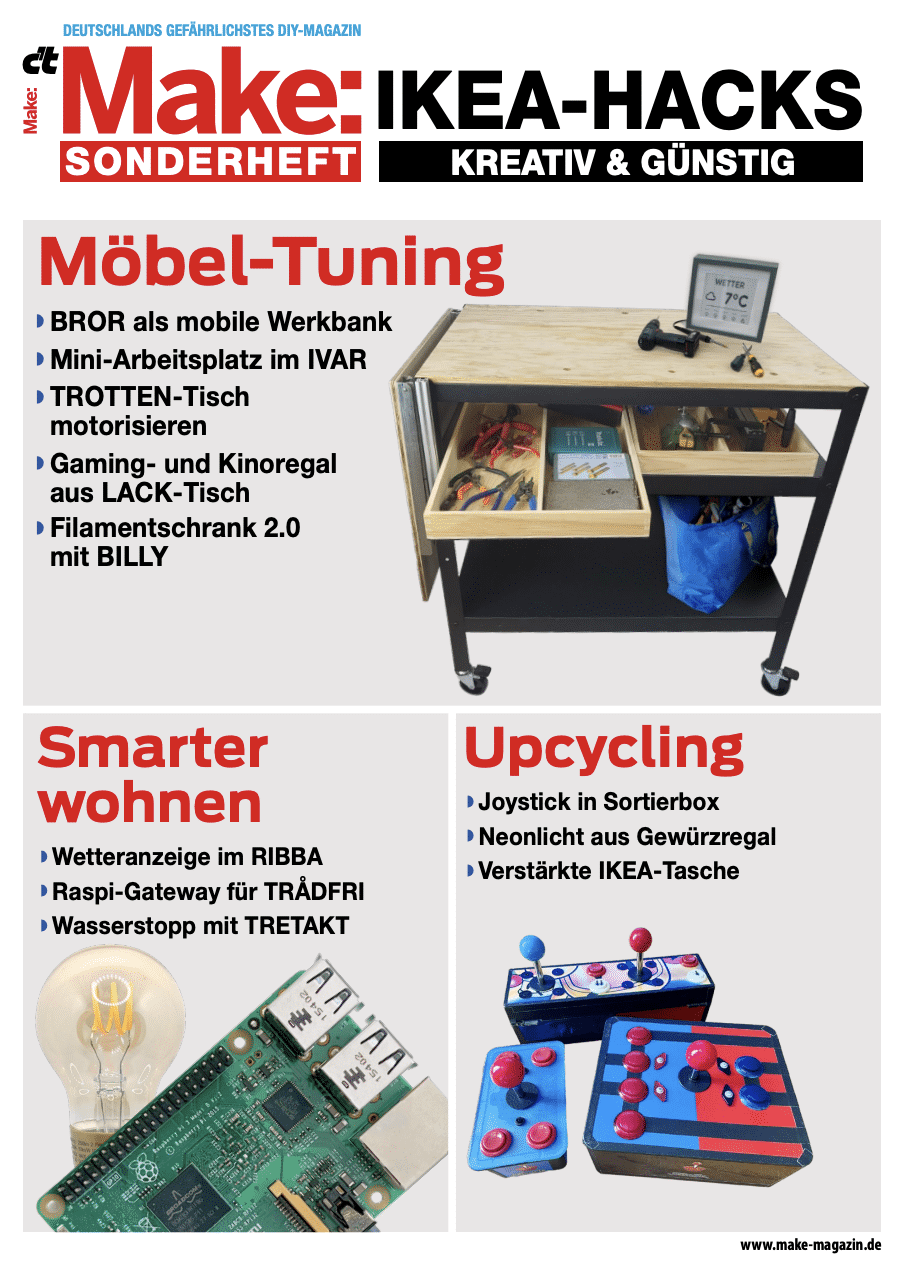

Jetzt im Make-Sonderheft 6/25: Ikea-Hacks

Ikea-Produkte sind ein toller Ausgangspunkt für eigene Projekte. Denn mit kleinen Anpassungen lässt sich meist noch mehr aus ihnen herauskitzeln. So wird ein Bror-Servierwagen in wenigen Schritten zu einer praktischen Arbeitsfläche in der Werkstatt oder ein Förnuftig-Luftfilter zu einer Absaugstation für Lötdämpfe. Das funktioniert oft auch mit einfachem Werkzeug und ohne 3D-Drucker – etwa wenn man sich eben mal einen coolen Joystick für Retrospiele aus einer Glis-Kiste bauen möchte.

Weiterlesen nach der Anzeige

In dem Make-Sonderheft 6/25 dreht sich alles um kreative Ikea-Hacks. Die Bandbreite der Projekte reicht von dekorativen Lichtinstallationen bis hin zu smårten Lösungen. So zeigen wir, wie man eine elegante Ladestation baut, ein Glasgewürzregal in eine fluoreszierende Leuchte verwandelt oder die ikonische Ikea-Tragetasche Frakta verbessert. Besonders praktisch ist der automatische Wasserstopp, der erkennt, ob gerade Wasser den Wohnraum flutet, und daraufhin den Hahn abdreht. Die selbstgebaute Arbeitsecke fürs Ivar-Regal schafft schnell Platz für Maker-Projekte, wo eigentlich keiner ist. Und wer sein Ikea-Smarthome flexibel konfigurieren möchte, lernt ebenso, wie sich ein ZigBee-Gateway auf Raspberry-Pi-Basis bauen lässt. Wir wünschen viel Spaß beim Hacken!

Weitere spannende Projekte gibt es in der Make 6/25.

Die aktuelle Make: Am Kiosk und online erhältlich

Die Ausgabe 6/25 ist online und am Kiosk erhältlich. Mit einem unserer Abos lag das Heft sogar bereits im Briefkasten. Außerdem können Sie die Make bequem als Printversion oder PDF im Heise Shop bestellen – bis zum 1.11. sogar versandkostenfrei. Wenn Sie die Make lieber digital lesen, können Sie das in unseren Apps für iOS und Android. Online finden Sie auch das Inhaltsverzeichnis der Make 6/25.

(akf)

Künstliche Intelligenz

Nicht mehr „Sam Sung“: Ex-Apple-Mitarbeiter mit neuem Namen

Eine Geschichte, die vor dreizehn Jahren in der Apple-Szene für Schmunzeln sorgte, hat nun ein (glückliches) Ende gefunden: Der ehemalige Apple-Retail-Mitarbeiter mit dem für den iPhone-Hersteller eher unpassenden Namen Sam Sung hat sich offiziell umbenannt. Aus Sam Sung wird nun „Sam Struan“, teilte der heute 36-Jährige in einem Gastbeitrag auf der US-Wirtschaftsseite BusinessInsider mit. Die Umbenennung sei auch deshalb erfolgt, weil sein Geburtsname derart viral gegangen sei.

Weiterlesen nach der Anzeige

Von Schottland nach Kanada

Struan hatte zuvor in mehreren Apple-Läden gearbeitet: Zunächst im schottischen Glasgow, später dann im kanadischen Vancouver. Struan hatte zuletzt die Stelle als „Specialist“ inne, und dafür auch entsprechende Visitenkarten. Einer der Kunden bekam diese 2012 in die Hände und postete sie schließlich auf Twitter, was eine ganze virale Welle lostrat. Struan nahm das sichtlich mit, er löschte sein LinkedIn-Profil unter dem Namen. 2013 verließ er schließlich Apple und versteigerte dann ein Jahr später Teile seiner Apple-Kleidung samt „Name Badge“ und Visitenkarten zu Gunsten einer Kinderstiftung.

Die Namensänderung nahm er dann nach eigenen Angaben vor, weil er „nicht bekannt für einen Internetwitz“ sein wollte. „Struan“ hat für ihn eine Bedeutung, das sei sein Liebingsort in Schottland. Heute sieht Struan die Situation allerdings etwas anders als noch 2012. Damals habe er befürchtet, durch den Wirbel womöglich seinen Job zu verlieren. „Ich hatte so viel Angst, ich wollte einfach nur nicht auffallen und weiter arbeiten.“ Rückblickend sei das lustig: „Ich hatte in diesem Moment wahrscheinlich die höchste Arbeitsplatzsicherheit, die ich je hatte. Hätte Apple mich gefeuert, hätte das noch mehr Aufruhr verursacht.“

Reporter im Laden auf der Suche nach Sam Sung

Damals seien Reporter in den Laden gekommen. „Apple hat mich deshalb zunächst von der Verkaufsfläche genommen.“ Seinen Kollegen habe man gesagt, ihn gegenüber Dritten nicht zu identifizieren. Visitenkarten gab es für ihn dann nicht mehr. „Die Leute kamen in den Laden und fragten, ob Sam Sung im Geschäft arbeitet. Ich habe dann so getan, als wäre ich das nicht.“ Am Telefon habe man ihn schon aufgrund seines schottischen Akzents nicht erkannt. Immerhin sei der Aufruhr dann nach einigen Monaten abgeebbt.

Struan hatte später auch ein anderes Problem: Nachdem er sich im Bereich Berufeconsulting zu etablieren versuchte, waren aufgrund des alten Namens kaum Möglichkeiten vorhanden, zur Marke zu werden. „Die Big-Tech-Firma hat schon ihre eigene Marke.“ Es sei also sinnvoll gewesen, den Namen zu ändern. Heute wünschte er, seinem jüngeren Ich sagen zu können, dass die Sache doch lustig gewesen sei. „Ich hätte mir keine Gedanken über meinen Job machen müssen.“ Besser wäre es gewesen, das LinkedIn-Profil offen zu halten und den Leuten zu danken, die sich damals bei ihm gemeldet hätten. „Ich hätte das Ganze als das, was es war, mehr genießen können.“

Weiterlesen nach der Anzeige

(bsc)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 1 Woche

UX/UI & Webdesignvor 1 WocheIllustrierte Reise nach New York City › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?