Online Marketing & SEO

OpenAI startet gpt-realtime: So menschlich klang KI noch nie

Das Modell versteht sogar Nuancen wie „sprich schnell und professionell“ oder „antworte empathisch mit französischem Akzent“. Damit erhalten Entwickler:innen ein Werkzeug, das Stimmen nicht nur natürlicher, sondern auch gezielt charaktervoll macht.

Weitere neue Werkzeuge

Die Realtime API wird mit diesem Release deutlich vielseitiger. OpenAI ergänzt gleich mehrere Funktionen, die das Einsatzfeld erweitern:

- Remote MCP Server: Externe Tools können angebunden werden, ohne dass Entwickler:innen eigene Schnittstellen bauen müssen.

- Bild-Input: Screenshots oder Fotos lassen sich ins Gespräch einfügen. Die KI kann Texte vorlesen oder visuelle Inhalte beschreiben.

- SIP-Telefonie: Über das Session Initiation Protocol (SIP) können Unternehmen ihre Telefonanlagen direkt anbinden – vom Callcenter bis zum klassischen Festnetztelefon.

- Wiederverwendbare Prompts: Standardisierte Gesprächsabläufe können gespeichert und mehrfach eingesetzt werden, ähnlich wie Makros in der Softwareentwicklung.

Damit öffnet OpenAI die Tür für Anwendungen, die weit über den Support hinausgehen. Lernplattformen könnten etwa Bilder von Aufgaben einbinden und die KI Lösungen erklären lassen. Gesundheitsdienste könnten Symptome aufnehmen und parallel mit Fachsystemen abgleichen.

Erste Tests: Was Zillow, T-Mobile und Co. schon machen

Dass das Modell mehr ist als ein Laborprojekt, zeigt ein Blick auf die Partner:innenunternehmen. Zillow, eine der größten Immobilienplattformen in den USA, testet gpt-realtime bereits. Josh Weisberg, Head of AI bei Zillow, erklärt, die neue Sprachschnittstelle könne Nutzer:innen durch die Immobiliensuche führen „as natural as a conversation with a friend“. Das System könne Kriterien wie Lebensstil oder Budget berücksichtigen und gleichzeitig Finanzierungshilfen erläutern.

Auch T-Mobile, StubHub oder Oscar Health setzen auf erste Tests. Sie alle haben eines gemeinsam: Sie arbeiten in Bereichen, in Wenn Sprach-KI in diesen Szenarien zuverlässig eingesetzt werden kann, etabliert sich womöglich in mehr Feldern als praxistaugliches Produktivwerkzeug

Preise und Verfügbarkeit: Sprach-KI wird günstiger

Die allgemein verfügbare Realtime API sowie das neue Modell gpt-realtime stehen Entwickler:innen ab sofort zur Verfügung. OpenAI senkt die Preise um rund zwanzig Prozent im Vergleich zur Vorgängerversion gpt-4o-realtime-preview. Eine Million Audioeingabe-Tokens kostet jetzt 32 US-Dollar (zwischengespeicherte Tokens: 0,40 US-Dollar), die Audioausgabe liegt bei 64 US-Dollar pro Million Tokens.

Zusätzlich führt OpenAI eine feinere Steuerung für den Konversationskontext ein. Entwickler:innen können damit Token-Limits setzen und mehrere Gesprächsrunden gleichzeitig kürzen. Das macht lange Sessions deutlich günstiger.

Das Preismodell richtet sich klar an Unternehmen, die Sprach-KI nicht nur testen, sondern in großem Maßstab ausrollen wollen. Für kleinere Projekte oder Startups bleibt die Einstiegshürde zwar bestehen, doch die Preissenkung signalisiert: OpenAI will Sprach-KI breiter verfügbar machen. Wer direkt starten möchte, findet Einstiegshilfen in der Realtime API-Dokumentation, kann das Modell im Playground ausprobieren und im Prompting Guide Tipps für den Einsatz abrufen.

Datenschutz und Sicherheit

Ein zentraler Punkt sind Datenschutz und Missbrauchsrisiken. OpenAI betont, dass die Realtime API vollständig EU Data Residency unterstützt. Damit können europäische Unternehmen die Technologie einsetzen, ohne Daten in die USA auslagern zu müssen.

Zusätzlich gibt es ein mehrstufiges Sicherheitssystem: aktive Inhaltsfilter, verpflichtende Kennzeichnung von KI-Dialogen und die Möglichkeit für Entwickler:innen, eigene Schutzmaßnahmen über das Agents SDK zu ergänzen. Ziel ist es, Vertrauen aufzubauen – sowohl bei Nutzer:innen als auch bei den Unternehmen, die KI einsetzen.

Einordnung im Markt: OpenAI will den Standard setzen

Mit gpt-realtime bewegt sich OpenAI in einem Feld, das längst umkämpft ist. Neben Google und Microsoft arbeiten auch Startups wie Deepgram oder Speechmatics an Echtzeitsprachsystemen. OpenAI verfolgt jedoch eine eigene Strategie: nicht nur technische Machbarkeit zu demonstrieren, sondern Lösungen zu liefern, die sofort im Alltag einsetzbar sind. Diese Kombination aus Qualität, Zusatzfunktionen und enger Zusammenarbeit mit Kund:innen verschafft dem Unternehmen einen spürbaren Vorsprung.

Die Botschaft ist klar: Die Zeit maschinell klingender Bots geht zu Ende. Mit gpt-realtime und der Realtime API etabliert OpenAI eine neue Kategorie von Sprach-KI, die Dialoge statt Scripts liefert. Für Unternehmen bedeutet das mehr als reine Effizienzgewinne. Sie können Kund:innen Erlebnisse bieten, die menschlich wirken – ob im Support, in der Beratung oder im Bildungsbereich.

Mit sinkenden Preisen, EU-konformem Datenschutz und ersten Tester:innen wie Zillow oder T-Mobile zeigt OpenAI, wohin sich der Markt bewegt. Wer künftig ein Unternehmen anruft, könnte nicht mehr merken, ob ein:e Mitarbeiter:in oder ein KI-System antwortet.

„Sag mir, wer ich bin“ –

der Hype um Persönlichkeits‑Prompts mit ChatGPT

Online Marketing & SEO

Fehler im YouTube-Video? So einfach integrierst du Korrekturen

Wir zeigen dir, wie du ganz einfach Korrekturen für deine YouTube-Videos einfügst, die die Viewer auch direkt sehen können.

Du hast gerade dein neuestes Video auf YouTube hochgeladen, da fällt dir auf, dass du einen Fehler eingebaut hast? Dann musst du das Video nicht wieder löschen und bearbeiten oder gar neu aufnehmen, ehe du es erneut hochlädst. Du kannst auch einfach Korrekturen einfügen, die via Info-Icon im Clip angezeigt werden. Wie das funktioniert, erklärt Rene Ritchie von der YouTube Liaison für den Kanal YouTube Insider.

Creator sein, ohne Content zu filmen?!

YouTube macht es möglich

Schnell Korrekturen in deine YouTube-Videos einbauen: So geht’s

Wenn du einen Fehler in einem deiner YouTube-Videos entdeckst, kannst du über die Beschreibung ganz einfach Korrekturen einbauen. Wenn du diese mit Time Stamps und einer Erklärung versiehst, finden Viewer zum einen in der Beschreibung die Hinweise und Richtigstellungen. Zum anderen liefert YouTube ein passendes Info-Icon am oberen rechten Bildrand des Videos, das auf die Beschreibung samt Anpassungen verweist und für User gut sichtbar ist.

Um diese Art der Korrektur einzufügen, solltest du die folgenden Schritte befolgen:

- Melde dich im YouTube Studio an.

- Wähle im Menü links den Bereich Content aus.

- Wähle das Video aus, das du bearbeiten möchtest.

- Klicke auf Details.

- Beginne in der Beschreibung eine neue Zeile und schreibe „Correction(s):“ oder „Korrektur(en):“ samt Doppelpunkt.

- Setze in einer neuen Zeile den passenden Time Stamp, etwa „1:00“, der mit dem Beginn des Fehlers im Video korrespondiert.

- Ergänze neben dem Time Stamp eine Erklärung zur Korrektur.

- In neuen Zeilen kannst du weitere Korrekturen einfügen.

Wer diese Punkte beachtet, sollte im Video dann auch das zuvor erwähnte Info-Icon sehen, das passend zu den Korrekturen im Video bei den Zeiten der Time Stamps angezeigt wird. Diese Informationen hat Rene Ritchie in einem Erklärvideo für den Creator Insider Channel geteilt. In diesem Video siehst du, wie die Korrekturen aussehen können.

Online Marketing & SEO

Neustart der Marke: Anke Engelke ist nicht genug: Warum die Deutsche Bahn jetzt Zeit braucht

Anke Engelke und Michael Peterson, DB-Vorstand Personenfernverkehr, bei der Vorstellung der Webserie in Frankfurt

Mit dem Launch ihrer neuen selbstironischen Webserie mit Anke Engelke hat die Deutsche Bahn für Aufsehen gesorgt. Doch werden die Reisenden deshalb wirklich eine andere Einstellung zu der schwer kriselnden Marke entwickeln? Das hängt von einigen Faktoren ab.

Wird Anke Engelke das Image der Deutschen Bahn nun retten? Reichen einige überaus amüsante Folgen der unternehmenseigenen Webserie „Boah, Ba

Diesen Artikel gratis weiterlesen!

Jetzt kostenfrei registrieren.

Die Registrierung beinhaltet

das HORIZONT Newsletterpaket.

Sie sind bereits registriert?

Hier anmelden

Der Nutzung Ihrer Daten können Sie jederzeit widersprechen. Weitere Hinweise finden Sie unter Datenschutz.

Online Marketing & SEO

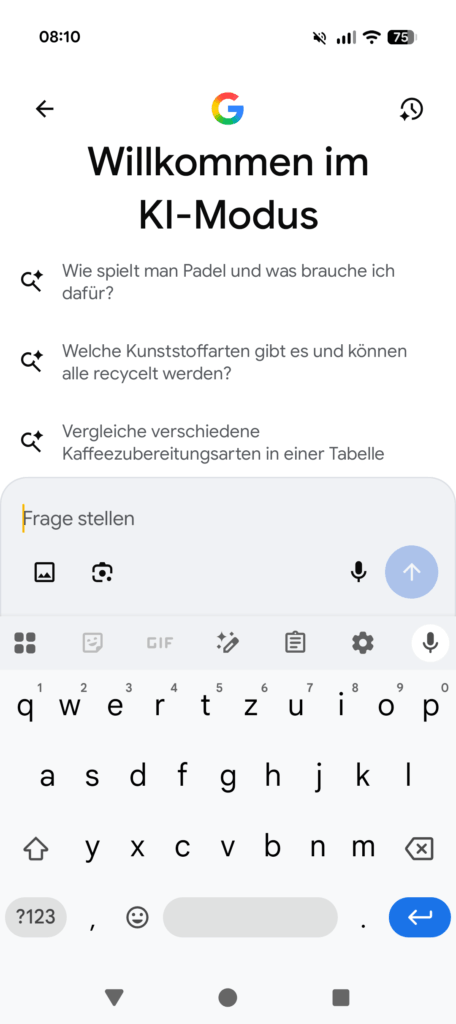

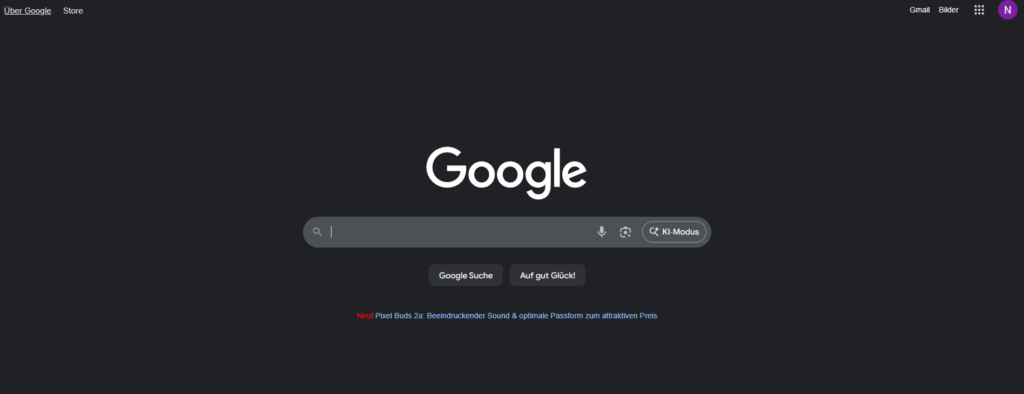

Du kannst jetzt Googles AI Mode in Deutschland nutzen

Der AI Mode von Google ist in Deutschland angekommen. Du kannst ihn jetzt mobil via Desktop auf Deutsch nutzen. Bald kommt auch die KI-Visual-Kreation von Nano Banana zu Lens und dem AI Mode in die Suche.

Auf Deutsch war der AI Mode schon seit dem 7. Oktober verfügbar. Den Roll-out für diverse Regionen in Europa, darunter Deutschland, kündigte Google zur gleichen Zeit an. Doch zunächst mussten die User sich gedulden, bis Google die Server umgestellt und die Suche auch hierzulande für den neuen KI-Modus eingestellt hatte. Jetzt ist es so weit und Nutzer:innen können in Deutschland den KI-Modus einsetzen, wenn sie mobil oder auf dem Desktop die Google-Suche nutzen. Dabei soll der Modus bald mit weiteren Features versehen werden, von Nano Banana bis hin zu Ads.

Endlich, oder doch nicht?!

Googles AI Mode startet in Deutschland

Googles AI Mode in Deutschland: So kannst du ihn einsetzen

Wir haben den AI Mode oder KI-Modus, wie er in Deutschland heißt, inzwischen in der Google App auf einem Android-Gerät und in der Desktop-Suche als Option. Um ihn einzusetzen, kannst du einfach in der App oder auf dem Desktop das Lupen-Icon samt Sternmotiv anklicken – auf dem Desktop steht auch „KI-Modus“ dahinter.

Im AI Mode kannst du deine Fragen stellen, auch per Stimme, auf vorgeschlagene Fragen von Google eingehen oder multimodal mithilfe von Bilder aus deiner Galerie oder Aufnahmen mit der Kamera suchen. Google rät dabei:

Je genauer die Frage, desto besser die Antwort.

Auch deinen KI Modus-Verlauf kannst du aufrufen, über das Uhren-Icon mit dem Sternmotiv, um zu sehen, welche Fragen du der KI bereits gestellt hast.

So funktioniert der AI Mode

Das Suchen mit Google wird immer einfacher. Dafür sorgt insbesondere der noch junge AI Mode. Als konversationelle KI-Unterstützung mit multimodalen Fähigkeiten bietet er im Vergleich zu den AI Overviews deutlich ausführlichere Antworten, etwa auf Fragen, die mehr rationale Evaluierung, Vergleichsgrößen oder weiterführende Sondierungen benötigen. Der AI Mode soll Usern erlauben, nuancierte Fragen zu stellen und eine ausführliche Antwort zu erhalten, für die es ohne den Modus mehrere Anfragen gebraucht hätte. Dabei unterstützt eine maßgeschneiderte Version von Gemini 2.5 den Modus. Shopping-Daten, Echtzeitinformationen und die wichtigsten Quellen werden herangezogen, um verständliche und passende Antworten zu finden.

Dafür fasst Google diverse verwandte Suchkontexte zu Unterthemen parallel zusammen und kreiert eine auf die Suchintention zugeschnittene Antwort. Mit dem als Fan-out-Praktik für Suchanfragen bezeichneten Verfahren nutzt Google ein umfassendes Reasoning. Dabei werden die Suchanfragen in Unterkategorien aufgeteilt, zu denen die KI unterschiedliche Suchen unternimmt, um sowohl aus dem Web als auch von Google – etwa aus Knowledge Graphs – relevante Informationen zusammenzutragen. Diese Antworten spielt der AI Mode inzwischen auch bei multimodalen Suchen aus. So können erste User in den USA mit Search Live und einer neuen Visual Search inzwischen sogar finden, was sie nur mit Bildern suchen und wofür sie gar nicht die passenden Worte haben – etwa dann, wenn sie nach einem bestimmten Vibe oder Chic suchen.

Dabei unterstützt das stetig verbesserte Gemini-KI-Modell im Hintergrund. Googles KI-Modus in der Suche steht für einen Wandel in der Art, wie Informationen verstanden und verarbeitet werden. Laut dem Tech-Publisher Engadget hilft die verbesserte Argumentationsfähigkeit des jüngsten Gemini-Modells im Kontext KI-Suche dabei, die Feinheiten lokaler Sprachen besser zu verstehen. Der AI Mode erkennt also beispielsweise, was Nutzer:innen wirklich meinen, auch dann, wenn Formulierungen kulturell geprägt oder mehrdeutig sind. Laut Artificial Analysis ist Googles Gemini 2.5 Native Audio Thinking das derzeit führende Speech-to-Speech-Modell bei der Big Bench Audio Benchmark.

Google’s Gemini 2.5 Native Audio Thinking is the new leading Speech to Speech model per our Artificial Analysis Big Bench Audio benchmark

The new model achieves a score of 92% on Big Bench Audio, the highest result recorded by Artificial Analysis to date. This not only places it… pic.twitter.com/T2MTVHNhzp

— Artificial Analysis (@ArtificialAnlys) October 13, 2025

Nano Banana kommt auch in den AI Mode

Und die Suchfähigkeiten über die konversationelle KI, die als ChatGPT-Alternative dient, werden stetig erweitert. Neuerdings integriert Google das KI-Bild- und Videogenerierungsmodell Nano Banana via Lens und AI Mode in die Suche. Dann können User direkt mithilfe des AI Mode besondere Bilder und Bildreihen erstellen – ohne dafür auf andere Dienste wie ChatGPT oder Midjourney auszuweichen.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenSo baut Googles NotebookLM aus deinen Notizen KI‑Diashows