Künstliche Intelligenz

Waveguides erklärt: So funktioniert das Display in Smart Glasses und AR-Brillen

Waveguides oder Wellenleiter, wie man sie auf Deutsch nennt, kann man sich als Bahnen vorstellen, die Licht, Radiowellen oder Schall gezielt von einem Ort zum nächsten führen. Die Waveguide-Displays in Smart Glasses und AR-Brillen sind eine spezielle Form von Waveguides, die für die präzise Führung von Licht entwickelt wurden. Daher spricht man in diesem Zusammenhang auch von optischen Waveguides.

Optische Waveguides sind eine weitverbreitete Form von Wellenleitern: In Gestalt von Glasfasernetzen etwa bilden sie die Grundlage für das Internet und die moderne Telekommunikation. Während Glasfasern kabelartig und biegsam sind und moduliertes Infrarotlicht über weite Strecken transportieren, sind die optischen Waveguides in Smart Glasses und AR-Brillen flach und starr und leiten sichtbares Licht über wenige Zentimeter direkt ins Auge.

So funktionieren Waveguide-Displays

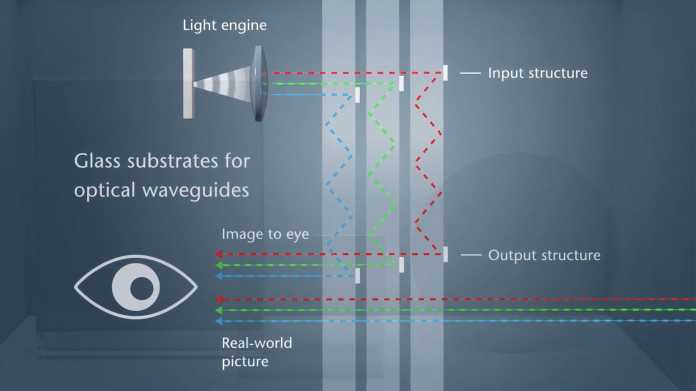

Ein Waveguide-Brillendisplay besteht im Wesentlichen aus zwei Bausteinen: der Light Engine, die meist im vorderen Bereich des Brillenbügels nahe dem Scharnier sitzt, und dem Waveguide selbst, der die Linse oder einen Teil dieser bildet.

Die Light Engine hat zwei zentrale Funktionen: Zum einen liefert sie die Lichtquelle und erzeugt ein winziges Bild mithilfe eines Mikrodisplays, wobei je nach Produkt unterschiedliche Technologien wie LCoS, Micro-OLED oder MicroLED zum Einsatz kommen. Zum anderen richtet sie die Lichtstrahlen aus und führt sie im erforderlichen Winkel in den Waveguide ein.

Der Waveguide selbst besteht aus einem Substrat mit möglichst hohem Brechungsindex. Meist handelt es sich um speziell angefertigtes Glas oder Kunststoff. Der Waveguide hat drei wichtige Aufgaben: Er koppelt das Licht der Light Engine ein, führt es entlang der Linse an seinen Bestimmungsort und koppelt es dort wieder aus, sodass es gezielt ins Auge des Brillenträgers gelangt.

Auf dem Bild gut zu sehen: Beidseitige Light Engines und Waveguides.

(Bild: Schott)

Auf seinem Weg durch den Waveguide bleibt das Licht durch ein physikalisches Phänomen namens Totalreflexion im Substrat eingeschlossen und bewegt sich darin wie in einem Spiegelkorridor. Totalreflexion tritt auf, wenn Licht aus einem Medium mit höherem Brechungsindex (Waveguide-Substrat) auf ein Medium mit niedrigerem Brechungsindex (meistens Luft oder eine umgebende Trägerlinse aus Glas oder Kunststoff) trifft. Ob es im Substrat bleibt, hängt vom Einfallswinkel ab: Überschreitet dieser den sogenannten kritischen Winkel, wird das Licht vollständig reflektiert. Je größer der Unterschied zwischen den Brechungsindizes ist, desto größer ist auch der Winkelbereich, in dem das Licht im Substrat gehalten werden kann. Dadurch verbessert sich die Effizienz der Lichtführung, und die Waveguides können dünner und kompakter konstruiert werden.

Beim Auskoppeln des Lichts schließlich wird das ursprünglich winzige Bild der Light Engine vom Waveguide aufgefächert und erzeugt so den Eindruck einer im Raum schwebenden Bildfläche, die kleinere oder größere Teile des Sichtfelds füllt.

Letzten Endes muss ein Waveguide-Display zweierlei leisten: Es führt künstliches Licht gezielt ins Auge und damit ins Sichtfeld, während es zugleich natürliches Licht durch seine Oberfläche passieren lässt, sodass die Umgebung sichtbar bleibt. Aus der Kombination beider Lichtquellen ergeben sich digitale Einblendungen, die die physische Welt überlagern und erweitern.

Das Funktionsprinzip eines Diffractive Waveguide: Einkopplung, Führung und Auskopplung des Lichts bei gleichzeitiger Transparenz zur Außenwelt.

(Bild: Schott)

Die Transparenz ist eine entscheidende Eigenschaft: Sie unterscheidet Waveguide-Displays von klassischen Displays in Mixed-Reality-Headsets wie der Meta Quest 3 oder Apple Vision Pro. Dort sitzt ein LCD- oder OLED-Bildschirm direkt vor den Augen, der den Blick auf die Außenwelt vollständig blockiert. Das reale Umfeld wird von Kameras aufgenommen und als Videobild wiedergegeben: eine Technik, die „Passthrough“ genannt wird und sich grundlegend vom „Seethrough“ optischer Display-Systeme wie Waveguides unterscheidet. Schaltet sich ein Mixed-Reality-Headset aus, sitzt man im Dunkeln. Fällt dagegen ein Waveguide-Display aus, bleibt die Umgebung weiterhin sichtbar. Die Lichtdurchlässigkeit kann jedoch von Waveguide zu Waveguide variieren.

Es gibt unterschiedliche Waveguide-Displays

Es gibt verschiedene Arten von Waveguides, die sich primär darin unterscheiden, wie sie Licht ein- und auskoppeln. Die häufigste Sorte sind Diffractive Waveguides, die das Licht der Light Engine mithilfe von ins Waveguide-Substrat eingeprägten Nanostrukturen beugen („Diffraction“ ist das englische Wort für Beugung). Diffractive Waveguides kommen in vielen bekannten Geräten wie Hololens, Magic Leap, den aktuellen Snap Spectacles sowie Metas Orion-Prototyp zum Einsatz.

Eine weitere, im Aufkommen begriffene Art von Waveguide-Display sind Geometric Reflective Waveguides, deren Entwicklung maßgeblich vom Waveguide-Pionier Lumus vorangetrieben wird. Diese Sorte von Waveguide kommt in der Meta Ray-Ban Display zum Einsatz. Ihren Namen tragen diese Waveguides, weil sie auf klassischen geometrischen Lichtwegen mit Spiegeln und Prismen basieren, im Gegensatz zu Diffractive Waveguides, die das Licht durch Beugung lenken. Statt Nanostrukturen leiten hier Schichten semitransparenter Spiegelchen das Licht ins Auge. „Die Bildqualität ist über die geometrische Anordnung dieser Spiegelchen definiert“, erklärt Rüdiger Sprengard, Head of Augmented Reality beim deutschen Spezialglashersteller und Lumus-Partner Schott, der Waveguides beider Arten fertigt.

In der Meta Ray-Ban Display lässt sich die erste Spiegelreihe noch erkennen, die restlichen bleiben unsichtbar.

(Bild: Lumus / Meta)

Beide Waveguide-Sorten erfordern unterschiedliche Fertigungsprozesse mit jeweils eigenen Herausforderungen, die die Ausbeute beeinträchtigen können. Bei Diffractive Waveguides müssen Strukturen im Nanometerbereich über linsenartige Flächen hinweg mit nahezu null Defekten eingeprägt werden. Geometric Reflective Waveguides wiederum erfordern ein äußerst präzises Beschichten und Anordnen halbspiegelnder Oberflächen auf Glas, wobei schon kleinste Abweichungen Helligkeitsunterschiede oder Farbstörungen verursachen können.

Ein schematischer Vergleich zwischen Diffractive und Geometric Reflective Waveguides.

(Bild: tobe)

Lange war unklar, ob Geometric Reflective Waveguides überhaupt jemals in großen Stückzahlen produziert werden können. Inzwischen hat Schott die Serienfertigung gemeistert. Und laut Metas Technikchef Andrew Bosworth ist es Schott, das die Waveguides für die Meta Ray-Ban Display in Malaysia fertigt.

Licht beugen oder reflektieren: Stärken und Schwächen

Die Vor- und Nachteile der beiden Waveguide-Sorten lassen sich gut an Metas Brillenmodellen ablesen. Vor einem Jahr präsentierte Meta den technisch eindrucksvollen AR-Brillenprototyp Orion, der Diffractive Waveguides nutzt. Diesen Monat folgte die Ankündigung der marktreifen Smart Glasses Meta Ray-Ban Display, die stattdessen auf ein Geometric Reflective Waveguide setzt. Hat Meta binnen eines Jahres die Waveguide-Sorte gewechselt? Keineswegs, denn die Modelle gehören unterschiedlichen Produktkategorien mit jeweils eigenen Anforderungen an.

Orion stellt den Versuch dar, eine vollwertige AR-Brille mit möglichst schlankem Formfaktor zu entwickeln: Sie bietet ein besonders weites Sichtfeld für digitale Einblendungen, kann die Umgebung räumlich erfassen und digitale Objekte darin verankern. Neben Blick- und Handerfassung ist sie potenziell auch in der Lage, 3D-Grafik anstelle bloßer Bildflächen darzustellen. Bis zur technologischen und kommerziellen Reife von Metas AR-Vision dürften allerdings noch ein paar Jahre vergehen.

Das Diffractive Waveguide in Meta Orion ermöglicht ein weites Sichtfeld.

(Bild: Meta)

Mit der Meta Ray-Ban Display verfolgt Meta derweil ein bescheideneres Ziel: Die bislang displaylosen Smart Glasses der Marke Ray-Ban Meta werden um eine kleine Anzeige im rechten Auge erweitert, die verschiedene Funktionen erfüllt. Sie blendet etwa Antworten des KI-Assistenten Meta AI ein, zeigt Nachrichten aus Whatsapp, Messenger und Instagram an, dient als Sucher für Fotos und Videos und unterstützt Nutzer mit visueller Navigation.

Die Meta Ray-Ban Display bietet ein Heads-up-Display (HUD) statt eines weiten AR-Sichtfelds. Die digitale Anzeige erscheint im Raum vor dem Nutzer, nicht auf der Linse, wie auf dem Bild dargestellt.

(Bild: Meta)

Eine der Stärken von Diffractive Waveguides ist, dass sie ein besonders weites Sichtfeld ermöglichen, weshalb Meta bei Orion auf diese Waveguide-Sorte setzte. Bei Diffractive Waveguides spielt der Brechungsindex des Substrats eine zentrale Rolle: Je höher er ist, desto größer kann das digitale Sichtfeld ausfallen. Mit einem Waveguide-Substrat aus Siliziumkarbid statt Glas erreicht Orion ein für diesen Formfaktor ungewöhnlich weites Sichtfeld von 70 Grad. Das entspricht einer rund 16-mal so großen digitalen Projektionsfläche im Vergleich zur Ray-Ban Meta Display. Gleichzeitig reduziert Siliziumkarbid eine der größten Schwächen von Diffractive Waveguides: die wellenlängenabhängige Lichtbeugung, die häufig Farbverzerrungen und Regenbogeneffekte verursacht. Der Haken: Siliziumkarbid ist in der Herstellung so aufwendig, dass eine Kommerzialisierung derzeit nicht infrage kommt.

Da für die Ray-Ban Meta Display ohnehin kein großes Sichtfeld vorgesehen ist, fiel Metas Wahl auf ein Geometric Reflective Waveguide, das günstiger herzustellen ist und in anderen Leistungsbereichen Vorteile bietet. Diese Art von Waveguide nutzt semitransparente Spiegel, die das Licht nahezu verlustfrei und unabhängig von der Wellenlänge reflektieren. Dadurch erreicht das Waveguide-Display eine deutlich höhere Bildqualität, Helligkeit und Effizienz als Diffractive Waveguides und ermöglicht so ein Smart-Glasses-Display, das einige Stunden nutzbar ist und auch im Freien bei hellem Tageslicht sichtbar bleibt.

Das Geometric Reflective Waveguide der Meta Ray-Ban Display eignet sich für den Einsatz im Freien.

(Bild: Meta)

Ein weiterer Vorteil des Geometric Reflective Waveguide ist, dass das Display für Außenstehende kaum sichtbar ist. Diffractive Waveguides erzeugen dagegen oft störende Reflexionen nach außen, die den Blickkontakt beeinträchtigen können. „Das Problem ist, dass diese Waveguides nicht richtungsselektiv sind. Die wollen genauso viel Bild zur Außenwelt schicken wie ins Auge. Die Spiegelchen [der Geometric Reflective Waveguides] hingegen haben ganz wenig Reflexionen zur Welt hin“, sagt Sprengard und bezeichnet diesen Umstand als ein „Geschenk der Natur“.

Für Sprengard ist noch offen, welche Art von Waveguide sich am Ende durchsetzen wird. Fest steht jedoch, dass sich beide Technologien weiterentwickeln werden. Substrate mit höherem Brechungsindex und neue, präzisere Prägungstechniken aus der Halbleiterfertigung könnten die Schwächen von Diffractive Waveguides verringern, während Geometric Reflective Waveguides beim Sichtfeld aufholen werden, da dieses hier weniger stark vom Brechungsindex abhängt. Lumus hat bereits angekündigt, im nächsten Jahr ein neues Waveguide-Design vorzustellen, dessen Sichtfeld mit Orion konkurrieren könnte. Abseits von Waveguides wird zugleich an leistungsfähigeren Light Engines gearbeitet, dem zweiten Baustein von Waveguide-Brillendisplays.

heise online XR-Briefing abonnieren

Jeden zweiten Montag, liefern wir Ihnen die wichtigsten Entwicklungen der XR-Branche. Damit Sie alles im Blick behalten.

E-Mail-Adresse

Ausführliche Informationen zum Versandverfahren und zu Ihren Widerrufsmöglichkeiten erhalten Sie in unserer Datenschutzerklärung.

Neben Diffractive und Geometric Reflective Waveguides gibt es weitere Sorten von Waveguide-Displays. Sollten Smart Glasses wie die Ray-Ban Meta Display erfolgreich sein, könnte das die Forschung und Entwicklung beschleunigen und die Entstehung von neuen Arten und Unterarten vorantreiben. Zwar existieren auch ganze andere Display-Ansätze wie Birdbath-Optik, doch Waveguides gelten derzeit als die vielversprechendste Technologie, um alltagstaugliche Smart Glasses und AR-Brillen Wirklichkeit werden zu lassen.

Dass die Technologie nach vielen Jahren endlich marktreif wird und Verbraucher erreicht, sieht Sprengard als wichtigen Meilenstein: „Das ist der Anfang von etwas, das die Art und Weise, wie wir Unterhaltungselektronik im Alltag benutzen, verändern wird.“

(tobe)

Künstliche Intelligenz

Space Forge erhitzt erstmals Fertigungsofen im Weltall auf 1000 Grad

Das Unternehmen Space Forge aus Cardiff, Wales, hat seinen Fertigungsofen im Satelliten ForgeStar-1 erfolgreich angeschaltet und auf 1000 Grad erhitzen können. In solchen Öfen will Space Forge künftig Materialien für die Chipproduktion herstellen, die weniger Verunreinigungen aufweisen. Space-Forge-CEO Josh Western betonte gegenüber der BBC, dass ihre Arbeit dabei helfe, „Halbleitermaterialien im All mit bis zu 4.000-fach höherer Reinheit herzustellen als derzeit auf der Erde.“

Weiterlesen nach der Anzeige

Der Satellit ForgeStar-1 sendete das folgendes Bild der erfolgreichen Erzeugung von Plasma zurück an Space Forge.

(Bild: Space Forge)

Die Bedingungen im Weltall sind durch die Schwerelosigkeit perfekt für die Herstellung von Chipmaterialien geeignet. Kristalle würden sich besser bilden und das Vakuum helfe dabei, dass weniger Unreinheiten eindringen.

Weitere Tests folgen

Der Satellit ForgeStar-1 mit dem etwa mikrowellengroßen Ofen wurde am 27. Juni vergangenen Jahres an Bord der Transporter-14 von SpaceX zusammen mit 70 weiteren Nutzlasten auf eine sonnensynchrone Umlaufbahn befördert.

Es ist noch nicht ganz klar, wie die erzeugten Materialien wieder zurück auf die Erde gelangen. Ein Hitzeschild mit dem Namen „Pridwen“, benannt nach dem Schild von König Arthur, soll in einer zukünftigen Mission getestet werden. Es könnte den Satelliten samt seiner wertvollen Fracht bei der Rückkehr schützen. ForgeStar-1 ist dieses Schicksal nicht beschert, es soll am Ende der Testphase kontrolliert in der Erdatmosphäre verglühen. Ebenfalls nicht berücksichtigt sind die Auswirkungen auf die Umwelt: Es müssen nämlich mehrfach Raketen mit den Rohstoffen zu den Öfen hochgeschossen werden, die dann wiederum die produzierten Halbleitermaterialien zurückbringen.

(wid)

Künstliche Intelligenz

Die zehn besten VR-Spiele der Dekade

Im Jahr 2016 hauchten die Oculus Rift, die HTC Vive und die Playstation VR dem Medium Virtual Reality endlich neues Leben ein. Nachdem die Technik in den Neunzigern gescheitert war, war es inzwischen möglich, sich in eindrucksvolle Welten zu versetzen – sei es in Rennspielen, vollwertigen Story-Abenteuern oder ganz neuen Konzepten. heise online hat vier seiner größten Immersions-Fans versammelt, um die zehn größten VR-Spielehighlights der vergangenen Dekade zu feiern.

Weiterlesen nach der Anzeige

Dabei spielt das Ökosystem keine Rolle. Wir berücksichtigen PC-VR-Plattformen wie SteamVR, Konsolen-Headsets wie PS VR 1 und 2 sowie Standalone-Geräte wie Meta Quest oder Pico. Ausgeklammert haben wir lediglich Simulationen, Fitness-Apps und Mixed-Reality-Titel, bei denen sich die Grafik mit der realen Umwelt vermischt. Auch sie sind ein wichtiger und unheimlich faszinierender Teil des Mediums. In diesem Artikel wollten wir uns aber ganz auf unsere persönlichen VR-Spiele-Favoriten der vergangenen zehn Jahre konzentrieren.

Innerhalb der zehn alphabetisch sortierten Titel gibt es keine Reihenfolge. Stattdessen hat sich jeder Redakteur einige Titel vorgenommen, die ihn besonders stark beeindruckt und geprägt haben. Oft fiel es schwer, sich auf nur zehn Highlights zu beschränken und auf prägende Titel zu verzichten – darunter Lone Echo, Asgard’s Wrath oder den zum Spiel angewachsenen, aber technisch holprig gestarteten Microsoft Flight Simulator 2024. Wir sind gespannt auf Ihre VR-Highlights in den Kommentaren!

Astro Bot Rescue Mission

Plattformen: PS VR

Gefeiert von: Jan Philipp Wöbbeking

Sonys Überraschungshit „Astro Bot Rescue Mission“ ist nicht nur pure gute Laune in Form eines VR-Spiels, sondern auch unglaublich gut darin, den Spieler aktiv werden zu lassen. Im Oktober 2018 konnte ich kaum fassen, wie kreativ ich ins Hüpfspielabenteuer einbezogen wurde. Wie bei Mario steuert man den charmant animierten Helden mit dem linken Stick, doch zusätzlich bewegt man auch den gewöhnlichen PS4-Controller durch den Raum, um auf der Suche nach verschollenen Robotern zu helfen.

Mal schleudert man Astro Bot beim Seiltanz meterweit in die Höhe, anderswo kühlt man mit einer Wasserkanone die tödliche Lava unter seinen Füßen ab. Manchmal muss man sogar eine Wand mit einem Kopfstoß zertrümmern. Die Abwechslung ist hier ähnlich groß wie die Bossgegner. Einen VR-Nachfolger gab es bisher leider nicht. Die technische Brillanz von Sonys japanischem Studio Asobi wird aber auch in den PS5-Ablegern Astro’s Play Room und Astro Bot mehr als deutlich.

Weiterlesen nach der Anzeige

Batman: Arkham Shadow

Plattformen: Meta Quest

Gefeiert von: Josef Erl

Kein anderes Batman-Spiel verleitet mich so sehr dazu, „Ich bin Batman!“ zu brüllen, während ich mich aus dem Schatten auf einen üblen Schlägertyp stürze, wie Metas Exklusivtitel. „Batman: Arkham Shadow“ ist die bislang überzeugendste Umsetzung einer großen popkulturellen Marke in die virtuelle Realität. Mit einer über zehn Stunden langen Kampagne liefert Entwickler Camouflaj ein vollwertiges Action-Adventure mit klarer Story-Verankerung im Arkham-Kanon.

Den Entwicklern ist es gelungen, das rhythmische Freeflow-Kampfsystem der Vorlage so umzusetzen, dass es in VR nicht chaotisch, sondern körperlich präzise wirkt – inklusive Blocken, Kontern und spektakulärer Kombos. Auch das lautlose Ausschalten von Gegnern profitiert enorm von der immersiven Perspektive. Gesten wie das Aktivieren der Detektiv-Sicht oder das Gleiten mit dem Umhang fühlen sich natürlich an und auch grafisch schöpft der Titel das Potenzial der Quest 3 voll aus. Ein ähnlich dynamisches Spiel mit Licht und Schatten habe ich auf Metas Standalone-VR-Brille selten erlebt.

Beat Saber

Plattformen: Meta Quest, PC-VR, PS VR2 (nur noch eingeschränkt)

Gefeiert von: Josef Erl

Kaum ein Titel hat das Potenzial von Virtual Reality so früh erkannt und so konsequent genutzt wie „Beat Saber“. Das Rhythmusspiel von 2018 verzichtet auf komplizierte und unbequeme künstliche Bewegungssysteme und setzt stattdessen auf direkte Körpersteuerung: Mit zwei Lichtschwertern bewaffnet, schneiden Spieler im Takt der Musik auf sie zufliegende Blöcke durch – ganz ohne Motion Sickness. Dieser zeitlose Mix aus intuitiver Steuerung, treibenden Beats und hoher Geschwindigkeit versetzt mich auch heute noch regelmäßig in einen Flow-Zustand, bei dem der Kopf abschaltet, der Körper wie ferngesteuert reagiert und der Schweiß nur noch so tropft.

Ein weiterer wichtiger Faktor, warum „Beat Saber“ so gut funktioniert, sind die perfekt choreografierten Level-Muster, die jede Bewegung logisch auf die nächste vorbereiten. Das verstärkt das Gefühl, sich „in“ der Musik zu bewegen. Wem die zahlreichen kuratierten Music Packs nicht ausreichen, kann am PC auch selbst modden und eigene Songs in das Spiel integrieren.

Demeo

Plattformen: Android XR, Apple Vision Pro, Meta Quest, PC-VR, Pico, PS VR2

Gefeiert von: Tomislav Bezmalinović

„Demeo“ ist ein taktisches Tabletop-Rollenspiel für bis zu vier Spieler, das sich auf einem magischen Spielbrett entfaltet. Man wählt eine Charakterklasse und bewegt seine Miniatur über die gekachelte Welt. An der Seite der Heldengruppe kämpft, zaubert und heilt man sich mithilfe von Karten durch farbenfrohe Fantasy-Szenarien. Was „Demeo“ unvergesslich macht, ist nicht allein das Spiel, sondern wie mühelos es intime Tabletop-Abende mit Freunden ermöglicht und damit eines der großen Versprechen von VR einlöst: Menschen so in einen Raum und an einen Tisch zu bringen, dass man die tatsächliche physische Distanz beinahe vergisst.

Auch in Sachen Interface setzte „Demeo“ Maßstäbe: Es etablierte eine befreiende und dabei zeitlos elegante Handsteuerung, mit der sich die eigene Perspektive durch feine Handbewegungen im Raum bewegen, drehen und die Größenverhältnisse der Welt stufenlos skalieren lassen. So findet man stets die perfekte Sicht auf das aktuelle Spielgeschehen, kann „Demeo“ selbst im Liegen mühelos spielen und Kämpfe auf Augenhöhe mit den Miniaturen erleben.

Ghost Town

Plattformen: Meta Quest, PC-VR, PS VR2

Gefeiert von: Tomislav Bezmalinović

„Ghost Town“ erzählt die Geschichte von Edith Penrose, einer jungen Frau mit einer übernatürlichen Begabung und Verbindung zur Geisterwelt, die im London der 80er-Jahre nach ihrem verschwundenen Bruder sucht. Die große Qualität des Spiels liegt in seiner Erzählkunst: wie es Handlung, Charaktere und Schauplätze zu einem filmischen Erlebnis verwebt, das einen in seinen besten Momenten vergessen lässt, dass man ein Spiel spielt.

Kaum ein anderes Medium besitzt die Kraft, Menschen so unmittelbar an andere Orte zu versetzen wie Virtual Reality. „Ghost Town“ feiert diesen Umstand, indem es Spieler an vielfältige, atmosphärisch dichte Schauplätze versetzt: eine nebelverhangene Leuchtturminsel, eine Wunderkammer mit übernatürlichen Exponaten, eine stillgelegte Londoner U-Bahn und mehr.

Seinem Genre nach ist „Ghost Town“ ein Abenteuer- und Rätselspiel, doch seine größte Kraft entfaltet es, wenn die spielerischen Elemente in den Dienst der Geschichte treten und unmerklich werden. In solchen Momenten entfaltet Virtual Reality ihre volle Magie.

Gran Turismo 7

Plattformen: PS VR2

Gefeiert von: Jan Philipp Wöbbeking

Sonys Gran Turismo 7 hob in VR das Renngefühl auf eine neue Ebene. Am 21. Februar 2023 reichte Sonys Tochterstudio Polyphony Digital einen offiziellen PSVR2-Modus für sein PS5-Vorzeigerennspiel nach, der meine Ausflüge auf die Piste noch um einiges immersiver machte. Beim präzisen Umschauen konnte ich plötzlich nicht nur Kurven besser einschätzen, sondern kniff sogar intuitiv die Augen zusammen, wenn mich die Sonne auf den HDR-Displays förmlich blendete.

Dank hunderter detailgetreu nachgebildeter Fahrzeuge mit Tuning-Optionen, Lenkradunterstützung und exzellenter Handhabung fühlt man sich wie auf der Piste. Das Spiel bietet das volle Paket aus Lizenz- und Online-Rennen, Meisterschaften, Belohnungsrennen, kostenlosen Updates und kostenpflichtigen Erweiterungen. Wer sich am etwas langsamen Fortschritt stört oder ein komplett authentisches Fahrverhalten bevorzugt, sollte lieber zu VR-Rennsimulationen auf dem PC greifen. Für Freunde einer vollwertigen Karriere mit einem PSVR2-Headset ist Gran Turismo 7 aber ein echter Pflichttitel!

Half-Life: Alyx

Plattformen: PC-VR

Gefeiert von: Jan-Keno Janssen

Der am wenigsten überraschende Top-10-Titel: Es wird vermutlich niemals eine „Best-of-VR“-Liste ohne „Half-Life: Alyx“ geben; und womöglich wird es auch niemals wieder ein VR-Spiel mit so hohen Produktionswerten und einer solchen Poliertheit geben, denn: „Alyx“ darf außerhalb der betriebswirtschaftlicher Verwertungslogik existieren, Entwickler Valve ist nicht darauf angewiesen, die Produktionskosten wieder einzuspielen. Das Spiel zeigt aber auch, wie stark VR immer noch auf Ablehnung stößt: Ich kenne mehrere Personen, die sich als „extreme Half-Life-Fans“ bezeichnen und das Spiel noch nie ausprobiert haben (ich hätte ihnen mein VR-Headset ausgeliehen).

Schade, denn ich halte Alyx für ein von vorn bis hinten gelungenes Spiel, in das ich mich immer gerne wieder hineinfallen lasse. Den einzigen Vorwurf, den ich Valve mache: Um endlich die Achievements komplett zu machen, müsste ich nahezu das gesamte Spiel mit einem Gartenzwerg in der Hand durchspielen – was an Masochismus grenzt. Aber, egal: Irgendwann mach ich‘s.

Moss & Moss: Book II

Plattformen: Meta Quest, PC-VR, Pico, PS VR 1/2

Gefeiert von: Jan-Keno Janssen

Es muss nicht immer Adrenalin sein. Auch eher geruhsame Spielerfahrungen funktionieren toll in VR. Moss 1 und 2 ist eines der besten Beispiele dafür: Man linst hier in ein „lebendiges Bilderbuch“, oder besser gesagt: in eine detaillierte Puppenhaus-Welt, in der man die Protagonistin, eine Maus namens Quill, mit dem Controller steuert. Ärgerlicherweise versucht die fiese Schlange Sarffog die Heimat der Mäuse zu unterjochen – aber da hat sie die Rechnung ohne Quill (und uns als Spieler) gemacht. In beiden Büchern der Geschichte kämpft man ein bisschen, löst Rätsel und erfreut sich an der ausnehmend liebevoll gestalteten Märchenwelt.

Beide Teile kann man in jeweils vier Stunden durchspielen. Will man alles sehen, braucht man ungefähr sieben Stunden. Klar, viel Spielzeit ist das nicht, dafür wird man toll unterhalten. Und: Auch wenn die Rätsel sehr simpel beginnen, kriegt man später echte Gehirnwindungs-Verdreher vorgesetzt. Ein faszinierendes Detail, das Nicht-Gehörlose beim Spielen womöglich gar nicht mitbekommen: Quill spricht nicht, sondern kommuniziert in Zeichensprache, genauer gesagt in ASL (American Sign Language).

Resident Evil 4

Plattformen: Meta Quest + PS VR2

Gefeiert von: Jan-Keno Janssen

Resident Evil 4 auf der Quest (ab Quest 2) demonstriert anschaulich die Magie von VR: Das Spiel sieht nicht viel besser aus als anno 2005 auf der Playstation 2, spielt sich aber mindestens dreimal so gut. Auf einmal sind die Zombie-Schießereien nicht mehr umständlich und fummelig, sondern wirken, ja, echt. Schön auch: Für Simulatorkrankheit-Anfällige gibt es einen Teleport-Bewegungs-Modus. Man merkt dem Spiel deutlich die Liebe an, die in die VR-Umsetzung geflossen ist; Armature Studios (gehört inzwischen zu Meta) hat hier wirklich fantastische Arbeit geleistet. Würde man das Original nicht kennen, würde man denken, das Spiel sei von Grund auf in VR entwickelt worden.

Die andere Seite der RE4-Medaille kann man auf der Playstation VR2 bestaunen: Hier hat Capcom dem Remake von 2023 einen VR-Modus verpasst. Diese Version sieht deutlich besser aus als die auf dem Original-Spiel basierende Quest-Variante. Dafür merkt man ihr aber auch an vielen Ecken an, dass der VR-Modus eben nur optional ist – etwa, weil man weniger Objekte wirklich mit der virtuellen Hand anfassen kann. Dennoch: Auch diese Version gehört zu den besten VR-Titeln, die man aktuell spielen kann (wenn man einen stabilen Magen hat).

Walkabout Mini Golf

Plattformen: Android XR, Meta Quest, PC-VR, Pico, PS VR

Gefeiert von: Josef Erl

„Walkabout Mini Golf VR“ ist ein Paradebeispiel dafür, wie Virtual Reality auch ohne fotorealistische Grafik überzeugen kann. Das eigentlich als Hollywood-Animationsstudio gegründete Mighty Coconut hat ein einfach zu lernendes Spiel aus der Realität in Welten verfrachtet, die vor Kreativität nur so strotzen. Von entspannenden Zen-Gärten über Hauptquartiere von Bond-Bösewichten oder der Spitze des Eiffelturms dient alles als Golfplatz, was die Fantasie erlaubt. In den vergangenen fünf Jahren ist „Walkabout Mini Golf VR“ dabei vom reinen Sportspiel zum digitalen Treffpunkt herangewachsen, in dem sich zahlreiche Communitys gebildet haben.

Bis zu acht Personen können sich plattformübergreifend in privaten Runden treffen, Crossplay funktioniert reibungslos und der Voice-Chat ist so gut abgestimmt, dass Gespräche ganz natürlich wirken. Ganz nebenbei fühlt sich die Ballphysik auch noch so glaubwürdig an, dass ich regelmäßig nach wenigen Schlägen vergesse, dass mein virtueller Putter gar kein echtes Gewicht hat.

(jpw)

Künstliche Intelligenz

WTF: Raspberry-Pi-Verbot bei Amtseinführung des New Yorker Bürgermeisters

Wer einen Raspberry Pi dabei hat, muss draußen bleiben: Mancher Maker dürfte über die Regeln bei der Amtseinführungszeremonie von New Yorks neuem Bürgermeister Zohran Mamdani heute Nachmittag stutzen. Denn man könnte sich fragen, was denn nun eigenartiger ist: Einen Raspberry Pi zur Amtseinführung eines Bürgermeisters mitbringen oder genau das bei einer solchen Veranstaltung zu verbieten.

Weiterlesen nach der Anzeige

Für New Yorks Stadtverwaltung war jedenfalls klar: Die vielseitig einsetzbaren Einplatinencomputer haben bei dem Event heute um 17 Uhr deutscher Zeit nichts zu suchen. Auf der Liste verbotener Gegenstände tummelt sich der Raspberry in ungewöhnlicher Gesellschaft: Unter anderem Fahrräder, Laserpointer, Regenschirme und der Flipper Zero sind ebenfalls nicht erlaubt.

Eigentlich weitgehend die üblichen Verdächtigen für diesen Anlass, jedenfalls, wenn man ihn sich mal genauer ansieht. Das Publikum wird sich voraussichtlich dicht an dicht auf dem New Yorker Broadway tummeln, für ein Fahrrad wäre kaum Platz. Ein Regenschirm könnte ausgeklappt anderen die Sicht versperren oder bei Handgreiflichkeiten gefährlich werden (und wer genügend Agenten-Thriller genossen hat oder den Fall Georgi Markow kennt, dem fallen bestimmt noch ganz andere Szenarien ein).

Und der Flipper Zero, quasi ein Hacking-Tool für die Hosentasche, kann unter anderem Funksignale von Autoschlüsseln, Alarmanlagen und ähnlichem aufzeichnen und wieder abspielen – nur ein möglicher plausibler Grund, warum die verantwortlichen Sicherheitsbehörden das Gerät an dem Abend aussperrten.

Und damit sind wir bei dem angelangt, was auch die Maker von Adafruit an der Sache so stutzig macht: Ohne zusätzliche Hardware, mindestens zur Stromversorgung, taugt so ein Raspberry Pi für recht wenig. Eine Begründung für das exotische Verbot gibt es von offizieller Seite nicht.

Das lässt Raum für Spekulationen: Wollte die Stadtverwaltung die Kreativität böswilliger Bastler auf keinen Fall unterschätzen? Hat der verantwortliche Beamte einfach die KI nach Flipper-ähnlichen Spielereien gefragt? Sicherheitsforscher Stefan Klatt hat einen anderen Verdacht und kommentiert den Vorgang auf X: „Wie sagt man, dass man keine Ahnung hat, ohne es zu sagen?“

Lesen Sie auch

(nen)

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenIllustrierte Reise nach New York City › PAGE online

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 3 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenSK Rapid Wien erneuert visuelle Identität

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenNeue PC-Spiele im November 2025: „Anno 117: Pax Romana“

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenDonnerstag: Deutsches Flugtaxi-Start-up am Ende, KI-Rechenzentren mit ARM-Chips

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenArndt Benedikt rebranded GreatVita › PAGE online