Datenschutz & Sicherheit

Institut für Menschenrechte: Dringende Warnung vor Gesichtserkennung

Mit einem neuen Überwachungspaket will das CSU-geführte Innenministerium unter anderem mehr Befugnisse für biometrische Gesichtserkennung schaffen. Das heißt, Polizist*innen sollen viele Menschen auf einmal anhand ihres Gesichts identifizieren und verfolgen dürfen. Verkauft werden die Pläne als Sicherheitspaket. Zwanzig zivilgesellschaftliche Organisationen sehen Grundrechte in Gefahr und lehnen die Pläne ab.

Während nun die zuständigen Ministerien über den Entwurf beraten, hat das Deutsche Institut für Menschenrechte eine aufrüttelnde Untersuchung mit Warnungen und Empfehlungen vorgelegt. Das Institut wird vom Bundestag finanziert und beobachtet als unabhängige Institution die Lage der Menschenrechte in Deutschland.

Auf insgesamt 43 Seiten fassen die Menschenrechtler*innen die Gefahren durch biometrische Gesichtserkennung zusammen. So nennt man es, wenn man Menschen anhand ihrer einzigartigen Gesichtsmerkmale identifiziert. Das sind beispielsweise die Position und Abstände von Augen, Nase, Kinn und Ohren.

Die Expert*innen schildern in ihrer Studie auch die rechtlichen Grundlagen und beschreiben, wo Behörden die Technologie in Deutschland bereits einsetzen. Am Ende machen sie sechs Empfehlungen, für die CSU-Innenminister Alexander Dobrindt direkt das Hausaufgabenheft aufschlagen könnte. Wer sich nicht durch das ganze Papier wühlen möchte, findet hier die wichtigsten Fragen und Antworten.

Warum ist biometrische Gesichtserkennung besonders?

Viele dürften es seltsam finden, wenn sie immer ein Namensschild oder gar ihren Ausweis um den Hals tragen müssten. Doch mit biometrischer Gesichtserkennung wird das eigene Gesicht zu einer Art Ausweis. Man kann es nicht ablegen und nur schwer vor Kameras verbergen. Ob auf der Straße oder im Netz – wer sich nicht stark einschränken will, gibt sein Gesicht immer wieder potenzieller biometrischer Erfassung preis. Die Expert*innen vom Deutschen Institut für Menschenrechte schreiben:

Die Fähigkeit, Menschen aus der Ferne, ohne ihr Wissen und ihre Mitwirkung, zu identifizieren, macht Gesichtserkennung zu einem Sonderfall der biometrischen Identifizierung, die einschüchternde Wirkung entfalten kann.

Was macht Gesichtserkennung so gefährlich?

Aus der Studie des Instituts gehen gleich mehrere Gefahren hervor, die biometrische Gesichtserkennung besonders bedenklich machen. Zum Beispiel:

- Falsche Verdächtigungen: Gesichtserkennung basiert auf Software, die Ähnlichkeiten erkennt. Dabei passieren Fehler. Das heißt, bei der Suche nach einem Verdächtigen kann die Polizei schlicht die falsche Person ins Visier nehmen und verfolgen. In den USA ist genau so etwas schon öfter passiert: Nach Verwechslungen mussten Unbeteiligte aufs Revier.

- Diskriminierung: Gesichtserkennung funktioniert nicht bei jeder Person gleich gut. Gerade bei Frauen oder People of Color kann die Technologie mehr Fehler machen als bei weißen Männern. Den Forschenden zufolge stelle sich die Frage, ob der Einsatz der Technologie „gegen das grund- und menschenrechtliche Diskriminierungsverbot verstößt“.

- Profilbildung: Biometrische Gesichtserkennung muss nicht nur punktuell geschehen. Man kann auch Personen immer wieder an mehreren Orten erkennen und dadurch Rückschlüsse ziehen. Es kann viel über einen Menschen verraten, mit wem er zum Beispiel häufig auf Demos gesichtet wird, ob er oft im Bankenviertel auftaucht oder auf dem Weg zu einer psychiatrischen Klinik. Die Forschenden verzichten zwar auf konkrete Beispiele, warnen aber vor solcher Profilbildung.

- Einschüchterung: Allein das Wissen, dass Behörden per Kameras Gesichtserkennung betreiben und dass dabei Fehler passieren, kann Menschen verunsichern. Die Forschenden warnen deshalb vor Abschreckungseffekten („chilling effects“). Sie könnten dazu führen, dass Menschen „auf die Wahrnehmung etwa ihrer Meinungs- und Versammlungsfreiheit verzichten“. Konkretes Beispiel: Sie trauen sich nicht mehr auf eine Demo.

Hat die KI-Verordnung nicht schon alles geregelt?

Leider nein. Die EU hat ihre Chance verpasst, biometrische Gesichtserkennung umfassend zu verbieten. Die KI-Verordnung (AI Act) formuliert nur rote Linien, die Mitgliedstaaten bei biometrischer Gesichtserkennung nicht überschreiten dürfen. Deutschland und andere EU-Staaten können aber weiterhin ihre eigenen Regeln schreiben – oder gar entscheiden, die Technologie für illegal zu erklären.

Noch Anfang 2024 äußerten Bundestagsabgeordnete der Ampel den Wunsch, dass Deutschland seinen Spielraum aus der KI-Verordnung nicht ausreizt und etwa biometrische Echtzeit-Überwachung verbietet. Doch das ist Schnee von gestern. Bei der schwarz-roten Bundesregierung stehen die Zeichen nicht auf weniger Überwachung, sondern auf mehr.

Wie viel Spielraum hat Deutschland bei Gesichtserkennung?

Der Spielraum für biometrische Gesichtserkennung in Deutschland ist aus vielen Richtungen begrenzt. Das Institut für Menschenrechte beschreibt eine Art Slalom entlang mehrerer Vorschriften und Grundrechte.

- Schon aus dem Recht auf Privatsphäre ergeben sich der Studie zufolge hohe Hürden für Gesichtserkennung. „Bereits die Speicherung von Lichtbildern, verbunden mit der bloßen Möglichkeit einer Gesichtserkennung, greift in das Menschenrecht auf Privatsphäre ein“, warnen die Forschenden.

- Konkretere Einschränkungen liefert die KI-Verordnung selbst. Für Gesichtserkennung in Echtzeit sind die Hürden höher. Hier müssen Behörden etwa Folgen für Grundrechte abschätzen und brauchen vor jeder Verwendung eine Genehmigung, etwa durch ein Gericht. Bei nachträglicher Gesichtserkennung wird die KI-Verordnung jedoch laxer – und es ist nicht einmal klar definiert, ab wann der Einsatz als nachträglich gilt.

- Ein System zur Gesichtserkennung braucht eine Datenbank, um Gesichter abzugleichen und Personen zuzuordnen. Kommerzielle Anbieter wie PimEyes oder Clearview AI, die Milliarden Gesichter kennen, kommen der Studie zufolge für Behörden jedoch nicht in Frage. Die KI-Verordnung verbietet nämlich Datenbanken, die ungezielt Gesichtsbilder aus dem Internet auslesen. Eine Alternative sind staatliche Lichtbilddatenbanken. Dort liegen die Bilder von erkennungsdienstlich registrierten Personen – darunter Tatverdächtige und Asylsuchende.

- Dann gibt es noch die EU-Richtlinie zum Datenschutz bei Polizei und Strafjustiz, kurz: JI-Richtlinie. Ähnlich wie die Datenschutzgrundverordnung (DSGVO) beschreibt die Richtlinie biometrische Daten als besonders schützenswert. „Deren polizeiliche Verarbeitung ist demnach nur dann erlaubt, wenn sie unbedingt erforderlich ist“, fasst die Studie zusammen.

- Sollte das Thema einmal beim Bundesverfassungsgericht landen, dürfte es den Richter*innen wohl ums Recht auf informationelle Selbstbestimmung gehen. Die Forschenden erinnern an ältere Rechtsprechung zur Kfz-Kennzeichenkontrolle. Ob nun Autokennzeichen erfasst werden oder Gesichter – die Situation ist vergleichbar. Schon damals habe das Gericht festgestellt, dass „jeder einzelne Datenverarbeitungsvorgang grundsätzlich einen Grundrechtseingriff“ darstelle.

Längst zeigen Fälle und Pilotprojekte aus den Bundesländern, wie Behörden einfach mal loslegen. Bereits 2020 hatte das BKA nach Protesten zum G20-Gipfel in Hamburg Gesichtserkennung eingesetzt. Das Land Hessen will Gesichtserkennung am Hauptbahnhof Frankfurt/Main haben. Das Land Sachsen hat Gesichtserkennung in der Region Görlitz genutzt – zum Ärger der Landesdatenschutzbeauftragten, die das für teils verfassungswidrig hielt. Einige der Beispiele tauchen auch in der Studie auf. Die Forschenden warnen vor der „rapiden Entwicklung“.

Was empfehlen die Menschenrechtsexpert*innen?

Trotz ihrer Warnungen lehnen die Forschenden biometrische Gesichtserkennung nicht generell ab. Das unterscheidet sich von der Position einiger zivilgesellschaftlicher Institutionen, die sich schlicht für den Stopp der Technologie stark machen. Ein klares Nein könnte jahrelange Unsicherheit und Rechtsstreitigkeiten vermeiden.

Die Menschenrechtler*innen formulieren stattdessen sechs teils dringliche Empfehlungen. An ihnen kann sich Schwarz-Rot messen lassen.

- Zuerst signalisieren die Forschenden Halt, Stopp!, wenn auch in anderen Worten. Sie warnen vor „erheblichen rechtlichen und ethischen Fragen“ und halten es für „unerlässlich, diese Technologie nicht vorschnell einzuführen“. Stattdessen empfehlen sie, zuerst Fachleute an die Sache heranzulassen. Es braucht demnach eine „Enquete-Kommission mit Vertreter*innen aus Polizei, Daten- und Diskriminierungsschutz, Zivilgesellschaft und Wissenschaft“, um das Thema öffentlich zu diskutieren.

- Zweitens soll es erst einmal nicht mehr, sondern weniger Gesichtserkennung geben. Der Zugriff der Polizei auf bereits bestehende staatliche Gesichtsdatenbanken soll beschränkt werden, und zwar „dringend“, wie die Forschenden schreiben. Es brauche „klar normierte, anlassbezogene Suchen“, um „unverhältnismäßige Eingriffe in die Privatsphäre zu vermeiden“.

- Drittens empfehlen die Forschenden ein Verbot von „digitaler polizeilicher Beobachtung“. Hier geht es darum, dass Gesichtserkennung nicht punktuell ist, sondern eben auch Material für umfangreiche Persönlichkeitsprofile liefern könnte.

- Viertens soll den Forschenden zufolge biometrische Gesichtserkennung unter Richtervorbehalt gestellt werden. Das sieht die KI-Verordnung nur bei Gesichtserkennung in Echtzeit vor, nicht aber bei nachträglicher Erkennung. Deutschland darf das jedoch strenger regeln.

- Fünftens verlangen die Forschenden Transparenz bei polizeilicher Gesichtserkennung, „damit eine demokratische Kontrolle gewährleistet ist“. Das Institut für Menschenrechte empfiehlt Bund und Ländern, dass sie auch öffentlich einsehbar machen, welche Systeme sie für den Einsatz registrieren. Laut KI-Verordnung müssten sie das nicht öffentlich tun.

- Zuletzt sollte Gesichtserkennung den Menschenrechtler*innen zufolge nicht bis auf Weiteres eingeführt werden, sondern allenfalls für begrenzte Zeit. Danach könne man prüfen, neu bewerten und „idealerweise“ die Folgen für Grundrechte abschätzen.

Wie geht es jetzt weiter?

Das CSU-Innenministerium hat mit seinen Referentenentwürfen den ersten Schritt gemacht. Falls sich die schwarz-rote Regierung auf einen gemeinsamen Entwurf einigt, wären als nächstes Bundestag und Bundesrat an der Reihe.

Datenschutz & Sicherheit

Breakpoint: Individuell uniform

Soziale Medien leben von Wiederholung. Der Algorithmus belohnt, was schon funktioniert hat, und macht es sichtbarer. Wer mithalten will, muss nachahmen. Das Versprechen von TikTok und Instagram klingt zunächst nach Freiheit: Jeder kann alles sein, jederzeit. Doch was wir tatsächlich sehen, sind dieselben Sounds, dieselben Outfits, dieselben Witze. Der Versuch, einzigartig zu sein, mündet in Uniformität.

Wer in sozialen Medien unterwegs ist, der kann sich jeden Tag eine neue Box aussuchen, in die er hineinpasst oder von der er sich abgrenzen möchte: Kleidungstrends werden aufs Genaueste benannt, Verhaltensweisen und Charaktereigenschaften werden kategorisiert, klassifiziert und anderen zur Schau gestellt, damit sie es bewerten. So sollen wir etwa „clean Girls“ oder „messy Girls“, Person „Type A“ oder „Type B“ sein. Deine Kategorie darfst du dir selbst aussuchen – solange du dich jener Kästen bedienst, die bereits existieren.

Diese Kategorien klingen nach Selbstverwirklichung, nach der Möglichkeit, sich neu zu erfinden. Tatsächlich aber sind sie Schablonen. Und wer eine Schablone wählt, landet zwangsläufig in der Masse derjenigen, die dieselbe gewählt haben.

Die Veralgorithmisierung von Trends

Das ist kein Wunder, denn die Algorithmen von Instagram und TikTok leben von Trends. Wo 2016 noch heute als peinlich betrachtete Bilder gepostet wurden – von der Klassenfahrt, dem misslungenen Kochversuch oder der Jugendparty, die um 5 Uhr morgens auf einem Aldi-Parkplatz endete -, da wiederholen heute hunderttausende Accounts den immer gleichen Content. Der gleiche Konversationsverlauf und die gleiche Storyline sind aber spätestens beim zweiten Video uninteressant. Und die immer gleiche Pointe verliert dann auch ihren Witz.

Auf diese Weise werden gerade auch typische Subkulturen zu Trends veralgorithmisiert. Jeder möchte anders sein und dadurch werden alle zunehmend gleicher. Wenn ich durch Berlin Neukölln laufe, tragen dort alle die gleichen abgelaufenen Adidas Sambas oder Retro-Lederstiefel, kombiniert mit einer 90s Trainingsjacke und irgendwie immer zu vielen Halsketten. In Köln Ehrenfeld sehen die Menschen genauso aus. Und in Hamburg Altona auch.

Sich davon zu befreien, ist in einer Zeit kaum möglich, in der große Teile unserer Freizeit und unseres Soziallebens im Konsum sozialer Medien und der Kommunikation darüber bestehen. Auch mir fällt das schwer. Diesen Text schreibe ich, während ich in einer 90s Trainingsjacke und Adidas Sambas im Zug sitze (auf dem Weg nach Hamburg Altona).

Der Drang zur Konformität

Dabei besteht in diesem Drang zur Konformität ein Widerspruch zum neoliberalen Werbeversprechen sozialer Medien: einem scheinbar schier unerschöpflichen Individualismus. In meiner letzten Kolumne schrieb ich darüber, dass Inhalte in sozialen Medien zunehmend suggerieren, wir sollten uns von der Gemeinschaft loslösen, nur noch unseren eigenen Selbstbedürfnissen nachgehen und dadurch immer freier, unabhängiger und individueller werden.

Doch ein solcher Individualismus scheitert an sich selbst. Wer einen Trend bricht, riskiert Unsichtbarkeit. Der Algorithmus bevorzugt, was schon funktioniert. Also belohnt er Wiederholung, Konformität, Kopie. Und so scrollen wir durch Feeds, in denen dieselben Songs, dieselben Outfits, dieselben Typisierungen endlos variieren, wie ein digitales Déjà-vu.

Während also alle immer individueller werden wollen – und das etwa durch vermeintliche Loslösung von sozialen Normen, Abnabelung von anderen und die Übernahme subkultureller Mode auszudrücken versuchen -, passen sie sich tatsächlich immer weiter stärker aneinander an. Weil sie alle das Gleiche tun. Dieser fehlgeschlagene Individualismus führt im Ergebnis zu immer mehr Anpassung.

Egal ob Vereinzelung oder trendige Konformität – selbstbestimmter werden wir dadurch nicht. Vielmehr bildet dieser als Individualismus gelabelte Widerspruch zwei Seiten der gleichen Medaille.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Berechenbare Gleichförmigkeit

Diese Entwicklung ist sicher nichts völlig Neues an sich. Etwas anderes zu behaupten, wäre Kulturpessimismus. Schon immer gab es Trends, denen – insbesondere Jugendliche – in Massen gefolgt sind und die wenig später wieder verflogen waren. Und dennoch wirken soziale Medien in besonderer Weise als Katalysator ebenjener Kultur der Gleichförmigkeit. Nie zuvor waren wir so vernetzt wie heute. Und nie zuvor wurde Konformität so sehr mit Aufmerksamkeit belohnt.

All das geht so weit, dass selbst politische Subkulturen inzwischen vor allem als Stil und Trend wahrgenommen werden denn als politische Ausdrucksform. So etwa Punk oder Metal, die historisch immer gesellschaftskritisch waren und ihre Abneigung gegen die Mainstream-Gesellschaft und Mitte-Politik durch bewusst abweichende Musik und Mode gezeigt haben.

Heute wird auf Instagram und Co argumentiert, dass Punk nur eine von vielen Arten sei, sich zu kleiden – und bei der Politik solle man sich doch bitteschön raushalten. Dabei ist Punk nichts weniger als der innerliche und äußere Widerstand gegen das angeblich Altbewährte, soziale Ungleichheit und ein Bürgertum, das am liebsten das Handeln der Menschen vorhersehen und beherrschen können würde.

Diese neue Art der Konformität kommt Letzterem dabei nicht ungelegen. Wenn alle das Gleiche tragen, sich gleich verhalten und zumindest oberflächlich das Gleiche wollen, dann sind sie berechenbarer. Für einen Markt, der uns in der einen Woche Millionen Labubus und in der Woche darauf kiloweise Dubai-Schokolade verkaufen will. Selbstbestimmung und -verwirklichung werden so der Logik des Marktes unterworfen. Er produziert, kopiert und reproduziert das, was die Konsumenten der eigenen TikToks und Reels massenhaft nachfragen.

Trends zu folgen, ist verständlich. Ich tue das auch. Die Person neben mir im Zug tut es. Und du wahrscheinlich auch. Das ist völlig in Ordnung. Nur eines wäre verfehlt: Diese Uniformität individuell zu nennen.

Datenschutz & Sicherheit

Die Woche, in der Trump die Antifa zur Terrorgruppe erklärte

Liebe Leser*innen,

jetzt bin ich also Terrorist. Zumindest laut Donald Trump. Der hat nämlich diese Woche „die Antifa“ in den USA als terroristische Organisation eingestuft. Ungarns Ministerpräsident Viktor Orbán hat bereits angekündigt, dass dies auch in seinem Land gelten soll. Das niederländische Parlament will auf Antrag von Geert Wilders eine entsprechende Einstufung prüfen. Die AfD-Co-Vorsitzende Alice Weidel forderte sie 2024 auch für Deutschland.

Trump schwadroniert davon, dass die Antifa eine Organisation sei. Aber Antifa ist keine Organisation, schon gar keine nationale. Antifa ist eine internationale Bewegung, die alle umfasst, die sich gegen Faschismus einsetzen – antifaschistisch eben. Faschismus bezeichnet etwa nationalistische Bewegungen, die autoritäre Regimes errichten wollen, die nach innen Minderheiten verfolgen und nach außen militaristische Strategien.

Trump, Orbán und Weidel eint mindestens die nationalistische Orientierung und der Kampf gegen Minderheiten. Wohl deshalb sehen sie „die Antifa“ als Feind. Anti-Demokrat*innen haben in der Vergangenheit immer wieder gezeigt, dass sie am liebsten alle aus dem Weg schaffen würden, die sich ihren autoritären Träumen in den Weg stellen.

Antifa, das sind nicht nur die schwarzvermummten Demospitzen. Jeder Mensch, der Demokratie und Rechtsstaat liebt, sollte Antifa sein und sich dem aufkeimenden Faschismus entgegenstellen. 1932, vor 93 Jahren, gründeten Menschen die Antifaschistische Aktion, weil sie die Gräuel der Nazis vor deren Machtergreifung vorausahnten. Sie wollten den Aufstieg des Faschismus verhindern.

Antifa, das waren die Geschwister Scholl, die US-amerikanischen Soldaten, die in der Normandie landeten, und die Menschen, die Verfolgte versteckten und unterstützten. Antifa ist heute das Bundesverfassungsgericht, wenn es Grundrechte hochhält. Antifa ist nach Selbstaussage auch der Verfassungsschutz Niedersachsen und Antifa sind alle Menschen, die auf Anti-Nazi-Demos gehen. Antifa bin auch ich – weil ich verhindern will, dass den Rechtsextremen, falls sie an die Macht kommen, ein hochentwickelter Überwachungsapparat schlüsselfertig ausgehändigt wird.

Ich kämpfe gegen Videoüberwachung, Netzsperren und all die anderen Kontrollwerkzeuge nicht zuletzt deshalb, weil ich autoritären und totalitären Bestrebungen die Waffen nehmen oder gar nicht in die Hand geben will, die diese zur Kontrolle und Gleichschaltung der Bevölkerung benötigen. Weil ich eine offene und freie Gesellschaft will.

Was die historischen Nazis an Leid über die Welt gebracht haben, ist unfassbar. Das darf sich niemals wiederholen. Deshalb bin ich Antifaschist, deshalb bin ich Antifa.

Martin

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Datenschutz & Sicherheit

Neues aus dem Fernsehrat (113): Hass und Zusammenhalt

Die letzte Sitzung des ZDF-Fernsehrats fand am Ende einer Woche statt, die für das ZDF besonders herausfordernd war: Dunja Hayali wurde für die Anmoderation eines Beitrags zur Ermordung Charlie Kirks tagelang mit Beleidigungen, Mord- und Vergewaltigungsdrohungen überzogen. Der ehemalige US-Botschafter in Deutschland, Richard Grenell, forderte aufgrund der journalistischen Einordnung Charlie Kirks durch Elmar Theveßen den Entzug seines US-Visums. Und die US-Regierung hat angekündigt, dass Visa für Journalist:innen zukünftig nur noch 240 Tage gelten sollen – üblich sind bisher fünf Jahre.

Es ist deshalb ein sehr wichtiges Zeichen, dass der Fernsehrat – mit all seiner politischen und gesellschaftlichen Vielfalt – die Angriffe auf Dunja Hayali und Elmar Theveßen in der Sitzung am vergangenen Freitag einstimmig verurteilt hat. In der gemeinsamen Erklärung betonte er außerdem, dass Pressefreiheit „für die Demokratie ein unverhandelbares Gut“ ist. Auch zu den kürzeren Visa-Laufzeiten äußerte sich der Rat deutlich. Er schloss sich dem Appell einer Reihe deutscher Intendanten (von ARD und ZDF bis zu ProSiebenSat.1) an: Die Bundesregierung soll sich auf diplomatischem Weg gegen die geplanten Änderungen aussprechen.

Es war für mich eine ereignisreiche erste Sitzung. Denn ab jetzt darf ich – entsandt vom Chaos Computer Club, D64 – Zentrum für Digitalen Fortschritt, eco – Verband der Internetwirtschaft und media berlinbrandenburg – den Bereich „Internet“ im ZDF-Fernsehrat vertreten. Ich trete damit die Nachfolge von Leonhard Dobusch (Juli 2016 bis Juni 2022, danach noch bis Mai 2025 im ZDF-Verwaltungsrat) und Laura Kristine Krause (Juli 2022 bis Juli 2025) an, die in der Vergangenheit auch diese Kolumne verantwortet haben.

Anonymität als Schutz für marginalisierte Gruppen

Mich beschäftigen ganz besonders der Hass und die Gewaltandrohungen, die Dunja Hayali in den großen sozialen Online-Plattformen entgegenschlagen. Gleichzeitig ist die breite Solidarität von weiten Teilen der Bevölkerung, der Politik und von Kolleg:innen ein Zeichen der Hoffnung.

Wir setzen uns bei D64 seit langem dafür ein, dass der digitale öffentliche Raum, in dem für unsere Demokratie zentrale Debatten ausgetragen werden, sicherer gestaltet werden muss. Zur Verbesserung der Strafverfolgung im Internet, auch der Anzeigemöglichkeiten für Betroffene, haben wir schon vor Jahren das Konzept der Login-Falle entwickelt. Das wurde sogar in den Koalitionsvertrag der früheren Ampel-Regierung aufgenommen, dann aber mangels politischem Willen nie umgesetzt.

Stattdessen werden immer wieder Forderungen nach autoritären Maßnahmen laut – sei es die anlasslose Vorratsdatenspeicherung von IP-Adressen oder Identifizierungspflichten für soziale Netzwerke. Dabei profitieren von der grundsätzlichen Möglichkeit der Anonymität im Internet ganz besonders Personen aus marginalisierten Gruppen, die sonst Hass und Repressalien befürchten müssen.

Auch eine Studie der Universität Zürich aus dem Jahr 2016 fand keine Belege dafür, dass Anonymität im Internet zu mehr Hass führt – im Gegenteil. Als besonders aggressiv stellten sich in der Datenanalyse Nutzerkonten heraus, die unter ihrem bürgerlichen Namen agieren.

Demokratische Alternativen für digitale öffentliche Räume

Was wir stattdessen brauchen, sind Alternativen zu den Big-Tech-Plattformen „gütiger Diktatoren“ des Silicon Valleys, die gemeinsam mit der Trump-Regierung derzeit eine Regierungsform aufbauen, die unter anderem vom Philosophen Rainer Mühlhoff als „neuer Faschismus“ bezeichnet wird. Diese Alternativen sollten der Konzentration von Macht durch einen dezentralen Aufbau strukturell entgegenwirken, staatsfern organisiert sowie gemeinwohlorientiert sein und die Vielfalt unserer Gesellschaft abbilden.

Vielversprechende Ansätze wie das Fediverse mit seinem bekanntesten Vertreter Mastodon gibt es bereits. Damit sich solche Alternativen durchsetzen können, braucht es aber noch deutlich mehr – ideelle wie finanzielle – Unterstützung durch relevante Akteure, die hohe gesellschaftliche Akzeptanz besitzen. Akteure wie der öffentlich-rechtliche Rundfunk.

Das sehen nicht nur Forschende beispielsweise mit den „Digital Open Public Spaces“ in der Digital-Public-Value-Studie und Aktivist:innen so, sondern breite Teile der Bevölkerung.

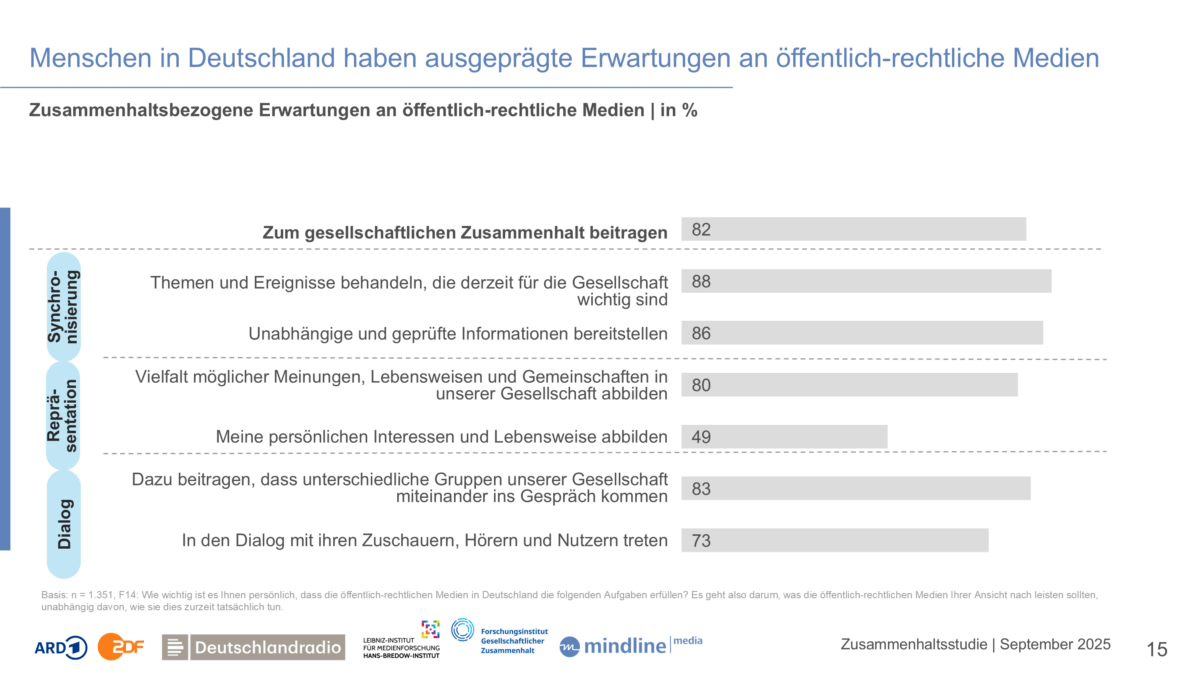

Dazu ist die „Zusammenhaltsstudie“ interessant, die ARD, ZDF und Deutschlandradio gemeinsam mit wissenschaftlichen Partnerinstitutionen durchgeführt und am vergangenen Mittwoch in Frankfurt vorgestellt haben. Laut der Erhebung äußern 83 Prozent der Befragten die Erwartung, dass öffentlich-rechtliche Medien dazu beitragen sollen, dass unterschiedliche Gruppen unserer Gesellschaft ins Gespräch kommen. 73 Prozent finden, dass öffentlich-rechtliche Medien im Dialog mit Nutzenden treten sollen.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Vorbei sind also die Zeiten, in denen der öffentliche-rechtliche Rundfunk sich auf seine Rolle als „Sender“ beschränken kann. Menschen erwarten vielmehr, dass er Interaktion von Menschen untereinander und mit den Medien selbst ermöglicht.

Mit großem Vertrauen kommt große Verantwortung

Die besondere Verantwortung der Öffentlich-Rechtlichen ergibt sich auch aus mangelhaftem Vertrauen in andere Institutionen. So nehmen lediglich ein knappes Drittel der befragten Personen einen positiven Beitrag von kommerziellen Social-Media-Plattformen zum gesellschaftlichen Zusammenhalt wahr.

Besonders bitter ist die Umfrage für zwei traditionelle Massenorganisationen: Von allen genannten Einrichtungen ist der Beitrag von Parteien und Kirchen zum gesellschaftlichen Zusammenhalt laut der Umfrage am geringsten. Der Beitrag der Öffentlich-Rechtlichen zum gesellschaftlichen Zusammenhalt wird dagegen nach Sportvereinen, der Wissenschaft und dem Bundesverfassungsgericht als am höchsten eingeschätzt.

Das ZDF hat sich bereits auf den Weg gemacht, den digitalen Diskurs zu fördern: Der Public Spaces Incubator ist das zentrale Projekt, um sich gemeinsam mit internationalen Partnern vom reinen Sender zu einer Plattform des konstruktiven Austauschs zu entwickeln, ganz ohne Überwachungskapitalismus, Engagement-Farming und süchtig-machenden Algorithmen.

Diesen Sommer gab es im Rahmen der Frauen-Fußball-Europameisterschaft einen ersten Testlauf der ZDFspaces, ab Oktober ist die Ausweitung auf weitere Formate geplant. Die Ereignisse der letzten Wochen zeigen die Dringlichkeit, dass dieser Weg engagiert von den öffentlich-rechtlichen Medien weiterverfolgt wird. Er ist unsere beste Chance für eine demokratische Diskussionskultur im Netz.

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen