Künstliche Intelligenz

Aus Softwarefehlern lernen – Teil 1: Einheiten. Wenn Zahlen irreführend werden

Wenn Softwarefehler auftreten, passiert das meistens unbemerkt und unauffällig, gelegentlich aber auch höchst spektakulär und kostspielig. Von fehlgeschlagenen Raumfahrtmissionen über Börsencrashs bis hin zu fehlerhaften medizinischen Geräten gibt es eine lange Liste berühmter Softwarepannen. Wer sie studiert, stellt schnell fest: Die meisten dieser Fehler wirken auf den ersten Blick wie einmalige Katastrophen, sind in Wahrheit aber Wiederholungen bekannter Muster.

Golo Roden ist Gründer und CTO von the native web GmbH. Er beschäftigt sich mit der Konzeption und Entwicklung von Web- und Cloud-Anwendungen sowie -APIs, mit einem Schwerpunkt auf Event-getriebenen und Service-basierten verteilten Architekturen. Sein Leitsatz lautet, dass Softwareentwicklung kein Selbstzweck ist, sondern immer einer zugrundeliegenden Fachlichkeit folgen muss.

Die Teile der Serie „Aus Softwarefehlern lernen“:

Diese Artikelserie stellt neun dieser typischen Fehlerklassen vor, die in der Praxis immer wieder auftauchen – unabhängig von Branche oder Technologie. In jeder Kategorie wird die Serie ein konkretes Beispiel vorstellen, dessen Ursachen analysieren und daraus ableiten, was Softwareentwicklerinnen und Softwareentwickler langfristig lernen können.

Der Bug in der Rechenanlage

Eine der beliebtesten Anekdoten der Softwaregeschichte ist die von Grace Hopper und der berühmten Motte. 1947 arbeitete Grace Hopper an der Harvard-Mark-II-Rechenanlage, in der sich eine echte Motte in einem Relais verfangen hatte. Nachdem ein Teammitglied sie gefunden und entfernt hatte, klebte dieser sie mit dem Kommentar „first actual case of bug being found“ ins Protokollbuch. Dieses Protokollbuch wird heute in einem Smithsonian Museum in Washington ausgestellt.

Diese Episode ist zu einer Legende der IT-Kultur geworden – das Wort „Bug“ wurde damals aber nicht erfunden. Schon Thomas Edison sprach 1878 in Briefen über „Bugs“ in Maschinen, also kleine, schwer zu findende Fehler. Trotzdem prägte Grace Hopper die Vorstellung, dass Softwarefehler etwas sind, das man wie ein Insekt finden und entfernen kann.

Doch die Realität ist oft subtiler: Bugs sind meist Symptome systematischer Schwächen. Hinter fast jeder spektakulären Panne steckt ein Muster, das sich in abgewandelter Form immer und immer wieder findet. Deshalb lohnt sich ein Blick nicht nur auf die einzelnen Vorfälle, sondern vor allem auf die Fehlerkategorien, die sie repräsentieren.

Teil 1: Einheiten und Maße: Wenn Zahlen irreführend werden

Am Beginn dieser Serie steht ein Thema, mit dem Entwicklerinnen und Entwickler jeden Tag wie selbstverständlich hantieren – und das vielleicht gerade deshalb so gefährlich ist. Es wird allzu leicht unterschätzt: Die Rede ist vom Umgang mit Zahlen.

Kaum ein Beispiel für Softwarefehler wird so häufig genannt wie der Verlust der NASA-Sonde Mars Climate Orbiter im Jahr 1999. Ziel der Mission war es, die Marsatmosphäre zu untersuchen. Nach einer monatelangen Reise näherte sich die Sonde dem Planeten – und verglühte. Die Ursache war fast grotesk simpel: Die Entwickler hatten in der Software metrische und imperiale Maßeinheiten verwechselt. Das Ergebnis war ein systematischer Navigationsfehler, der die Sonde auf eine zu niedrige Umlaufbahn führte.

Dieser Vorfall zeigt, dass Zahlen ohne Kontext gefährlich sind. Eine Zahl wie 350 kann das Maß einer Geschwindigkeit, einer Kraft oder einer Energie bedeuten – oder eben etwas ganz anderes. Solange eine Software Daten als rohe Zahlen behandelt, besteht die Gefahr, dass jemand sie falsch missinterpretiert. In großen Projekten mit mehreren Teams potenziert sich dieses Risiko, wenn jede Seite implizite Annahmen trifft, die niemand irgendwo explizit dokumentiert oder technisch abgesichert hat.

Aus Sicht der Qualitätssicherung sind solche Fehler besonders tückisch, denn Unit Tests können ebenso wie Integrationstests durchaus korrekt durchlaufen – solange die falschen Einheiten konsistent falsch sind. Das Problem zeigt sich oft erst in der Realität, wenn Sensoren, Aktoren oder externe Systeme ins Spiel kommen, deren Daten den zuvor getroffenen Annahmen nicht entsprechen. Die Lehre aus diesem Vorfall ist klar: Zahlen brauchen Bedeutung. Moderne Programmiersprachen und Frameworks bieten verschiedene Möglichkeiten, diese Bedeutung explizit zu machen:

- Value Objects oder Wrapper-Typen: Statt

doubleoderfloatkommt ein eigener Typ wieForceInNewtonoderVelocityInMetersPerSecondzum Einsatz. Damit wird die Einheit Teil der Typinformation. Manche Programmiersprachen, beispielsweise F#, bieten Unterstützung für Einheiten sogar bereits als Teil der Sprache an. - Bibliotheken für physikalische Einheiten: Sie ermöglichen automatische Umrechnungen und erzwingen korrekte Kombinationen.

- Schnittstellenverträge und End-to-End-Tests: API-Definitionen sollten Einheiten benennen. Tests mit echten Daten decken Diskrepanzen auf, bevor sie zu Katastrophen führen.

Neben diesen technischen Maßnahmen spielt außerdem auch die Teamkultur eine große Rolle. Projekte, die früh auf eine gemeinsame Sprache für ihre Daten achten – sei es durch Domain-Driven Design (DDD) oder einfach durch konsequente Dokumentation –, vermeiden solche Fehler deutlich häufiger.

Der Verlust des Mars Climate Orbiter hat die NASA hart getroffen. Doch er hat auch dazu geführt, dass Entwicklerinnen und Entwickler zumindest in manchen Projekten stärker auf Einheitenfehler achten und diese Fehlerklasse seither (hoffentlich) ernster nehmen. Für Softwareteams im Alltag gilt dasselbe: Wer Zahlen ohne Kontext weitergibt, lädt zum nächsten Bug geradezu ein.

Im nächsten Teil lesen Sie: Überlauf, Arithmetik und Präzision: Wenn Zahlen kippen

(who)

Künstliche Intelligenz

Bundeswettbewerb KI für Schüler: Vom preisgekrönten Projekt zur Marktreife

Die diesjährige Ausgabe des vom Tübingen AI Center ausgetragenen Bundeswettbewerbs KI (BWKI) geht in die heiße Phase. Alle Projekte sind eingereicht und begutachtet, die zehn Finalistinnen und Finalisten stehen fest. Bereits jetzt zeigen sich die Organisatoren zufrieden: Teilgenommen haben an die 350 Schülerinnen und Schüler zwischen 12 und 20 Jahren und damit etwa 40 Prozent mehr als im Vorjahr; der Großteil ist 16 bis 18 Jahre alt. Auch Teilnehmer von deutschen Schulen aus Brasilien, Kolumbien und Peking sind mit von der Partie, an der deutschen Botschaftsschule in Peking gibt es sogar eine BWKI-AG.

Seit dem Jahr 2019 gibt es den Bundeswettbewerb KI (BWKI). Die Initiatoren sind Forschende des Tübingen AI Centers.

Das Tübingen AI Center ist ein vom Bundesministerium für Bildung und Forschung (BMBF) gefördertes Kompetenzzentrum der Universität Tübingen und des Max-Planck-Institut für Intelligente Systeme. Der Hauptförderer der Initiative ist die Carl-Zeiss-Stiftung.

Der BWKI bietet neben seinem Wettbewerb auch einen kostenlosen KI-Kurs für alle Interessierten an. Schulen, die diesen Kurs besonders viel nutzen, habe die Chance „KI-Schule des Jahres“ zu werden.

Sein Thema kann jeder nach Gusto und Interesse wählen, einzige Bedingung: Es soll dem Wohle der Gesellschaft dienen und einen konkreten praktischen Nutzen haben. Dementsprechend groß ist das Themenspektrum, wie BWKI-Sprecher Sören Drabesch im Interview mit c’t erklärt. Und das Konzept scheint auch in anderer Hinsicht aufzugehen: Nicht wenige Jugendliche bleiben danach am Ball und versuchen, ihre zwar funktionierenden, aber noch unfertigen Systeme zu perfektionieren oder gar zur Marktreife zu bringen. Zwei davon stellen wir im Folgenden vor.

Man darf also gespannt sein, welche Ideen die Jury in diesem Jahr am meisten überzeugen – und was später einmal daraus wird. Alle zehn Auserwählten dürfen am 14. November 2025 zum Finale reisen und ihre Projekte präsentieren. Es findet diesmal nicht in den heimischen Gefilden der Veranstalter statt, sondern im Frankfurter Museum für Kommunikation, das künstliche Intelligenz als Schwerpunktthema für das Jahr 2025 auserkoren hat. Dort werden vier Preise vergeben: außer dem Hauptpreis auch „AI for Good“ für ein besonders nachhaltiges Projekt, „No risk, no fun!“ für einen besonders innovativen Ansatz sowie der Publikumspreis, über den die Öffentlichkeit ab sofort abstimmen darf.

Das war die Leseprobe unseres heise-Plus-Artikels „Bundeswettbewerb KI für Schüler: Vom preisgekrönten Projekt zur Marktreife“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

Künstliche Intelligenz

„Anno 117“ im Test: Rom für Zuckerbäcker

Weiterlesen nach der Anzeige

Wenn eine Aufbauserie so altbekannt ist, dass Fans schon vorher wissen, welche Quersumme sie aus den Zahlen im Titel bilden können, was soll eine Fortsetzung dann noch Neues bieten? Bei der Beantwortung dieser Frage hat sich die Anno-Serie schon einmal verirrt. „Anno“ steht wie kaum eine andere Serie für den Aufbau malerisch schöner, historischer Welten, wie vom Konditor aus Lebkuchen gezaubert und ins Schaufenster gestellt.

Doch nach erfolgreichen Spielen zwischen dem 15. und 18. Jahrhundert erschienen Fortsetzungen, die in der Zukunft spielten oder während der Industrialisierung. Sie näherten sich aktuelleren gesellschaftlichen Problemen von der Umweltzerstörung bis zu sozialer Gerechtigkeit an. Ein Widerspruch aber wurde nie so richtig aufgelöst: Soll das immer noch eine interaktive Postkartenidylle sein?

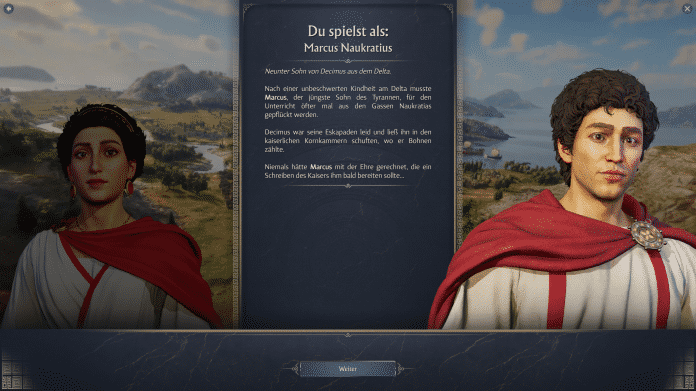

Schon durch das antike Rom als Szenario wirkt das neue „Anno 117“ wie eine Rückkehr zu alten Stärken. Es ist das erwartet große Spiel, ein üppiges Buffet, das man auch nach knapp 20 Stunden Spielzeit nicht abschließend beurteilen kann. Die wendungsreiche Kampagne ist zwar wieder eine Art Tutorial, bietet aber gewichtige Entscheidungen und zwei verschiedene Hauptcharaktere. Multiplayermöglichkeiten auch mit Koop, ein Endlosmodus mit vielen Einstellungsmöglichkeiten und zwei Regionen ergeben eine große Auswahl der Spielmöglichkeiten. Gebaut wird nicht nur im römischen Latium, sondern auch im fernen Albion, wo die unheimlichen Kelten im Sumpfland siedeln und Aale verschlingen.

Solides Zuckerbäckerhandwerk

Die schroffen Inseln im Norden funktionieren vor allem als andere Tapete für den virtuellen Urlaub: hier mediterran mit warmer Sonne, dort üppig grün mit spannendem Wetter. Stürmisch und versumpft sind die Inseln im fernen Norden. Doch trotz aller Witze über den Achselschweiß der romanisierten Wilden ist das neue „Anno“ immer idyllisch. Die meiste Zeit blickt man von weit oben auf eine Siedlung wie aus dem Modellbau. Sie wird wunderschön detailliert gerendert, von kleinen Menschlein durchwuselt und von dynamischen Wettereffekten in ein immer neues Licht gerückt.

Jan Bojaryn

)

Die Reibung beim Aufbau wirkt altbekannt. Man muss ein Netzwerk aus Produktionsketten knüpfen, platziert Holzfäller, Sägewerk und Lagerhaus wie an einer Perlenschnur, puzzelt Fischhütte, Bauernhof und Marktplatz mit Wohnhäusern ins Raster. Dabei müssen die Abstände zueinander stimmen, die Zahl der Arbeiter muss zu den Gebäuden passen, und in den ersten Stunden jeder Partie gibt es immer noch eine Produktionskette, die man nebenbei errichtet. Später geht es dann eher um Reparaturen am laufenden Motor, wenn Handel oder Krieg die Karten neu mischen.

Weiterlesen nach der Anzeige

Dass stinkende Gewerbe jetzt auch Abwertungen bringen oder dass im Forschungsbaum zahlreiche Wahlmöglichkeiten stecken, ändert nicht viel am Spielgefühl. In der Grundeinstellung spielt sich „Anno 117“ sehr zugänglich und der Aufbau erlebt eher sanfte Bodenwellen statt großer Hindernisse. Auch wenn die ersten Siedler jetzt „Liberti“ heißen: Wer Anno kennt, für den ist dieses Spiel ein Wiedersehen mit einem alten Bekannten.

Déjà-vu im Freilichtmuseum

Auch wenn Anno seine besten Zeiten zwischen dem 15. und 18. Jahrhundert hatte: Das neue Spiel sieht dermaßen klassisch aus, dass man beim Spielen noch einmal schauen muss, ob es das nicht doch schon gab. Gab es aber nicht; antiken Städtebau haben diverse andere Serien bedient, an die man sich hier auch erinnert fühlen kann.

Ob im fein einstellbaren Endlosmodus oder der Kampagne, alles beginnt mit einer weitgehend leeren Insel. In der Kampagne hat ein Vulkanausbruch für Neuland mit hübsch herumstehenden Ruinen gesorgt. Der Anfang ist bescheiden, mit einem kleinen Vorrat an Ressourcen, aus dem Wohnhäuser, Holzfäller, Sardinenhütte, Haferhöfe und Lagerhäuser errichtet werden. Wer die Bedürfnisse der ersten Siedler befriedigt, kann sie zu Plebejern hochstufen. Dadurch können sie neue Jobs erledigen, mehr Geld abwerfen, haben aber auch neue Bedürfnisse. Schnell wird die erste Praetorenvilla gebaut, Wachstationen zur Abwehr von Feuer und Verbrechen, ein personalhungriges Militär und allerlei Deko-Objekte.

Die Ressourcen sind mechanisch austauschbar, aber stimmungsvoll. Früh in der Kampagne schwärmt der Kaiser so ausgiebig vom Aroma des Garum, dass man den vergorenen Fisch fast riechen kann. Unangekündigt losquatschende Charaktere gibt es auch im Endlos-Modus, doch mehr Sinn ergeben sie in der Kampagne. Hier wird eine launische und bewegte Geschichte inszeniert, die nicht beim Klischeebild der Antike stehenbleibt, sondern von Rom als zerfahrenem Weltreich erzählt. Der eigene Praetor kommt aus Ägypten und darf sich nur kurz in Latium beweisen, bevor es abrupt nach Albion geht.

Die Charaktere sind hinterlistig oder arrogant, hasenfüßig oder frech. Ihre Auftritte erinnern allerdings weniger an Hollywood, eher an Bilderbücher oder Terra-X-Dokus. Neben einigen kurzen Videos müssen Bildtafeln, sprechende Porträts und Multiple-Choice-Menüs reichen. Interessant wird die Erzählung vor allem durch zahlreiche Entscheidungen. Sie sorgen dafür, dass man auch in der linear erzählten Kampagne das Gefühl behält, am Steuer zu sitzen.

Die Grundeinstellung der Kampagne ist eher einfach. Allerdings lässt sich die Schwierigkeit auch in Details nachregeln. Vor allem im Endlosmodus darf man auch mit knappen Ressourcen gegen kriegerische Nachbarn antreten.

Künstliche Intelligenz

Kommentar zur KI-Blase: Sam Altman mimt den Oppenheimer des 21. Jahrhunderts

Weltweit reiben sich Ökonomen und Anleger die Augen: OpenAI meldet zweistellige Milliardenverluste pro Quartal, und jeder noch so kleine YouTuber mit Anlegertipps warnt inzwischen vor dem Platzen der KI-Blase. Und doch pumpen Investoren weiter Geld in KI, während OpenAI-Chef Sam Altman erklärt, die Betriebskosten interessierten ihn nicht im Geringsten. Wie ist diese Diskrepanz zwischen Horrorzahlen und ungebrochener Investitionsfreude zu erklären?

Weiterlesen nach der Anzeige

Die Strategie des „Wachstums, koste es, was es wolle“ ist altbekannt: Amazon, Uber, Netflix – sie alle verbrannten in den ersten Jahren Kapital, um Märkte zu erobern. Aber ihre Verluste bewegten sich im einstelligen Milliardenbereich pro Jahr, nicht bei über elf Milliarden in einem einzigen Quartal. Und sie hatten Geschäftsmodelle, bei denen Skaleneffekte irgendwann die Kosten drückten.

Redakteur Hartmut Gieselmann, Jahrgang 1971, ist seit 2001 bei c’t. Er leitet das Ressort Anwendungen, Datenschutz & Internet und bearbeitet unter anderem aktuelle Themen rund um die Bereiche Medizin-IT, Netzpolitik und Datenschutz.

OpenAI dagegen betreibt eine Technologie, deren variable Kosten – Chips, Strom, Rechenzentren – mit jeder Generationsstufe steigen. Laut einer Analyse der Unternehmensberatung Bain wäre bis 2030 in der KI-Branche ein globaler Jahresumsatz von zwei Billionen Dollar (sic!) nötig, um die benötigte Rechenleistung zu finanzieren. Die Lücke ist so groß, dass sie mit Abomodellen schlicht nicht zu schließen ist. Sie ist ein klares Signal an alle potenziellen Konkurrenten: Ihr könnt hier nicht mitspielen, ohne euch zu ruinieren.

Trotzdem zieht niemand den Stecker. Warum?

OpenAI geht es nicht darum, bloß ein neuer Player der globalen Plattformökonomie zu werden. Es geht vielmehr um geopolitische Machtsicherung. Die USA behandeln fortgeschrittene KI inzwischen wie ein nationales Infrastrukturprojekt. Es ist für sie das geopolitische Großprojekt des 21. Jahrhunderts, mit dem sie ihre Dominanz sichern wollen.

Palantir-Chef Alexander Karp hat eine solche nationale Großanstrengung in seinem Buch „The Technological Republic“ offen gefordert. Und Trumps Entscheidung, die leistungsfähigsten Nvidia-Chips exklusiv in den USA zu halten, zeigt das unverblümt. Das Weiße Haus hat im Herbst bereits angekündigt, den Ausbau von Rechenzentren als „kritische Infrastruktur“ zu priorisieren. Was hier entsteht, ähnelt eher dem Manhattan-Projekt als dem nächsten iPhone aus dem Silicon Valley.

Wie beim Atomprogramm der 40er Jahre entsteht eine technologisch, politisch und finanziell abgeschirmte Großstruktur, die nur unter staatlicher Protektion funktionsfähig ist. Es gelten dann andere Regeln: Nvidia, Microsoft, OpenAI und Co. werden gegen ausländische Konkurrenz abgeschirmt, rechtlich privilegiert und politisch getragen. Die Verluste sind keine betriebswirtschaftlichen Fehlplanungen, sondern Vorleistungen für ein Machtinstrument, das später kaum noch einholbar ist. Deshalb verwundert es nicht, dass Altman mit seinen nationalen Ausbauplänen und seiner demonstrativen Gleichgültigkeit gegenüber den gigantischen Kosten auftritt, als stünde er an der Spitze eines neuen Manhattan-Projekts.

Weiterlesen nach der Anzeige

Wer die technologische Infrastruktur kontrolliert, bestimmt die Standards, Protokolle und Abhängigkeiten der nächsten Jahrzehnte. Und die USA haben in ihrer Geschichte mehrfach bewiesen, dass sie zur Absicherung technologischer und wirtschaftlicher Vorherrschaft selbst vor gravierenden Kollateralschäden nicht zurückschrecken und geopolitische Prioritäten über ökologische und gesellschaftliche Folgen stellen. Die absehbaren Schäden des KI-Ausbaus für Umwelt und Klima gelten in Washington als verkraftbarer Preis.

Strategische Warnungen vor dem Crash

Die offenen Anspielungen der CEOs wie Mark Zuckerberg auf das mögliche Platzen der KI-Blase sind in diesem Kontext kein Alarmruf, sondern strategisch platzierte PR. Wer öffentlich vor einer Überbewertung warnt, signalisiert Investoren, dass nur die größten Player stabil genug sind, um einen Crash zu überstehen. Das erschwert kleineren Konkurrenten die Finanzierung und senkt deren Übernahmepreis, sobald die Kurse in den Keller rauschen.

Angesichts dieses Gigantismus muss Europa einen anderen Weg einschlagen als die USA. Weder Gigawatt-Rechenzentren noch milliardenschwere Chipfabriken sind eine realistische Option; ökologisch wären sie ein Desaster. Souveränität heißt stattdessen, die Kontrolle über Standards, Schnittstellen und Zugänge zu behalten: offene Modelle, offene Daten, gemeinsame europäische Compute-Cluster, klare Interoperabilitätsvorgaben und eine demokratische Aufsicht über die KI-Systeme, die in Wirtschaft und Verwaltung eingesetzt werden.

Die Schweiz zeigt mit dem Apertus-Programm, dass ein solcher Weg möglich ist. So könnte sich Europa langfristig vom KI-Tropf der USA abnabeln, ohne den Kontinent in eine zweite Rechenzentrumswüste nach dem Vorbild Arizonas zu verwandeln.

(hag)

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenHarte Zeiten für den demokratischen Rechtsstaat

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events