Apps & Mobile Entwicklung

Lidl verkauft gerade ein beliebtes Gadget, das Euch den Winter rettet!

Ja, es ist Sommer. Tatsächlich erwartet uns in den nächsten Tagen eine Hitzewelle. Dennoch hat Lidl ein Angebot auf Lager, dass sich vor allem im Winter richtig lohnt. Das Gadget gibt es beim Discounter jetzt mit winterlichen 63 Prozent Rabatt. Warum sich der Kauf genau jetzt lohnt, verrät unser Deal-Check.

Lidl scheint sich das Stichwort „antizyklisch“ auf die Fahne geschrieben zu haben. Während der August zeigt, was er drauf hat, reduziert der Supermarkt nämlich ein beliebtes Winter-Gadget deutlich. Die Rede ist hier vom Tado Starter-Kit V3+. Aktuell gibt’s das smarte Heizkörperthermostat samt WLAN-Bridge fast 50 Euro günstiger* als bei allen anderen Online-Shops.

Der Winter kann kommen: Lohnt sich das Tado Starter-Kit V3+?

Okay, ich sitze hier mit einem Ventilator und mir läuft die eiskalte Brühe über den Nacken, aber das bedeutet natürlich nicht, dass es ewig so heiß sein wird. Vor allem Menschen, die in Altbau-Wohnungen leben kennen die Probleme, die eine schlechte Isolierung mit sich bringt: Im Sommer ist es zu heiß und im Winter zu kalt. Damit sind gehen zudem extrem hohe Heizkosten in der kalten Jahreszeit einher, die einen Großteil der Nebenkosten ausmachen können. Möchtet Ihr diese senken, lohnt sich ein smartes Heizkörperthermostat (Kaufberatung) definitiv.

Einer der absoluten Vorreiter dieser Gadgets ist Tado. Das Unternehmen bietet mit dem Starter-Kit V3+ zudem alles, was Ihr benötigt. Neben dem Thermostat ist nämlich auch die passende Bridge, sowie ein Adaptersatz, ein EU- und UK-Netzadapter und die nötige Anleitung im Lieferumfang enthalten. Ich habe mir selbst solche Thermostate verbaut und kann Euch daher sagen, dass der Einbau absolut kein Problem ist. Ich bin handwerklich ungefähr auf dem Niveau meines Hundes, kann also nicht einmal ein Regal gerade an die Wand bringen.

Dennoch war es beim Heizkörperthermostat extrem leicht. Ihr benötigt hierfür nur eine Rohrzange und etwas kraft. Dreht das alte Thermostat ab, steckt das Tado-Thermostat auf die Öffnung und zieht es fest – fertig. Anschließend müsst Ihr nur noch einen Steckplatz für die Bridge verbinden und die beiden Geräte miteinander koppeln. In der Tado-App seht Ihr dann einerseits, wie hoch Euer Verbrauch ist und andererseits könnt Ihr hier Zeitpläne und Routinen einrichten. Ihr könnt die Thermostate auch einfach in Euer Smart Home einbinden und so via Sprachbefehl steuern. Möchtet Ihr noch mehr erfahren, lohnt sich ein Blick in unseren Testbericht zum Tado V3+.

Smartes Thermostat im Sommer kaufen? Deshalb ergibt es Sinn!

Möchtet Ihr also Eure Heizkosten effektiv senken und vor allem die volle Kontrolle haben, ist die Anschaffung eines smarten Thermostates durchaus sinnvoll. Der Zeitpunkt ist nur etwas befremdlich. Allerdings nicht komplett abwegig, wenn wir uns den Preisvergleich anschauen. Lidl verlangt gerade 55,05 Euro für das Tado Starter-Kit V3+*. Hier kommen noch einmal 4,95 Euro für den Versand hinzu, was dennoch deutlich unter dem nächstbesten Angebot liegt. Denn für dieses zahlt Ihr gerade mindestens 107,95 Euro.

Vor allem von September bis Dezember, also dann, wenn es richtig kalt wird, kosten smarte Thermostate deutlich mehr. Jetzt könnt Ihr also bereits für den nahenden Winter vorsorgen. Den bisherigen Bestpreis von 39,99 Euro erreicht das Set zwar nicht ganz, aber im Vergleich ist dieser Deal durchaus einen Blick wert. Übrigens: Lidl bietet derzeit auch das Tado-Einzelthermostat für 59,99 Euro* (UVP: 89,99 Euro) an. Hier könnte sich ein wenig Geduld jedoch auszahlen.

Was haltet Ihr von dem Angebot? Ist das Tado Starter-Kit V3+ interessant für Euch? Kauft Ihr antizyklisch ein, um Geld zu sparen? Wir sind gespannt auf Eure Kommentare!

Apps & Mobile Entwicklung

Langzeittest: Schadet schnelles Laden dem Smartphone-Akku?

Um zu ermitteln, ob schnelles Laden einen Nachteil für die Alterung von Smartphone-Akkus bedeutet, hat der YouTube-Kanal HTX Studio ein Langzeitexperiment gewagt. Über einen Zeitraum von sechs Monaten wurden zahlreiche Smartphones sowohl schnell als auch langsam geladen.

Das Vorgehen beim Test

Insgesamt kamen bei dem Test 20 Smartphones zum Einsatz: jeweils zehn iPhone 12 mit iOS und zehn Vivo iQOO 7 mit Android. In beiden Lagern wurden jeweils drei Geräte im Schnelllademodus betrieben, drei auf langsame Weise geladen und drei in einem Bereich von 30 bis 80 Prozent Akkustand im Schnelllademodus geladen. Jeweils 500 Ladezyklen mussten sie überstehen. Das jeweils zehnte Gerät diente als „Kontrollgruppe“ und wurde im Rahmen des sechsmonatigen Tests gar nicht aufgeladen. Damit sollte der Zeitfaktor ermittelt werden, also wie viel Kapazität allein über die Zeit verloren geht, ohne dass ein Ladezyklus stattfindet.

Bei dem Test wurde auf den Smartphones eine App ausgeführt, die für das stetige Entladen des Akkus sorgt. Sobald der Akkustand auf 5 Prozent fiel, schickte die App ein Signal an die Ladegeräte, die sodann mit dem vollständigen Aufladen auf 100 Prozent begannen. In der Gruppe mit 30 bis 80 Prozent Akkustand wurde entsprechend anders verfahren.

Die Ergebnisse

Unterm Strich gibt es Entwarnung für jene, die befürchten, dass ihr Akku unter der Schnellladefunktion leidet. Die verbliebene Akkukapazität war bei den Probanden mit schnellem und langsamem Laden nahezu identisch bei weniger als 1 Prozent Differenz. Dafür zeigte sich die Gruppen, in der stets zwischen 30 und 80 Prozent geladen wurde, als beständiger. Das Ent- und Aufladen in diesem Bereich schont den Akku also auch in der Praxis, sodass dieser im Falle der iPhones eine um 4 Prozent höhere Kapazität als beim vollständigen Schnellladen besaß. Bei den Android-Phones lag die Differenz bei 2,5 Prozent.

Die beiden vor dem Versuch formulierten Fragen konnten also wie folgt beantwortet werden:

- Schadet das schnelle Laden dem Akku mehr als langsames Laden? Nein, so gut wie nicht.

- Ist es von Vorteil, den Akku im Bereich von 30 bis 80 Prozent der Kapazität zu halten? Ja, das bietet zumindest im geringen Maße einen Vorteil.

Apps & Mobile Entwicklung

Steam Sale: Neue Rabattaktion dreht sich um Tiere in Spielen

Immer wieder hält Valve auf Steam abseits der vier großen jährlichen Steam Sales auch kleinere Rabattaktionen mit klarem Genre- oder Themenbezug ab. Immer wieder heißt dabei fast immer. Jetzt ist eine Rabattaktion zu Tierspielen gestartet. Die Angebote laufen bis zum 17. November um 19:00 Uhr.

Tierische Angebote

Diesmal dreht sich die Rabattaktion um sämtliche Arten von Spielen, bei denen Tiere eine Rolle spielen. Und damit sind nicht ausschließlich Zoo-Simulationen gemeint, sondern etwa auch Titel, in denen Spieler höchstselbst in tierischer Gestalt unterwegs sind, Scharen von Ameisen auf ein RTS-Schlachtfeld führen oder aber in anderer Weise umfangreich mit Tieren interagieren können. Ein Trailer zum Event stellt einige rabattierte Spiele wie gewohnt kurz vor.

Neben rabattierten Games rückt Valve außerdem auch kostenlose Demos und bald erscheinende Games in den Mittelpunkt. Diesmal sind auch die gewohnten drei Dreingaben im Steam-Punkteshop wieder mit von der Partie: Dort lassen sich bis zum Ende der Aktion ein animierter Avatar, ein Profilrahmen und ein animierter Sticker abholen.

Zu bedenken ist bei derartigen Rabattaktionen wie üblich, dass Sale-Preise nicht unbedingt Tiefstpreise sein müssen. Eine Übersicht über derzeit reduzierte Spiele, bisherige Tiefstpreise und diverse Filter-Optionen liefert die Datenbank SteamDB. Wer am Event teilnehmende und derzeit im Preis reduzierte Spiele empfehlen möchte, kann dies gerne in den Kommentaren tun. Auch Anmerkungen oder Erfahrungen zu teilnehmenden Titeln sind gerne gesehen.

Nach dem Steam Sale ist vor dem Steam Sale

Nach dem Festival der Tierspiele folgen bis zum Jahresende noch zwei weitere Rabattaktionen, wobei die letzte der große Steam Sale zum Winter ist, der bis in den Januar 2026 reichen wird. Davor sind aber Sportspiele an der Reihe.

Apps & Mobile Entwicklung

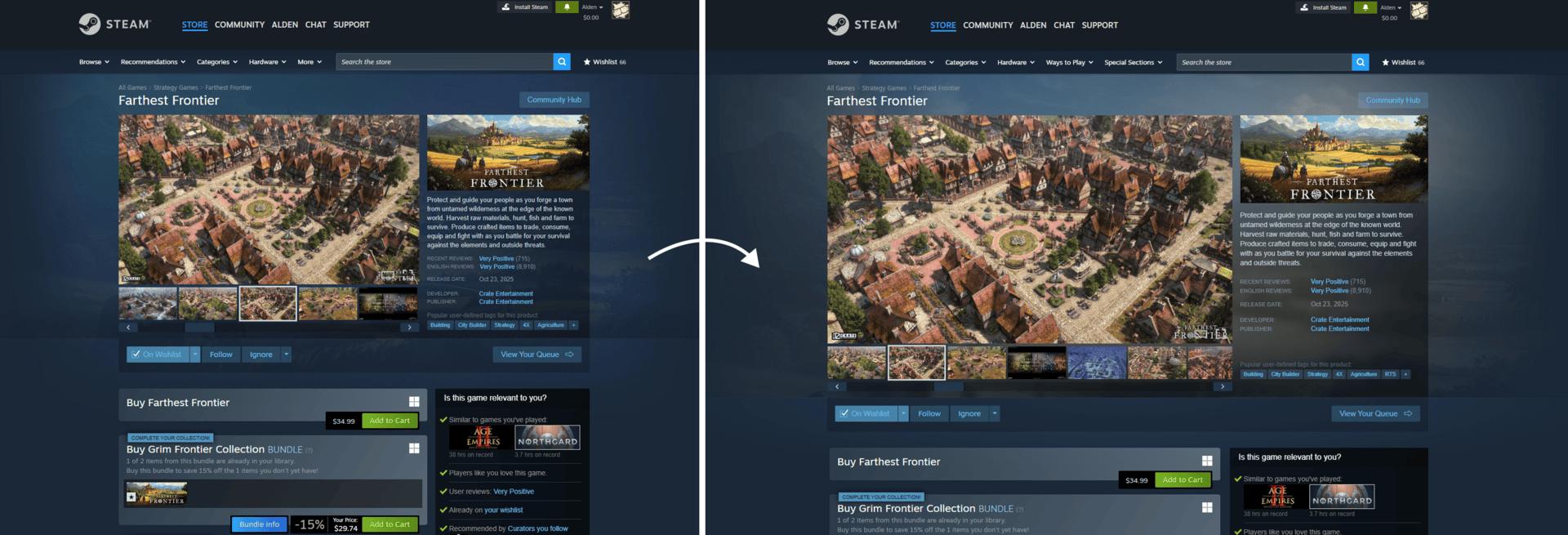

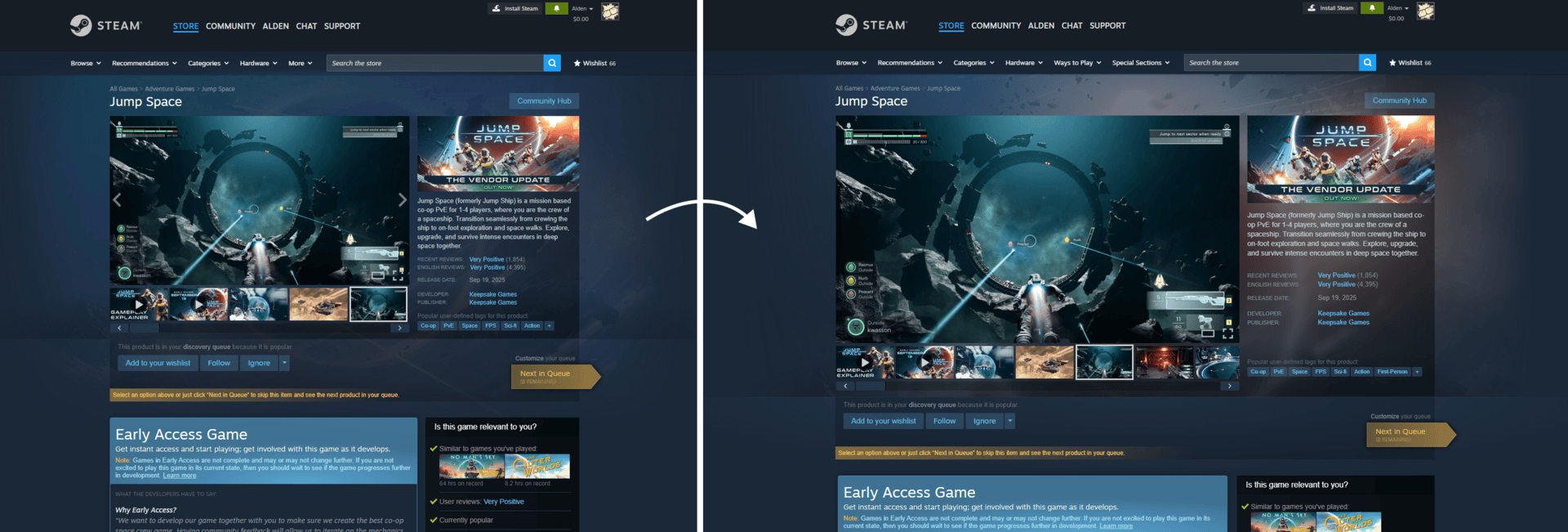

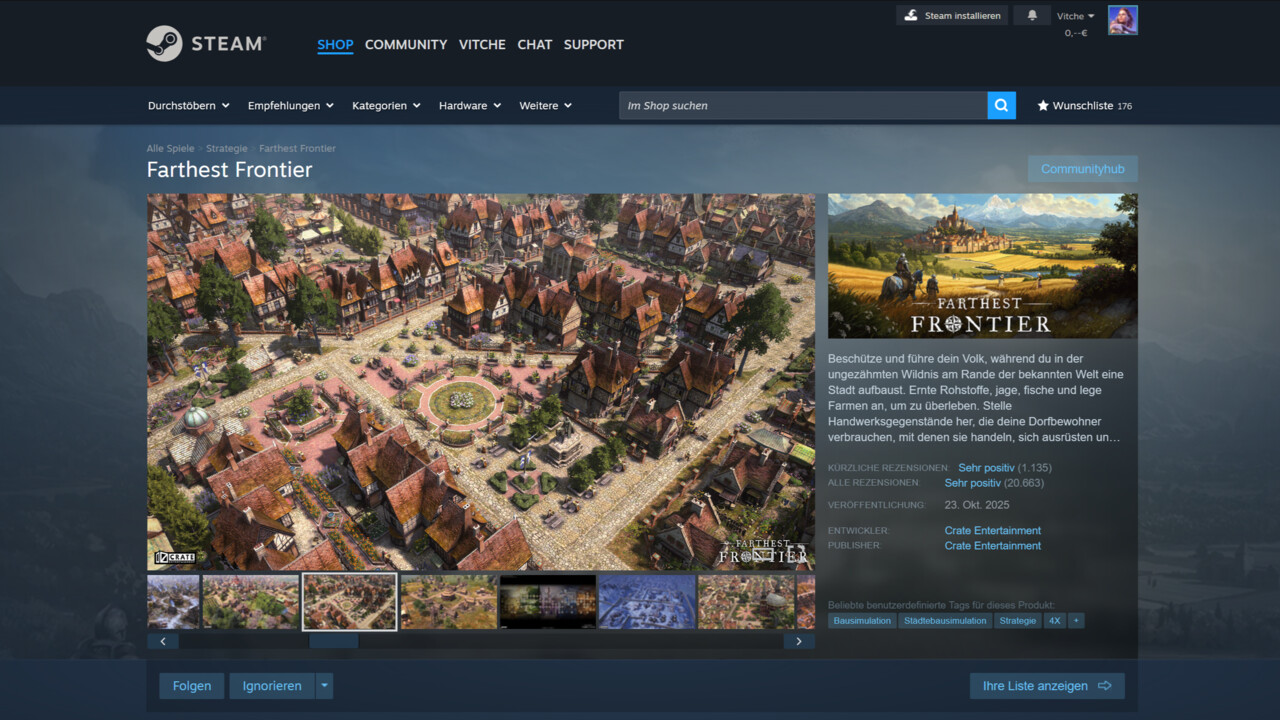

Valve: Steam-Shopseiten sind jetzt breiter gebaut

Steam-Betreiber Valve ist über die vergangenen Monate mit der Überarbeitung des Shops beschäftigt. Nach dem Menü und dem Video-Player ist jetzt in erster Linie das Layout der Spiele-Shopseiten selbst an der Reihe. Neben einer höheren Breite gibt es auch höher auflösende Bilder.

Steam-Shopseiten sind jetzt 1.200 Pixel breit

Die Shopseiten auf Steam werden breiter. Gemeint ist damit vorerst nicht der gesamte Shop-Bereich, sondern insbesondere die Übersichtsseiten zu konkreten Spielen inklusive Rezensionen. Übers Wochenende hat Valve deren Breite auf 1.200 Pixel statt zuvor 940 Pixel angehoben. Dem folgen außerdem die Suchergebnisse im Steam-Shop sowie diverse Empfehlungs- und Statistik-Seiten. Die Änderungen betreffen sowohl Desktop-Clients als auch den Steam-Store im Browser.

Der linke Teil der Shopseiten, den Spiele-Publisher und -Entwickler weitestgehend frei gestalten können, wächst damit einhergehend von 616 Pixel auf 780 Pixel Breite. Außerdem hält ein neues Karussell für Trailer und Screenshots Einzug, das jetzt für Bild- und Videodateien einen Kino- und Vollbildmodus unterstützt, wie er beispielsweise von YouTube bekannt ist. Des Weiteren wurde die maximale Auflösung für verschiedene Bildtypen auf den Shopseiten erhöht. Das neue Layout wurde bereits seit August im Rahmen eines Beta-Programms getestet und jetzt für alle Steam-Accounts ausgerollt.

Valve begründet die Änderungen mit der wachsenden Verbreitung hochauflösender Displays. Insbesondere werde Steam immer häufiger auf UHD-Bildschirmen mit 3.840 × 2.160 Pixeln geöffnet. Die volle Bildschirmbreite solcher Monitore werde aber weiterhin nicht veranschlagt, weil die meisten entsprechenden Nutzer Steam nicht im Vollbildmodus, sondern in Fensteransicht verwenden würden – 1.200 Pixel wären folglich ein guter Kompromiss. Damit ist der Steam-Betreiber nicht allein, eben diese Breite etabliert sich über die letzten Jahren als neuer Standard für den zentralen Content-Bereich von Websites. Auf ComputerBase kommt aktuell auch für hochauflösende Displays noch eine Breite von 960 Pixeln zum Einsatz.

Valve greift Fragen vor

Bei kleineren Viewports reagiere das Steam-Layout stets responsiv, nimmt Valve die Antwort auf die potenzielle Frage hinweg, wie sich Steam zukünftig auf Full-HD-Bildschirmen verhalte. In diesem Fall werde also nichts abgeschnitten, stattdessen skaliere das Layout sukzessive bis hin zur Mobile-Ansicht. Außerdem kündigt Valve an, dass die Startseite des Steam-Shops „zeitnah“ folgen soll. Erst in Juli und September wurden der integrierte Video-Player respektive das Shop-Menü aktualisiert. Außerdem hat Valve erst kürzlich einen neuen Steam-Kalender vorgestellt, der individuell auf den jeweiligen Nutzer zugeschnittene aktuelle und kommende Veröffentlichungen aufzeigt.

-

Ich finde das gut, das neue Layout gefällt mir.

-

Ich mag das nicht, das alte Layout war für mich übersichtlicher.

-

Das ist mir ehrlich gesagt komplett egal.

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenHarte Zeiten für den demokratischen Rechtsstaat

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events