Apps & Mobile Entwicklung

Nvidia, Telekom, SAP: Deutsche KI-Cloud mit 10.000 GPUs geht Anfang 2026 online

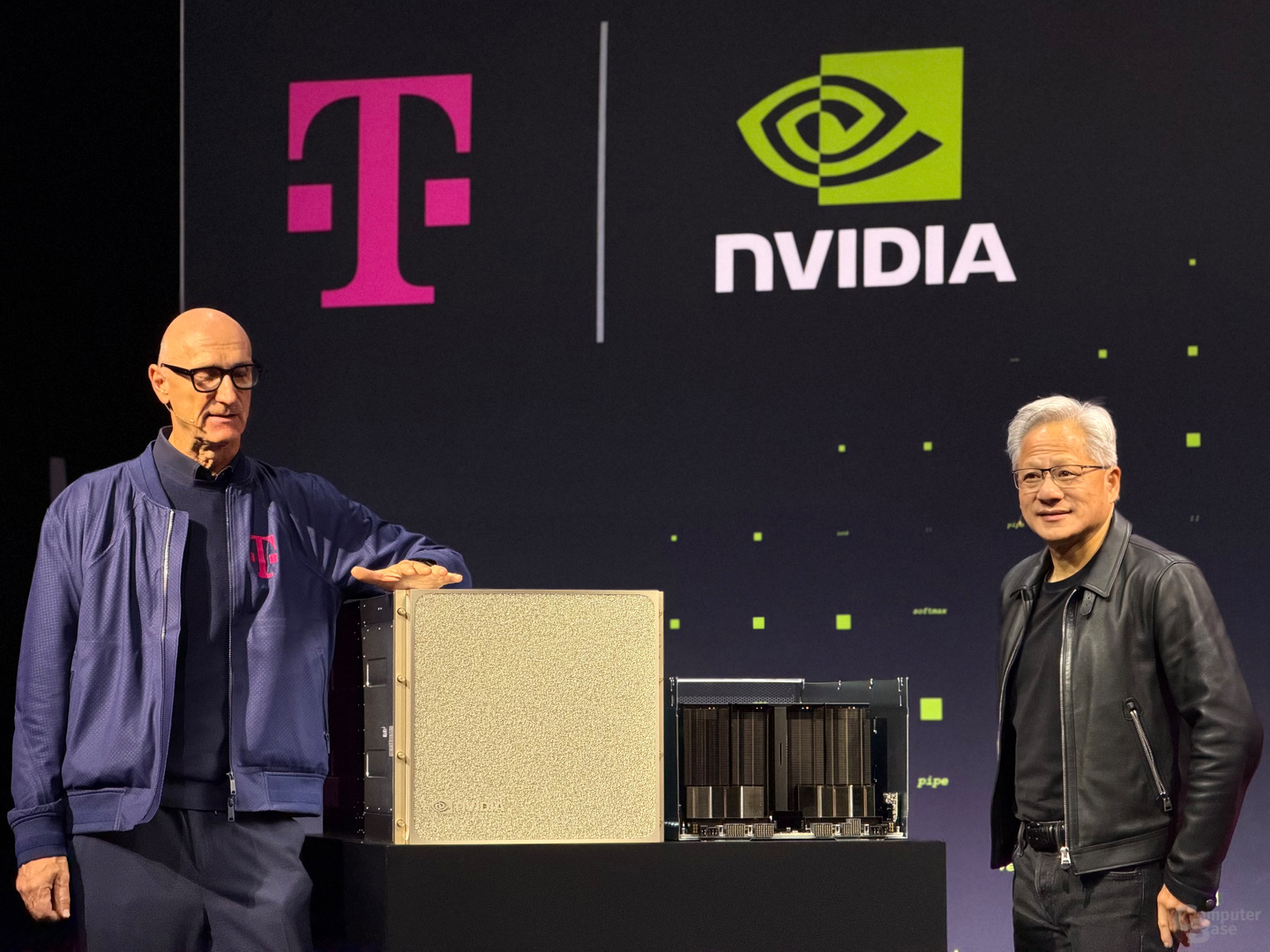

Nvidia und Telekom hatten im Juni ihre Pläne einer 10.000 GPU starken „Industrial AI Cloud“ in Deutschland bekannt gegeben. Heute haben die Partner erklärt, dass sie im ersten Quartal 2026 mit dem neuen Datacenter-Standort bei München online gehen wollen. Damit werde die AI-Kapazität in Deutschland um 50 Prozent gesteigert.

„Jetzt gibt es keine Ausreden mehr“, sagte Timotheus Höttges, CEO der Deutschen Telekom, zum Termin in Berlin und meinte damit die deutsche Industrie, die mit der „Industrial AI Cloud“ in Deutschland jetzt nicht mehr argumentieren könne, dass es hierzulande keine souveränen KI-Kapazitäten gebe. Es folgten dramatisch Worte: „Deutschland wird nicht überleben, wenn wir diese neue Technologie nicht nutzen.“

Deutsche KI-Kapazität um 50 Prozent steigern

Der Aufbau eines Datacenters mit 10.000 GPUs steigere die AI-Kapazität in Deutschland auf einen Schlag um 50 Prozent, erklärten die Partner. In Europa stünden derzeit lediglich 5 Prozent der globalen GPU-Leistung für Künstliche Intelligenz. In den USA hingegen 70 Prozent, in China 14 Prozent. Diesen Rückstand will die Deutsche Telekom reduzieren. Für das Projekt haben die Partner 1 Milliarde Euro in die Hand genommen. Von der Idee bis zum Launch sei nur ein halbes Jahr vergangen.

Startschuss im ersten Quartal 2026

Nachdem Nvidia zuerst zur Computex im Juni in Aussicht gestellt hatte, dass Deutschland eine „Industrial AI Cloud“ bekommen wird, folgte wenige Tage später die offizielle Ankündigung der Kooperation mit der Deutschen Telekom.

Jetzt ist bekannt, dass das Datacenter bei München aufgebaut wird und im Laufe des ersten Quartals 2026 für Kunden online gehen soll. Soweit bekannt ist, wurde als Standort der Tucherpark im Stadtteil Schwabing-Freimann gewählt. Dort ist die „Industrial AI Cloud“ mehrere Stockwerke unter der Erde an einem ehemaligen Datacenter-Standort der Hypovereinsbank entstanden. Die Kühlung soll dabei unter anderem über den Eisbach erfolgen, der parallel zur Isar durch den Tucherpark fließt.

Telekom setzt auf DGX B200 und RTX Pro Server

Die Telekom hat sich bei ihrer „Industrial AI Cloud“ für „mehr als tausend“ Nvidia DGX B200 und RTX Pro Server entschieden. Die noch dichter gepackten GB200- und GB300-Racks, die ausschließlich mittels Wasserkühlung betrieben werden können, sind demnach nicht für den Standort gewählt worden.

DGX B200 ist die weniger dicht gepackte, luftgekühlte x86-Plattform von Nvidia, bei der sich ein Node aus zwei Xeon Platinum 8570 und acht Nvidia B200 zusammensetzt – acht Packages und demnach 16 GPU-Dies. Bis zu 72 PFLOPS für das Training und 144 PFLOPS für das Inferencing stellt eines dieser Systeme bei einem Energiebedarf von bis zu 14,3 kW zur Verfügung. Bei den RTX Pro Servern handelt es sich um luftgekühlte Systeme mit acht RTX Pro 6000 Blackwell Server Edition via PCIe.

12 Megawatt aus erneuerbaren Energien

Den Energiebedarf des Rechenzentrums bezifferte Höttges mit 12 Megawatt, die vollständig aus erneuerbare Energien stammen sollen. Die Deutsche Telekom betreibt und least derzeit insgesamt 184 Rechenzentren mit einem Energiebedarf von 390 MW.

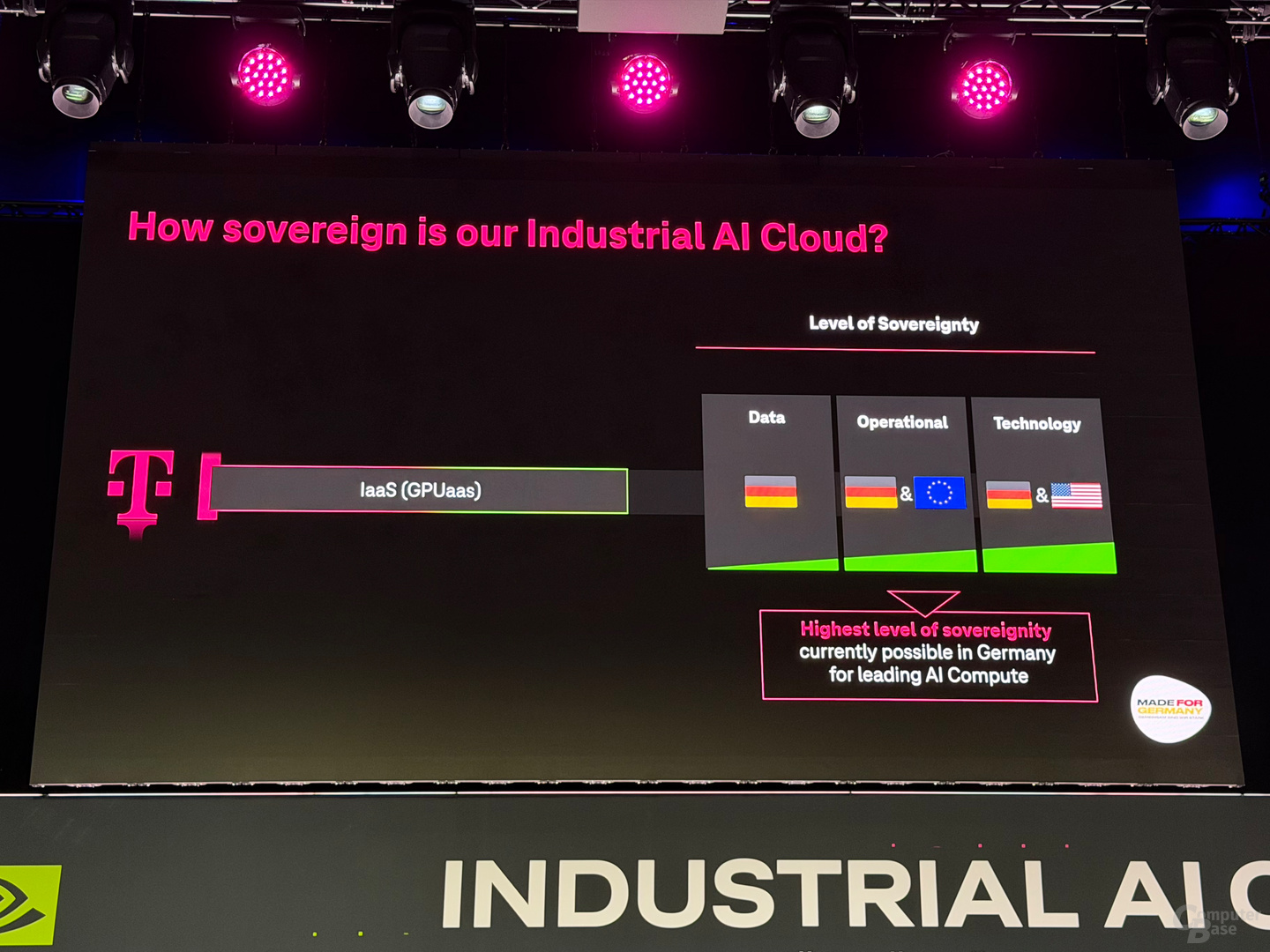

Deutsche KI-Souveränität mit US-Technologie

Geschaffen werden soll eine digitale Infrastruktur für öffentliche Einrichtungen und innere Sicherheit. Die physische Infrastruktur stellt die Deutsche Telekom, während SAP die eigene Business Technology Platform und Anwendungen beisteuert. Von einem „Deutschland-Stack“ und deutscher KI-Souveränität war zur Ankündigung die Rede. Darauf sollen künftig alle digitalen Lösungen für die genannten Zielgruppen entwickelt werden. Während die Technologie aus den USA und Deutschland stammt, soll der Betrieb in deutscher und europäischer Hand liegen. Die Daten sollen jedoch vollständig in Deutschland verbleiben.

Kunden aus dem B2B- und B2C-Segment

Passend dazu wurden heute die ersten Kunden und Nutzer der „Industrial AI Cloud“ genannt. Das sind im B2B-Sektor Siemens, Agile Robots, Wandelbots, PhysicsX und EY. Mit Quantum Systems ist zudem ein deutscher Hersteller von zivilen und militärischen Überwachungsdrohnen vertreten. Und im B2C-Segment schafft die Deutsche Telekom mit dem Datacenter neue Inferencing-Kapazitäten für den AI-Anbieter Perplexity.

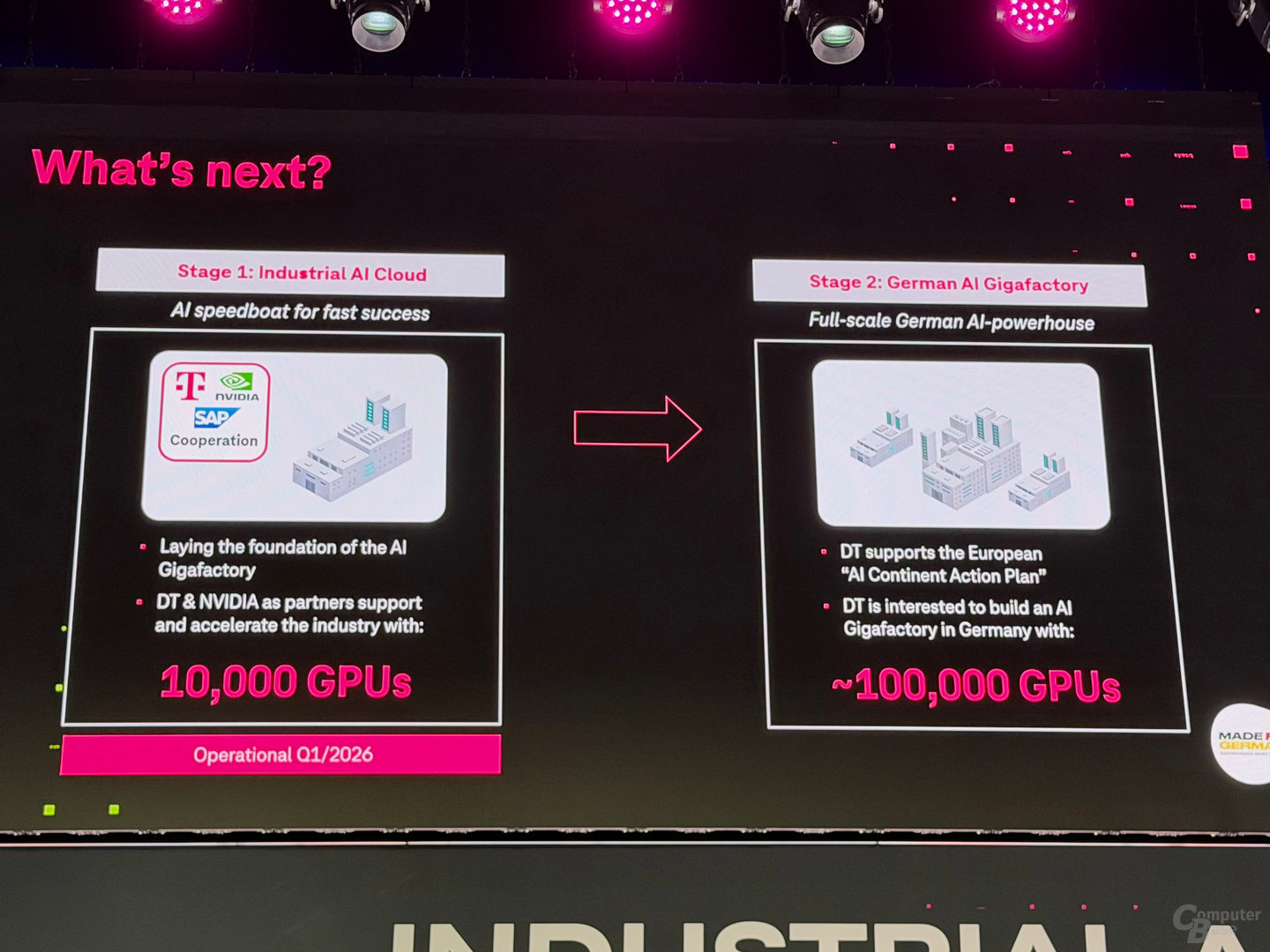

Stage 2 folgt mit 100.000 GPUs

Das Datacenter bei München bezeichnet die Deutsche Telekom als „Stage 1“ Perspektivisch soll im Rahmen der „Stage 2“ und des europäischen „AI Continent Action Plan“ eine „German AI Gigafactory“ mit 100.000 GPUs entstehen. Neben der Deutschen Telekom, Nvidia und SAP werde dafür ein Infrastrukturpartner ins Boot geholt, sagte Höttges. Konkrete Details zur deutschen Gigafactory waren heute allerdings noch kein Thema.

Apps & Mobile Entwicklung

Nativ vs. DLSS 4.5 vs. FSR AI im Leser-Blindtest

Nativ UHD, DLSS 4.5 oder FSR Upscaling AI? Upsampling oder kein Upsampling? Was findet ihr am schönsten? Wir finden es heraus! Eine Woche lang habt ihr Zeit, in sechs verschiedenen Spielen euren Favoriten zu wählen. Als Basis dienen qualitativ YouTube weit überlegene Side-by-Side-Videos.

Nativ vs. DLSS 4.5 und FSR Upscaling AI im Leser-Blindtest

ComputerBase hat sich in den letzten Wochen intensiv mit dem Thema Upsampling beschäftigt. Der etwas überraschende Start von DLSS 4.5 (Test) war der Grund dafür, Nvidia hat mit der neuen Version die Qualität erneut sichtbar verbessern können. Mehrere Analysen hat die Redaktion dann durchgeführt, in denen DLSS 4.5, DLSS 4, FSR Upscaling AI und „Nativ“ die Hauptrolle gespielt haben und die Redaktion hat das Ergebnis bewertet.

Der Upsampling-Blindtest ist da!

Jetzt wird der Spieß umgedreht: Nicht der Redakteur bewertet das Upsampling, sondern die Leser. Damit das funktioniert, hat die Redaktion einen Blindtest erstellt, der sich in sechs verschiedenen Spielen auf DLSS 4.5 sowie FSR Upscaling AI und damit auf die neuesten Upsampling-Varianten von Nvidia und AMD konzentriert. Als Auflösung hat die Redaktion Ultra HD ausgesucht, als Qualitätsstufe sich für „Quality“ entschieden. Als Dritter im Bunde nimmt „Nativ“ in Form der nativen Auflösung, also Ultra HD, mitsamt dem spieleigenen TAA teil.

- Sechs Spiele

- Ultra HD als Ausgabe-Auflösung

- DLSS 4.5 und FSR Upscaling AI (FSR 4): Quality

- Nativ: Ohne Upsampling, aber mit TAA

So vergleichbar wie möglich!

Jedes Spiel kommt dabei mit einer eigenen Testsequenz daher, die die Community bewerten kann. Alle Videos wurden in Ultra HD mit 60 FPS aufgenommen. Es kam eine externe Capture-Karte zum Einsatz. Das Ergebnis ist also nicht vom Encoder der verwendeten Grafikkarte abhängig. Als Videocodec wurde NVENC AV1 mit einer Bitrate von 60 Mbps ausgewählt.

Als Player setzt die Redaktion wie gewohnt auf Nvidias ICAT-Player. Dieser macht nichts anderes als die Videos abzuspielen – die Videos wurden weder vorab von der Redaktion noch vom ICAT-Player in irgendeiner Form bearbeitet.

Darum kein YouTube

Warum kein YouTube? Das hat verschiedene Gründe. Einer davon ist, dass der ICAT-Player vom Benutzer konfiguriert werden kann. Die Abspielgeschwindigkeit und der Bildausschnitt können geändert, zudem kann in das Video hinein- oder hinausgezoomt werden. Dafür einfach die linke Maustaste drücken und den Ausschnitt verschieben oder am Mausrad drehen.

Der Hauptgrund ist aber ein anderer: YouTube komprimiert sämtliche Videos sehr stark, was die Bildqualität auch im besten Fall negativ beeinflusst. So ist es nur schwer bis gar nicht möglich, die Bildqualität bestmöglich zu beurteilen. Das bedeutet auch, dass das Video doppelt komprimiert wird. Bei der Videoerstellung, was sich aber kontrollieren lässt. Und eben von YouTube selbst, worauf man aber keinerlei Einfluss hat.

Ein paar Worte zu ICAT

Bei ICAT findet dagegen nur eine Komprimierung bei der Videoerstellung statt, der Player selbst spielt die Videos dann 1:1 ab – völlig unbearbeitet. Das hat aber auch einen Nachteil: Anstatt eines 4K60-Streams müssen bei ICAT in diesem Test drei 4K60-Streams gleichzeitig abgespielt werden, was auch die Videoeinheiten der modernsten Grafikkarten ans Limit bringt. Ältere Grafikkarten werden die Videos eventuell nicht flüssig wiedergeben können.

Und mehr als eine ICAT-Datei zur selben Zeit lassen sich vermutlich nicht öffnen. Hier hilft es nur, ein ICAT-Video über den Schalter „Videovergleich öffnen“ zu öffnen, das Video zu analysieren und die Browserseite mit dem geöffneten Video wieder zu schließen beziehungsweise zur nächsten Artikelseite zu wechseln. Das mag umständlich erscheinen, doch anders sind die Einflüsse auf die Bildqualität zu groß.

So funktioniert der Leser-Blindtest

Jedes einzelne Video ist gleich aufgebaut: Das Video ist in drei gleich große Bildbereiche aufgeteilt, die das jeweilige Spiel mit DLSS 4.5 Quality, mit FSR Upscaling AI Quality und mit der nativen Auflösung inklusive der spieleigenen TAA-Kantenglättung zeigen.

Damit unklar bleibt, welcher Teil des Videos welche Technik benutzt, hören die Videos schlicht auf die Namen „1“, „2“ und „3“. Der ICAT-Player blendet die Namen direkt unter den jeweiligen Videos ein, dort können die Videos mit einem Mausklick aber auch verschoben werden. Standardmäßig ist das Video „1“ auf der linken Seite, Video „2“ in der Mitte und Video „3“ rechts. Die drei Technologien werden immer mal wieder vertauscht. Wer zum Beispiel immer Video „1“ auswählt, bekommt nicht immer dieselbe Technologie.

Unter jedem Video gibt es dann eine Umfrage, an der eine Woche lang teilgenommen werden kann. Als Antwortmöglichkeit stehen „1“, „2“, „3“ oder „Ich finde alle Videos gleich gut“ zur Verfügung. Einmal abgegebene Antworten können im Nachhinein nicht mehr geändert werden.

Nach einer Woche wird ComputerBase die Antworten dann zuordnen und auswerten. Daraufhin wird ein weiterer Artikel erscheinen, der die Ergebnisse analysiert. Wir sind gespannt!

Apps & Mobile Entwicklung

Amazon verkauft beliebte Logitech MX Keys Mini Tastatur mit 20 Prozent Rabatt

Die Logitech MX Keys Mini ist aktuell für kurze Zeit zu einem ziemlich günstigen Preis bei Amazon erhältlich. Wer schon länger mit dem Gedanken spielt, sein Setup aufzuwerten, sollte sich dieses Angebot also nicht entgehen lassen.

Logitech steht für Qualität – und genau deshalb sind die Produkte des Herstellers normalerweise alles andere als Schnäppchen. Gelegentlich tauchen jedoch echte Angebote auf, wie das aktuelle zur MX Keys Mini. Für unter 60 Euro kommt Ihr jetzt an die beliebte Tastatur, wir schauen genauer hin.

MX Keys Mini: Darum ist die Tastatur so beliebt

Die MX Keys-Reihe zählt zweifelsohne zu den beliebtesten Tastaturen für Büroarbeit. Dafür gibt es mehrere Gründe. Einerseits dürfte das minimalistische Design viele Menschen ansprechen. Vor allem die Mini-Serie, ohne NUM-Pad, nimmt kaum Platz weg und nutzt zudem keine unnötigen Bedienelemente. Die leicht eingewölbten Tasten ermöglichen einen flüssigeren Schreibübergang und die Switches können ohne großen Druck bedient werden, was die Gelenke schont.

Eine „Diktierfunktion“ gibt es ebenfalls, mit der Ihr verschiedene Eingaben automatisieren könnt. Da es sich hierbei um ein spezielles Modell für Apple-Geräte handelt, habt Ihr die Möglichkeit, die Tastatur mit mehreren Mac-Computern oder iPads gleichzeitig zu verbinden. Allerdings eignet sie sich auch prima für Windows etc. Ein weiterer Grund für die Beliebtheit ist zudem die Ausdauer der Bluetooth-Tastatur. Denn bis zu 10 Tage Laufzeit bei eingeschalteter Hintergrundbeleuchtung verspricht Logitech. Schaltet Ihr diese aus, sind es sogar bis zu 5 Monate.

Darauf solltet Ihr vor dem Kauf unbedingt achten

Amazon verhökert die Funk-Tastatur gerade für nur 59,99 Euro statt 74,90 Euro. Der Versandriese bietet Euch damit den aktuellen Bestpreis an, Ihr bekommt die Tastatur also aktuell nirgendwo günstiger.

Was haltet Ihr von dem Angebot? Ist die Logitech-Tastatur zu diesem Preis interessant für Euch? Wünscht Ihr Euch mehr solcher Deals? Lasst es uns wissen!

Mit diesem Symbol kennzeichnen wir Partner-Links. Wenn du so einen Link oder Button anklickst oder darüber einkaufst, erhalten wir eine kleine Vergütung vom jeweiligen Website-Betreiber. Auf den Preis eines Kaufs hat das keine Auswirkung. Du hilfst uns aber, nextpit weiterhin kostenlos anbieten zu können. Vielen Dank!

Apps & Mobile Entwicklung

Oryon-CPU-Architekt: Gerard Williams und John Bruno verlassen Qualcomm

Knapp fünf Jahre nach der Übernahme von Nuvia durch Qualcomm verlässt CPU-Chefarchitekt Gerard Williams das Unternehmen. Zu seinen Entwicklungen gehören drei Generationen Oryon-Kerne, die Qualcomms aktuelle Snapdragon-Prozessoren für Notebooks und Smartphones antreiben. Zuvor war er bei Apple und Arm angestellt.

Zu den letzten öffentlich bekannten Entwicklungen von Gerard Williams und dem CPU-Team von Qualcomm gehören die Oryon-CPU-Kerne des Snapdragon X Elite (1. Generation), Snapdragon 8 Elite (2. Generation) sowie Snapdragon X2 Elite (Extreme) und Snapdragon 8 Elite Gen 5 (3. Generation). Die neue CPU sorgte dafür, dass Qualcomm sich von den Mikroarchitekturen von Arm abkoppeln und einen deutlich leistungsfähigeren, aber zugleich effizienten Prozessor auf die Beine stellen konnte.

Oryon war zuvor das Phoenix-CPU-Design

Was bei Qualcomm derzeit Oryon genannt wird, war vorher das Phoenix-CPU-Design von Nuvia, das für einen stromsparenden, schnellen Arm-Server-Prozessor zum Einsatz kommen sollte. Williams hatte Nuvia im Frühjahr 2019 gemeinsam mit John Bruno (Google, Apple, AMD, ATi) und Manu Gulati (Broadcom, Apple, Google) gegründet. Noch bevor das geplante Produkt auf den Markt kommen konnte, erfolgte Anfang Januar 2021 die Übernahme durch Qualcomm für 1,4 Milliarden US-Dollar.

Williams war vorher bei Apple und Arm

Das Trio und vor allem Williams ist insbesondere für die Zeit bei Apple bekannt. Williams war für 9 Jahre Senior Director in Platform Architecture und damit Chefarchitekt aller CPU- und SoC-Entwicklungen ab dem Apple A7, dem ersten 64-Bit-Arm-Prozessor für Smartphones. Er leitete die Entwicklungen aller CPU-Kerne wie Cyclone, Typhoon, Twister, Hurricane, Monsoon, Vortex, Lightning und Firestorm. Williams war auch für die Mac-Plattformen M1 Pro, M1 Max und M1 Ultra verantwortlich.

Vor Apple war Williams für über 12 Jahre bei Arm angestellt und hatte es dort zum erlesenen Kreis eines sogenannten Fellow geschafft, der im Regelfall höchsten Engineering-Position und Ehrung in US-Tech-Unternehmen. Bei Arm hatte Williams unter anderem den Cortex-A8 (Tiger) und Cortex-A15 (Eagle) entwickelt. Vor Arm war Williams Design Team Lead bei Texas Instruments und Praktikant bei Intel.

Auch John Bruno hat Qualcomm verlassen

Neben Williams ist zu Ende Januar offiziell auch Nuvia-Mitgründer John Bruno bei Qualcomm ausgeschieden. Der weitere Mitgründer Manu Gulati ist seinem Linked-In-Profil zufolge weiterhin als VP of Engineering bei Qualcomm angestellt.

Direkt ins nächst Chip-Abenteuer will sich Williams allerdings nicht stürzen. In einem Linked-In-Beitrag gibt er an, jetzt erst einmal Zeit mit der Familie verbringen, sein Haus neu streichen und sich dann einer langen Liste von Dingen widmen zu wollen.

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Künstliche Intelligenzvor 1 Monat

Künstliche Intelligenzvor 1 MonatSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenHuawei Mate 80 Pro Max: Tandem-OLED mit 8.000 cd/m² für das Flaggschiff-Smartphone

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFast 5 GB pro mm²: Sandisk und Kioxia kommen mit höchster Bitdichte zum ISSCC

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenSyncthing‑Fork unter fremder Kontrolle? Community schluckt das nicht

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenWeiter billig Tanken und Heizen: Koalition will CO₂-Preis für 2027 nicht erhöhen