Online Marketing & SEO

SAM 3 von Meta revolutioniert Bild- und Videobearbeitung mit KI

Mit SAM 3 können User jetzt Objekte in Bildern und Videos noch zielsicherer in Echtzeit segmentieren. Das Modell kommt für Meta AI, Facebook Marketplace und auch in die Edits App.

UPDATE

Nachdem Meta im Juli 2024 das Segment Anything Model 2 (SAM 2) herausgebracht hat, launcht das Unternehmen nun die Nachfolgeversionen SAM 3 und SAM 3D. Die Segment Anything Models sind über einen Open-Source-Software-Lizenzvertrag für alle nutzbar und sollen laut Meta „die fortschrittlichste KI, um Bilder und Videos zu erkennen, zu bearbeiten und mit diesen zu experimentieren“ sein.

Mit SAM 3 kannst du unter anderem folgende Aktionen ausführen:

- Elemente aus Bildern oder Videos isolieren

- Ausgewählte Bereiche in flexibel bearbeitbare Elemente umwandeln

- Effekte wie Weichzeichnen oder Klonen nutzen

- Wiederverwendbare Vorlagen erstellen, speichern, herunterladen und teilen

Die Modelle sollen bald im Rahmen verschiedener Features im Facebook Marketplace, der Edits App sowie Meta AI verfügbar sein.

Dieser Beitrag erschien erstmals am 31. Juli 2024.

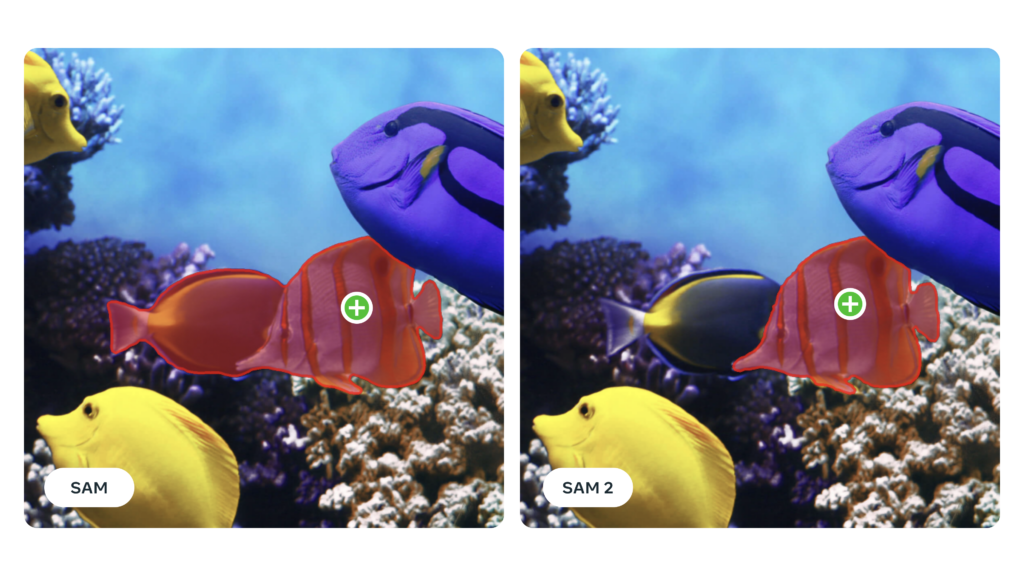

Nach dem erfolgreichen Launch des Segment Anything Models (SAM) im Jahr 2023 legt Meta mit SAM 2 nach. Das Modell ist über Apache 2.0 – einen Open-Source-Software-Lizenzvertrag – für alle nutzbar. SAM 2 erlaubt in Echtzeit die Objektsegmentierung in Bildern und auch in Videos und lässt sich auch mit Prompts steuern. Das Modell lässt sich für verschiedene Zwecke einsetzen, von der simplen Objektbearbeitung über die KI-gesteuerte Generierung neuer Bildeffekte bis hin zur Optimierung von Computer Vision dank vereinfachter Annotation.

Introducing Meta Segment Anything Model 2 (SAM 2) — the first unified model for real-time, promptable object segmentation in images & videos.

SAM 2 is available today under Apache 2.0 so that anyone can use it to build their own experiences

Details ➡️ pic.twitter.com/mOFiF1kZfE

— AI at Meta (@AIatMeta) July 29, 2024

SAM 2 und SA-V im Überblick: Meta vereinfacht Visual-Bearbeitung

Auf dem eigenen Blog erklärt Meta, was die neue Generation des Segement Anything Models zu bieten hat. Vor allem die erhöhte Präzision bei der Obejktmarkierung in Bildern sowie Videos sticht demnach heraus.

Insbesondere die Anwendungsmöglichkeiten im Bewegtbildbereich wollte Meta optimieren:

SAM was able to learn a general notion of what objects are in images. However, images are only a static snapshot of the dynamic real world in which visual segments can exhibit complex motion. Many important real-world use cases require accurate object segmentation in video data, for example in mixed reality, robotics, autonomous vehicles, and video editing. We believe that a universal segmentation model should be applicable to both images and video […].

Parallel zu SAM 2 hat Meta das Datenset SA-V mit über 51.000 Real-World-Videos gelauncht. Dieses ist über die CC BY 4.0-Lizenz verfügbar und bietet rund 53 Mal mehr Annotationen als das bisher größte Videodatenset für die Objektmarkierung.