Künstliche Intelligenz

Studie: Potenziell gefährliche KI-generierte Proteine werden nicht immer erkannt

Die Fähigkeit, mithilfe künstlicher Intelligenz neue Proteine zu entwerfen, gilt als eine der faszinierendsten und zugleich riskantesten Entwicklungen in den modernen Biowissenschaften. Die Technologie eröffnet völlig neue Möglichkeiten für Medizin, Materialforschung und nachhaltige Produktion – doch sie wirft auch Fragen zur Biosicherheit auf. Abhilfe soll verbesserte Erkennungssoftware schaffen.

Eine in der Fachzeitschrift Science veröffentlichte Studie von Wittmann et al. zeigt, dass KI-Systeme zur Proteindesign-Generierung tatsächlich in der Lage sind, Varianten gefährlicher Proteine zu produzieren, die kommerzielle Biosicherheits-Screening-Systeme teilweise nicht erkennen.

Diese Firmen sind eine kritische Kontrollinstanz, um den Missbrauch der Technologie, etwa zur Herstellung von Biowaffen, zu verhindern. Die Studie soll als Stresstest für die aktuellen Sicherheitsmechanismen dienen und deren Grenzen hinsichtlich generativer KI aufzeigen.

KI-generierte Proteine gegen kommerzielle Scanner

Für die Untersuchung nutzten die Forschenden eine Open-Source-KI, um über 75.000 Varianten von bekannten gefährlichen Proteinen zu erstellen. Diese legten sie vier verschiedenen kommerziellen Biosicherheits-Screening-Systemen (BSS) zur Prüfung vor. Das Ergebnis war eindeutig: Während die Systeme die Original-Sequenzen der Proteine zuverlässig erkannten, war die Erkennungsrate bei den KI-generierten Varianten, die eine ähnliche Funktion bei abweichender Sequenz aufwiesen, unzuverlässig.

In Zusammenarbeit mit den BSS-Anbietern entwickelten die Autoren daraufhin Software-Updates, welche die Erkennung signifikant verbesserten. Eine hundertprozentige Detektion aller potenziell gefährlichen Varianten konnte jedoch auch damit nicht erreicht werden.

Die Reaktion anderer Wissenschaftler fällt differenziert aus. „Das Risiko ist mit der neuen KI-basierten Technologie sehr stark gestiegen“, kommentiert Prof. Dr. Gunnar Schröder vom Forschungszentrum Jülich. Die Technologie sei nun einer weitaus größeren Gruppe von Wissenschaftlern zugänglich als noch vor wenigen Jahren. Prof. Dr. Jens Meiler von der Vanderbilt University kritisiert die Darstellung der Studie: „Die Studie ist in der Hinsicht problematisch, weil sie suggeriert, dass sich die Wissenschaft noch nicht mit der Thematik beschäftigt hätte – das machen wir aber seit zwei bis drei Jahren.“

Er verweist auf bestehende Initiativen wie die Leitlinie zum verantwortungsvollen Umgang mit KI im Biodesign. Diese Einschätzung teilt Jun.-Prof. Clara Schoeder von der Universität Leipzig, die zudem methodische Schwächen der Studie anführt. So sei die Gefährlichkeit der Proteine lediglich computerbasiert („in silico“) vorhergesagt und nicht im Labor validiert worden. Zudem sei für die gezielte Erzeugung gefährlicher Proteine weiterhin hohe Expertise und böswillige Absicht notwendig.

Technisches Wettrüsten und ethische Leitplanken

Die Debatte dreht sich vor allem um die adäquaten Gegenmaßnahmen. Die Studie selbst zeigt mit den entwickelten Software-Patches einen technischen Lösungsansatz, der jedoch an das von Prof. Dr. Birte Platow (TU Dresden) beschriebene „Hase-und-Igel-Rennen“ erinnert: Ein ständiger Wettlauf zwischen offensiven und defensiven Technologien.

Darüber hinaus werden regulatorische und ethische Ansätze gefordert. Prof. Dr. Dirk Lanzerath vom Deutschen Referenzzentrum für Ethik in den Biowissenschaften betont die Notwendigkeit verbindlicher Policies und des „Ethics by Design“-Prinzips, bei dem ethische Reflexionen bereits in die Entwicklung integriert werden. Angesichts der globalen Risiken sei ein internationaler Austausch über Standards unverzichtbar.

Gleichzeitig warnt Clara Schoeder vor den negativen Folgen einer zu strikten Regulierung. Diese könnte die legitime Forschung, etwa zur Entwicklung von Impfstoffen auf Basis viraler Sequenzen, durch langwierige Genehmigungsprozesse behindern. Die wissenschaftliche Community setzt daher auch auf Selbstverpflichtung und soziale Kontrolle, wie Birte Platow hervorhebt.

(mack)

Künstliche Intelligenz

Microsoft will KI-Agenten smarter machen und mit Agent 365 besser überwachen

Microsoft hat mehrere neue Produkte und Funktionen Künstlicher Intelligenz (KI) angekündigt. So soll der erweiterte Zugriff auf Unternehmensdaten KI-Agenten intelligenter machen, sodass diese Menschen besser unterstützen können (sollen). Microsofts „Agent Factory“ soll die Erstellung eigener KI-Agenten vereinfachen, während „Agent 365“ zur Verwaltung und Kontrolle dieser KI-Agenten dient. Diese Steuerungsebene soll den sicheren Einsatz der KI-Agenten gewährleisten.

Weiterlesen nach der Anzeige

Diese und andere Ankündigungen erfolgten im Rahmen der Hausmesse „Ignite 2025“, wo Microsoft nicht müde wird zu betonen, dass KI zur Unterstützung von Menschen und Mitarbeitern dient. Nach Ansicht des Konzerns werden moderne Unternehmen künftig „von Menschen geführt und von Agenten betrieben“. Das hat Microsoft teilweise auch bereits selbst umgesetzt, denn im Juli dieses Jahres erklärte ein hochrangiger Manager des Konzerns, dass Microsoft 500 Millionen Dollar durch KI einspart. Denn dafür mussten 15.000 Mitarbeiter gehen.

Höherer IQ für KI durch mehr Datenzugriff

Diesen Weg ebnet Microsoft auch anderen Unternehmen durch eigene KI-Agenten. Zur Verbesserung dieser KI gehört Work IQ, das durch Zugriff auf Unternehmensdaten, Speicher und KI-Abfragen Wissen anhäuft. Auf Basis von E-Mails, Dateien, Meetings und Chats kann Copilot damit „Zusammenhänge erkennen, neue Erkenntnisse gewinnen und die nächsten sinnvollen Schritte vorschlagen“, schreibt Microsoft. Dazu kommen Fabric IQ, ein Modell auf Basis von Analyse-, Zeitreihen- und standortbasierten Daten, sowie Foundry IQ, ein „voll gemanagtes Wissenssystem“ aus mehreren Datenquellen für KI-Agenten.

Darauf aufbauend lassen sich mit Microsofts „Agent Factory“ individuelle KI-Agenten entwickeln, die dann per Microsoft 365 Copilot zur Verfügung stehen. Verwaltet und überwacht werden diese KI-Agenten mit „Agent 365“. Der Konzern vergleicht dies mit dem Management von Mitarbeitern, denn die KI-Agenten werden „mit vielen derselben Apps und Schutzmaßnahmen wie Menschen“ ausgestattet, aber eben auf KI-Bedürfnisse zugeschnitten. Dadurch sollen KI-Agenten schneller und einfacher in Geschäftsprozesse integriert werden können.

Microsoft: KI-Agenten sind die Zukunft

Denn an KI-Agenten kommen moderne Unternehmen nach Ansicht Microsofts nicht vorbei. Sie würden Aufgaben automatisieren, mit Menschen zusammenarbeiten und die Produktivität beschleunigen. Der Konzern verweist dabei auf die Prognose der Marktforscher von IDC, nach der es bis 2028 bereits 1,3 Milliarden KI-Agenten geben wird. Diese IDC-Untersuchung aus dem Mai 2025 wurde allerdings von Microsoft gesponsert, wie der Konzern per Fußnote zugibt.

Weiterlesen nach der Anzeige

Lesen Sie auch

Agent 365 wird im Admin-Zentrum von Microsoft 365 zur Verfügung stehen. Derzeit ist es aber nur über das Frontier-Programm verfügbar, in dem Anwender einen Vorabzugriff auf Funktionen erhalten, die sich noch in der Entwicklung befinden. Damit können IT-Administratoren die Erstellung, die Verwaltung und die Anwendung neuer KI-Agenten in verschiedenen Szenarien zunächst testen.

(fds)

Künstliche Intelligenz

Google bringt Gemini 3 und Agenten-Plattform raus

Weiterlesen nach der Anzeige

Gemini 3 ist auf allen Ebenen besser als der Vorgänger, Gemini 2.5 – das sagt Google und beruft sich dabei auch auf die Ergebnisse in der LM Arena, in der KI-Modelle gegeneinander antreten. Die neue Version wird ab sofort für Verbraucher, Entwickler und Unternehmen verfügbar gemacht. Zudem bietet Google künftig mit Antigravity eine Plattform an, über die KI-Agenten erstellt und betreut werden können.

Mit Gemini 3 soll jeder jede Idee zum Leben erwecken können. Das Modell sei besonders gut im Reasoning, also im Nachdenkprozess, sowie im Vibe Coding – so nennt sich Programmieren, wenn die Anweisungen in natürlicher Sprache von KI ausgeführt werden. Außerdem soll Gemini 3 den Kontext und die Absicht einer Anfrage besser verstehen. In einem Blogbeitrag schreibt Google-CEO Sundar Pichai, es sei aufregend, wie KI nicht mehr nur Text und Bilder lesen kann, sondern inzwischen auch den Raum versteht. Was Google nicht erklärt und auch auf Nachfrage schmallippig antwortet: Wie genau das Modell denn verbessert worden ist. Gibt es eine neue Architektur, andere Trainingsdaten oder wurden mehr Daten genutzt? Es habe überall Verbesserungen gegeben, heißt es in einem Gespräch.

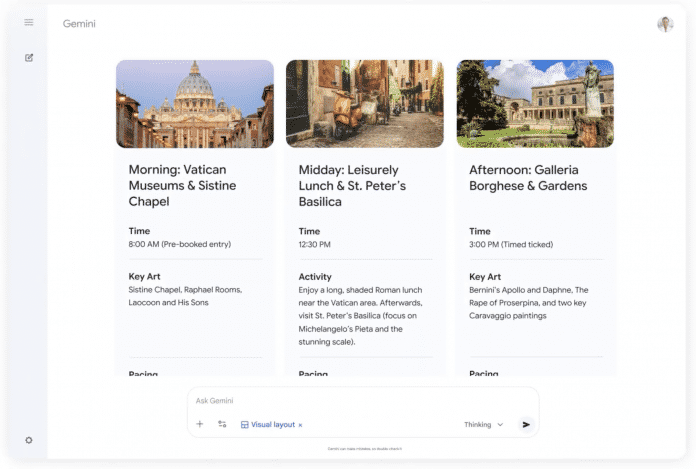

Gemini App: Antworten im Magazin-Style

Nun zieht Gemini 3 in die Gemini App. Der zuständige Google-VP, Josh Woodward, sagt, jeder würde sofort merken können, wie viel hilfreicher Gemini mit dem Update geworden ist. Er zeigt in einer Pressevorführung, wie Gemini den Output neu sortieren kann. Der gesamte Look ist überarbeitet worden. Als Beispiel muss natürlich – wie bei fast jeder KI-Präsentation – das Thema Reiseplanung herhalten. Die App liefert Informationen fast im Stil eines Hochglanz-Magazins. Woodward zeigt auch ein Storytelling über Vincent Van Gogh – ebenfalls bunt, dynamisch und schick. Freilich bleibt immer die Frage, ob alle Informationen richtig sind, ob es Halluzinationen gibt und woher die Informationen stammen. KI ist nach wie vor auch bei Google ein Experiment.

(Bild: Google)

So kommt es denn auch, dass Gemini 3 Deep Think, ein auf Reasoning spezialisiertes Modell, zunächst noch von Sicherheitsforschern getestet wird und nur für Google AI Ultra Abonnenten verfügbar ist.

Laut Googles Deepmind-CEO Demis Hassabis, schlägt Gemini 3 Pro alle anderen Modelle in der LM Arena – mit 1501 Punkten in der Bestenliste. In Humane`s Last Exam schafft es beispielsweise 37,5 Prozent (Gemini 2.5 Pro hat 21,6 Prozent richtig beantwortet). Gemini 3 Deep Think erreicht sogar 41 Prozent.

Weiterlesen nach der Anzeige

AI Mode setzt auf Gemini 3

Auch die Suche baut künftig auf Gemini 3 auf – gemeint ist damit der AI Mode. Für Google AI Pro und Ultra Abonnenten zunächst in den USA gibt es sogar noch eine Erweiterung namens Thinking, in der Gemini 3 Pro genutzt wird. Google spricht davon, dass der KI-Modus ein neues, generatives User-Interface erhält. Gemeint ist, dass sich etwa ganze Passagen in die Promptbar verschieben lassen, sowie interaktive Layouts und Simulationen, die das KI-Modell erstellt. Dafür greift Gemini auch auf die eigenen agentischen Fähigkeiten zurück.

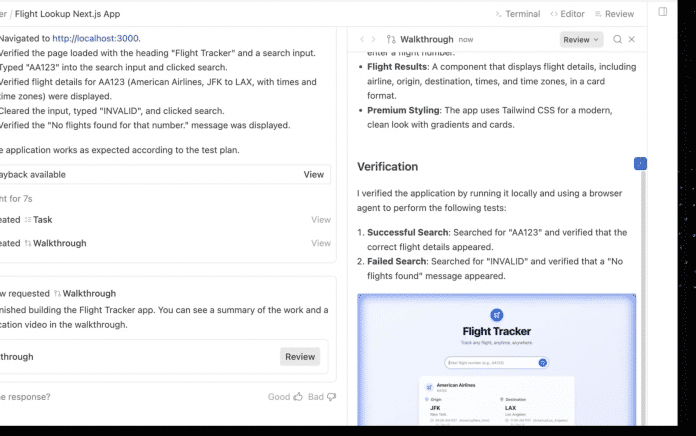

Um KI-Agenten zu erstellen und zu verwalten, gibt es nun eine neue Plattform: Google Antigravity. Sie richtet sich an Entwickler. Es geht also nicht um einen Agenten, der aus dem Chat heraus mal eben ein Paar Socken für den Nutzer kauft, wie es beispielsweise der ChatGPT Agent machen soll. Grundsätzlich handelt es sich um eine integrierte Entwickler-Umgebung (IDE). Die Agenten haben dabei Zugang zum Editor, Terminal und Browser. In Antigravity ist auch Gemini 2.5 Computer Use integriert. Das ist der KI-Agent, der den Browser bedienen kann und dafür auf Screenshots zurückgreift. Auch Nano Banana steckt als Bildgenerator in der Plattform.

Antigravity

(Bild: Google)

Entwickler haben auf Gemini 3 Zugriff via API in AI Studio, Antigravity und Gemini CLI. Für Unternehmen steht Gemini 3 via Vertex AI und Gemini Enterprise zur Verfügung.

Bei all dem soll Gemini 3 das bisher sicherste Modell von Google sein. Es sei beispielsweise weniger anfällig für Prompt Injections oder den Missbrauch für Cyberangriffe.

(emw)

Künstliche Intelligenz

Grok 4.1 soll emotionaler, kreativer und faktentreuer sein

Das Large Language Model Grok soll nach einem Update auf Version 4.1 mehr emotionales Einfühlungsvermögen mitbringen, kreativer, faktentreuer und schneller sein. Das verspricht zumindest Entwickler xAI und verweist auf Benchmarks wie LMArena, laut denen das KI-Modell besser als bekannte Mitbewerber wie GPT 5 von OpenAI oder Claude Sonnet 4.5 von Anthropic abschneidet. Bemerkenswert ist dabei, dass sich das schnellere Modell ohne Reasoning-Schritt ebenfalls vor anderen Modellen mit Reasoning platzieren konnte.

Weiterlesen nach der Anzeige

Grok 4.1 soll weniger oft Unsinn erzählen, sich im Gespräch angenehmer anfühlen, kreativer schreiben und schneller antworten. Laut xAI wurde das Modell in Blindtests von Nutzern gegenüber Grok 4 bevorzugt. In rund 65 Prozent der Fälle fanden sie demnach die neue Version besser.

Weniger Halluzinationen

xAI verspricht auch eine höhere Faktentreue. Das Non-Reasoning-Modell halluzinierte nur noch in 4,2 statt 12 Prozent der Fälle. Der Entwickler selbst spricht von „erheblichen Verbesserungen für die praktische Anwendbarkeit von Grok“. Das Modell ist in den USA zum Beispiel in Tesla-Fahrzeugen als Assistent integriert. Für das Training habe man auf die gleiche Infrastruktur zurückgegriffen, die auch bei Grok 4 im Einsatz war. Dieses Mal hätten jedoch die Optimierung des Stils, der Persönlichkeit und Hilfsbereitschaft sowie die Ausrichtung des Modells im Fokus gestanden.

Im LMArena-Test nahm das Thinking-Modell Platz 1 ein, was einen bedeutenden Sprung nach vorn darstellt, da Grok 4 dort noch auf Platz 33 stand. Die emotionale Intelligenz wurde mit EQ-Bench gemessen. Auch hier konnte sich Grok von Version 4 (1206 Punkte) auf Version 4.1 (1586 Punkte) deutlich verbessern. Beim kreativen Schreiben platzierte sich Grok 4.1 hinter der Preview-Version von GPT 5.1. Offenbar ist das Modell aber recht empfänglich für manipulative Prompts. Laut der Model Card habe Grok 4.1 im MakeMeSay-Test schlecht abgeschnitten. Allerdings sehen die Entwickler hierin kein großes Risiko.

Ab sofort verfügbar

Grok 4.1 ist in den Varianten Thinking (Codename quasarflux) und Non-Thinking (Codename tensor) ab sofort verfügbar auf grok.com, im Kurznachrichtendienst X sowie in den iOS- und Android-Apps. Es kann kostenlos von allen Nutzern verwendet werden und ist automatisch vorausgewählt. Zahlende Nutzer haben weniger Limits.

Weiterlesen nach der Anzeige

(mki)

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenAdobe Firefly Boards › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenHarte Zeiten für den demokratischen Rechtsstaat

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 Monaten„Buongiorno Brad“: Warum Brad Pitt für seinen Werbejob bei De’Longhi Italienisch büffeln muss