Online Marketing & SEO

Warum Du eine llms.txt für Deine Inhalte brauchst!

Wenn Du im Online Marketing tätig bist, kennst Du mit großer Wahrscheinlichkeit den Begriff robots.txt. Diese Datei steuert, welche (Suchmaschinen)-Bots auf welche Bereiche Deiner Seite Zugriff erhalten und sie crawlen dürfen. Die robots.txt ist nicht zu verwechseln mit der llms.txt, die Sprachmodellen (LLMs) wie ChatGPT, Claude oder Gemini dabei hilft, Deine Inhalte besser zu verstehen – mit dem Crawling hat sie nichts zu tun! Ich erkläre Dir heute, wofür diellms.txt-Datei da ist, wie Du sie für Deine Webseite nutzen kannst und wie sinnvoll ihr Einsatz ist.

Definition & Erklärung llms.txt

Die llms.txt ist eine Textdatei im Markdown-Format, die Sprachmodellen (LLMs) dabei helfen soll, die Struktur und die Inhalte Deiner Webseite besser zu verstehen. Sie wird vom Webseitenbetreiber bereitgestellt und liegt im Root-Verzeichnis der Domain, z.B. www.deinewebseite.de/llms.txt.

Immer mehr KI-Systeme nutzen neben ihren Trainingsdaten auch das Web, um Ihre Modelle mit aktuellen Informationen zu füttern oder um Antworten direkt zu generieren. ChatGPT und Co. stoßen dabei auf Herausforderungen:

Die Webseiten sind primär für User erstellt, oft zu komplex und das Kontextfenster zu klein, um als LLM die meisten Webseiten in ihrer Gesamtheit vollständig zu verstehen. Die llms.txt wandelt diese komplexe Struktur, die zusätzlich zu den Inhalten weitere Bausteine wie Navigation, Werbung, JavaSkripte oder Bilder enthält, in LLM-freundlichen Klartext um, denn: LLMs bevorzugen prägnante, fachliche hochwertige Informationen ohne BlaBla.

Das bedeutet; Die llms.txt soll LLMs helfen,

- relevante Inhalte schneller zu finden.

- gezielter aus diesem Content Informationen zu extrahieren.

- effizienter bei der Websuche zu helfen.

So sollen Webseiten in den Antworten der Sprachmodelle sichtbarer werden.

Der Technologie-Experte Jeremy Howard hat einen Standard für llms.txt vorgeschlagen: https://llmstxt.org/. Zwar ist dieser Standard noch nicht verbindlich, ich empfehle Dir aber, Dich an diesen zu halten.

Aufbau der llms.txt:

Laut oben genanntem Standard von Jeremy Howard, soll eine llms.txt folgenden Aufbau aufweisen:

- Eine H1-Überschrift mit dem Namen der Seite oder des Projekts

- Optional: Ein Absatz mit einer kurzen Zusammenfassung des Projekts und den notwendigen Informationen, um den Rest des Dokuments zu verstehen

- Optional: Markdown-Abschnitte (z.B. Listen) mit weiteren Informationen zum Projekt, jedoch ohne weitere Überschriften

- Optional: Markdown-Abschnitte mit Überschriften (H2), die Dateilisten mit URLs enthalten, die wiederum weitere Informationen beinhalten. Hier sind weitere Anmerkungen zu den Dateien möglich. Der Aufbau ist wie folgt [{Name}]({URL}):{Beschreibung}

- Optional: Die „Optional“-Sektion: Dieser Bereich hat eine spezielle Bedeutung. Er kann von den LLMs übersprungen werden, wenn sie weniger Kontext benötigen. Das sind nur sekundäre Informationen.

Klingt kompliziert? Ein Beispiel macht es anschaulicher:

# Luisas Beispielprojekt > Luisas Beispielprojekt ist kein echtes Projekt. Es dient dazu, anhand eines Beispiels den Aufbau einer llms.txt zu veranschaulichen. Gegründet wurde dieses Projekt niemals. In diesem Abschnitt kannst Du weitere, optionale Details auflisten. Das Projekt enthält verschiedene Bereiche, die exemplarisch Inhalte und Funktionen bereitstellen. ## Shop - [Shop]( Verkauf von Beispielen aller Arten zu fairen Preisen für Endnutzer ## Ratgeber - [Ratgeberbereich]( Inhalte rund um Beispiele – wie man gute Beispiele erstellt und wann man sie benötigt. ## Unternehmen - [Über uns]( Unsere (fiktive) Unternehmensstory ## Dienstleistungen - [Beratung]( Beratungsdienstleistungen rund um Beispiele ## Optional - [Wie schreibe ich ein gutes Beispiel?]( Schritt-für-Schritt-Anleitung - [Wann braucht man Beispiele?]( Typische Szenarien und Anwendungsfälle - [Die 10 häufigsten Fehler bei Beispielen]( Tipps zur Vermeidung von Stolperfallen

Inspiration & Generatoren für llms.txt

Du möchtest Dich noch mehr inspirieren lassen? Dann schau unter hier findest Du Links zu verschiedenen llms.txt.

Tipp: Du kannst nach .de filtern und Dir verschiedene, deutsche llms.txt files ansehen.

Die meisten CM- und Shopsysteme bieten inzwischen entweder selbst einen Generator an oder es gibt ein Plugin dafür. Bei WordPress bietet zum Beispiel YOAST bereits in der Free-Version eine Möglichkeit. Hier kannst Du die Seiten entweder automatisch aussuchen lassen oder manuell auswählen. In meinen Tests wurden bei der automatischen Auswahl meistens Seitens ausgewählt, die ich nicht in der llms.txt favorisiere, von daher wählte ich manuell:

In den YOAST-Einstellungen wählst Du selbst, ob Du die Seiten manuell auswählen möchtest oder das Plugin dies automatisiert für Dich übernimmt.

Allerdings gibt es bei der manuellen Auswahl vordefinierte Bereiche, denen Du dann aus einer Dropdown-Liste die richtigen URLs zuordnen kannst:

- Über Uns

- Kontakt

- Nutzungsbedingungen

- Datenschutzerklärung

- Shop

Darunter gibt es die Möglichkeit weitere Inhaltsseiten Anhand ihres Titels auszuwählen:

Im YOAST-Konfigurationsbereich lassen sich Seiten anhand ihres Titels auswählen.

Allerdings kannst Du hier keinen individuellen Titel vergeben und keine Beschreibung hinzufügen.

Als weitere Möglichkeit gibt es noch Online-Generatoren für Deine llms.txt, zum Beispiel

Dort gibst Du Deine Domain ein, Deine Webseite wird (an)gecrawlt und es wird eine llms.txt erstellt. So hast Du schon einmal die Grundstruktur. Der Generator von Wordlift listet recht gut die URLs auf, gibt aber keine Beschreibung der URLs.

Writesonic finde ich persönlich besser, weil dieser Generator eine kurze Beschreibung der URLs einbaut, die gar nicht so schlecht ist. Allerdings sind diese Beschreibungen manchmal – nicht immer – auf Englisch. Hier musst Du auf jeden Fall kontrollieren und im Zweifel nachbessern.

So sieht beispielsweise eine llms.txt aus, die mit writesonic erstellt wurde.

Ich empfehle Dir, eines der Tools zu nutzen, damit Du die Basisstruktur hast. Dann solltest Du die Datei noch einmal selbst überarbeiten und im Anschluss manuell hochladen.

Llms.txt vs. llms-full.txt

Neben der llms.txt gibt es noch die llms-full.txt. Der Unterschied leitet sich bereits aus dem Namen ab:

- txt: Kompakte Übersicht der wichtigsten Seiten. Es ist eine Art Inhaltsverzeichnis.

- Llms-full.txt: Einzelnes Markdown-Dokument, in dem bereits der gesamte, reine Textinhalt Deiner Webseite zusammengefasst ist. Die llms-full ist also das „fertige Buch“.

Der Vorteil der llmsfull.txt liegt darin, dass das Einlesen der Informationen für die KI-Bots noch einfacher wird. Das bietet sich vor allem für API- oder Software-Dokumentationen an. Gibt man diese URL den LLMs als „Futter“, werden die Antworten deutlich präziser.

Unterschiede zwischen robots.txt, sitemap.xml und llms.txt

Anders als die robots.txt ist die llms.txt nicht für die Crawlingsteuerung zuständig, sondern soll als Brücke zwischen großen, komplexen Webseiten und den Sprachmodellen fungieren.

Vereinfacht gesagt: Die llms.txt soll den LLMs helfen, die Inhalte der Webseite besser zu verstehen.

Die robots.txt erlaubt oder verbietet bestimmten Crawlern den Besuch Deiner kompletten Webseite oder einzelner Bereiche. Mehr dazu kannst Du in unserem Blogpost zur robots.txt nachlesen.

Die llms.txt dagegen ist eine Möglichkeit LLMs kuratierte und LLM-freundliche Informationen bereitzustellen. Sie kann keine Bots blocken. Möchtest Du LLMs-Bots blocken, musst Du dafür die robots.txt verwenden. Die meisten der bekannten KI-Crawler (GPTBot, PerplexityBot, Google-Extended) beachten die robots.txt-Datei Deiner Webseite.

Die sitemap.xml ist eine XML-Datei, die alle indexierbaren URLs Deiner Webseite auflistet und Suchmaschinen-Bots dabei helfen soll, diese schneller zu crawlen und zu indexieren.

Die llms.txt hat eine ganz andere Funktion als die robots.txt. Letztere ist für das Crawling zuständig, während die llms.txt Informationen bereitstellt.

Kritikpunkte an der llms.txt

Die llms.txt ist aktuell noch experimentell und ihr Einsatz unter SEOs umstritten. Wie bei allem, gibt es Argumente für beide Seiten. Ich habe Dir hier die häufigsten Kritikpunkte aufgelistet – und meine Meinung dazu.

1. Nur sehr wenige Webseiten nutzen bisher eine llms.txt.

Ein häufig genannter Kritikpunkt ist, dass aktuell nicht einmal 0,005% aller Webseiten eine llms.txt nutzen. Diesen Punkt lasse ich für mich persönlich nicht gelten. Wenn wir hier jetzt von einem riesigen Programmieraufwand sprechen würden, wäre ich vollkommen bei den kritischen Stimmen und würde sagen: „Warte erstmal ab, ob sich das durchsetzt“. Aber nachdem Du je nach Seitengröße mit den diversen Tools für eine erste, einfache llms.txt nicht mal 15 Minuten brauchst, bin ich der Meinung: Probiere es einfach aus!

2. Es gibt keinen etablierten Standard.

Es gibt zwar einen Standard-Vorschlag, aber keinen etablierten Standard. Das heißt: Die llms.txt, die zu finden sind, unterscheiden sich im Aufbau. Niemand weiß, ob sich llms.txt durchsetzen werden und wenn ja, wie sie dann aussehen sollen. Es kann also sein, dass Du jetzt eine llms.txt erstellst, deren Aufbau künftig ganz anders sein soll. Hier gilt für mich das gleiche Argument wie beim vorherigen Punkt: Nachdem sich der Aufwand in Grenzen hält, ist auch eine spätere Adaption an einen Standard nicht dramatisch. Und: Die Etablierung von Standards dauert eben seine Zeit. Auch der Aufbau einer Sitemap oder der robots.txt geschah nicht über Nacht.

3. Große LLMs ignorieren die llms.txt.

Laut John Müller und Gary Illyes von Google, ignorieren die großen LLMs die llms.txt. John Müller vergleicht sie in einem reddit-Thread sogar mit dem schon lange überflüssigen Keyword-Meta-Tag. Seine Argumente:

Du willst keine unserer Beiträge mehr verpassen und auf dem Laufenden bleiben? Abonniere jetzt unseren Newsletter und erhalte jeden neuen Seokratie-Beitrag per E-Mail direkt in Dein Postfach!

Hier geht es zum Anmeldeformular.

- Die Informationen in der llms.txt sind zu leicht manipulierbar (das sind aber Webseiteninhalte auch…)

- Die Bots müssten dann sowieso die Webseite erneut crawlen, um die Informationen gegenzuprüfen (ja, aber so haben sie schon einmal einen Anhaltspunkt, wo sie starten können).

Außerdem crawlt zumindest der OAI-SearchBot von ChatGPT bei einigen Projekten die llms.txt.

Ganz interessant ist auch das Experiment von Ryan Howard.Er hat in seinen llms.txt-Generator für WordPress einen Zähler integriert, der Aufrufe durch verschiedene LLM-Bots von seinem Plugin erstellten llms.txt-Dateien trackt. Laut diesem rufen der GPTBot und der Claude-Bot die llms.txt am häufigsten auf. Im Vergleich zu den Installationen seines Plugins (über 20.000) erscheint mir die Zahl jedoch sehr gering (einige Hundert besuchte llms.txts. Auch wie technisch korrekt das Projekt aufgezogen ist, kann ich ehrlicherweise nicht beurteilen. Kein belegbarer SEO- & LLMO-Vorteil vorhanden.

Korrekt, es gibt bisher keinen Hinweis darauf, dass die llms.txt das Ranking in den Suchmaschinen oder LLMs verbessert. Allerdings wurde auch noch nicht das Gegenteil bewiesen. Und solange es kein zuverlässiges (!) Tracking für LLMs gibt, wird es mit der Beweislast schwer. Ich bin der Meinung: Es kann zumindest auch nicht schaden.

4. Die llms.txt muss gewartet werden.

Ich bin der Meinung, Du musst nicht gleich mit einer vollständigen llms-full.txt starten, sondern es reicht eine llms.txt mit Deinen wichtigsten URLs. Diese wichtigsten Inhalte werden sich vermutlich nicht allzu häufig ändern. Der Wartungsaufwand hält sich in Grenzen. Außerdem gibt es inzwischen einige automatisiert arbeitende Tools, für die llms-full.txt kann das hilfreich sein.

5. Die Antworten in den LLMs zeigen nicht auf die Quell-URL, sondern auf die llms.txt.

Lustigerweise haben die gleichen Leute, die sagen, dass die LLMs die llms.txt nicht nutzen, Angst, dass die Sprachmodelle statt auf die Quell-URL auf die llms.txt verweisen, was ein negatives Nutzererlebnis darstellt. Ich selbst habe noch keine Quell-URL gesehen, die auf die llms.txt oder eine .md-Datei (Eine Markdown-Variante des Inhalts) verweist. Die llms.txt fungiert mehr wie ein Wegweiser und soll – wie gesagt – dem Sprachmodell helfen, relevanten Content zu finden.

Fazit: Solltest Du eine llms.txt nutzen?

Ganz ehrlich: Ich finde es schadet nicht und ist mit einem geringen Aufwand verbunden.

Der Standard formt sich gerade, die Nutzung wird immer häufiger. Ich sehe es wie Carolyn Shelby: „Because when it comes to the future of AI search, the riches go to those who make their value easy to find.”

Übrigens hat Anthropic, der Entwickler von Claude, für seine Dokumentation sowohl eine llms.txt als auch eine llsm-full.txt: . Das ist für mich ein starkes Signal, wenn eines der führenden AI-Unternehmen daraufsetzt. Und auch Google hat in seinem Agent-to-Agent Protokoll auf Github eine llms.txt integriert:

Aber: Wie die Zukunft der llms.txt aussehen wird – das weiß im Moment nur die Glaskugel.

Bildquellen:

Titelbild: © RaCreative #1561584766 Adobe Stock

Bild 2 und 3: © Seokratie, Screenshots aus Yoast-Plugin

Bild 4: © Seokratie, Screenshot aus dem Tool Writesonic

Bild 5: © KI-generiert mit ChatGPT

Online Marketing & SEO

YouTube Shorts erhalten bald Links

Für YouTubes Kurzvideobereich Shorts gibt es große Updates: Brands können bald Links integrieren und Creator erhalten Drafts direkt aus der Camera Roll.

Du möchtest Videoideen ohne dein Zutun erhalten, die aber genau auf deine verfügbaren Visuals zugeschnitten sind? Und du möchtest auf Shorts auf deine Brand verlinken? YouTube hat die Wünsche einiger Creator erhört und liefert neue Features, die auf genau diese Bedürfnisse eingehen. Mit Edit with AI kommt ein KI-Kreations-Feature, das dir Brainstorming und Erstellung von Shorts abnimmt. Und Brand Links werden ebenfalls bald eingeführt.

YouTube Shorts x Adobe:

Kreativer Content ohne Aufwand dank KI

Endlich Brand Links in YouTube Shorts

Seit 2024 können Creator bereits Links in ihren Shorts auf YouTube integrieren. Allerdings können diese nur zu anderen YouTube-Inhalten wie Shorts, Longform-Videos oder Livestreams führen.

Doch schon lange wünschen sich Creator eine Integration von Links zu Drittquellen, wie sie etwa in den Instagram Stories vorhanden ist. Auf Instagram gab es für Reels bereits entsprechende Experimente und auf TikTok gibt es ebenso schon Produkt-Links in Videos. In YouTubes Konkurrenzprodukt Shorts war das in der Form bisher nicht möglich, wenngleich Creator und Marken Product Tags integrieren können. Doch auf eine Nachfrage auf X, ob das im Rahmen von YouTubes jüngstem Update Event erwähnte Brand Link Feature tatsächlich kommen werde, reagierte Rene Ritchie von der YouTube Liaison. In seinem Post erklärte er, dass Links zu Markenseiten zum Ende des Jahres in die Testphase kommen, ehe sie 2026 breit ausgerollt werden. Für Brands ist das eine gute Nachricht, um die Sichtbarkeit via YouTube zu erhöhen und auf Traffic zu bauen. Immerhin erwähnt Google YouTube auch sehr gern im AI Mode.

Adding a link to a brand site will begin testing later this year and launch

broadly next year! https://t.co/ZpmLr20SuT— YouTube Liaison (@YouTubeInsider) November 2, 2025

Edit with AI: YouTube macht Content-Vorschläge mit Content aus deiner Camera Roll

Ein neues Tool, das Creatorn in der YouTube App und im Create-Bereich schon zur Verfügung gestellt wird, ist Edit with AI. Damit haben die User die Chance, aus Inhalten ihrer Camera Roll automatisch Content für Shorts generieren zu lassen. Sie können einfach Bilder oder Videos auswählen, die in ihren Archiven vorliegen. Dafür können dann Editing Styles gewählt werden, etwa eine Narration mit Voiceover (bisher nur auf Englisch oder Hindi). Und YouTubes KI generiert umfassende Vorschläge für Shorts, die die Creator dann noch verfeinern können. Doch die große Kreationsarbeit im Vorwege entfällt. So erklärt das YouTube Team:

Sometimes the hardest part of video creation is getting started, which is why we built Edit with AI. We hope this new tool gives you creative momentum when you don’t know where to begin! Edit with AI has already started to launch and will be available in Shorts and on the Create app in the coming months […].

Das Feature erinnert ein wenig an Metas KI-basierte Content-Vorschläge für Inhalte, die du noch gar nicht veröffentlicht hast. Das Opt-in Feature ermöglicht der Meta AI durch die Zustimmung der User, auf die Camera Roll zuzugreifen und aus den Visuals welche auszuwählen, für die beispielsweise Story-Vorlagen kreiert werden. Die können die User dann, auch ohne Design-Skills, direkt posten.

OnlineMarketing.de-Redakteurin Caroline Immer war auf dem YouTube Festival 2025 in Berlin vor Ort und hat mit Content Creatorin Alicia Joe und Googles Head of YouTube Sales DACH Christian Lutterbeck über YouTubes Alleinstellungsmerkmale, erfolgreiche Creator-Brand-Kooperationen und die Chancen und Risiken des umfassenden Einsatzes von KI auf der Plattform gesprochen.

Erfahre in dieser Folge von TAP INTO MARKETING unter anderem:

- ob YouTube aus Creator-Sicht als Einnahmequelle überzeugt

- wie viele User YouTube monatlich in Deutschland erreicht

- warum sich Künstliche Intelligenz mit einem Messer vergleichen lässt

- welches No-Go Marken bei der Zusammenarbeit mit Creatorn vermeiden sollten

Online Marketing & SEO

Organischer Content als Brand Ad: LinkedIn Partnerships Hub

Mache passende organische Inhalte von Creatorn zu Thought Leader Ads für dein Unternehmen. Über den neuen Partnerships Hub findest du den besten Content. Davon profitieren Creator und Marketing Teams zugleich – und nicht zuletzt LinkedIn.

Über eine Milliarde Mitglieder tauschen sich auf LinkedIn regelmäßig über ihre Erfahrungen, Jobs und brandaktuelle Entwicklungen im Arbeitskontext – und zuweilen auch im Privaten – aus. Dabei werden nicht selten Unternehmen erwähnt oder markiert, die Teil ihrer Inhalte und somit auch der Beiträge sind. Genau diese organischen Inhalte können dann für betreffende Unternehmen zu relevantem Testimonial Content avancieren. Und um diesem noch mehr Aufmerksamkeit zu verschaffen, gibt es die Thought Leader Ads. Damit lassen sich Beiträge von Angestellten oder Creatorn sponsern, die zunächst organisch waren, für ein Unternehmen aber als Brand-Botschaft in Frage kommen.

Passend zu diesem Werbe-Feature hat LinkedIn mit dem Roll-out eines Partnerships Hubs begonnen. Diesen sehen erste User im Kamapgnen-Manager. Mithilfe des Hubs lassen sich relevante organische Beiträge für ein Unternehmen aus dem LinkedIn-Kosmos schnell finden und promoten. So kann on-brand Marketing am Puls der Zeit und Zielgruppen umgesetzt werden, während Creator profitieren.

Monetarisierung gestartet:

So verdienen LinkedIn Creator jetzt mit Thought Leader Ads und BrandLink

So funktioniert der Partnerships Hub auf LinkedIn

Der Social-Media-Experte und Feature-Beobachter Lindsey Gamble weist in einem Post auf der Plattform auf die Neuerung hin. Demnach kann er bereits auf den Partnerships Hub zugreifen. Im Kampagnen-Manager findet er den neuen Reiter gleichen Namens. Darüber können User ganz einfach die Inhalte auf der Plattform durchsuchen, um Content mit Brand-Erwähnungen ausfindig zu machen. Finden sie passende Beiträge, können sie eine Anfrage für ein Sponsoring via Thought Leader Ad stellen. Dann können die Marketer in eine manuelle Verhandlung gehen, um aus relevanten, vielleicht sogar viralen Inhalten schnell eine Ad zu machen.

Tipps für guten Content, direkt von LinkedIn selbst, findest du in unserem Listicle-Beitrag.

Endlich guter Content:

7 kreative Prinzipien für deinen Content auf LinkedIn

Lindsey Gamble benennt in seinem Post die Vorteile des neuen Features, das nach und nach für User ausgerollt werden dürfte. Zum einen können Unternehmen und Marketer so Creator entdecken, die sie bislang nicht auf dem Radar hatten, die sich aber als organische Brand-Befürworter:innen erweisen. Zum anderen können auf diesem Wege – ähnlich wie auf anderen Plattformen wie TikTok oder YouTube – in kurzer Zeit Inhalte, die gerade die Community beschäftigen, im werblichen Kontext des Unternehmens hervorgehoben werden. Das spart Zeit und Ressourcen für die Kampagnenplanung und -erstellung; denn der UGC ist schon vorhanden. Gerade bei Trendmomenten ist das von Vorteil. Schließlich können die Unternehmen mit dem Partnerships Hub genau die Personen finden, die sogar schon ohne Gegenwert positiv über die Marke sprechen. Und das ist besonders wertvoll für das Branding. Gamble schreibt:

[…] True advocates: Most brands want to work with people who actually like their products. If someone’s already posting about you on their own, that’s exactly who you want […].

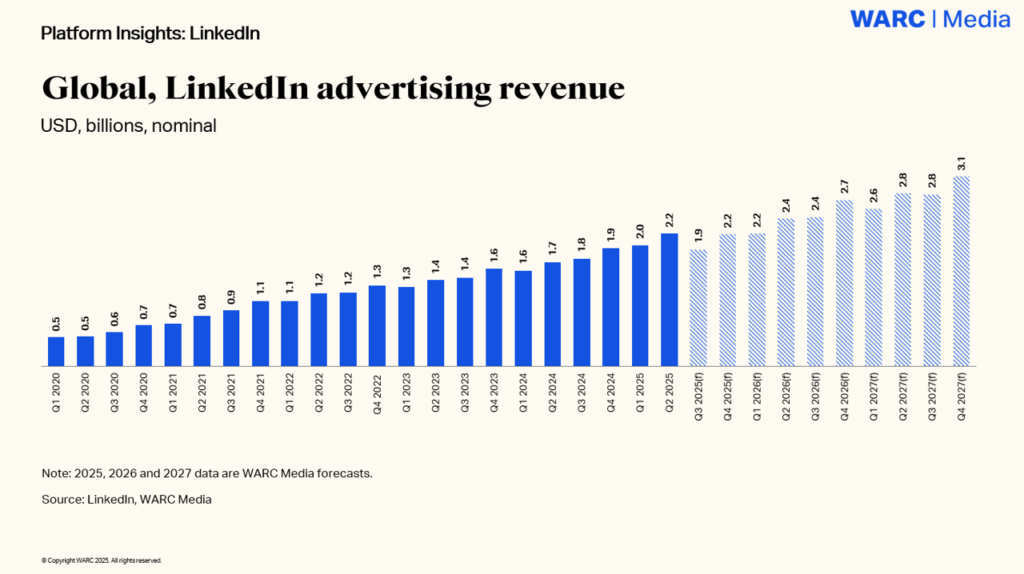

Gewinnchance für Creator, Brands und LinkedIn selbst

Von den Thought Leader Ads und dem Partnerships Hub für deren optimierten Einsatz profitieren also sowohl Marketer und auf der Plattform aktive Brands als auch die Creator selbst. LinkedIn wird sich ebenfalls über mehr Werbung freuen. Im zweiten Quartal 2025 nahm LinkedIns Umsatz im Vorjahresvergleich bereits um neun Prozent zu. Und im Werbebereich prognostiziert WARC im jüngsten Bericht zu LinkedIn einen Umsatz von 8,2 Milliarden US-Dollar für 2025, was einem deutlichen Wachstum von 18,3 Prozent gegenüber dem Vorjahr entspräche.

LinkedIn setzt ohnehin auf mehr Werbung, was vielen Usern im Feed schon aufgefallen sein dürfte. Zum einen werden Videoinhalte immer wichtiger und LinkedIn pusht das Wachstum auch deshalb, weil es Raum für relevante Werbeintegrationen wie die neuen First Impression Ads gibt. Zum anderen werden überhaupt immer mehr Werbemöglichkeiten in die Plattform integriert.

Neu ist in Deutschland inzwischen auch die Boost-Option für Creator, mit der diese eigene Beiträge für eine Gebühr promoten können. Diese sorgt indes derzeit für Diskussionen und stellt den Wert organischer Inhalte zur Debatte. Gegenüber OnlineMarketing.de erklärte LinkedIn-Expertin Britta Behrens:

LinkedIn tanzt auf dem Drahtseil. Kurzfristig neue Einkommensströme zu erschließen ist legitim. Doch den Nutzer:innen die Reichweite zu drosseln und sie diese dann wieder einkaufen zu lassen – und das für hochwertigen Content, der aufwändig und kostenlos erstellt wird –, klingt ziemlich zynisch. Für manche Postings und für Solopreneur:innen ist die Funktion sinnvoll, in Dosen. Sie müssen unbedingt die Balance halten, denn wenn fachliche Stimmen nicht mehr ausgespielt werden und dafür der Newsfeed mit geboosteten Werbe-Postings geflutet wird, verliert die Plattform an Attraktivität. Und dann wenden sich viele von der Plattform ab. Das wird ein Boomerang für LinkedIn und die Umsätze des Unternehmens. Die Entshittification ist in vollem Gange.

LinkedIn:

Bezahlter Beitrags-Boost für Creator in Deutschland sorgt für Diskussion

Online Marketing & SEO

Googles Regeln versagen: Musks KI-Wikipedia erobert die Suche

Dass Google Grokipedia überhaupt indexiert, obwohl die Inhalte vollständig KI-generiert und kaum überprüft sind, verdeutlicht ein zentrales Problem: Das Unternehmen muss für die Suche neu evaluieren, ob solche Inhalte den eigenen Qualitätsrichtlinien überhaupt noch gerecht werden.

Google kämpft mit den eigenen Richtlinien

Die Indexierung von Grokipedia-Inhalten ist aus Sicht der Publisher und auch Googles fragwürdig. Seit dem Start von Google neueren Spam-Richtlinien im Frühjahr 2024 geht Google gezielt gegen sogenannten Scaled Content Abuse vor, also gegen Websites, die massenhaft automatisch generierte Inhalte veröffentlichen, ohne redaktionellen Mehrwert oder überprüfte Quellen. Zahlreiche Seiten mit KI-Content wurden seither manuell abgestraft oder komplett aus dem Index entfernt. Doch Grokipedia-Inhalte scheinen trotz ihrer Natur nicht unter diese Richlinie zu fallen.

Innerhalb weniger Tage nach dem Launch tauchten bereits Hunderte der fast 900.000 automatisch generierten Seiten in den Google-Suchergebnissen auf. Der SEO-Experte Martin Jeffrey wies auf LinkedIn darauf hin, dass Google damit offenbar die eigenen Qualitätsrichtlinien unterlaufe. Er erinnerte daran, dass in den vergangenen Monaten Websites mit deutlich weniger KI-Inhalten hart bestraft wurden – während Grokipedia unbehelligt wächst.

Dass Google und Bing die Seiten dennoch indexieren, macht das Projekt zu einem Stresstest für den Umgang mit Gen AI Content im Web. Während Wikipedia auf Nachprüfbarkeit und Moderation setzt, basiert Grokipedia auf einer unkontrollierten Flut maschinell erzeugter Texte. Das gefährdet nicht nur die Informationsqualität, sondern auch das Vertrauen in Suchmaschinen, die solche Inhalte sichtbar machen.

KI, Wikipedia und der Kampf um Informationsqualität

Die Herausforderung, die Grokipedia aufzeigt, geht deutlich über SEO hinaus: Sie betrifft das Fundament des digitalen Informationssystems. Laut dem Artikel von Wired enthält Grokipedia teils gravierende Fehler und ideologische Verzerrungen. Gleichzeitig zeigen Daten des Reuters Institute for the Study of Journalism im Digital News Report 2024, dass eine wachsende Zahl von Menschen Nachrichten über soziale Medien und KI-Assistenzen bezieht, anstatt klassische journalistische oder wissenschaftliche Quellen zu nutzen. Eine Studie des European Broadcasting Union (EBU) dokumentiert, dass KI-Assistants bereits von rund sieben Prozent der Befragten weltweit als Nachrichtenquelle genutzt werden, bei den unter 25-Jährigen liegt der Anteil sogar bei bis zu 15 Prozent.

Diese Entwicklungen verändern die Wahrnehmung von Wissen: Zwischen Einträgen von Wikipedia, Kurzvideos auf TikTok und Chatbot-Antworten verschwimmt die Grenze zwischen überprüfter Information und vermeintlicher Plausibilität, die dem Algorithmus gefällt. Auch Wikipedia selbst steht seit Jahren in der Kritik, politisch voreingenommen oder von bestimmten Communities dominiert zu sein, wie sowohl die Süddeutsche Zeitung als auch eine Untersuchung des Manhattan Institute zeigen. Beide verweisen auf ideologische Schlagseiten in politischen Artikeln und strukturelle Ungleichgewichte in der Autor:innenschaft, etwa den geringen Anteil weiblicher Beitragender und die Dominanz einzelner Gruppen bei der Themenpriorisierung. Musk greift diese Kritik auf und verspricht mit Grokipedia mehr „Objektivität“. Doch bislang hat er diese vermeintliche Neutralität häufig mit seiner eigenen politischen Agenda verknüpft.

Ein Prüfstein für Googles KI-Regeln

Grokipedia zeigt, wie schwierig es für Suchmaschinen geworden ist, zwischen seriösem KI-Einsatz und inhaltsloser Skalierung zu unterscheiden. Wenn eine Website binnen Tagen Hunderttausende Texte veröffentlicht und indexiert wird, wirft das Fragen zu Googles Suchindex auf.

Für Musk ist Grokipedia ein weiterer Schritt, xAI als globalen Player im KI-Markt zu positionieren. Für Google hingegen wird es zum Prüfstein: Reagiert das Unternehmen nicht konsequent, verliert es an Glaubwürdigkeit und das Fundament verlässlicher Information im Netz gerät weiter ins Wanken.

GEO-Check für KI-Sichtbarkeit:

Diese Quellen nutzen ChatGPT, Perplexity und Co.

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenIllustrierte Reise nach New York City › PAGE online

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online