Online Marketing & SEO

AI Mode zeigt in Bildern, was du nicht in Worte fassen kannst

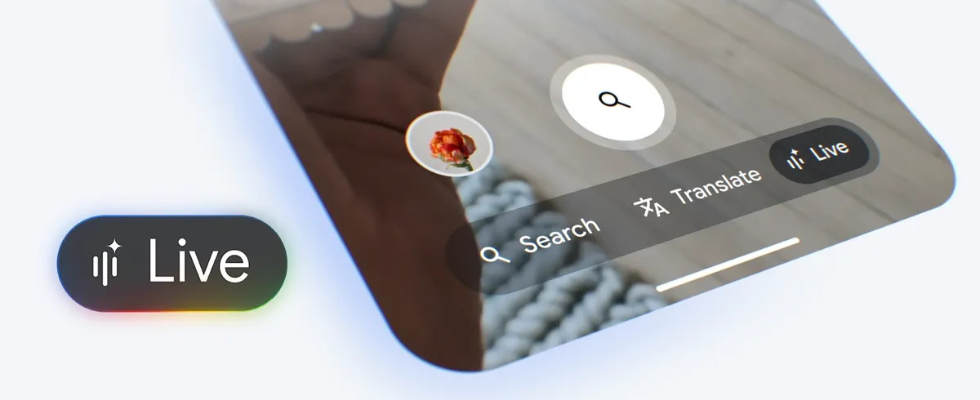

Vibe-Check mit Google: Im AI Mode können User jetzt konversationell Fragen stellen und reichhaltige visuelle Ergebnisse erhalten, auch für den Shopping-Kontext. Das Update folgt kurz nach dem Roll-out der Search Live-Option.

Du suchst nach einer Jacke im 80s Chic mit einem ganz bestimmten Schnitt, nach Inspiration für deine Inneneinrichtung im Japandi-Style oder Accessoires, die einen spezifischen Vibe mitbringen? Wenn dir dafür in der Google-Suche die präzisen Wörter oder Keywords fehlen, soll das künftig kein Problem mehr sein. Denn Google bringt eine neue Suchfunktion in den AI Mode, die visuelle Unterstützung auch bei eher vagen Fragen im konversationellen Modus bietet. Dank der multimodalen und hochleistungsfähigen Sprach- und Reasoning-Fähigkeiten von Gemini 2.5 kann der AI Mode bei Anfragen umfassende Inhalte und Bilder liefern. Diese können als Touchpoint zum Shopping oder für die weitere Recherche genutzt werden. Immerhin können User die Suche im Gespräch mit der KI verfeinern und sogar nach konkreten Details aus Bildergebnissen fragen.

So wird die Google-Suche im AI Mode nach dem Roll-out von Search Live immer mehr zu einer vielschichtigen KI-Assistenz – aber noch immer nicht für alle.

Gradient G:

Google mit neuem Logo für alle Bereiche

Visuelle und konversationelle Suchhilfe vom AI Mode oder der Style-Check mit Google

Das Suchen mit Google wird immer einfacher. Dafür sorgt insbesondere der noch junge AI Mode. Als konversationelle KI-Unterstützung mit multimodalen Fähigkeiten bietet er im Vergleich zu den AI Overviews deutlich ausführlichere Antworten, etwa auf Fragen, die mehr rationale Evaluierung, Vergleichsgrößen oder weiterführende Sondierungen benötigen. Der AI Mode soll Usern erlauben, nuancierte Fragen zu stellen und eine ausführliche Antwort zu erhalten, für die es ohne den Modus mehrere Anfragen gebraucht hätte. Dabei unterstützt eine maßgeschneiderte Version von Gemini 2.5 den Modus. Shopping-Daten, Echtzeitinformationen und die wichtigsten Quellen werden herangezogen, um verständliche und passende Antworten zu finden.

Dafür fasst Google diverse verwandte Suchkontexte zu Unterthemen parallel zusammen und kreiert eine auf die Suchintention zugeschnittene Antwort. Mit dem als Fan-out-Praktik für Suchanfragen bezeichneten Verfahren nutzt Google ein umfassendes Reasoning. Dabei werden die Suchanfragen in Unterkategorien aufgeteilt, zu denen die KI unterschiedliche Suchen unternimmt, um sowohl aus dem Web als auch von Google – etwa aus Knowledge Graphs – relevante Informationen zusammenzutragen. Diese Antworten spielt der AI Mode inzwischen auch bei multimodalen Suchen aus.

Und um diese geht es mit der neuen Visual Search. Robby Stein, VP of Product für die Google Search, stellt sie auf X vor. Er beschreibt die Option als Weg, um von einer Idee oder wenigen Worten schnell zu passenden Bildern oder gar Shopping-Optionen zu gelangen, die deiner Idee entsprechen. Für die Bereitstellung passender Ergebnisse auch im visuellen Kontext – also etwa Bilder zur vage erfragten Jacke im 80s Chic – setzt Google auf das neue Visual-search-fan-out-Verfahren.

(2/4) This experience is powered by Gemini 2.5’s multimodal capabilities and our visual understanding in Search. Using a new technique we’re calling „visual search fan-out,” AI Mode is able to analyze more objects in an image and better understand the context of your question.

— Robby Stein (@rmstein) September 30, 2025

Details zur Veränderung des AI Mode: US User im Vorteil

Das erklärt Stein gemeinsam mit Lilian Rincon, VP of Product für Consumer Shopping, auf dem Blog The Keyword. Dort schreiben sie darüber, wie Google die visuelle Entdeckung natürlicher machen möchte, also mit natürlicher Sprache und Konversation im AI Mode. Dabei betonen sie, dass das neue Feature vorerst nur auf Englisch und in den USA ausgerollt wird.

Got the vibe but not the words? Starting today, you can simply show or tell AI Mode about what you’re looking for and get rich, visual results to explore. ✨

This experience works by bringing together Search’s world-class visual understanding from Lens and Image search with… pic.twitter.com/xxbHtLDrxF

— Google AI (@GoogleAI) September 30, 2025

Die Verfügbarkeit der Funktion könnte bald für weitere Märkte folgen. Genau wie für die neue Suchoption Search Live, bei der User mit ihrer Stimme und Kamera live Fragen an den AI Mode stellen und passende Echtzeitantworten erhalten können. Auch diese Option verschiebt die Google-Suche weiter in den Bereich natürlicher Sprache, die Googles KI-Modell besser denn je versteht. Mit Gemini 3 könnten sich die Fähigkeiten sogar noch steigern, vor allem, wenn Milliarden User Daten und Kontexte für das Training bereitstellen, etwa durch Search Live oder die Visual Search.

Der AI Mode ist bereits in über 180 Ländern und auf verschiedenen Sprachen verfügbar, in der EU müssen die User aber noch auf ihn warten.

Mit Stimme und Kamera suchen:

Google Search Live endlich im Roll-out

So bringt Google jetzt Suchideen und visuelle Ergebnisse zusammen

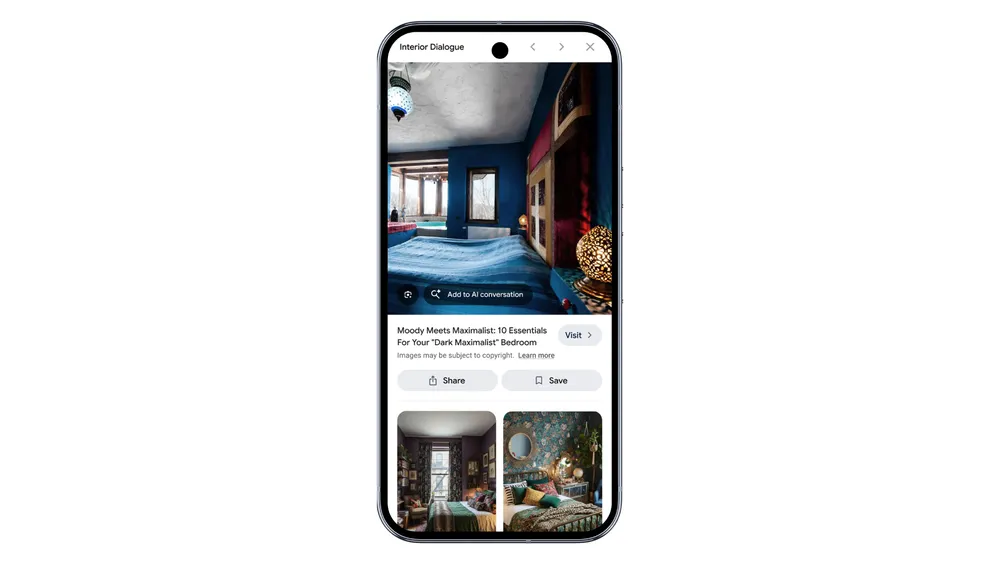

Im Blog Post geben Rincon und Stein konkrete Beispiele für die neue Visual Search preis. Suchen User beispielsweise nach Inspiration für ein maximalistisch eingerichtetes Schlafzimmer, liefert Google passende Bilder. Diese ersten Ergebnisse können die User dann optimieren, etwa nach dunklen oder hellen Tönen suchen, auf passende Links klicken oder mit Follow-up-Fragen die Recherche ausweiten. Auch können die User ihre Inspirationssuche ausgehend von Bildern oder Videos starten, die sie hochladen, da der AI Mode multimodalen Input verarbeiten kann.

Wenn dich zudem einzelne Details aus Bildern interessieren, etwa ein Bett auf einem Bild in einem Schlafzimmer, das dir zusagt, kannst du den AI Mode direkt nach diesem Detail fragen. Du kannst Bildelemente einfach zur AI-Konversation hinzufügen, ein AI Mode Icon mit entsprechendem CTA erscheint dann im Visual.

Statt auf zahlreiche Filter bei der Suche zu setzen, raten Rincon und Stein also zur verfeinerten Suche via AI Mode. So lässt sich beispielsweise die passende Jeans in einem ganz bestimmten Stil finden. Von der Startsuche mit „barrel jeans that aren’t too baggy“ bis hin zur angepassten Beinlänge geht es im konversationellen Modus schnell.

Shopping-Hilfe mit Hintergedanken in Googles AI Mode

Google kann bei der Auswahl auf über 50 Milliarden Produkt-Listings aus dem Shopping Graph zurückgreifen. Die Shopping-Beiträge zeigen Reviews, verschiedene Farboptionen und Verfügbarkeiten an. Jede Stunden werden über zwei Milliarden Listings aktualisiert, sodass Suchende immer passende Produkte finden können. Allerdings wird Google vorerst keinen Checkout direkt in der KI-Suche integrieren, wie es OpenAI jüngst mit dem Instant Checkout für ChatGPT und beispielsweise Shopify Seller ermöglicht hat. Das bestätigte Robby Stein gegenüber SEO-Experte Barry Schwartz.

Barry asked Google’s Robby Stein about the possibility of buying directly in AI Mode -> „I did ask Robby Stein, VP at Google Search, about Google AI Mode eventually letting users check out in AI Mode, and he said right now, the final checkout will be done on the retailer’s site.… https://t.co/XXxTj5yxNd

— Glenn Gabe (@glenngabe) September 30, 2025

Online Marketing & SEO

Gruppen-Chats für ChatGPT sind da

Rolling out now to Free, Go, Plus, and Pro users in Japan, New Zealand, South Korea, and Taiwan on both mobile and web.

Make sure you’re on the latest iOS or Android app.https://t.co/jusfSiaEPf

— OpenAI (@OpenAI) November 14, 2025

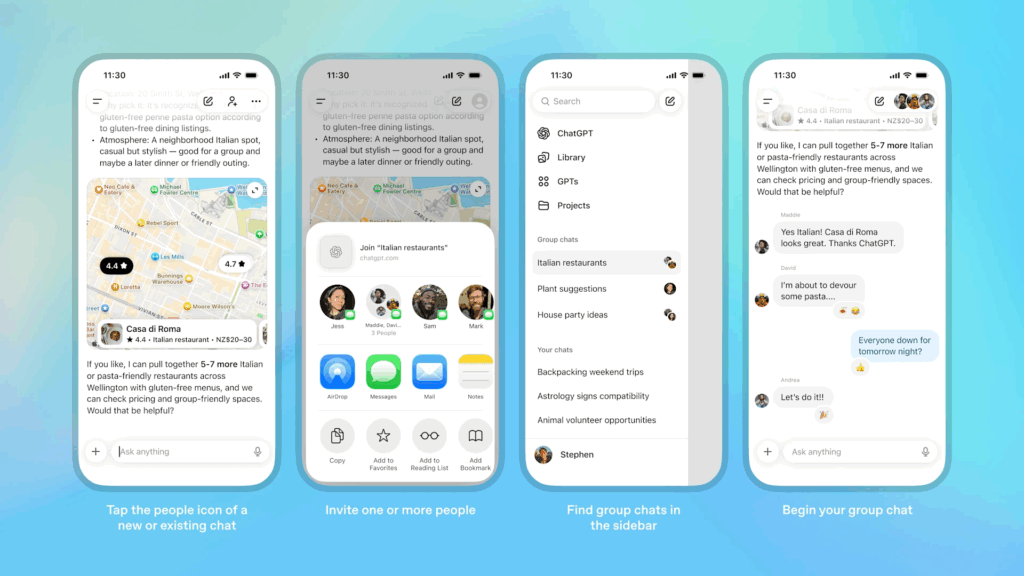

Die Gruppen-Chats sollen dazu dienen, Kooperationen schnell und einfach möglich zu machen. Diese können sich auf die Planung von Reisen oder Geschenken beziehen oder auf eine Kampagne im Team bei der Arbeit. Dabei sind die Gruppen-Chats stets von den privaten Chats der User getrennt und können eigens benannt werden. Und die Chat-Erinnerungen werden niemals mit anderen Mitgliedern dieser Gruppen geteilt. Auch werden aus diesen Gruppen keine neuen Erinnerungen generiert.

ChatGPT selbst kann im Gruppen-Chat mitwirken und durch die direkte Erwähnung zu Antworten oder Inspiration aufgerufen werden. Ansonsten schreitet die KI ein, wenn sie es für nötig hält, kann aber auch passiv bleiben. OpenAI gibt an, der KI das „Verhalten in Gruppen-Chats“ beigebracht zu haben. Mit Custom Instructions lassen sich die Antworten der KI indes noch feinjustieren, je nach Zweck in der Gruppe.

In die Gruppen-Chats können User andere aufnehmen, indem sie auf das passende Icon im oberen rechten Bereich neuer oder bestehender Chats tippen. Dann kopiert ChatGPT die Konversation und startet eine separate Gruppenkonversation. Über Link Sharing können bis zu 20 Leute für die Gruppe eingeladen werden. Nach der Einladung werden Teilnehmende gebeten, ein Profil mit Namen, Foto und Username zu erstellen, um für andere identifizierbar zu sein. Das korreliert mit dem Test für personalisierte Profile, den OpenAI zuletzt umsetzte. Die Gruppen-Chats erscheinen in einem gesonderten Reiter in der Sidebar.

GPT-5.1 Power und Multimodalität möglich

Die Antworten, die ChatGPT in Gruppenkonversationen liefert, basieren auf dem neuen GPT-5.1-Modell in der Auto-Variante. Diese nutzt je nach Kontext die Modelloption Instant oder Thinking. Dabei kann die KI passende Informationen liefern, mit Emojis auf Nachrichten reagieren – auch ganz wie auf WhatsApp – und sogar auf Profilbilder von Usern referenzieren oder diese für lustige Visuals nutzen. User können im Chat die Suche nutzen, Bilder hochladen und ebenso Dokumente miteinbeziehen.

Wer eine Einladung zum Gruppen-Chat erhält, muss diese erst aktiv annehmen. In den Gruppen sind alle Mitglieder zu sehen, sie können auch jederzeit die Gruppe verlassen. Und wer noch keine 18 Jahre alt ist (laut Angaben bei ChatGPT), wird automatisch nicht mit sensiblen Inhalten konfrontiert, die ChatGPT selbst teilen könnte; das betrifft dann allerdings die ganze Gruppe. Eltern können Gruppen-Chats für Kinder zudem ganz ausstellen mithilfe der Elternkontrollen.

Dass die Gruppen-Chats bald auch in andere Regionen kommen, ist bei OpenAIs Ablauf hinsichtlich der Produktbereitstellung sehr wahrscheinlich. Zunächst möchte man aber das Feedback der ersten User einholen und etwaige Optimierungen integrieren. Derweil können sich User der Business-, Enterprise- und Edu-Abonnements über die Integration von Figma in ChatGPT freuen. Damit lassen sich Diagramme auch zu den komplexesten Fragen im Chat erstellen, wie das Unternehmen auf X mit einem Augenzwinkern zeigt.

Figma in ChatGPT is now available on their Business, Enterprise and Edu plans so imagine a more professional use case here https://t.co/XI141WFV4j

— Figma (@figma) November 13, 2025

Für noch mehr Funktionsvielfalt und lustigere, persönlichere sowie liebevollere oder verspielte Antworten soll nun GPT-5.1 als Optimierung gegenüber GPT-5 als neues Default-Modell für ChatGPT sorgen. GPT-5.1 ist inzwischen ebenfalls in der API verfügbar – zum gleichen Preis wie bei GPT-5 –, genau wie gpt-5.1-codex and gpt-5.1-codex-mini.

GPT-5.1 is now available in the API. Pricing is the same as GPT-5.

We are also releasing gpt-5.1-codex and gpt-5.1-codex-mini in the API, specialized for long-running coding tasks.

Prompt caching now lasts up to 24 hours!

Updated evals in our blog post.

— Sam Altman (@sama) November 13, 2025

Online Marketing & SEO

„Wie ein Blei-Teddybär“: So genial springt Duolingo auf den Hype um Rosalias „Berghain“ auf

Das neue Album des spanischen Popstars Rosalia hat sich in Rekordzeit zum kulturellen Phänomen entwickelt. Besonders ihr auf deutsch gesungener Hit „Berghain“ fasziniert die Fans. Jetzt liefert das Marketingteam der Sprach-App Duolingo eine eigene Version, in der die Duolingo Eule mal Popstar spielen darf.

Die Bildsprache der Vorlage ist in Duolingos Social-Media-Clip perfekt getroffen: Das Streicherorchester ist da, die Badewanne ist da, und auch der Ma

Jetzt Angebot wählen und weiterlesen!

HORIZONT Digital

- Vollzugriff auf HORIZONT Online mit allen Artikeln

- E-Paper der Zeitung und Magazine

- Online-Printarchiv

HORIZONT Digital-Mehrplatzlizenz für Ihr Team

Online Marketing & SEO

Nächste KI-Browser-Option: Firefox erhält AI Window

ChatGPT Atlas ist da:

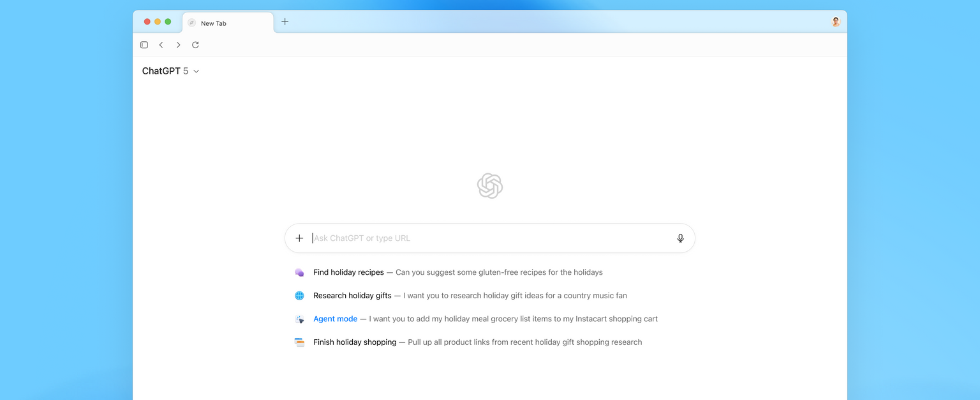

AI-first Browser auf dem Weg zur Superassistenz

AI Window, Shake to Summarize und Co. – neue AI-Lösungen für Firefox mit User-Fokus

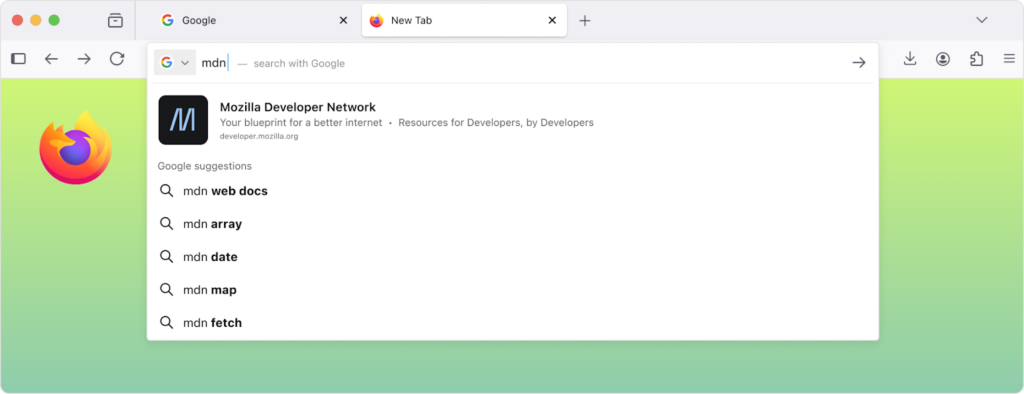

Mozilla ist stets darum bemüht, die Browser-Erfahrung für User so gut wie möglich zu gestalten. Dabei betont die Organisation immerzu die Wahlfreiheit, die Nutzer:innen im Digitalraum haben. Sie können Chrome nutzen, aber auch Safari, Edge oder eben Firefox. Dieser Browser, der stark auf Datenschutz baut und von einer Non-Profit-Organisation betrieben wird, entwickelt sich derzeit rasant weiter. Vor wenigen Wochen wurden bereits optimierte Search-Vorschläge vorgestellt, die Firefox direkt in der Adresszeile ausspielt.

Außerdem gibt es für iOS User in den ersten Regionen – leider noch nicht in Deutschland – das Feature Shake to Summarize. Damit können User dank AI Support mit einem Schütteln des Mobilgeräts ganze Websites (mit maximal 5.000 Wörtern) oder Artikel zusammenfassen lassen. Auf dem Desktop hingegen können User in der Sidebar mit einem AI Assistant in Kontakt treten. Dabei haben sie die Möglichkeit, zum Beispiel Claude, ChatGPT, Gemini, le Chat oder den Copilot auszuwählen.

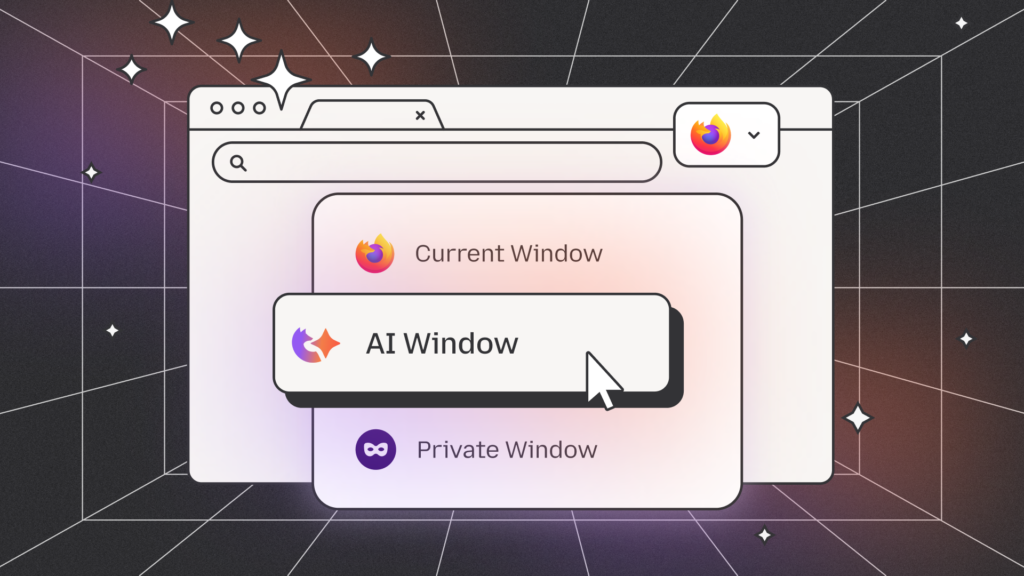

Und das Chatten mit der KI wird im Browser-Kontext jetzt zur Norm. Mit dem AI Window erlaubt Firefox Hilfestellung vonseiten der KI parallel zum Besuchen von Websites. Es handelt sich um eine Opt-in-Option, die die Standardfenster und privaten Browser-Fenster als Variante ergänzt. Interessierte können sich dafür bereits auf die Warteliste schreiben lassen. User können den AI Support über diese Fensteroption anwählen, oder einfach bei ihrem klassischen Firefox-Fenster bleiben – die Wahl bleibt bestehen. Die Auswahl bezieht sich auch auf die AI Assistants, die die Nutzer:innen wie im Sidebar-Kontext selbst wählen können. Mozilla weist aber darauf hin, dass der Einsatz von Chatbots wie Claude, Gemini und Co. Hand in Hand mit der Zustimmung zu den Nutzungsrichtlinien der Unternehmen dahinter geht. Daten, die Firefox beim klassischen Browsing nicht trackt, könnten dann beim Einsatz der KI an die Unternehmen weitergeleitet werden.

Das Team von Firefox erklärt im Blog Post, man wolle sich von anderen Playern abgrenzen und Usern so viel Selbstbestimmung wie möglich lassen. Man dürfe aber die KI-Integrationen nicht verschlafen:

[…] While others are building AI experiences that keep you locked in a conversational loop, we see a different path — one where AI serves as a trusted companion, enhancing your browsing experience and guiding you outward to the broader web. We believe standing still while technology moves forward doesn’t benefit the web or humanity. That’s why we see it as our responsibility to shape how AI integrates into the web — in ways that protect and give people more choice, not less.

„Choice verändert das Verhalten“

– Robin Karakash von Mozilla über Alternativdienste, relatable Datenschutz und AI

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenAdobe Firefly Boards › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenHarte Zeiten für den demokratischen Rechtsstaat

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenIllustrierte Reise nach New York City › PAGE online

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet