Apps & Mobile Entwicklung

Arm Lumex CSS Platform: Neue C1-Kerne führen SME2 für AI direkt auf der CPU ein

Die Arm Lumex CSS Platform führt das C1-CPU-Cluster als Nachfolger der bisherigen Cortex-Kerne ein. Dabei setzt Arm durch die Bank auf die Scalable Matrix Extension 2 (SME2) für schnelles und effizientes AI direkt auf der CPU. Vier neue Kerne, ein neuer Interconnect und mehr schrauben die Leistung hoch und den Verbrauch runter.

Künstliche Intelligenz soll erwarteter Standard werden

Die Chip-IP-Entwickler von Arm vergleichen Künstliche Intelligenz mit der Einführung und späteren Etablierung von Touch-Bildschirmen auf mobilen Endgeräten. Ein ehemals neues Feature sei mittlerweile so sehr in der Gesellschaft verankert, dass junge Menschen ganz selbstverständlich jeden Bildschirm mit den Fingern bedienen wollen. Diese Veränderung in der Interaktion mit Geräten stehe Arm zufolge auch dem Einsatz Künstlicher Intelligenz bevor. AI werde sich wie Touch in der Gesellschaft verankern und zu einem Feature entwickeln, das Anwender schlichtweg erwarten.

Lumex folgt auf Cortex

Die passende Hardware ermöglicht das Unternehmen mit der neuen Arm Lumex CSS Platform. Diese folgt auf die letztjährige CSS for Client (Compute Subsystems for Client), die unter anderem aus den CPU-Kernen Cortex-X925, A725 und A520 Refresh sowie den GPUs Immortalis-G925, Mali-G725 und Mali-G625 bestand.

Die neuen Namen der Plattformen

Dass Arm zu neuen Namen wechseln wird, hatte das Unternehmen bereits im Mai bekannt gegeben. Was über Jahrzehnte unter dem Namen „Cortex“ vermarktet wurde, heißt mit der neuen Generation „Lumex“. Mit „Niva“ soll später auch eine eigene PC-Plattform folgen.

- Arm Neoverse for infrastructure

- Arm Niva for PC

- Arm Lumex for mobile

- Arm Zena for automotive

- Arm Orbis for IoT

C1 Ultra, Premium, Pro und Nano

Von dem Neustart abgeleitet hat Arm den Zähler für die Bezeichnungen der einzelnen Lösungen innerhalb der Plattform zurückgesetzt und führt neue ergänzende Namensschemata ein, um Produkte wie zum Beispiel die CPU-Kerne in verschiedene Leistungsklassen zu sortieren. Beispiel: Das neue CPU-Cluster heißt „C1“ und kommt in den Abstufungen „Ultra“, „Premium“, „Pro“ und „Nano“. Das ist vergleichbar mit den Lösungen, die zuvor unter den Namen Cortex-X925, A725 und A520 liefen.

Vier neue CPU-Kerne lösen drei alte ab

Arm bietet innerhalb des C1-CPU-Clusters jetzt allerdings vier Abstufungen an. Ultra sitzt oberhalb und Premium unterhalb des vorherigen Cortex-X900. Pro und Nano sortiert Arm auf dem Niveau der Vorgänger Cortex-A700 und Cortex-A500 ein.

SME2-Einheiten für AI direkt auf der CPU

Über allen technischen Veränderungen an den CPU-Kernen steht ein Feature: die Scalable Matrix Extension 2 (SME2). SME2 ist eine Erweiterung der Armv9-A-Architektur und wurde entwickelt, um den Prozessor bei genau der Art von Rechenarbeit deutlich schneller zu machen, die in KI, Machine Learning, Bild- und Audiosignalverarbeitung ständig vorkommt – nämlich große Matrizen von Zahlen zu verschieben, zu multiplizieren und zu addieren. Die SME2-Einheit ermöglicht dem Prozessor, ganze Blöcke von Zahlen gleichzeitig zu verarbeiten, anstatt bei Matrizen viele kleine Schritte nacheinander auszuführen. Das steigert die Leistung in Bereichen wie Bilderkennung, Sprachverarbeitung oder Textzusammenfassung und reduziert zugleich den Stromverbrauch, weil weniger Daten unnötig hin- und hergeschoben werden müssen.

Arm hatte zuvor die Scalable Vector Extension (SVE) und SVE2 eingeführt, die Vektorregister variabler Länge bieten. SME2 erweitert dieses Prinzip auf Matrixregister – man kann dadurch ganze 2D-Blöcke von Daten direkt in der CPU verarbeiten.

Einsatz vom kleinsten bis zum größten Kern

Das C1-CPU-Cluster entspricht der Armv9.3-ISA und ist das erste Cluster von Arm, das SME2 auf allen Kernen unterstützt. Auf SME2 hat zuvor ausschließlich Apple beim M4 gesetzt. Bis auf CPU-Cluster mit lediglich zwei der kleinsten Nano-Kerne ist SME2 nicht optional, Chip-Entwickler können die SME2-Einheit(en) somit nicht einfach weglassen, da diese fester Bestandteil der Architektur sind. Kommt SME2 im Cluster zum Einsatz, dann muss die Einheit allen Kernen zur Verfügung stehen und kommt damit selbst beim kleinsten Nano zum Einsatz.

SME2 ist der nächste Entwicklungsschritt bei Arm für AI direkt auf der CPU, ohne für diese Berechnungen zu einer diskreten GPU oder NPU wechseln zu müssen. Arm entwickelt unter der Bezeichnung „Ethos“ zwar auch NPUs speziell für KI-Workloads, siedelt diese aber im IoT-Segment und nicht innerhalb der Lumex CSS Platform an.

CPU soll zur ersten Wahl für AI werden

Die CPU sei mit der SME2-Erweiterung die erste Wahl für Entwickler von AI-Apps, erklärte Arm zum Vorabtermin am Firmenstandort in Cambridge. Die CPU biete die größte Flexibilität und erhalte mit SME2 einen großen Leistungsschub für AI. Eigene NPUs werde es laut Arm auch weiterhin bei den finalen Produkten der Kunden geben, diese betrachtet das Unternehmen aber als hochspezialisierte Hardware-Einheiten für ganz konkrete Aufgaben. Eine CPU sei hingegen breiter aufgestellt, zudem komme es nicht zu Einbußen oder Latenz durch Datentransfers.

Leistungssteigerung um den Faktor 5

SME2 soll im C1-CPU-Cluster bei AI-Workloads bestenfalls für eine Leistungssteigerung um den Faktor 5 und eine Effizienzsteigerung um den Faktor 3 sorgen. Arm nennt beispielhaft die Spracherkennung in Whisper Base, wo sich die Latenz von 1.495 ms auf 315 ms reduzieren lasse. Oder das Audio-Encoding mit Gemma 3 mit einer Steigerung von 84 auf 398 Token/s. Für eine Audio-Generierung mit Stable Audio gibt Arm eine Reduzierung von 27 s auf 9,7 s bis zur Fertigstellung an. Die durchschnittliche Leistungssteigerung für AI auf der CPU erreiche Arm zufolge den Faktor 3,7. Die Zahl ergibt sich aus einer Testreihe von 13 AI-Benchmarks und AI-Anwendungen.

KleidiAI soll es Entwicklern leicht machen

Für Software-Entwickler soll mit SME2 kein zusätzlicher Aufwand entstehen. Dafür soll die von Arm angebotene Software-Library-KleidiAI sorgen. KleidiAI besteht aus stark optimierten Micro-Kernels, die in verschiedenen KI-Frameworks (XNNPACK, PyTorch, LiteRT (früher TensorFlow Lite), llama.cpp) eingebettet werden. Entwickler müssen dabei keinen zusätzlichen Code schreiben – KleidiAI sorgt automatisch dafür, dass dieser auf dem verfügbaren Arm-Hardware-Instruktionssatz optimal ausgeführt wird. Bei SME2-fähiger Hardware übernimmt KleidiAI die automatische Weiterleitung rechenintensiver Matrixoperationen an die entsprechenden Einheiten der CPU.

C1-Ultra ist der neue Prime-Core mit +11% IPC

Ganz oben im C1-CPU-Cluster steht mit der neuen Lumex CSS Platform der C1-Ultra als Prime-Core. Für diesen CPU-Kern gibt Arm eine zweistellige Verbesserung der IPC im Vergleich zum Cortex-X925 an (Geekbench, ISO Frequency und Memory Subsystem). Die IPC-Leistung habe Arm seit dem Cortex-X1 um über 75 Prozent steigern können. Arm gibt die relative IPC-Leistung gegenüber der „2024 Premium Android Competition“, bei der es sich um den Oryon-Prime-Core des Qualcomm Snapdragon 8 Elite handeln dürfte, mit dem Faktor 1,2 an, also mit 20 Prozent mehr Leistung – bei jeweils gleichem Takt. Gegenüber dem Cortex-X925 liegt der IPC-Vorteil dem Diagramm zufolge bei 11 Prozent.

Front-End, Core und Back-End überarbeitet

Für die Zugewinne des C1-Ultra hat Arm abermals das Front-End, den Core und das Back-End überarbeitet. Das Front-End ist bei einem Prozessor für die Sprungvorhersage, das Fetching aus dem Speicher und das Decoding zuständig. Arm gibt unter anderem für das Fetching eine um 33 Prozent erweiterte Bandbreite für den L1-Instruction-Cache an, nachdem diese letztes Jahr verdoppelt wurde. Erneut gibt es abgeleitet von einer höheren Genauigkeit Leistungs- und Effizienzverbesserungen für bedingte Branches, die in Abhängigkeit von einer Kondition ausgeführt oder eben nicht ausgeführt werden.

Der Core bleibt beim „10-wide-Design“, aber mit 25 Prozent größerem Out-of-Order-Fenster und bis zu ~2K Instruktionen „in flight“. Maschinensprachen-Befehle wie Move-Instruktionen wurden vor die Core-Pipeline gesetzt, was Leistung und Effizienz zugutekommen soll. Im Back-End hat Arm den L1-Data-Cache auf 128 KB verdoppelt, das Out-of-Order-Fenster um 25 Prozent vergrößert und die Data-Prefetcher optimiert.

C1-Premium ist ein Sub-Flagship-Core

Unterhalb des C1-Ultra sitzt der C1-Premium, den Arm mit „Premium-Leistung für neue Marktsegmente“ beschreibt. Das Unternehmen gibt Flächeneinsparungen über die Vektor-Einheiten, den L2-Cache und eine optimierte physische Umsetzung gegenüber dem C1-Ultra an. Eine DynamIQ Shared Unit (DSU) mit zwei C1-Premium und sechs C1-Pro falle 35 Prozent kleiner aus als eine DSU mit zwei C1-Ultra und sechs C1-Pro. In diesem „Sub-Flagship-Tier“ unterhalb der Lösung für Flaggschiffe werde im Vergleich zum „Mainstream-Tier“ mit vier C1-Pro und vier C1-Nano aber eine 35 Prozent höhere Single-Thread-Leistung geboten. Für C1-Ultra und C1-Premium wirbt Arm mit der CPU-IPC-Führung, höchsten Flächeneffizienz und gesteigerten Effizienz für eine hohe anhaltende Leistung.

C1-Pro ist das Arbeitstier im Cluster

Den C1-Pro bezeichnet Arm als das Arbeitstier im Cluster mit zwei ausgeprägten Einsatzgebieten: in Kombination mit dem C1-Ultra oder C1-Premium für das Flaggschiff- und Sub-Flaggschiff-Segment sowie in Kombination mit dem C1-Nano in allen niedrigeren Preisklassen. Der C1-Pro liefere in einer Auswahl von Apps und Spielen bis zu 16 Prozent mehr Leistung bei gleicher Frequenz wie der Cortex-A725 oder sei bei gleicher Leistung bis zu 12 Prozent effizienter. Der Core bleibt unverändert, im Front-End gibt es für die Sprungvorhersage einen gesteigerten Durchsatz und eine höhere Genauigkeit. Im Back-End hat Arm den Durchsatz gesteigert und die Latenz reduziert. In einer ISO-Konfiguration erreiche der C1-Pro im Geekbench 6.3 eine 11 Prozent höhere Leistung pro Watt oder verbrauche bei gleicher Leistung 26 Prozent weniger.

Area Optimized Configuration des C1-Pro

Analog zum Cortex-A720 und Cortex-A725 bietet Arm den C1-Pro auch wieder in einer „Area Optimized Configuration“ an, um bei gleicher Fläche eines älteren Cortex-A78 ein verhältnismäßig günstiges ISA-Upgrade von der alten Armv8 auf die Armv9 zu ermöglichen. Diese Version des C1-Pro behält die Fläche des Cortex-A720 bei, bietet aber 10 Prozent mehr Leistung im Geekbench 6.1 und 19 Prozent mehr im SPECint2017.

C1-Nano hebt E-Core auf neues Niveau

Der C1-Nano folgt auf den Cortex-A520 (Refresh) und ist damit der neue E-Core respektive kleinste Kern im C1-CPU-Cluster. Nach wie vor handelt es sich um ein In-Order-Design, während C1-Pro, Premium und Ultra erneut Out-of-Order-Designs sind. Durch reduzierten Traffic zum L3-Cache und DRAM soll der C1-Nano unter Verwendung der gleichen Fertigung 26 Prozent effizienter als der Cortex-A520 sein. 5,5 Prozent mehr Leistung in SPECint2017 innerhalb von 2 Prozent mehr Fläche gibt Arm für den C1-Nano an.

Im Front-End hat Arm die Pipelines für die Sprungvorhersagen und das Fetching voneinander getrennt, was die Leistung steigern, Instruktionen früher in den L1-I-Cache bringen und Stalls reduzieren soll. Für den Core nennt Arm Verbesserungen an den Vektor-Einheiten sowohl bei der Leistung als auch Effizienz sowie eine zusätzliche Weiterleitung der Ergebnisse aus Vektor-Operationen für die direkte Nutzung in der nächsten Instruktion, ohne über die Register oder den Speicher gehen zu müssen.

C1-DSU ist schneller und effizienter

Zusammengeführt werden die unterschiedlichen Kerne über die DynamIQ Shared Unit (DSU), die bei der Arm Lumex CSS Platform von der bisherigen Bezeichnung DSU-120 zur neuen C1-DSU wechselt. Nach wie vor lassen sich in einer DSU bis zu 14 CPU-Kerne unterbringen. Und erneut kann ein SoC auch mehr als eine DSU für somit mehr als 14 CPU-Kerne nutzen, in der Praxis ist diese Erweiterung aber kaum von Relevanz. Ausnahmen wie der Nvidia GB10 mit 20 CPU-Kernen von Arm bestätigen die Regel.

Quick Nap für einzelne RAM-Bänke

Die C1-DSU lässt sich erneut mit bis zu 32 MB L3-Cache konfigurieren, die FPGA-Referenzplattform von Arm kommt hingegen mit 16 MB aus. Arm taktet die DSU neuerdings aber mit 2,0 GHz statt 1,8 GHz. Erweitert hat Arm den letztes Jahr eingeführten „Quick Nap“ des L3, bei dem sich der RAM jetzt in kleinere Bänke unterteilen lässt. „L3 Quick Nap Mode“ bedeutet, dass der Cache-Inhalt gehalten werden kann, sich während dieses kurzzeitigen Energiesparmodus aber nicht mehr in den Cache schreiben oder daraus lesen lässt. Dieser Modus lässt sich jetzt für einzelne RAM-Bänke definieren, sodass mehr vom RAM im Energiesparmodus verbleiben kann.

SI L1 und MMU L1

Arm wechselt mit der Lumex CSS Platform zu einer neuen Interconnect-Architektur, die den neuen System Interconnect L1 (SI L1) und die neue Memory Management Unit L1 (MMU L1) mit sich bringt. CPU und GPU sind direkt am zusammengelegten SI L1 angebunden, nachdem die CPU bislang an den CI-700 und die GPU an den NI-700 angebunden war. Der NI-700 war als Network-on-Chip für die Anbindung von Beschleunigern wie GPUs, SoC-Konnektivität und Peripherie zuständig und sitzt jetzt innerhalb des SI L1 mit direkter Anbindung an die integrierten Memory Controller Nodes (MCN) mit deren zugewiesenem System Level Cache (SLC), der bei der Referenzplattform von Arm auf abermals 16 MB kommt.

Vorbereitet für LPDDR6

Die Anzahl der MCN-Slices (bis zu 8) und deren SLC-Größe (bis zu 4 MB) können die Chip-Anbieter eigenständig konfigurieren. Der neue Aufbau soll die statische Interconnect-Latenz um bis zu 75 Prozent reduzieren und den Energiebedarf verringern. Arm hat den SI L1 und die MMU L1 mit entsprechender Bandbreite für den Einsatz von LPDDR6 vorbereitet, wenngleich LPDDR5X erst einmal die Norm darstellen wird.

Referenzplattform mit 2+6 Kernen und 4,1 GHz

Das alles mündet mit der Arm Lumex CSS Platform in einer Gesamtlösung, für die Arm eine FPGA-basierte Referenzplattform entwickelt hat, die sich aus zwei C1-Ultra mit 4,1 GHz, sechs C1-Pro mit 3,5 GHz, zwei SME2-Einheiten mit 2,0 GHz, einer C1-DSU mit 2,0 GHz und 16 MB L3, dem SI L1 mit 16 MB SLC, der neuen Grafikeinheit Mali G1-Ultra mit 14 Kernen und 4 MB L2, LPDDR5X-9600 und Android 15 zusammensetzt. Es ist davon auszugehen, dass Partner ähnlich gestaltete SoC-Designs vorstellen werden. Arm visiert mit der Plattform die Fertigung in 3 nm an.

Für diese Referenzplattform gibt Arm im Vergleich zur vorherigen eine 45 Prozent höhere Multi-Thread-Leistung, 25 Prozent höhere Single-Thread-Leistung, 24 Prozent höhere Browser-Leistung, 15 Prozent schnellere App-Launches, 24 Prozent mehr Leistung im GFXBench 5, 28 Prozent mehr Leistung im 3DMark, 37 Prozent mehr Leistung im Basemark GPUScore und 18 Prozent mehr Leistung im AnTuTu 3DBench an.

Erste Prozessoren auf Basis der Arm Lumex CSS Platform mit C1-CPU-Cluster sollen Gerüchten zufolge noch dieses Quartal angekündigt werden. Arm kann und darf zwar nicht für Partner sprechen, doch könnte MediaTek schon bald den ersten Schritt machen. Die passenden Smartphones dürften nur wenige Wochen später folgen.

ComputerBase hat Informationen zu diesem Artikel von Arm im Rahmen einer Veranstaltung des Herstellers in Cambridge, UK erhalten. Die Kosten für An-, Abreise und zwei Hotelübernachtungen wurden vom Unternehmen getragen. Eine Einflussnahme des Herstellers oder eine Verpflichtung zur Berichterstattung bestand nicht.

Apps & Mobile Entwicklung

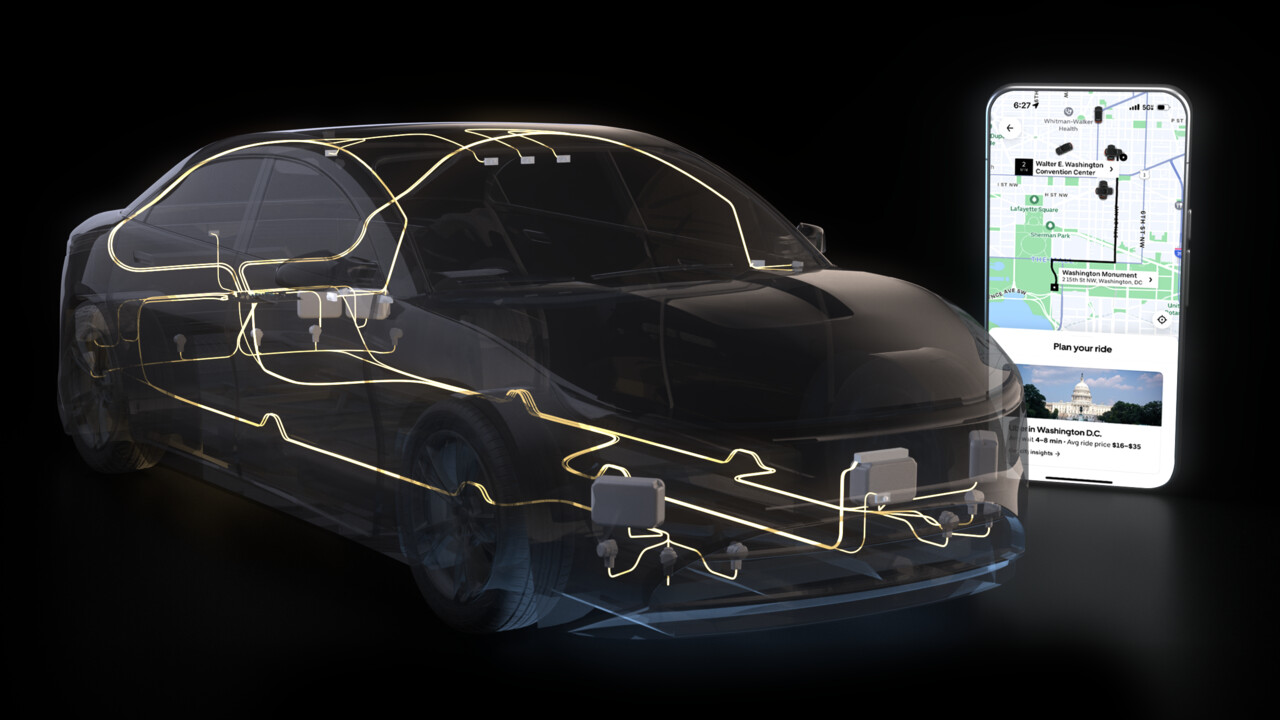

Drive AGX Hyperion 10: Lucid, Mercedes, Uber, Stellantis setzen für Level 4 auf Nvidia

Zum Ableger der GTC in Washington, D.C. hat Nvidia mit Drive AGX Hyperion 10 die nächste Generation der Referenzplattform für autonomes Fahren bis Level 4 vorgestellt. Zusagen gibt es bereits von Lucid, Mercedes-Benz, Uber und Stellantis. Die nächste S‑Klasse soll demnach Level 4 beherrschen. Uber plant eine Robotaxi-Flotte.

Hyperion ist Nvidias Referenzplattform für assistiertes, automatisiertes und autonomes Fahren. Auf die Ankündigung von Hyperion 9 im Frühjahr 2022 folgt jetzt Drive AGX Hyperion 10, die Autoherstellern und OEMs die Umsetzung in Fahrzeugen vereinfachen soll, da Nvidia mit der Referenzplattform bereits eine gewisse Vorarbeit geleistet hat, was Bereiche wie Compute, Sensorik oder Software und Testfahrten anbelangt.

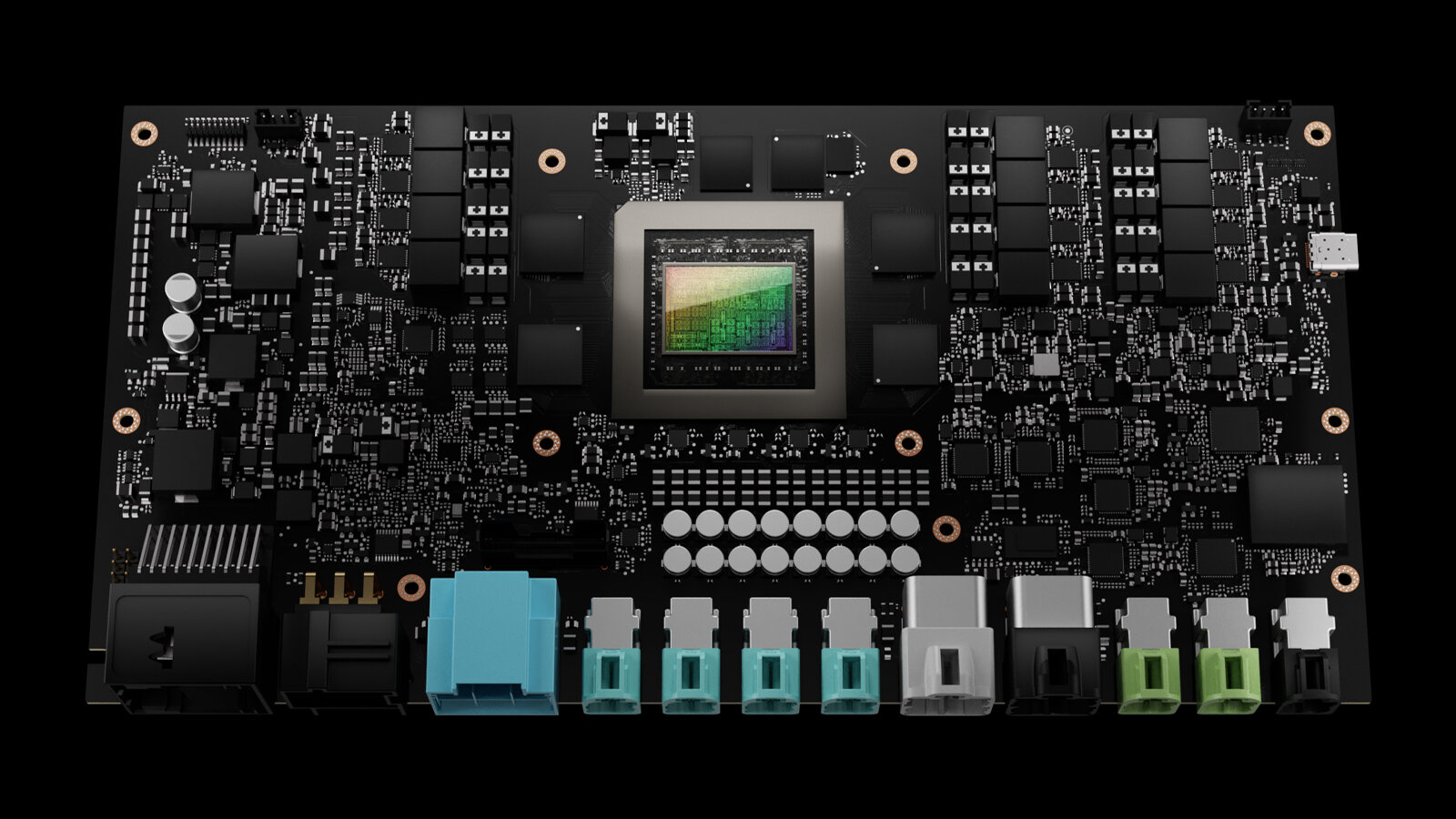

Drive AGX Hyperion 10 für schlüsselfertiges Level 4

Der neueste Ableger setzt beim Thema Compute auf zwei Drive AGX Thor auf Basis der Blackwell-Architektur mit einer kombinierten Rechenleistung von mehr als 4.000 TFLOPS FP4 oder 2.000 TOPS INT8. In den Thor-Chips läuft die rundherum im Fahrzeug verbaute Sensorik wie Kameras, Radar, Lidar, Ultraschall oder Mikrofone zusammen und wird verarbeitet. Die Plattform ist Nvidia zufolge für Transformer- und Vision-Language-Action-Modelle optimiert und für das Fahren mit bis zu Level 4 ausgelegt. Das Level 4 entspricht dem, was zum Beispiel Waymo (Test) anbietet. Das bedeutet „mind off“, also die vollständige Übergabe der Fahraufgabe an die autonomen Systeme des Fahrzeugs, ohne dass – und somit anders als bei Level 3 – die Bereitschaft für einen manuellen Eingriff erhalten bleibt.

Drive AGX Hyperion 10 umfasst aber nicht nur die Rechenleistung, sondern auch eine bereits zertifizierte, multimodale Sensor Suite, die Autoherstellern die Entwicklung vereinfachen soll. Dazu gehören 14 hochauflösende Kameras, 9 Radare, ein Lidar und 12 Ultraschallsensoren. Die Plattform ist Nvidia zufole modular und anpassbar ausgelegt, sodass sie obgleich ihrer Auslegung als Referenzplattform von jedem Abnehmer modifiziert werden kann. Aufseiten der Software kommt Nvidia DriveOS zum Einsatz.

Lucid setzt vollständig auf Nvidia

Ankündigungen durch Partner gab es zur GTC gleich mehrere. Der US-Autohersteller Lucid will den gesamten Hard- und Software-Stack von Nvidia auf Basis der neuen Hyperion-Plattform für die nächste vollständig neue Generation von Fahrzeugen verwenden.

Die nächste S-Klasse beherrscht Level 4

Bei Mercedes-Benz sollen MB.OS und Drive AGX Hyperion für die neue S-Klasse vereint werden. Dabei kann es sich sowohl um die Modellpflege der aktuellen Baureihe 223 (Test) als auch um ein vollständig neues Modell in den Jahren danach handeln. Mercedes-Benz will zuerst in der S-Klasse Level 4 anbietet, nachdem dort aktuell mit dem erweiterten Drive Pilot (Test) das Fahren nach Level 3 mit bis zu 95 km/h ermöglicht wird – schneller geht es derzeit bei keinem Hersteller. Das Unternehmen strebt bis Ende der Dekade das Fahren nach Level 3 mit bis zu 130 km/h an.

Uber und Stellantis setzen auf Hyperion 10

Der Ridehailing-Service Uber wiederum will ab 2027 schrittweise eine Robotaxi-Flotte von 100.000 Fahrzeugen aufbauen, die allesamt auf Basis von Nvidias neuer Plattform nach Level 4 fahren können sollen. Geplant sei eine Flotte aus menschlichen Fahrern und Robotern, wobei der Roboter in diesem Fall das System im Auto selbst ist.

Stellantis, das Unternehmen hinter zahlreichen Automarken wie unter anderem Alfa Romeo, Chrysler, Dodge, Fiat, Citroën, Open oder Peugeot plant in Kooperation mit Foxconn den Einsatz des vollständigen Hard- und Software-Stacks von Nvidia. Entsprechende Fahrzeuge können damit dann auch Teil der Uber-Flotte werden.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

Apps & Mobile Entwicklung

Holzheizung könnte bald nicht mehr grün sein!

Ein vertrautes Heizsystem steht plötzlich am Pranger. Laut einer neuen Einschätzung des Umweltbundesamts soll Holz nicht länger als klimaneutral gelten. Was steckt hinter dieser Entscheidung – und was bedeutet sie für Millionen von Euch?

Holz galt bislang als Inbegriff der Nachhaltigkeit. Doch laut Umweltbundesamt ist das nur bedingt richtig – mit potenziell weitreichenden Folgen für mehr als 11 Millionen Heizungen in Deutschland. Viele von Euch setzen beim Heizen auf Holz oder Pellets, weil Ihr damit unabhängig bleiben wollt – und weil es sich einfach richtig anfühlt, mit einem nachwachsenden Rohstoff zu heizen. Doch genau dieses Selbstverständnis gerät jetzt ins Wanken. Eine neue Analyse im Auftrag des Umweltbundesamts (UBA) zieht die Klimaneutralität von Holzenergie ernsthaft in Zweifel. Die Aufregung ist groß – und das aus gutem Grund.

Das Umweltbundesamt rüttelt an einem Grundpfeiler der Energiewende

Das UBA hat das Institut für Klimaschutz, Energie und Mobilität (IKEM) mit einem juristischen Kurzgutachten zur „Klimawirkung der energetischen Holznutzung“ beauftragt. Dessen Ergebnis sorgt für Sprengstoff: Strom und Wärme aus Holz sollen demnach nicht uneingeschränkt als erneuerbare Energien im Sinne der Pariser Klimaziele gelten. Der Grund: Es fehle an einer einheitlichen Definition, was überhaupt als nachhaltige Biomasse zu werten sei.

Damit stellt das Umweltbundesamt eine ganze Branche infrage. Denn Holz und seine Derivate – etwa Pellets oder Hackschnitzel – gelten in Deutschland bislang als zentrale Säule der Wärmewende. In Millionen Haushalten sorgen sie für Wärme und gelten als klimafreundliche Alternative zu Öl und Gas. Doch laut UBA soll das künftig nur noch dann gelten, wenn strenge Nachhaltigkeits- und Treibhausgas-Kriterien erfüllt sind – etwa durch zertifizierte Waldbewirtschaftung oder lückenlose Herkunftsnachweise.

Die Idee der Kaskadennutzung – Holz mehrfach verwenden, bevor es im Ofen landet

Ein zentraler Punkt der UBA-Analyse ist die sogenannte Kaskadennutzung. Das Prinzip dahinter: Holz soll so lange wie möglich stofflich genutzt werden, bevor es am Ende seines Lebenszyklus verbrannt wird. Praktisch bedeutet das: Erst wird es zu Bauholz, Möbeln oder Werkstoffen verarbeitet. Wenn diese Produkte nicht mehr genutzt werden können, kann das Material weiterverwendet werden – etwa für Spanplatten oder Papier. Erst danach steht die energetische Nutzung, also das Verbrennen, um Wärme oder Strom zu erzeugen.

Auf diese Weise bleibt das im Holz gespeicherte CO₂ länger im Umlauf und ersetzt mehrfach fossile Ressourcen. Dieses Prinzip gilt seit Jahren als Leitlinie nachhaltiger Holzwirtschaft. Das Umweltbundesamt argumentiert nun jedoch, dass das allein nicht ausreiche, um die Klimawirkung von Holz als neutral einzustufen. Denn insbesondere, wenn große Mengen an Pellets oder Hackschnitzeln über weite Strecken transportiert werden, verschlechtert das die Bilanz erheblich. Transporte über den Atlantik – etwa von Nordamerika nach Europa – verursachen erhebliche Emissionen, die bei der Gesamtbewertung oft unter den Tisch fallen.

Im Umkehrschluss bedeutet das: Regional geschlagenes Holz bleibt klimafreundlicher, da die Transportwege kurz sind. Doch Holz generell die Nachhaltigkeit abzusprechen, halten viele Fachleute für zu pauschal.

Empörung in der Holzenergie-Branche

Beim Fachverband Holzenergie (FVH) stößt die Einschätzung auf scharfe Kritik. Die Vorsitzende Marlene Mortler spricht topagrar gegenüber von einer „ideologisch motivierten Veröffentlichung“, die in die Hände der fossilen Energiewirtschaft spiele. Das Umweltbundesamt mache damit, so Mortler, „den Job der fossilen Energiewirtschaft“ im Kampf gegen die Holzindustrie.

Der Verband weist darauf hin, dass Holzenergie im vergangenen Jahr rund 32 Millionen Tonnen CO₂ eingespart habe – allein durch den Ersatz fossiler Energieträger. Zahlen, die das UBA selbst ermittelt und zur Verfügung gestellt hat. Holz, so die Argumentation, sei und bleibe ein wichtiger Bestandteil der Wärmewende. Neue Regulierungen würden das Gegenteil bewirken: mehr Bürokratie, weniger Investitionen und eine Verunsicherung der Verbraucher, die gerade erst Vertrauen in klimafreundliche Heizformen gefasst haben.

Das UBA verteidigt sich mit dem Hinweis, man wolle klare Standards schaffen, keine Panik verbreiten. Die Verantwortung liege darin, die Holzverwendung besser zu regulieren, um Missbrauch und unfaire Subventionierung zu verhindern. Doch in der Praxis dürfte genau das eintreten, was viele fürchten: ein unübersichtlicher Regeldschungel, der eher abschreckt, als hilft.

Wenn Holz nicht mehr als nachhaltig gilt – drohen massive Folgen

Die Einschätzung des Umweltbundesamts könnte weitreichende Konsequenzen haben – sowohl für Hausbesitzer als auch für Betriebe. Sollte Holz offiziell nicht mehr als nachhaltiger Energieträger gelten, könnte das auch das Gebäudeenergiegesetz (GEG) betreffen. Dieses verlangt, dass Heizsysteme zu mindestens 65 Prozent mit erneuerbaren Energien betrieben werden. Wird Holz diese Eigenschaft abgesprochen, verlieren Millionen Heizungen ihre gesetzliche Grundlage.

In der Praxis hieße das: Nur noch Holz oder Pellets, die nachweislich aus nachhaltiger, meist lokaler Produktion stammen, könnten verwendet werden. Und das dürfte teuer werden. Denn Importe aus dem Ausland, die bislang einen großen Teil des Pelletmarktes abdecken, fielen dann als günstige Option weg. Auch Industrieanlagen, die große Mengen Holz oder Holzreste nutzen, wären betroffen.

Damit wächst das Risiko eines Dominoeffekts: höhere Brennstoffpreise, Unsicherheiten bei der Förderung und Verunsicherung unter den Holzheizungsbesitzern. All das, während viele Haushalte gerade erst in Holzheizungen investiert haben – in gutem Glauben, etwas Nachhaltiges zu tun.

Ein Schritt in Richtung Klarheit – oder ein Eigentor?

Das Umweltbundesamt betont, es gehe nicht darum, Holzenergie abzuschaffen, sondern ihre Rolle im Klimaschutz neu zu bewerten. Doch der Zeitpunkt und die Tonlage der Veröffentlichung lassen viele zweifeln. Nach der Verunsicherung um das Heizungsgesetz könnte die aktuelle Diskussion das Vertrauen in die Wärmewende erneut erschüttern.

Holz war lange das Symbol für eine greifbare Energiewende im Alltag – warm, regional, bezahlbar. Wird diese Säule nun wackelig, droht mehr als nur eine politische Diskussion: Es geht um Glaubwürdigkeit. Und um die Frage, wie Deutschland künftig mit einem Rohstoff umgeht, der seit Jahrhunderten Teil seiner Energiegeschichte ist.

Was Ihr als Holzheizungsbesitzer jetzt wissen solltet

Noch ist nichts entschieden. Das Gutachten ist eine Einschätzung, keine Gesetzesänderung. Dennoch ist klar: Die Diskussion hat begonnen, und sie wird nicht schnell verstummen. Informiert Euch, achtet auf regionale Herkunft und Zertifizierungen Eures Brennstoffs – und verfolgt die Debatte aufmerksam.

Eines steht fest: Wer mit Holz heizt, steht künftig mehr im Fokus – und muss sich darauf einstellen, dass Nachhaltigkeit vielleicht nicht mehr selbstverständlich anerkannt wird. Ob das sinnvoll ist oder nicht, wird sich zeigen. Aber eines ist sicher: Diese Diskussion wird die Heizpolitik in Deutschland noch lange beschäftigen.

Apps & Mobile Entwicklung

OpenAI und PayPal: Produkte in ChatGPT direkt mit PayPal einkaufen

Ein weiterer Schritt für ChatGPT auf dem Weg zur Shopping-Plattform: OpenAI und PayPal haben eine Partnerschaft verkündet. Der Bezahldienst wird ab dem nächsten Jahr direkt in ChatGPT integriert, Nutzer können dann Bezahlvorgänge direkt innerhalb des Chatbots abwickeln.

PayPal wird in ChatGPT den gewohnten Funktionsumfang bieten. Einkäufe lassen sich über das Bankkonto, das PayPal-Guthaben oder Kreditkarten bezahlen, hinzu kommt der Käufer- und Verkäuferschutz sowie Servicefunktionen wie die Sendungsverfolgung und Streitbeilegung.

Bei den Händlern, die Produkte innerhalb von ChatGPT verkaufen, läuft die Zahlungsabwicklung ebenfalls wie gewohnt.

Neue Schnittstelle für Chatbot-Käufe

Abgewickelt wird die PayPal-Integration über das Agentic Commerce Protocol (ACP), das OpenAI im September vorgestellt hat. Entwickelt wurde es gemeinsam mit dem Zahlungsdienstleister Stripe. Händler und Plattformen können damit direkt an ChatGPT andocken.

Den Anfang bei der Integration machte der Online-Marktplatz Etsy. Den konnten ChatGPT-Nutzer in den USA mit den Abo-Paketen Plus, Pro und Free bereits seit dem Start der ACP-Schnittstelle nutzen. Shopify soll folgen.

Am Anfang werden nur Direktkäufe unterstützt, weitere Funktionen wie Warenkörbe mit mehreren Artikeln sowie eine größere Händlerauswahl und mehr Regionen wurden im September bereits in Aussicht gestellt. ChatGPT ist laut OpenAI in diesem Prozess lediglich KI-Agent des Benutzers. Der Chatbot übermittelt Informationen zwischen Benutzer und Händler, heißt es in der Mitteilung vom September.

Für Nutzer ist der Dienst kostenlos, Händler müssen eine laut OpenAI „kleine Gebühr“ zahlen.

OpenAI als Shopping-Plattform

Eine Auswahl an Produkten zeigt ChatGPT jetzt schon an. Wird nach aktuellen Grafikkarten gefragt, erhalten Käufer eine Übersicht. OpenAI erklärt in der Mitteilung, die Auswahl der Produktergebnisse basiere auf einer organischen Suche und sei nicht gesponsort.

Wird das Produktbild angeklickt, landet der Käufer bis dato aber beim jeweiligen Online-Shop. Künftig ist so eine Weiterleitung nicht mehr nötig, der komplette Einkauf lässt sich innerhalb von ChatGPT abwickeln. Nutzer müssen die App nicht mehr verlassen.

Für OpenAI ist es also ein weitreichender Schritt, um das Shopping innerhalb von ChatGPT zu erleichtern. Das Ziel ist klar: Man will den Chatbot immer mehr im Alltag der Nutzer verankern. Es ist ein weiterer Baustein des Geschäftsmodells, das bislang vor allem auf Abo-Einnahmen und den API-Gebühren von Unternehmen basiert.

PayPal ist für OpenAI als Partner besonders attraktiv, der Bezahldienst zählt zu den populärsten. Weltweit kommt PayPal auf rund 430 Millionen Nutzer, in Deutschland sind es 32 Millionen aktive Konten. ChatGPT hatte Anfang Oktober 800 Millionen wöchentliche Nutzer.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenIllustrierte Reise nach New York City › PAGE online

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets