Künstliche Intelligenz

Guter Mini-PC zum starken Preis: Bosgame P4 Plus mit Ryzen 7 für 225 € im Test

Der Bosgame P4 Plus bietet viel Leistung zum kleinen Preis: Bereits ab 225 Euro gibt es das Mittelklasse-System mit Ryzen 7, USB-C-Port, Wi-Fi 6E und 2x LAN.

Die Mittelklasse bei den Mini-PCs ist hart umkämpft und viele Hersteller werfen zahlreiche Modelle in den Ring. Dabei robbt diese Preisklasse kostenseitig immer weiter Richtung 200 Euro herunter – wofür auch Systeme, wie der Bosgame P4 Plus verantwortlich sind. Denn mit seinem Ryzen 7 5825U, 16 GB Arbeitsspeicher (RAM) sowie einer 512 GB großen NVMe-SSD kostet er aktuell lediglich 225 Euro. Das ist für diese Ausstattung ein absoluter Kampfpreis, zumal der PC auch anschlussseitig überzeugt. Was er sonst kann und wie gut er am Ende wirklich ist, zeigen wir im Test.

Das Testgerät hat uns Bosgame zur Verfügung gestellt.

Ausstattung: Welche Hardware bietet der Bosgame P4 Plus?

Der Bosgame P4 Plus setzt wie viele günstige Mini-PCs auf den Ryzen 7 5825U, der Anfang 2022 vorgestellt wurde und auf acht Kerne bei 16 Threads setzt. Die CPU ist im 7-nm-Prozess bei TSMC gefertigt, auf Basis der Zen-3-Architektur (Barcelo-U). Er taktet zwischen 2,0 und 4,5 GHz und kommt mit einer TDP (thermischen Verlustleistung) von 15 Watt sowie einer maximalen Betriebstemperatur von 95 Grad. Als integrierte Grafikeinheit verrichtet eine Radeon RX Vega 8 mit einem Takt von bis zu 2000 MHz ihren Dienst.

Beim Speicher setzt Bosgame auf wahlweise 16 oder 32 GB an DDR4-RAM. In unserem Fall ist es die 32-GB-Variante, die sich aus zwei 16 GB große SO-DIMM-Module von Vickter Electronics, die mit 3200 MT/s arbeiten. Schnellerer DDR5-RAM wird chipseitig vom Speichercontroller nicht unterstützt. Die in unserem System 1 TB große NVMe-SSD mit PCIe-4.0 kommt von Kingston. Sie liest mit 3653 MB/s und schreibt mit 2872 MB/s. Das ist ordentlich, aber nicht herausragend.

Die Anschlussausstattung ist gut, neben vier USB-A-Buchsen gibt es einmal USB-C (Daten und Bild), 2x 2,5G-LAN sowie HDMI und Displayport. Insbesondere für den niedrigen Preis kann sich das sehen lassen, hier sparen viele Konkurrenten an der Auswahl. Die Stromversorgung kann nicht per USB-C erfolgen, sondern über einen klassischen Rundhohlstecker vom mitgelieferten 65-W-Netzteil. Drahtlos stehen Wi-Fi 6E sowie Bluetooth 5.2 zur Verfügung, was ebenfalls für diesen Preisbereich sehr gut ist. Als WLAN-Controller kommt ein Intel AX210 zum Einsatz.

Performance: Wie schnell ist der Bosgame P4 Plus?

Der Bosgame P4 Plus gehört im Bereich der Mini-PCs zu den Mittelklasse-Modellen. Im Bürobenchmark PCmark 10 zeigt er dies auch mit einer durchschnittlichen Punktzahl von 5714 Punkten mit Spitzen bei 5558 und 5816 Punkten. Damit liegt er fast auf Augenhöhe mit dem ähnlich ausgestatteten Aliwava U58 (Testbericht). Im Benchmark 3Dmark Time Spy kann er diesen sogar leicht übertreffen und erreicht 1552 Punkte insgesamt, welche sich aus 1362 GPU-Punkten und 7458 CPU-Punkten zusammensetzen.

Weiter geht es mit dem CPU-Benchmark Cinebench 2024, wo der P4 Plus im Single-Core auf 86 Punkte und im Multi-Core auf 599 Punkte kommt. Beim Cross-Plattform-Benchmark Geekbench schafft das System 1957 Punkte (Single-Core) und 8305 Punkte (Multi-Core).

Bosgame P4 Plus – Bilderstrecke

Kommen wir zu der Spieleleistung, wo der Bosgame P4 Plus sicher kein Paradebeispiel wird, das ist aber auch für den Preisbereich nicht zu erwarten. Wir testen in Full HD. Anno 1800 läuft mit niedrigen Optionen und mit dem aktivierten Upsampler FSR (AMD Fidelity FX Super Resolution) im Modus „Ausgewogen“ zwischen 26 und 32 FPS. Im grafisch weniger ansprechenden Modus „Leistung“ werden daraus 32 bis 36 FPS. Ohne FSR gibt es größere Framedrops und das Spiel läuft zwischen 12 und 19 FPS, was im Gegensatz zu der nicht berauschenden Performance mit FSR eher unspielbar ist.

Das Städtebauspiel Cities Skylines 2, das nach wie vor sehr anspruchsvoll ist, läuft mit aktivem FSR und niedrigen Grafikoptionen mit nur 12 FPS. Das ist unspielbar und auch die optischen Details gehen hier selbstredend verloren. Counter Strike 2 läuft unter niedrigen Optionen und aktivem FSR (Modus Ausgewogen) immerhin mit bis zu 85 FPS auf Dust 2, leidet aber an starken Framedrops, die den Ego-Shooter ebenfalls unspielbar machen.

Lüfter: Wie laut ist der Bosgame P4 Plus?

Der Lüfter im Bosgame P4 Plus läuft durchgehend, auch ohne Last, und verursacht dabei eine konstante Lautstärkeemission von 33 dB(A). Unter Last steigt die Lautstärke auf 36 dB(A). Der CPU-Takt pendelt sich in einem Stresstest zwischen 2,9 und 3,0 GHz ein, nachdem er wenige Sekunden lang bei 4,5 GHz lag. Der Stromverbrauch liegt dann bei 48 W, die Temperatur verharrt bei 73 Grad. Ohne Last sinkt der Verbrauch auf 10 W ab, bei Verwendung von Anwendungen im Alltag liegt er bei 20 bis 25 W.

Software: Mit welchen Betriebssystemen arbeitet der Bosgame P4 Plus?

Auf dem Bosgame P4 Plus ist Windows 11 Pro installiert, wobei direkt zu Beginn ein großer Schwung Updates zu installieren ist. Insbesondere das Funktionsupdate von 22H2 auf 24H2 nimmt viel Zeit in Anspruch. Der Betrieb von Linux gelingt im Test denkbar einfach. Das System wählt automatisch beim Start den neu angeschlossenen USB-Stick aus und bootet diesen. In unserem auf Ubuntu basierenden Testsystem Tuxedo OS funktioniert alles wie vorgesehen: Die Auflösung ist richtig, WLAN, Bluetooth und Audio funktionieren – und selbst aus dem Standby-Modus erwacht das System, wenn auch etwas behäbig. Bei vielen Mini-PCs ist insbesondere das Aufwecken aus dem Standby ein Problem. Wer ins AMI-BIOS muss, kommt via F7-Taste oder über die erweiterten Wiederherstellungsoptionen von Windows dorthin. Lüfterprofile sind nicht hinterlegt. Die Geräteauswahl ist per Backspace-Taste erreichbar. Secure Boot ist standardmäßig deaktiviert.

Bauform: Wie ist die Verarbeitung des Bosgame P4 Plus?

Der Bosgame P4 Plus ähnelt in seinem grundlegenden Gehäuseaufbau Modellen, wie dem Trigkey S5 oder dem Ninkear N9. Vorn prangt der große, auffällig rote Ein-/Aus-Button. Das Gehäuse besteht weitestgehend aus schwarzem Kunststoff, der sich hochwertig anfühlt. Das Material ist auf der Oberseite mit einem schicken Muster durchzogen, was den PC gleich hochwertiger wirken lässt. Das Lüftergitter erstreckt sich von der linken Gehäuseseite über die Oberseite bis zur rechten Seite und nimmt dabei rund zwei Drittel der jeweiligen Seite ein. Damit gibt es viel Fläche für Luftzufuhr und Abtransport von Wärme.

Das Öffnen des Gehäuses gestaltet sich zunächst nicht allzu kompliziert: vier Schrauben auf der Unterseite lösen und die Bodenplatte mittels Gummilasche (sehr gut) vom Gehäuse ziehen. Dann allerdings folgt das böse Erwachen, denn ein großflächiger Kühlkörper mit Lüfter versperrt den Weg zur Hardware. Erst nachdem dieser aufwendig entfernt ist, gelangt man an RAM und SSD. So wichtig Kühlung auch ist, eine derart der Wartung nachteilige Umsetzung ist unschön – das bekommen andere Hersteller schon besser hin.

Preis: Was kostet der Bosgame P4 Plus?

Der Bosgame P4 Plus kostete zuletzt etwa 320 Euro. Momentan ist er in unserer Testausstattung aber bereits zum Preis von 299 Euro erhältlich, die Basisausstattung mit 16/512 GB kostet sogar nur 225 Euro – ein absoluter Kampfpreis.

Fazit

Der Bosgame P4 Plus fällt im Test auf mit seinem schlichten, aber schicken Design, das durch kleine Akzente, wie der texturierten Oberseite gefällt. Auch die Leistung stimmt und kann mit der ähnlich aufgestellten Konkurrenz überzeugen. Gleiches gilt für die Anschlussausstattung sowie die Drahtlosstandards, die für den Preisbereich überdurchschnittlich gut aufgestellt sind. Nachteilig ist der durchgehend laufende Lüfter, was für den Betrieb im Idle unnötig ist. Dafür wird das System unter Last nicht mehr viel lauter und bleibt noch im angemessenen Lautstärkebereich. Die Wartung oder ein Austausch der Komponenten, wie RAM und SSD, gestaltet sich zudem schwerer als bei Konkurrenten.

Allen voran spricht aber der enorm gute Preis für den Bosgame P4 Plus. Dieser liegt zum Testzeitpunkt bei attraktiven 225 Euro für die 16-GB-Variante. Das ist eine absolute Ansage für ein hervorragendes Mittelklasse-System. Im Test gibt es viereinhalb von fünf Sternen abzüglich unserer Kritikpunkte.

Künstliche Intelligenz

Verband: Deutschland liegt beim Quantencomputing zwei bis drei Jahre zurück

Führende Experten auf dem Gebiet der Quantentechnologien ziehen ein gemischtes Fazit zum Stand Deutschlands auf diesem Zukunftsgebiet. Die Zusammenarbeit zwischen Grundlagenforschung und jungen Unternehmen funktioniere in etablierten regionalen Ökosystemen wie München, Stuttgart/Ulm, Jülich und Braunschweig sehr gut, betonen die Wissenschaftler in einem Positionspapier, das der Elektrotechnik- und IT-Verband VDE im Vorfeld des Kongresses MikroSystemTechnik in Duisburg veröffentlicht hat. Erste Produkte für Quantensensorik und IT-Sicherheit seien bereits auf dem Markt. Im internationalen Vergleich liege Deutschland beim Quantencomputing allerdings zwei bis drei Jahre zurück.

Weiterlesen nach der Anzeige

Die größte Herausforderung ist laut der Analyse derzeit nicht primär technologischer Natur, sondern die zurückhaltende Nachfrage und das mangelnde Wissen aufseiten der Anwender in vielen Branchen. Zudem bewerten die Insider die Forschungsförderung, insbesondere mit Blick auf die Abstimmung zwischen den beteiligten Ministerien, als nicht immer kohärent und zielgerichtet genug. Jenseits der Schwächen bei Quantenrechnern befinde sich Deutschland bei der Quantensimulation, der Quantenkommunikation mit ersten Versuchsnetzen sowie der Quantensensorik auf Augenhöhe mit der internationalen Spitze.

„Die Quantentechnologien machen derzeit erkennbare Fortschritte“, schreiben die Verfasser. Aber der Weg zu erfolgreichen, auch massentauglichen Produkten sei lang: „Wir brauchen einen langen Atem.“ Aus dem Status quo leiten die Experten, denen auch Führungskräfte aus Konzernen wie IBM, Infineon, Bosch und Trumpf angehören, sieben Impulse ab. Diese sollen helfen, die Wettbewerbsfähigkeit zu sichern und Deutschland bis 2026 als führenden Standort für industrielle Anwendungen im Quantensektor zu etablieren.

Ruf nach nationaler Quanteninitiative

Die Zuständigen in Politik, Wissenschaft und Wirtschaft sollen demnach eine von allen getragene „Moonshot“-Vision und Technologie-Fahrpläne mit messbaren Zielen entwickeln. Es gelte, die regionalen Quanten-Ökosysteme strategisch zu stärken. Öffentlich geförderte Pilotlinien müssten mit Einbindung der Wirtschaft betrieben werden, der Staat soll als Ankerkunde und durch Forschungskäufe den Markt fördern. „Das heißt zum Beispiel, dass darin geförderte Hightech-Infrastrukturen nach festgelegten Regeln auch für andere Projekte niederschwellig zugänglich sind“, erklärt Thomas Becks vom VDE. „So können wir Investitionsmittel effizient einsetzen.“

Die Förderung soll fokussierter, kohärenter und thematisch auf kritische Pfade ausgerichtet werden. Eine Trennung von Hard- und Software nach Ressorts sei zu vermeiden, ist dem Papier zu entnehmen. Die Mittelvergabe müsse auf messbaren Zielen basieren, um Projekte agil anpassen oder bei Misserfolg ohne Sanktionen stoppen zu können. Zudem seien Anreize für etablierte Unternehmen und eine intensivierte, finanziell aufgestockte Startup-Förderung nötig.

Deutschland müsse im globalen Wettbewerb um exzellente Wissenschaftler und Nachwuchs durch attraktive Angebote und die Reduzierung bürokratischer Hürden punkten, fordern die Fachleute. Die größte Herausforderung sei die Akzeptanz. Neue Veranstaltungsformate und die finanzielle Unterstützung für Erstanwendungen in der Industrie sollen die Nachfrage stimulieren und Lernkurven ermöglichen. Auch die aktive Begleitung der Standardisierung und Normung sei essenziell, insbesondere bei der Integration von Quantentechnologien in bestehende Systeme wie das Internet der Dinge oder Hochleistungsrechnen.

Weiterlesen nach der Anzeige

Die Verfasser schlagen vor, eine nationale Quanteninitiative aufzubauen. Diese müsse alle relevanten Fachdisziplinen und Unternehmensgrößen einbinden. Ein solcher Schritt könne die erforderliche Koordination und eine Roadmap liefern.

()

Künstliche Intelligenz

Fedora Linux 43: Adieu X11, Hallo WebUI

Zwar ist Fedora um weitreichende Umbauten an der Linux-Distribution nie verlegen, doch haben die beiden signifikanten Änderungen zur jetzt veröffentlichten Version 43 weiteren Vorlauf benötigt und im Falle der entfernten X11-Unterstützung in Gnome zu internen Diskussionen geführt. Mit Fedora Linux 43 ist die Gnome-Session ab jetzt nur noch mit Wayland als Display-Protokoll verfügbar – ein optionales Paket zum Nachrüsten einer X11-Session gibt es nicht mehr. Denn Gnome und seine Komponenten sind hier nun ganz ohne X11 kompiliert – eine Möglichkeit dieser Desktop-Umgebung ab Gnome Version 47. Die Reduktion auf Wayland sollte zunächst auch den Display-Manager GDM zur Anmeldung betreffen, welcher ohne X11-Unterstützung auch keine anderen, zusätzlichen installierten Desktop-Umgebungen mit diesem Protokoll mehr starten könnte. So wie Ubuntu verzichtete Fedora deshalb auf den letzten Schritt und belässt X11 bis Fedora 49 in GDM, damit Anwender mit mehreren installierten Desktops neben Gnome vorerst nicht auf einen anderen Display-Manager wie LightDM ausweichen müssen.

Weiterlesen nach der Anzeige

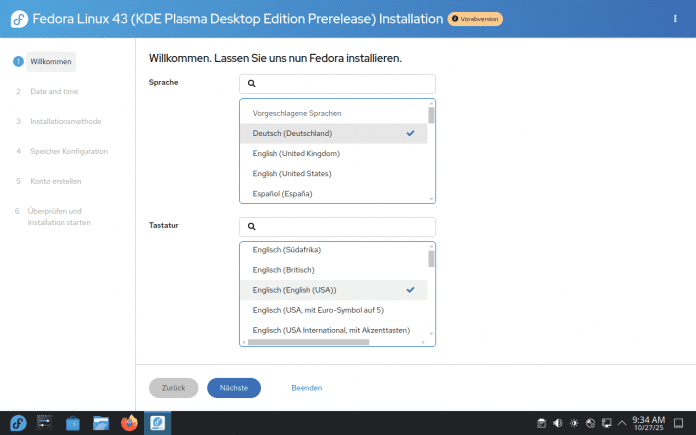

Anaconda in neuem Gewand

Der Installer Fedoras, genannt Anaconda, fiel immer schon mit einer ungewöhnlichen Benutzerführung auf, die keine linearen Menüs präsentiert, sondern Untermenüs für die einzelnen Schritte wie Partitionierung, Benutzerkonto sowie Netzwerkverbindungen zeigt. Zuletzt bekam Anaconda in Fedora 26 mit dem alternativen Partitionierer Blivet eine größere Ergänzung, die fortgeschrittenen Anwendern detaillierte Einstellungen beim Anlegen neuer Partitionen bot. Jetzt zieht Fedora mit dem neuen Installer WebUI die lange bekannten Probleme der Anaconda-Oberfläche glatt. WebUI basiert auf HTML, Javascript sowie Python und setzt ein lineares, intuitiveres Frontend vor Anaconda, das den gewohnten Installationswegen anderer Linux-Distributionen ähnlicher ist.

Diese Oberfläche zur Installation war schon in der Gnome-Ausgabe von Fedora 42 zu sehen. Nun ist der neue, lineare Installer auch der Standard in der KDE-Version und den anderen Fedora-Spins geworden.

(Bild: Screenshot David Wolski)

Mit einer neuen Option zur Reinstallation kann WebUI das System außerdem über ein bestehendes erneut installieren, behält dabei aber die bereits vorhandenen Daten in den Home-Verzeichnissen. Sein Debüt hatte der neue Installer, der seit Fedora 37 in Entwicklung ist, schon in der vorherigen Ausgabe. Allerdings nur in der Gnome-Version Fedoras, während jetzt der neue Installer auch bei KDE Plasma und den Fedora-Spins der Standard ist. Kleine Unterschiede gibt es dabei im Installer der Gnome-Ausgabe: Die Erstellung des ersten Benutzerkontos erfolgt in Gnome nach dem ersten Boot des installierten Systems, bei den anderen Fedora-Ausgaben gleich in der WebUI. In den kommenden Ausgaben wird WebUI auch die Server-Ausgabe, die Netzwerk-Installationsmedien und die Immutable-Ausgaben installieren und das bisherige GTK4-Frontend für Anacoda ab Fedora 46 komplett ersetzen. Der Aufbau als App mit Web-Techniken soll überdies die Installation Fedora in Cloud-Instanzen über Remote-Verbindungen im Browser erleichtern.

Boot-Partition und initiale Ramdisk

Einfacher ist auch die automatische Partitionierung geworden, bei welcher Fedora von Haus ein btrfs-Volumes mit dem Home-Verzeichnis als Subvolumes anlegt, mit einer aktivierten Komprimierung per Zstandard und sehr niedriger Kompressionsstufe. Dieses Verfahren soll keinen Speicherplatz sparen, sondern die Schreibvorgänge für Flash-Datenträger messbar reduzieren. Im EFI-Modus verlangt Fedora nun stets nach einem Datenträger mit GPT als Partitionstabelle und akzeptiert keinen Master Boot Record mehr. Diese Kombination ist zwar seitens der EI-Spezifikation möglich, machte in der Praxis mit UEFI-Implementierungen verschiedener Hersteller immer wieder Probleme. Wer Fedora einige Versionen schon per Paketmanager DNF auf neue Ausgaben aktualisiert hat, kennt in vielen Fällen auch die Fehlermeldung über eine zu kleine /boot-Partition beim Entpacken neuer Kernel-Pakete. Die separate Boot-Partition dehnt Fedora deshalb bei Neuinstallation auf 2 GByte aus, um größere initiale Ramdisk, die weiterhin experimentellen Unified Kernel Images (UKIs) und mehr Firmware aufnehmen zu können. Für initiale Ramdisks nutzt Fedora nicht mehr den Packer XZ, sondern Zstandard, um einen Neustart ein paar Sekunden schneller absolvieren zu können. Das Paketformat aktualisiert Fedora auf RPM 6.0, das mehrere Signaturen pro Paket erlaubt, die Verwaltung der OpenPGP-Schlüssel aus Repositorys vereinfacht und lokal gebaute, eigene RPM-Paket automatisch signieren kann.

Desktops: Fedora in vielen Varianten

Weiterlesen nach der Anzeige

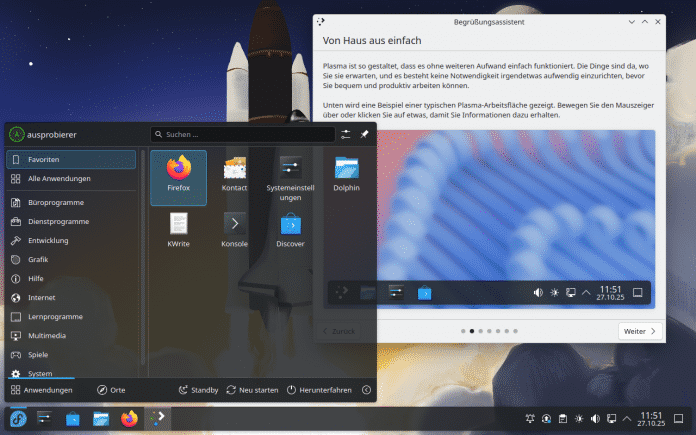

Der Kernel ist in Version 6.17, wie bei Fedora zu erwarten, auch hier wieder sehr jung. Im Laufe des Unterstützungszeitraums bis Dezember 2026 werden die Entwickler auch mindestens noch die kommende Kernel-Version 6.18 nachschieben. Die GNU-Toolchain hat Fedora auf Gcc 15.2 und Glibc 2.42 gehievt. Python-Entwickler bekommen den Interpreter in Version 3.14 vorinstalliert, das wieder einige Methoden als veraltet markiert oder bereits entfernt hat. Zur Abwärtskompatibilität gibt es weiterhin Python 3.13 in den Paketquellen. Wie immer gibt es Fedora auch mit anderen Desktops als mit Gnome 49 und KDE Plasma 6.5 in den Hauptversionen.

Seit Fedora 42 ist die KDE-Ausgabe, nun mit Plasma 6.5 ausgestattet, zur Hauptausgabe neben Gnome befördert. Automatischer Theme-Wechsel und abgerundete Kanten sind die Highlights dieser Plasma-Version.

(Bild: Screenshot David Wolski)

Installierbare Live-Systeme gibt es als „Spins“ auch wieder mit den schlankeren Arbeitsumgebungen von XFCE, LXQT, LXDE und Mate. Zudem gibt als Alternative zu Gnome auch das von Linux Mint bekannte Cinnamon, Budgie und auch schon eine Vorabversion des neuen Rust-Desktops Cosmic, der aktuell von System76 entwickelt wird. Auch diese Versionen liegen nicht nur für die x86-64Architektur vor, sondern auch für ARM.

Der aktuelle Stand der wichtigsten Unix- und Linux-Distributionen:

(dmk)

Künstliche Intelligenz

KanDDDinsky 2025: Eindrücke von Europas DDD-Community-Konferenz

Vergangene Woche waren mein Kollege Rendani und ich im Berliner nhow Hotel, zusammen mit rund 250 bis 300 anderen Menschen, die unsere Leidenschaft für Domain-Driven Design (DDD), Event Sourcing und durchdachte Softwarearchitektur teilen. Auf der KanDDDinsky 2025 war unsere erste Teilnahme an dieser Konferenz – nicht nur als Besucher, sondern als Sponsoren und Aussteller für die von uns entwickelte Datenbank EventSourcingDB.

Weiterlesen nach der Anzeige

Ein anderes Konferenzformat

Was uns sofort ins Auge fiel, war die Herangehensweise an die Zeitplanung. Statt des typischen Konferenzformats mit einheitlichen Session-Längen schufen die Organisatoren eine Puzzle-artige Agenda, die 50-minütige Vorträge mit 120-minütigen Hands-on-Workshops kombinierte. Die Sessions liefen in vier parallelen Tracks.

Golo Roden ist Gründer und CTO von the native web GmbH. Er beschäftigt sich mit der Konzeption und Entwicklung von Web- und Cloud-Anwendungen sowie -APIs, mit einem Schwerpunkt auf Event-getriebenen und Service-basierten verteilten Architekturen. Sein Leitsatz lautet, dass Softwareentwicklung kein Selbstzweck ist, sondern immer einer zugrundeliegenden Fachlichkeit folgen muss.

Dieses Format eröffnet interessante Wahlmöglichkeiten für die Teilnehmerinnen und Teilnehmer. Theoretisch ließ sich zwar zwischen Sessions wechseln, praktisch sah die Sache jedoch anders aus. Einen zweistündigen Workshop auf halbem Weg zu verlassen, um einen Vortrag mitzunehmen, ergibt nur bedingt Sinn – auch wenn wir beobachteten, dass einige Teilnehmer sich leise zur Halbzeit aus Vorträgen verabschiedeten, um eine andere Session zu besuchen. Eine elegante Lösung, die sowohl tiefgehende Einblicke als auch schnellen Wissensaustausch ermöglicht – etwas, das uns in dieser Form auf anderen Konferenzen bisher nicht begegnet ist.

Ebenso durchdacht war die viertägige Struktur: Workshops am Dienstag (21. Oktober), die Hauptkonferenz am Mittwoch und Donnerstag (22.-23. Oktober) und ein Open Space am Freitag (24. Oktober). Diese Progression von fokussiertem Lernen über breite Exploration bis hin zu Community-getriebener Konversation zeigt, wie sorgfältig die Organisatoren darüber nachgedacht haben, wie Menschen tatsächlich mit Konferenzen interagieren möchten.

Die Content-Landschaft

Weiterlesen nach der Anzeige

Die Bandbreite der Themen auf der zweitägigen Agenda war beeindruckend. Der Mittwoch startete mit einer interaktiven Keynote zur Modellierung in Software- und menschlichen Systemen, während der Donnerstag Vorträge von Ian Coopers „The Emissary“ bis hin zu Eric Evans höchstpersönlich über „AI and Tackling Complexity“ bot. Die Klassiker waren natürlich vertreten – CQRS, Event Sourcing, DDD-Pattern – standen aber gleichberechtigt neben Sessions zu Wardley Mapping, kollaborativer Modellierung, hexagonaler Architektur und Organisationsdesign.

Über beide Tage hinweg kristallisierten sich mehrere Themen heraus. Vor allem die Schnittstelle von KI und DDD ließ sich kaum ignorieren: Rinat Abdullins „When DDD Met AI: Practical Stories from Enterprise Trenches“, Eric Evans über die Bewältigung von Komplexität mit KI und Hila Fox‘ Diskussion sozio-technischer Systeme im KI-Zeitalter – alle deuteten auf eine Community hin, die sich aktiv damit auseinandersetzt, wie diese Welten aufeinanderprallen. Der Hands-on-Workshop „Epic Systems Design: Surviving Complexity“ von Jacqui und Steven Read fand am Donnerstag statt, ebenso wie eine reflektierende Session unter dem Titel „Over 20 Years of DDD – What We Know, What We Do, What Needs to Change“, quasi eine Meta-Konversation über die Praxis selbst.

Besonders interessant fanden wir, wie natürlich dabei KI ihren Weg in den Diskurs fand. Sessions wie Marco Heimeshoffs „Hybrid Intelligence“ und die verschiedenen KI-fokussierten Vorträge wurden nicht als Neuheiten behandelt, sondern als natürliche Erweiterungen der Kernthemen der Community. Das passt perfekt zu unserer Arbeit an eventsourcing.ai, wo wir thematisieren, wie KI und Event-getriebene Architekturen einander sinnvoll ergänzen können. Die Vorteile Event-getriebener Architekturen für KI-Anwendungen – Nachvollziehbarkeit, Time-Travel-Debugging, deterministische Replays – werden anscheinend zunehmend offensichtlich.

Die Closing Keynote am Donnerstag von Alberto Brandolini über „DDD Lessons from ProductLand“ rundete die Hauptkonferenztage ab: Eine der Koryphäen der Community reflektierte darüber, wie sich DDD-Erkenntnisse jenseits der reinen Softwareentwicklung anwenden lassen.

Die Konferenz fand vollständig auf Englisch statt, was ihren international geprägten Charakter widerspiegelt. Die Teilnehmer kamen hauptsächlich aus Europa – Deutschland, Österreich, Italien und darüber hinaus – und bildeten eine diverse, aber kohärente Community. Dass Inklusion den Organisatoren wichtig ist, zeigte sich sowohl im Speaker-Lineup als auch in der Art, wie die Veranstaltung strukturiert war.

Die größere Erkenntnis

Vielleicht war unsere wichtigste Einsicht aus diesen Tagen gar nicht technischer Natur – es ging um die Community selbst. Manchmal hört man die Einschätzung, DDD, CQRS und Event Sourcing seien Nischeninteressen, die von einer kleinen Gruppe Enthusiasten in isolierten Ecken praktiziert würden.

Die KanDDDinsky widerlegte diese Wahrnehmung eindrücklich. Ja, diese Ansätze sind nicht das, was alle machen. Sie sind nicht der Standard, der mit jedem Framework ausgeliefert oder in jedem Bootcamp gelehrt wird. Aber sie sind auch keineswegs exotisch. Wenn man sich in diesem pink getönten Konferenzraum umsah und Hunderte von Menschen aus zahllosen Unternehmen und Ländern beobachtete, wurde die Realität offensichtlich: Dies ist eine substanzielle, wachsende Community mit handfester Erfahrung im Bau von Produktivsystemen.

Die Gespräche, die wir führten, waren dabei alles andere als theoretisch: Menschen lösen konkrete Probleme mit diesen Pattern. Sie ringen mit echten Trade-offs, teilen ihre Erfahrungen aus dem Alltag und lernen aus den Erfolgen und Misserfolgen der anderen. Dies ist ein ausgereifter Praxisbereich, keine experimentelle Spielwiese.

Für uns hat diese Bestätigung Gewicht. Wir bauen EventSourcingDB, weil wir überzeugt sind, dass Event Sourcing und CQRS erstklassige Tooling-Unterstützung verdienen. Die Größe und das Engagement dieser Community zu erleben, bestätigt uns darin, dass echte Nachfrage nach Tools besteht, die diese Pattern zugänglicher machen.

Ausblick

Die beiden Konferenztage setzten einen starken Akzent, wobei der Open Space am Freitag noch bevorstand, um die Gespräche in einem offeneren Format fortzuführen. Die Mischung aus Vorträgen und Workshops schuf natürliche Rhythmen – intensive Lernsessions, gefolgt von Networking und Zeit zum Verdauen. Die Location funktionierte einwandfrei, die Organisation lief reibungslos, und die Community war einladend.

Wir verarbeiten noch immer all das, was wir gelernt haben, und all die Menschen, die wir kennengelernt haben. Das ist das Zeichen einer guten Konferenz – wenn man mit mehr Fragen als Antworten nach Hause fährt und mehr Kontakte geknüpft hat, als man sofort nachverfolgen kann.

Die KanDDDinsky 2025 hat uns einen Einblick in diese Zukunft gegeben, und sie sieht vielversprechend aus: dicht, erfüllt und summend vor Ideen – genau so, wie wir es mögen. Wir freuen uns bereits darauf, diese Gespräche fortzusetzen und zu beobachten, wie diese Community die nächste Generation Event-getriebener Systeme prägt.

(rme)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

UX/UI & Webdesignvor 1 Woche

UX/UI & Webdesignvor 1 WocheIllustrierte Reise nach New York City › PAGE online

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets