Künstliche Intelligenz

Studie: KI-Modell „Delphi-2M“ sagt Krankheitsrisiken voraus

Ein Team von Forschern aus England, Dänemark und der Universität Heidelberg hat ein KI-Modell entwickelt, das Erkrankungsrisiken für mehr als 1000 Krankheiten vorhersagen können soll – und das nicht nur für Einzelpersonen, sondern auch für ganze Bevölkerungsgruppen. Das System namens Delphi-2M (mit zwei Millionen Parametern) basiert auf einer Transformer-Architektur, wie sie auch in großen Sprachmodellen zum Einsatz kommt.

Bisherige Systeme beschränkten sich meist auf einzelne Krankheiten. Delphi-2M dagegen soll simultan Muster über viele Diagnosen hinweg erkennen und sogenannte „health trajectories“ – also individuelle Krankheitsverläufe – prognostizieren. Die Modellierung reicht laut den Forschenden bis zu 20 Jahre in die Zukunft. Veröffentlicht wurden die Ergebnisse in der Fachzeitschrift Nature.

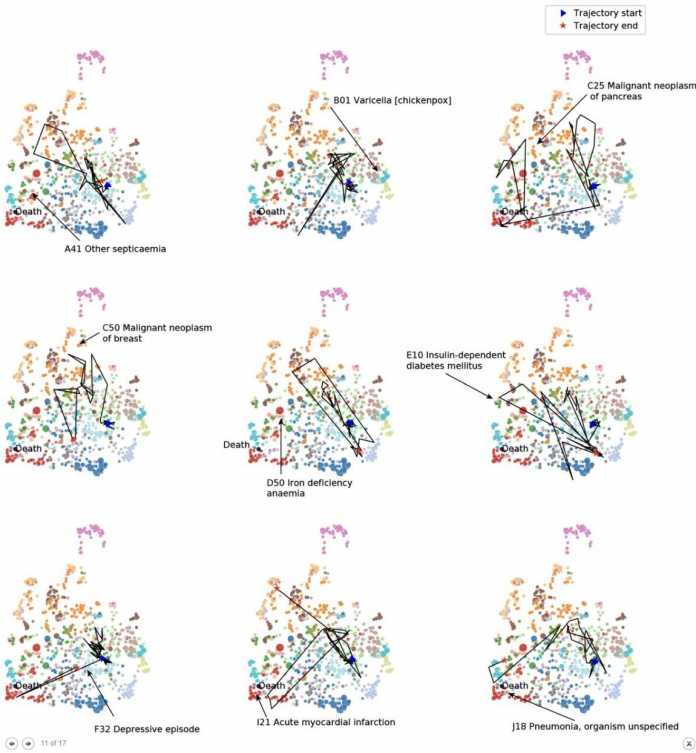

Krankheitstrajektorien von Delphi‑2M, die typische Verläufe einzelner Diagnosen bis zum Tod veranschaulichen sollen.

(Bild: Shmatko et al.)

Trainiert wurde Delphi-2M mit klinischen Daten von 400.000 Patientinnen und Patienten aus der britischen UK Biobank, darunter auch Faktoren wie Body-Mass-Index oder Konsumgewohnheiten. Für die Validierung griff das Team auf ein dänisches Register mit 1,9 Millionen Personen zurück. Erste Tests zeigen: Beim Risiko für Herzinfarkte, bestimmte Tumoren oder Mortalität lieferte das System ähnlich verlässliche Vorhersagen wie spezialisierte Modelle. Delphie‑2M erreicht im Schnitt einen C-Index – mit der Vorhersagemodelle bewertet werden – von ungefähr 0,85 im 5‑Jahres-Zeitraum.

Grenzen hat die Technik dort, wo Krankheitsbilder komplex, unregelmäßig oder selten sind, etwa bei psychischen Störungen oder Schwangerschaftskomplikationen. Das liegt beispielsweise daran, dass es zu seltenen Erkrankungen weniger Trainingsdaten gibt. Hinzu kommt, dass die Trainingsdaten bisher nicht repräsentativ für die Gesamtbevölkerung sind, da die UK Biobank vor allem Daten älterer und britischer Teilnehmender enthält.

„Wir reden hier noch von Zukunftsmusik. Der Weg in die konkrete medizinische Anwendung ist meist länger, als man denkt. Bei allen Potenzialen dürfen wir uns nicht in eine KI-gestützte Glaskugelschau verrennen – auch die besten Modelle erkennen Muster, aber sie sagen keine Zukunft voraus. Für Patienten muss klar sein: solche Prognosen sind keine Schicksalsurteile. Sie können aber Anhaltspunkte für Präventions- oder Therapieentscheidungen geben“, schätzt dazu Prof. Robert Ranisch ein, Juniorprofessor für Medizinische Ethik mit Schwerpunkt auf Digitalisierung von der Universität Potsdam. Wichtig sei zudem, „dass der Einsatz solcher Modelle den Entscheidungsspielraum der Patienten nicht einengt. Ihre Autonomie im Jetzt darf nicht einem Behandlungsregime untergeordnet werden, das allein auf zukünftige Gesundheit ausgerichtet ist. Selbst wo dies nicht geschieht, bliebe doch eine gewisse Nötigung, sich zu prognostizierten Zukünften zu verhalten. Entscheidend bleibt deshalb auch ein Recht auf Nichtwissen.“

Begehrlichkeiten bei Versicherungen oder Arbeitgebern

„Gleichzeitig ist zu befürchten, dass solche KI-Modelle falsche Begehrlichkeiten wecken – etwa bei Versicherungen oder Arbeitgebern, besonders über Deutschland hinaus. Dann geht es weniger darum, ob die Vorhersagen tatsächlich belastbar sind, sondern um die Illusion einer exakten Berechenbarkeit. Diese kann dazu führen, dass Menschen ungerechtfertigt benachteiligt werden. Deshalb müssen wir sehr genau überlegen, wo wir solche Modelle im Gesundheitssystem einsetzen wollen“, gibt Ranisch zu bedenken. Ethik und Recht würden sich „bisher oft an binären Kategorien von gesund oder krank“ orientieren, oft seien in der „digitalen und präventiven Medizin […] Graustufen entscheidend“. Zudem wirft Ranisch weitere Fragen auf, was es bedeute, wenn gesunde Menschen in ein Muster „bald Kranker“ passen, oder wie Gesundheitsinformationen geschützt werden sollen, „wenn plötzlich eine Vielzahl persönlicher Daten für KI-Prognosen relevant“ werden.

„Bei der Frage, wer und wie die Technologie zum Einsatz kommen sollte, ist zwischen zwei Fällen zu unterscheiden: Dem Einsatz, um Entwicklungen im gesamten Gesundheitssystem abzuschätzen, und der Einsatz, um Aussagen über Individuen zu treffen“, erklärt dazu PD Dr. Markus Herrmann, Leiter des Bereichs KI-Ethik am Institut für Medizin- und Datenethik an der Universität Heidelberg. Ersteres wäre vergleichsweise unproblematisch, bei letzterem müsse bedacht werden, dass der Menschen auch ein Recht auf „Nicht-Wissen“ habe – also ein Recht darauf, „sein Leben nicht in Sorge oder gar Angst vor drohender Krankheit zu führen“.

(mack)

Künstliche Intelligenz

Österreichs Höchstgericht: Personalisierte Werbung Meta Platforms’ unzulässig

Meta Platforms hat sein Geschäftsmodell im Europäischen Wirtschaftsraum illegal betrieben: Es hat zu viele Daten gesammelt, Werbung unzulässig personalisiert und zu wenig Auskunft gegeben. Das hat der Oberste Gerichtshof Österreichs (OGH) nach elf Jahren Verfahrensdauer entschieden (Az. 6 Ob 189/24y). Facebook durfte Werbung nicht auf den Kläger zuschneiden und darf auf Drittseiten keine Daten über ihn ernten. Und entgegen Metas bisheriger Praxis beschränkt sich sein Anspruch auf Auskunft nicht bloß auf eine Kopie aller persönlichen Daten, sondern umfasst auch die Offenlegung der Zwecke der Verarbeitung sowie die Quellen und Empfänger der Daten.

Weiterlesen nach der Anzeige

Grundsätzlich hat Meta ein Monat Zeit, Auskunftsbegehren zu beantworten. Im konkreten Fall ist diese Frist schon vor Jahren abgelaufen, daher gewährt der OGH nur Zeit bis Jahresende. Angestrengt hat das Verfahren der österreichische Jurist und Datenschutzaktivist Max Schrems im Jahr 2014. Seither war der Prozess zweimal beim Europäischen Gerichtshof (EuGH) und nun das dritte Mal beim OGH.

Jetzt ist Schluss – aber nur mit diesem Prozess. Zahlreiche Klagen dürften folgen, und womöglich wird sich auch der deutsche Bundesgerichtshof (BGH) an Auslegungen des OGH orientieren.

„Meta (muss) Herrn Schrems beispiellosen Zugang zu den über ihn gesammelten Daten gewähren”, sagt die Anwältin des Klägers, Katharina Raabe-Stuppnig. „Dies geht weit über das Download-Tool oder die Informationen auf der Webseite hinaus. Seit mehr als einem Jahrzehnt weigert sich Meta, vollständige Transparenz über die Verarbeitung von europäischen Daten zu gewähren. Das Urteil ist in der gesamten EU unmittelbar vollstreckbar.“

Personalisierte Werbung kein Dienst am User

„Für die Erbringung der Dienste des sozialen Online-Netzwerks ist … die Personalisierung von Werbung unter Verwendung der personenbezogenen Daten des Nutzers … nicht erforderlich”, stellt der OGH fest. „Auch die Aggregation und Analyse personenbezogener Daten zu Werbezwecken ist kein Bestandteil der für den Kläger bestimmten Vertragsleistung.” Das sei vielmehr eine Leistung für Werbekunden, nicht für die Nutzer. Damit fällt die von Meta behauptete Rechtsgrundlage für den persönlichen Zuschnitt der Reklame weg.

Allerdings bietet Meta Nutzern seit 2023 die Möglichkeit, sich durch Zahlung von Gebühren den Werbezuschnitt zu verbitten. Was diese Konstellation juristisch bedeutet, lässt der OGH ausdrücklich offen. Sein Erkenntnis bezieht sich ausschließlich auf die Situation 2020.

Unterdessen ist die Situation noch komplexer geworden. Die EU-Kommission hat mit Meta jüngst einen Pakt geschlossen, wonach Meta bald weniger Daten für personalisierte Reklame auf Facebook und Instagram auswerten wird, es für die umfassende Unterlassung der aber Gebühren verlangen darf. Das hilft aber, soweit ersichtlich, nur gegen den Werbezuschnitt, nicht gegen die Sammlung personenbezogener Daten an sich. Sobald der Nutzer den EWR verlässt, oder sich die Rechtslage ändert, könnte Meta die bereits gesammelten Daten wieder voll auswerten.

Weiterlesen nach der Anzeige

Datenernte auf Drittseiten unzulässig

Meta sammelt nicht nur über eigene Dienste, sondern auch auf zahllosen Webseiten und Apps Dritter Daten über deren User, durch Cookies sowie die berüchtigten „Meta Business Tools”. Diesbezüglich stellt der OGH fest, dass Meta „hinsichtlich des Erhebens, der Übermittlung und der weiteren Verarbeitung jener personenbezogenen Daten des Klägers, die sie mittels ihrer sozialen Plugins und ähnlicher Technologien im Zuge von Besuchen oder Aktivitäten des Klägers auf Webseiten dritter

Anbieter erlangt” Verantwortliche” im Sinne der Datenschutzgrundverordnung (DSGVO) ist. Metas Argument, dafür seien allein die Betreiber der jeweiligen Apps und Webseiten zuständig, greift nicht.

Metas Plugins sind beispielsweise auch in Webseiten politischer Parteien, medizinische Seiten oder Seiten für Homosexuelle eingebunden. Damit erfassen sie sensible Daten, die von der DSGVO besonders geschützt werden. Ob Meta solche Daten absichtlich oder unabsichtlich sammelt, spiele laut OGH keine Rolle. Meta habe diese Datensammlung über Webseiten und Apps Dritter zu unterlassen. Dabei kommt es auch nicht darauf an, ob die Daten für Werbung oder andere Zwecke ausgewertet wird.

Der OGH stützt sich dabei auch auf den EuGH. Dieser hat im Verfahren mit dem deutschen Bundeskartellamt (Az. C-252/21) eine Aufspaltung des Gesamtvorgangs in einzelne Verarbeitungsvorgänge und unterschiedliche Datenkategorien ausdrücklich abgelehnt.

„Der OGH bestätigt, dass die Meta Business Tools generell rechtswidrig sind”, verdeutlicht der deutsche Anwalt Max Baumeister. „Es sind Spionagewerkzeuge, die unser aller Privatleben ausspionieren.” Baumeister führt, unabhängig von Schrems‘ elf Jahre alter Klage, einen juristischen Großangriff auf Metas Geschäftsmodell in Deutschland und Österreich. Der Anwalt geht „davon aus, dass der BGH das Ende 2026 oder Anfang 2027 bestätigen wird”, sagte er Donnerstagabend zu heise online.

Nur 500 Euro für Max Schrems

In einem früheren Stadium des Verfahrens hat der OGH Max Schrems bereits 500 Euro Schadenersatz zugesprochen, weil Meta die Auskunftspflicht verletzt hat. Für die illegale Datensammlung und die unzulässige Datenauswertung für personalisierte Werbung gibt es schon deswegen keinen weiteren Schadenersatz, weil Schrems insgesamt nicht mehr als 500 Euro beantragt hat – wohl um den Streitwert und damit Prozesskosten nicht ausufern zu lassen.

„Wir gehen davon aus, dass hier noch wesentlich mehr drin steckt”, meint Baumeister, „Das gilt für Österreich; für Deutschland aufgrund strengerer Gesetze bei schwerwiegenden Eingriffen in das Persönlichkeitsrecht sowieso.” Die deutschen Landgerichte sind bezüglich Metas Datenpraxis geteilter Meinung.

Der lange Weg zum BGH

Weil Privatpersonen in Deutschland keine vollstreckbaren Sammelklagen erheben können, hat Baumeister in den letzten zwei Jahren rund 8.000 Klagen wegen der Datenernte mittels Meta Business Tools eingereicht. Mehr als 2.000 Verfahren sind bislang in erster Instanz entschieden, kein einziges rechtskräftig.

Aufsehen erregte Mitte des Jahres ein Urteil des Landgerichts Leipzig, das einem Meta-Betroffenen 5.000 Euro zusprach (Az. 05 O 2351/23, nicht rechtskräftig). Zunächst urteilten die deutschen Gerichte überwiegend für Meta, doch nach und nach gewinnen die Datenschutzargumente Boden bei deutschen Richtern. Die juristischen Begründungen sind nicht immer gleich, die zugesprochenen Schadenersatzbeträge variieren um den Faktor 100: Die Bandbreite reicht von 100 Euro bis 10.000 Euro.

Der BGH wird entscheiden müssen. Im Zusammenarbeit mit dem österreichischen Verbraucherschutzverein (VSV) sammelt Baumeister nun Teilnehmer aus beiden Ländern, die kostenlos an einer Verbandsklage teilnehmen möchten.

(ds)

Künstliche Intelligenz

Porträt von John Ternus: Ist er Apples nächster CEO?

Die Umstände für die Präsentation einer historischen Apple-Produktneuerung waren am 10. November 2020 alles andere als ideal. Die Corona-Pandemie breitete sich verheerend schnell aus, die Weltwirtschaft rutschte in eine tiefe Rezession. Trotz der widrigen Rahmenbedingungen wollte Apple-Chef Tim Cook das „One More Thing“-Event nicht absagen. So kam John Ternus, der Leiter der Hardware-Sparte, zu seinem wichtigsten öffentlichen Auftritt: Er präsentierte die initialen Macs mit den hauseigenen M1-Chips. Sie hauchten der altgedienten Gerätekategorie neuen Schwung ein und ließen die vorausgehenden Intel-Macs über Nacht sehr alt aussehen.

Cook beschränkte sich auf eine kurze Einordnung: „Dies ist ein bedeutender Tag für den Mac und für Apple. Fortschritte dieser Größenordnung sind nur möglich, wenn man mutige Veränderungen vornimmt.“ Danach überließ er dem Jungstar Ternus die Bühne. Seitdem ist der passionierte Schwimmer aus Kalifornien immer wieder für den Chefposten im Gespräch. Beobachter sehen in ihm den künftigen Apple-CEO, sollte Tim Cook sich aus der Führungsspitze verabschieden.

- Ternus ist seit über 20 Jahren mit Apple-Hardware betraut.

- Er war an vielen Apple-Meilensteinen beteiligt.

- Jony Ives Abgang gab Ternus mehr Spielraum.

- Als Cook-Nachfolger braucht es jedoch mehr als nur Hardware-Expertise.

Feuertaufe gemeistert

Prominente Keynote-Auftritte bleiben bei Apple nicht dem Zufall überlassen: Sie dienen nicht nur der Produktvorstellung, sondern auch der sorgfältigen Präsentation des potenziellen Führungspersonals. Diese Vorstellung richtet sich nicht allein an Apple-Fans und Kunden, sondern ebenso an den Aufsichtsrat – das Board of Directors – und die Investoren.

Das war die Leseprobe unseres heise-Plus-Artikels „Porträt von John Ternus: Ist er Apples nächster CEO?“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

Künstliche Intelligenz

Top 10: Der beste Full-HD-Beamer für Heimkino, TV & Konsole im Test

Etoe Seal Pro

Der Full-HD-Beamer Etoe Seal Pro lockt mit Android 11, einer hohen Helligkeit von 1000 Ansi-Lumen und einer umfangreichen Ausstattung zu einem günstigen Preis. Wir haben ihn getestet.

- hohe Helligkeit mit 1000 Ansi-Lumen

- scharfes und kontrastreiches Full-HD-Bild

- Android 11 mit Netflix, Prime Video & Co. in Full-HD

- umfangreiche Ausstattung mit HDMI 2.1, USB und Bluetooth

- gute automatische Bildkorrekturen wie Autofokus und Trapezkorrektur

- attraktiver Preis

- groß und schwer, nur bedingt mobil einsetzbar

- keine Linsenabdeckung oder Tasche

- Fernbedienung nutzt in Teilen Infrarot

- Lüfter hörbar

- sichtbare Spaltmaße

Full-HD-Beamer Etoe Seal Pro im Test

Der Full-HD-Beamer Etoe Seal Pro lockt mit Android 11, einer hohen Helligkeit von 1000 Ansi-Lumen und einer umfangreichen Ausstattung zu einem günstigen Preis. Wir haben ihn getestet.

Der Full-HD-Beamer Etoe Seal Pro verspricht eine hohe Helligkeit von 1000 Ansi-Lumen, ein scharfes Full-HD-Bild, Android 11, automatische Bildkorrekturen und viele Anschlüsse. In diesem Test nehmen wir Optik, Verarbeitung, Hardware, Bild, Software und den Preis des Etoe Seal Pro genauer unter die Lupe. Wir zeigen, was der Beamer zu bieten hat und ob er trotz seines günstigen Preises eine Empfehlung ist.

Wie ist die Optik und die Verarbeitung des Etoe Seal Pro?

Der Etoe Seal Pro ist mit Maßen von 22 x 17 x 19 cm und einem Gewicht von 3,2 kg recht groß und schwer. Dazu kommt noch der Tragegriff, mit dem sich der Beamer einfach transportieren lässt. Trotzdem ist er aufgrund seiner Größe und des fehlenden Akkus nur bedingt mobil. Hier empfehlen sich eher kompakte Akku-Beamer wie der Xgimi Halo+ (Testbericht) oder der Blitzwolf BW-VT2 (Testbericht).

Optisch setzt der Seal Pro auf ein schlichtes, unauffälliges Design. Er ist größtenteils in mattem Schwarz gehalten und besteht überwiegend aus Kunststoff. Die Linse steht leicht aus dem Gehäuse hervor, eine Abdeckung oder eine Tasche zum Schutz gibt es leider nicht. Vorne und hinten befinden sich große Kunststoffgitter für die Zu- und Abluft des Lüfters. An den Seiten sitzen die Öffnungen für die zwei integrierten 10-Watt-Lautsprecher.

Die Verarbeitungsqualität des Etoe Seal Pro ist insgesamt in Ordnung, aber nicht überragend. Es gibt stellenweise deutliche Spaltmaße zwischen den Gehäuseteilen. Da der Beamer im Betrieb aber meist einfach nur herumsteht und nicht ständig bewegt wird, ist das nicht weiter schlimm. Eine Zertifizierung gegen das Eindringen von Staub und Wasser hat und braucht der Seal Pro nicht.

Was kann die Hardware des Etoe Seal Pro?

In Sachen Anschlüsse ist der Etoe Seal Pro gut aufgestellt. Er bietet einen HDMI-2.1-Eingang für das Videosignal, an den man etwa einen Laptop, eine Spielekonsole oder einen Receiver anschließen kann. Über den USB-A-Port lassen sich Medien von einem USB-Stick abspielen oder Endgeräte wie Streaming-Sticks mit Strom versorgen. Außerdem gibt es noch einen 3,5-mm-Klinkenausgang für den Anschluss von Kopfhörern oder externen Lautsprechern.

Erfreulich ist, dass sich der Seal Pro auch direkt am Gerät über eine Tastenleiste auf der Oberseite bedienen lässt. So ist man nicht zwingend auf die mitgelieferte Fernbedienung angewiesen. Ihr Design ist ebenfalls gelungen. Sie liegt gut in der Hand, hat eine logische Tastenbelegung und bietet dedizierte Knöpfe für den Aufruf von Youtube, Netflix, Disney+ und Prime Video. Zudem verfügt sie über ein Mikrofon für die Sprachsteuerung.

Etwas merkwürdig: Obwohl die Fernbedienung per Bluetooth mit dem Beamer verbunden ist, was für die Sprachsteuerung nötig ist, erfolgen normale Eingaben über Infrarot. Man muss also mit der Fernbedienung stets auf den Beamer zielen, was etwas umständlich ist. Zudem gibt es eine leichte Verzögerung von etwa einer halben Sekunde bei der Eingabe.

Ansonsten unterstützt der Seal Pro WLAN mit 2,4 und 5 GHz sowie Bluetooth 5.1 für die Verbindung mit externem Zubehör. Im Inneren arbeitet ein ARM Quad 64-bit Cortex-A53-Prozessor, dem 2 GB RAM und 16 GB interner Speicher zur Seite stehen. Eine Bildschirmspiegelung ist per Mirror Cast möglich, um etwa Inhalte von Smartphone oder Laptop auf den Beamer zu übertragen.

Das externe Netzteil, das die Hitze aus dem Gehäuse heraushält, liefert maximal 180 Watt Leistung.

Wie gut ist das Bild des Etoe Seal Pro?

Der Etoe Seal Pro liefert ein scharfes und helles Full-HD-Bild mit 1920 x 1080 Pixeln. Die Helligkeit ist mit 1000 Ansi-Lumen für diese Preisklasse außergewöhnlich hoch. Wer es noch etwas heller und günstiger will, der kann sich etwa den Wanbo X5 (Testbericht) ansehen. Damit ist der Seal Pro auch in Räumen mit etwas Restlicht noch gut nutzbar. Natürlich ist das Bild in einem komplett abgedunkelten Raum am besten. Die hohe Helligkeit sorgt auch dafür, dass das Bild zu den Rändern hin nicht zu sehr abfällt.

Der Beamer nutzt ein 4,4 Zoll großes LCD-Panel und erreicht einen dynamischen Kontrast von 3000:1. Das Bild wirkt insgesamt kontrastreich, die Farben sind kräftig. Einige Nutzer berichten von einem leichten Grauschleier, der die Farben etwas blass erscheinen lässt, das konnten wir in unserem Test aber nicht feststellen. Der Beamer unterstützt zudem HDR10 für Quellen mit erweitertem Kontrastumfang.

Das native Seitenverhältnis ist 16:9, optional sind auch 16:10 und 4:3 einstellbar. Das Projektionsverhältnis liegt bei 1,22:1, der Projektionsabstand ist mit 1,1 bis 5,4 Metern recht flexibel. Damit lassen sich Bilddiagonalen von 40 bis 200 Zoll realisieren. Die empfohlene Diagonale für ein optimal scharfes Bild liegt zwischen 80 und 120 Zoll, der ideale Abstand zwischen Beamer und Leinwand zwischen 2,16 und 3,24 Metern.

Um auch bei schrägem Aufstellwinkel oder schiefer Leinwand ein gerades Bild zu erhalten, bietet der Seal Pro diverse automatische Bildkorrekturen. Per Autofokus wird das Bild stets scharf gestellt, die Trapezkorrektur von ±40° richtet es vertikal aus. Eine digitale 4-Punkt-Korrektur ist ebenfalls verfügbar. Zudem gibt es einen digitalen Zoom von 50 Prozent bis 100 Prozent.

Diese Korrekturen funktionieren insgesamt gut, gehen aber zulasten der Bildqualität. Denn der Beamer muss das Bild dann digital nachberechnen und erreicht nicht mehr die native Full-HD-Auflösung. Für das beste Ergebnis sollte man den Etoe Seal Pro also möglichst gerade vor der Leinwand oder Wand positionieren.

Wie gut ist die Software des Etoe Seal Pro?

Auf der Unterseite des Seal Pro versteckt sich hinter einer Klappe der Streaming-Stick Etoe TV D1221 mit Android 11 für Android TV. Er unterstützt gängige Videoformate wie H.265 4K bei 60 fps, VP9 4K bei 60 fps, AVS2-P2 bis 4K bei 60 fps, H.264 4K bei 30 fps sowie MPEG1/2/4.

Dank der Android-TV-Oberfläche gestaltet sich die Ersteinrichtung recht einfach, auch komplett ohne Fernbedienung. Man kann den Beamer direkt mit dem WLAN verbinden und mit einem Android-Handy einrichten. Anschließend landet man auf dem übersichtlichen Android-TV-Homescreen.

Die vorinstallierten Apps umfassen Youtube, Netflix, Prime Video und Disney+, die sich mit einem Klick auf der Fernbedienung aufrufen lassen. Erfreulich ist, dass sich diese Dienste dank des externen Streaming-Sticks in Full-HD-Auflösung nutzen lassen. Das ist bei vielen günstigen Beamern ohne Stick nicht der Fall, da ihnen die nötige Zertifizierung fehlt. Natürlich lassen sich auch weitere Apps aus dem Google Play Store installieren.

Die Bedienung von Android TV auf dem Etoe Seal Pro funktioniert flüssig genug, auch wenn es bei Eingaben über die Fernbedienung zu kleinen Verzögerungen kommt. Für die Wiedergabe von Videos und Filmen von einem lokalen USB-Speicher muss man den VLC-Player aus dem Store herunterladen.

In den Einstellungen hat man Zugriff auf die üblichen Android-TV-Optionen. Erweiterte Bild-Einstellungen wie eine Anpassung von Helligkeit, Kontrast oder Farbtemperatur gibt es nicht. Dafür bietet Etoe ein eigenes Menü für die Beamer-Funktionen, in dem sich etwa der Projektionsmodus (Front, Rückprojektion, Decke) oder die Trapezkorrektur anpassen lassen. Die Möglichkeiten sind aber auch hier eher begrenzt. Mehr dazu in unserer Bildergalerie.

Etoe Seal Pro Screenshots

Wie gut sind der Klang und die Lautstärke des Lüfters beim Etoe Seal Pro?

Im Etoe Seal Pro arbeiten zwei 10-Watt-Lautsprecher, die einen recht guten Klang liefern. Sie sind kräftig genug, um einen größeren Raum mit Sound zu füllen und den Lüfter zu übertönen.

Die Höhen und Mitten werden sauber wiedergegeben, doch der Bass könnte kräftiger sein. Insgesamt eignen sich die eingebauten Lautsprecher für den gelegentlichen Film- oder Fußballabend. Für das volle Heimkino-Erlebnis mit sattem Klang empfiehlt sich trotzdem die Verbindung mit einer externen Soundbar (Bestenliste) oder einem Bluetooth-Lautsprecher (Bestenliste).

Der Lüfter des Seal Pro ist im Betrieb deutlich hörbar, ohne dabei aufdringlich zu werden. Ein gewisses Grundrauschen lässt sich kaum vermeiden, schließlich muss die Abwärme des hellen Projektors aus dem Gehäuse befördert werden. Im Vergleich zu anderen Beamern dieser Preisklasse ist die Lüfterlautstärke des Seal Pro aber noch im grünen Bereich. Wer sehr empfindlich ist, sollte aber zur Sicherheit vor dem Kauf Probehören.

Wie teuer ist der Etoe Seal Pro?

Der Etoe Seal Pro kostet regulär 500 Euro. Wer ihn bei Amazon im Etoe-Shop kauft, kann einen Coupon aktivieren und zahlt dann nur noch 400 Euro. Bei Geekmaxi ist der Beamer für 350 Euro gelistet. Mit Coupon-Code Z2QPA7DU kostet er sogar nur 324 Euro.

Fazit

Der Etoe Seal Pro ist ein richtig guter Full-HD-Beamer zum günstigen Preis. Er trumpft mit einer hohen Helligkeit von 1000 Ansi-Lumen, einem scharfen und farbenfrohen Bild sowie einer umfangreichen Ausstattung inklusive Android 11 auf. Dank des integrierten Streaming-Sticks sind auch Netflix und Co. in Full-HD möglich. Die automatischen Bildkorrekturen funktionieren gut, die Anschlussvielfalt mit HDMI 2.1, Bluetooth 5.1 und USB ist vorbildlich.

Schwächen zeigt der Seal Pro bei der Mobilität. Mit über 3 kg ohne Akku ist er recht klobig und hauptsächlich für die Nutzung zu Hause geeignet. Auch die Verarbeitung mit ihren Spaltmaßen ist nicht über jeden Zweifel erhaben. Die Bedienung über die Fernbedienung reagiert manchmal etwas verzögert. Auch nutzt die Fernbedienung in Teilen Infrarot, es gibt keine Linsenabdeckung oder Tasche und der Lüfter dürfte gerne noch etwas ruhiger sein.

Insgesamt bekommt man mit dem Etoe Seal Pro aber sehr viel Beamer fürs Geld. Wer nach einem günstigen Gerät mit heller Full-HD-Projektion für gelegentliche Film- und Fußballabende sucht und keine Ansprüche an die Mobilität hat, bekommt hier ein tolles Gesamtpaket.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenIllustrierte Reise nach New York City › PAGE online

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 2 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenSK Rapid Wien erneuert visuelle Identität

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenNeue PC-Spiele im November 2025: „Anno 117: Pax Romana“

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenDonnerstag: Deutsches Flugtaxi-Start-up am Ende, KI-Rechenzentren mit ARM-Chips

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenArndt Benedikt rebranded GreatVita › PAGE online