Apps & Mobile Entwicklung

Deepcool CL6600: Neues Gehäuse lagert CPU-Hitze ins Oberteil aus

Prozessor oder Grafikkarte optimal kühlen? Deepcool möchte im CL6600 beides und lagert dazu die Hitze der CPU aus. Sie wird in einer eigenen Kammer abgegeben, die der Hersteller vom übrigen Gehäuse trennt und als „Oberteil“ auf den Kern-Tower setzt. Der dafür nötige Kühler wird gleich mitgeliefert.

Die ungewöhnliche Interpretation eines Zwei-Kammer-Layouts nimmt den klassischen Midi-Tower als Grundlage und setzt ihm einen weiteren Kasten oben auf. Das, Holz an der Front und ein integrierter Headset-Halter produzieren einen ungewöhnlichen Look. Der soll auch zu sehen sein: Gedacht ist, das Gehäuse auf den Schreibtisch zu stellen, die Anschlüsse befinden sich dementsprechend an der Unterseite.

Oberteil kühlt

Das Oberteil hat zudem eine Funktion. Dort wird die Abwärme des Prozessors abgegeben, Deepcool nennt das „HyperSplit“. Obwohl das CL6600 auch große Luftkühler bis zu einer Höhe von 175 Millimetern aufnehmen kann, funktioniert dieses spezielle Konzept mit einem Heatpipe-Kühler nicht, es benötigt eine Wasserkühlung.

Ein passendes Modell mit 360-mm-Radiator und auf das Gehäuse abgestimmter Schlauchlänge wird daher vorinstalliert. Nachrüsten lassen sich drei weitere Lüfter auf dem Radiator für eine Push-Pull-Belüftung. Die Pumpe kann zwischen 2.500 und 3.400 U/min betrieben werden, die Lüfterdrehzahl liegt zwischen 500 und 2.500 U/Min.

Das Netzteil soll ebenso vom übrigen Innenleben entkoppelt werden. Damit das funktioniert, sitzt es direkt hinter der Front und entlässt warme Abluft seitlich aus dem Gehäuse. So bleibt die Grafikkarte als einzige Wärmequelle im Innenraum übrig. Unterstützt werden logischerweise auch extrem lange und große Modelle.

Frische Luft besorgen zwei 120-mm-Lüftern vom Typ FL12R SE mit invertierten Blättern an der Unterseite, die an einer ausziehbaren Halterung vor dem Netzteil sitzen. Sie können zwischen 500 und 2.150 U/Min betrieben werden. Weitere Lüfter können an Front, Heck und Oberseite nachgerüstet werden, teilweise ausschließlich im 140-mm-Format.

Preis und Verfügbarkeit

Das CL6600 soll ab sofort im Handel verfügbar sein, als Preisempfehlung nennt Deepcool rund 200 Euro für die schwarze und knapp 210 Euro für die weiße Version. Ein wenig relativiert sich der Preis, da ein Kühler beim Marktvergleich eingerechnet werden muss.

Apps & Mobile Entwicklung

Studio Display (XDR): Apples 5K-Monitor erhält Thunderbolt 5 und Mini-LED-Option

Apple bringt zwei neue Monitore auf den Markt. Das Studio Display erhält nach rund 4 Jahren einen Nachfolger und eine XDR-Variante mit Mini-LED-Technik. Während es bei 5K-Auflösung und einmal auch 60 Hz bleibt, gibt es nun Thunderbolt 5, besseren Sound und (optional) einen höhenverstellbaren Ständer.

Apple Studio Display (2026) mit 60 Hz

Apple verpasst seinem Studio Display einen neuen Ständer und moderne Anschlüsse. Optional und gegen Aufpreis gibt es nun einen Standfuß mit Höhenverstellung , die Standardausführung erlaubt nur das Neigen des Displays. Bei den Anschlüssen wird auf Thunderbolt 5 aktualisiert. Die Universalschnittstelle mit USB-C-Anschluss gibt es im Doppelpack: Als Eingang mit 96 Watt Power Delivery (etwa für ein Notebook) und als Ausgang (etwa für ein zweites Display). Daneben liegen noch zwei USB-C-Ports mit 10 Gbit/s.

Am eigentlichen Display ändert sich wenig, denn erneut wird die 5K-Auflösung 5.120 × 2.880 auf 27 Zoll Diagonale mit somit 218 ppi geboten. Helligkeit (600 cd/m²) und Bildwiederholrate (60 Hz) entsprechen auch dem Vorgängermodell aus dem Jahr 2022.

Überarbeitet wurden die integrierte 12-MP-Webcam (mit Center Stage und Desk View) sowie das Sound-System mit 6 Lautsprechern, 3 Mikrofonen und angeblich 30 Prozent tieferen Bässen.

Ab dem 4. März kann das neue Apple Studio Display vorbestellt werden und soll ab dem 11. März verfügbar sein. Die Preise beginnen bei 1.599 USD für die Standardversion mit normaler Glasfront und einfachem Ständer. Gegen 300 USD Aufpreis gibt es Nanotexturglas und der höhenverstellbare Ständer kostet weitere 400 USD. Somit ist die beste Ausstattung erst für 2.299 USD zu haben.

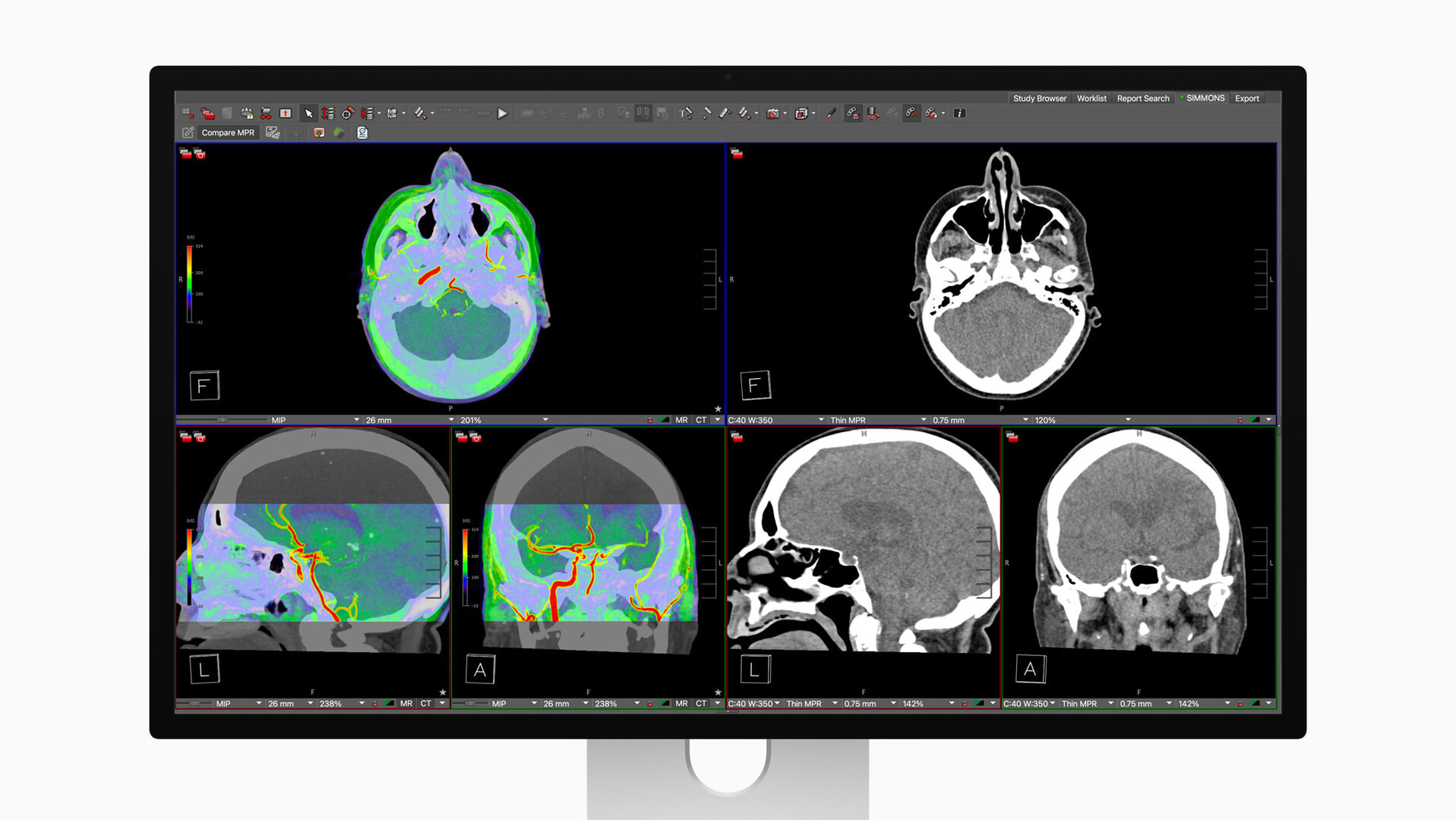

Apple Studio Display XDR mit Mini-LED und 120 Hz

Erstmals gibt es eine „XDR“-Variante des Studio Display. Diese liefert die gleiche Auflösung von 5.120 × 2.880 Pixeln allerdings in Kombination mit einem Mini-LED-Backlight. Dieses verteilt sich auf 2.304 individuell dimmbare Leuchtzonen und soll 1.000 cd/m² im SDR-Betrieb und bis zu 2.000 cd/m² im HDR-Modus erreichen. Damit ist der Kontrastumfang (1 Mio. zu 1) weitaus größer als beim Standardmodell. Diesem hat die XDR-Version auch die auf 120 Hz verdoppelte Bildwiederholrate voraus. Angaben zur Reaktionszeit macht Apple nicht.

Profis sollen mit Voreinstellungen für Farbräume wie P3 und Adobe RGB, HDR-Inhalte und sogar für Digital Imaging and Communications in Medicine (DICOM) angesprochen werden. Die Anschlüsse entsprechen mit zweimal Thunderbolt 5 (in/out) und zweimal USB-C (10 Gbit/s) jenen des neuen Studio Display. Allerdings liefert der TB5-Upstream-Port sogar bis zu 140 Watt. Wie beim Studio Display hat auch das Studio Display XDR eine 12-MP-Kamera mit Center STage und Desk View sowie ein Soundsystem mit 6 Lautsprechern.

Das Apple Studio Display XDR ist ebenfalls ab dem morgigen 4. März vorbestellbar und ab dem 11. März erhältlich. Der Startpreis liegt bei hohen 3.299 USD mit Standardglas. Das „nano-texture glass“ gibt es auch hier gegen 300 USD Aufpreis. Der vielseitigere Ständer mit Höhen- und Neigungsverstellung ist wiederum bei der XDR-Version gesetzt und kostet nichts extra.

Apps & Mobile Entwicklung

CB-Fotowettbewerb: Im März fotografiert die Community Aufzüge

Der monatliche Fotowettbewerb der ComputerBase-Community geht in die nächste Runde. Im März 2026 werden Aufnahmen zum Thema „Aufzüge“ gesucht. Bilder können wie üblich bis zum 20. Tag des Monats eingereicht werden, dann beginnt die Abstimmung innerhalb der Community.

Aus dem Sitzen hoch hinaus

Im vergangenen Februar konnte sich zum Thema „Sitzgelegenheiten“ einmal mehr Community-Mitglied K P K behaupten: Seine Aufnahme zeigt eine verzierte Bank vor einer im Einklang verzierten Wand. Insgesamt gaben ihm 26 Prozent der Teilnehmer an der Abstimmung eine ihrer drei Stimmen.

Die Redaktion gratuliert zum gelungenen Foto und dem ersten Platz. Wie üblich gebührt K P K damit einhergehend das Recht, das Thema für den nachfolgenden Monat zu setzen. Gesucht sind diesmal Bilder zum Thema „Aufzüge“.

Aufzüge! Erlaubt sind: Personenaufzüge, Lastenaufzüge, Aufzüge in und außerhalb von Gebäuden, Aufzugskabinen von innen und außen. Auch eindrucksvolle Aufzugstüren und -eingänge sind okay und selbstverständlich auch Paternoster.

Community-Mitglied K P K

Damit sind alle interessierten Community-Mitglieder aufgefordert, bis zum 20. März 2026 um 23:59 Uhr eine Aufnahme (JPEG oder PNG) zum Thema per E-Mail mitsamt dem eigenen Benutzernamen im ComputerBase-Forum an Initiator lowrider20 einzusenden.

Teilnahmebedingungen und Abstimmung

Je registriertem Community-Mitglied ist die Teilnahme mit einem eigens aufgenommenen, beliebig alten Bild erlaubt, das in noch keinem vorherigen Fotowettbewerb eingereicht oder anderweitig im ComputerBase-Forum veröffentlicht wurde. Aufnahmen mit dem gleichen Motiv eines bereits veröffentlichten Bildes aus leicht abgeänderter Perspektive sind unerwünscht. Nicht gestattet sind überdies Zeichnungen, gemalte oder per KI generierte Bilder sowie Renderings. Einmal eingereichte Bilder können nicht mehr ausgetauscht werden.

Nach Einsendeschluss startet eine neuntägige Abstimmung zu allen, maximal aber den ersten 40 eingereichten Bildern, an der alle Leser mit Forum-Nutzerkonto teilnehmen dürfen. Um die Anonymität der Fotografen zu wahren, werden die Fotos auf maximal 3.840 Pixel in Höhe und Breite verkleinert und die EXIF-Daten entfernt. Der zum Ende des Monats feststehende Gewinner darf erneut über das Monatsthema der nächsten Runde entscheiden. Die Redaktion wünscht allen Teilnehmern viel Erfolg!

Apps & Mobile Entwicklung

Seagate Mozaic 4+: Die ersten 44-TB-Festplatten rotieren schon bei Kunden

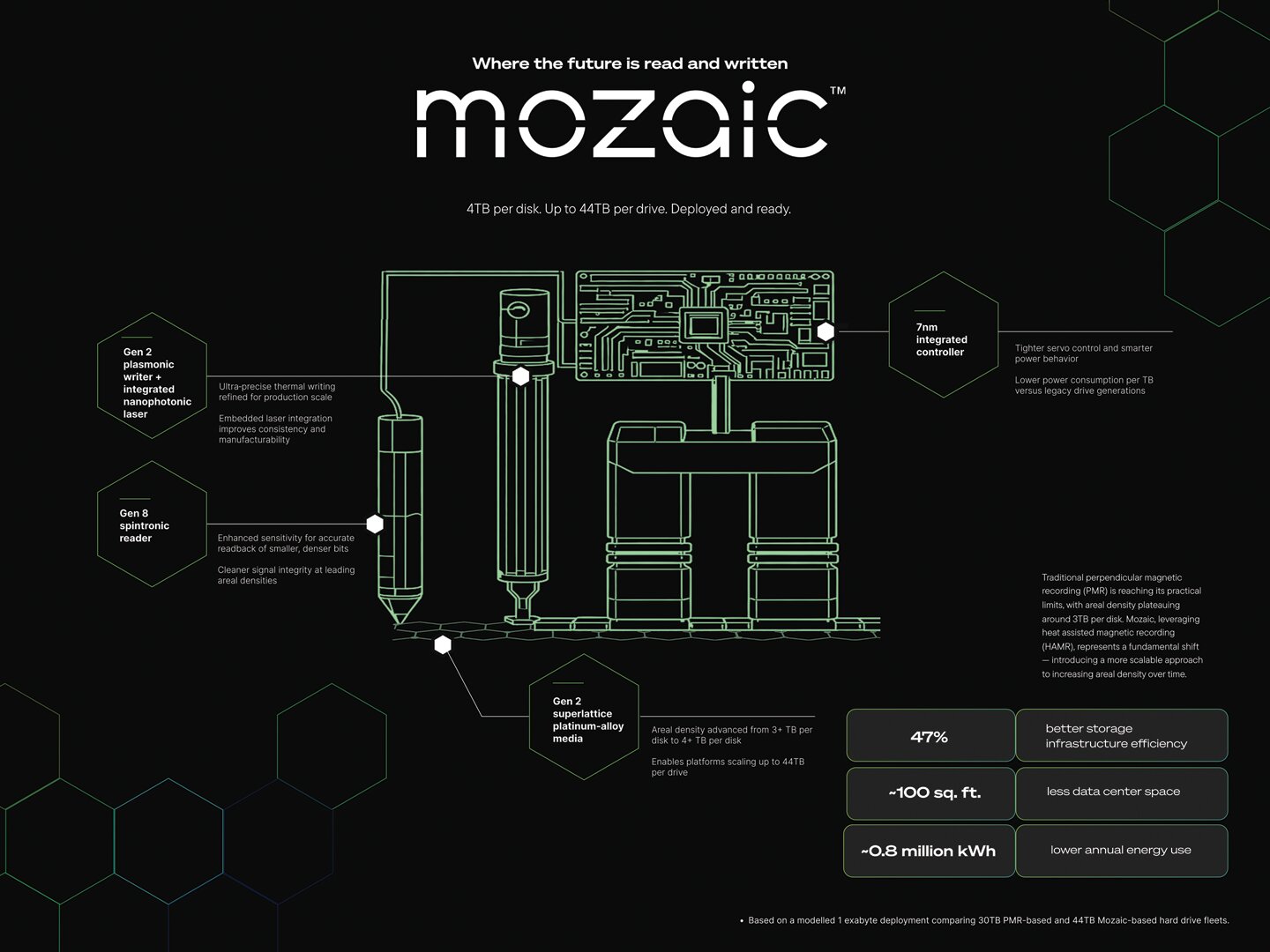

Bei der maximalen HDD-Speicherkapazität legt Seagate die Messlatte höher. Jetzt kommen über 4 TB pro Scheibe für 44 TB in der Spitze unter. Die neuen Festplatten für Rechenzentren erreichen diese Speicherkapazität mit der weiterentwickelten HAMR-Technik „Mozaic 4+“. Bei zwei Hyperscalern kommen sie schon zum Einsatz.

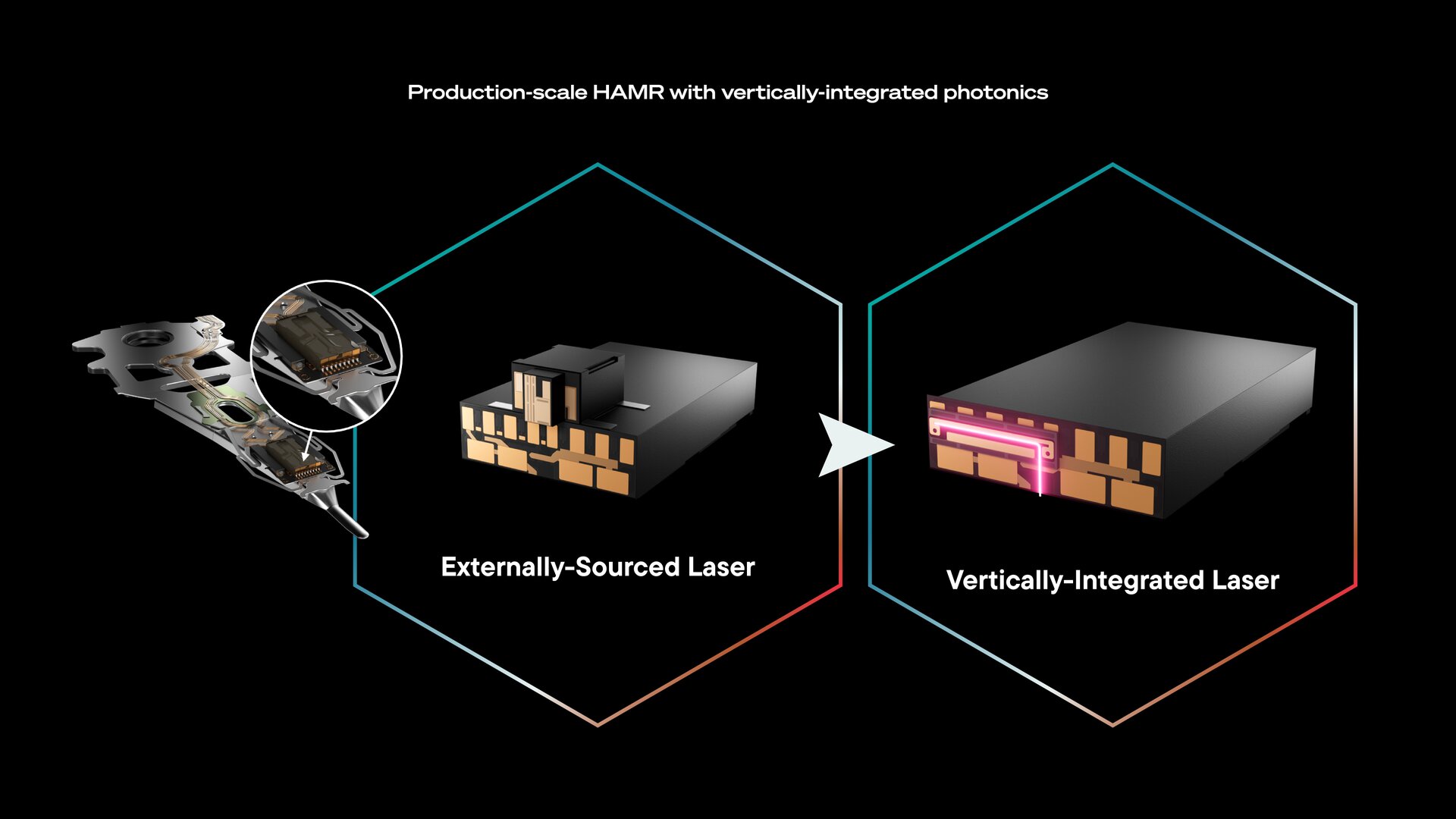

HAMR-Technik erreicht das nächste Level

Bisher bot Seagate seine HAMR-Festplatten mit bis zu 32 TB an, 36 TB waren mit überlappenden Spuren (SMR) möglich. Bei 10 Magnetscheiben (Platter) ergab sich ein Speichervolumen von gut 3 TB pro Scheibe. Daher heißt diese Generation auch „Mozaic 3+“.

- IronWolf HDD mit HAMR im Test: Seagate presst mit Hitze 30 TB auf nur zehn Platter

- Seagate IronWolf Pro 32 TB im Test: Die derzeit größte HDD für NAS-Systeme

Doch jetzt kündigt der HDD-Hersteller die nächste Generation an: Mozaic 4+. Folglich steigt die Kapazität pro Platter auf über 4 TB. Dem 10-Platter-Design bleibt Seagate treu, sodass darauf mehr als 40 TB möglich werden. Die Rede ist von „bis zu 44 TB“, was Modelle mit etwa 40 TB oder 42 TB nicht ausschließt.

Es kommt SMR zum Einsatz

Wie ComputerBase auf Nachfrage beim Hersteller erfuhr, kommt bei Mozaic 4+ allerdings SMR-Technik mit überlappenden Spuren zum Einsatz. Das schränkt die Leistung beim erneuten Beschreiben ein, denn angrenzende Spuren müssen ebenso aktualisiert werden. Für „kalte“ Daten ist dies aber selten ein Problem. Dennoch stellt sich die Frage, wie viel TB bei konventioneller Aufzeichnung (CMR) möglich wären. Seagate erklärte, dass momentan Mozaic-HDDs bis 32 TB mit CMR und bis 44 TB mit SMR im Programm sind.

Bei der Technik geht Seagate nicht allzu sehr ins Detail, nennt aber „eine Suspension-Architektur der nächsten Generation und ein verbessertes System-on-a-Chip“ als Fortschritte mit der neuen Plattform. Die bereitgestellte Explosionsgrafik ist symbolisch gemeint, denn darauf sind nur 8 Platter zu sehen, die für 44 TB mehr als 5 TB bieten müssten. Eine 32-TB-Version ließe sich nun aber durchaus mit nur 8 Plattern dank Mozaic 4+ realisieren.

Neue Platten rotieren schon bei Kunden

Nach Angaben von Seagate wurde die Mozaic-4+-Plattform schon von zwei großen Hyperscale-Cloud-Providern qualifiziert. Beide würden nun „in hohen Stückzahlen“ mit den HDDs mit bis zu 44 TB beliefert, heißt es weiter. Um welche Kunden es sich dabei handelt, bleibt allerdings geheim.

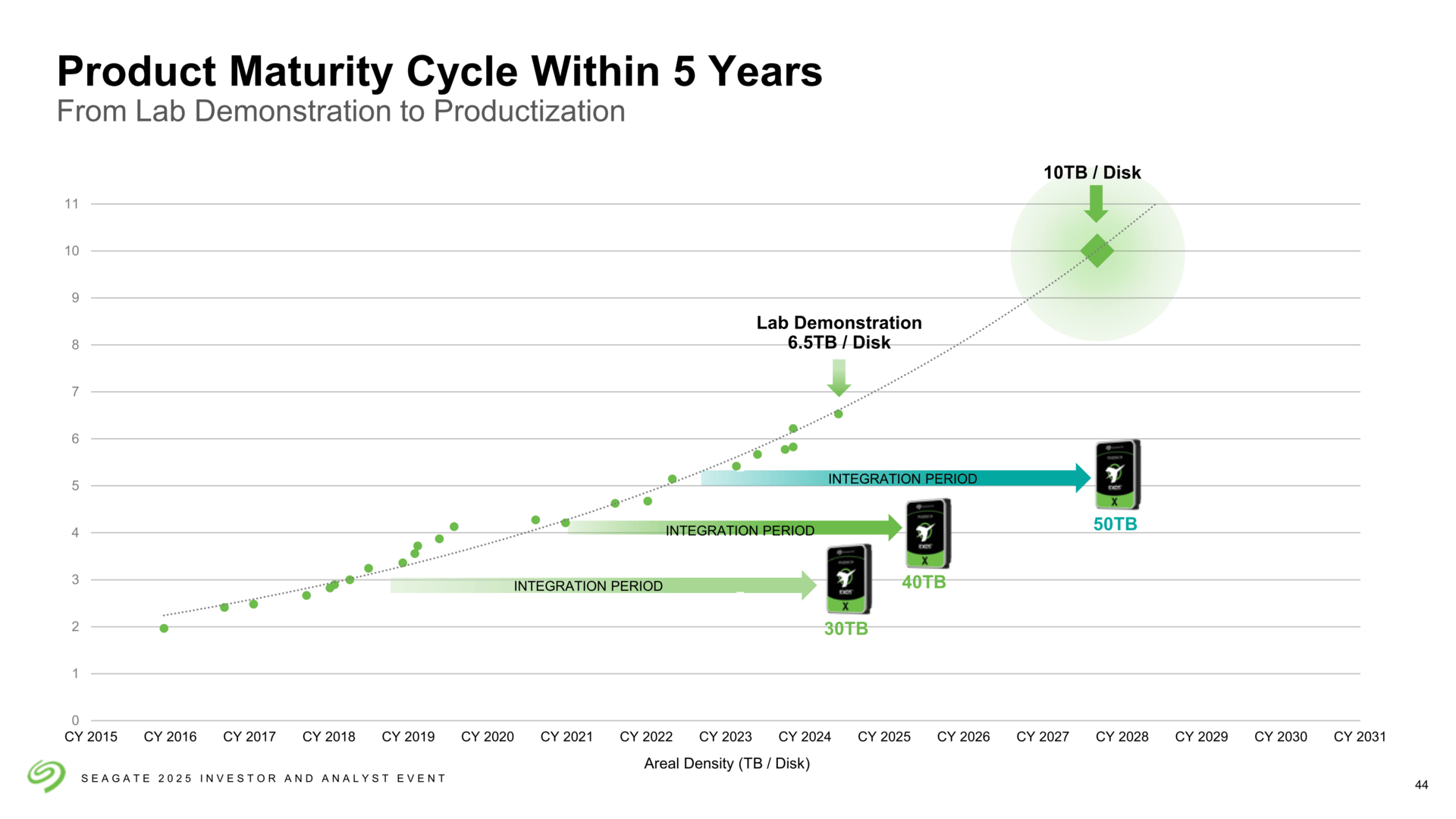

Seagate will damit zeigen, dass die zuvor dargelegte Roadmap diesmal eingehalten wird. Die Marke von 40 TB war bereits im vergangenen Jahr auf 2026 datiert worden. Im gleichen Kontext wäre dann mit 50 TB für 2028 zu rechnen. Für die Zukunft sind 100 TB bei 10 TB pro Scheibe geplant. Im vergangenen November hatte Seagate erklärt, in den eigenen Forschungslaboren bereits 7 TB pro Platter erreicht zu haben.

KI sorgt für Nachfrage

Wie fast überall in der Branche ist auch bei diesen Produkten der vermehrte Einsatz von Künstlicher Intelligenz die Triebfeder. KI-Modelle benötigen riesige Datenmengen für ihr Training, die relativ kostengünstig auf Festplatten gesichert werden können. Da für die gleiche Speichermenge im Rechenzentrum mit den 44-TB-HDDs deutlich weniger Festplatten nötig sind als bisher, sinkt der Energie- und Platzbedarf. Im Gegenzug lässt sich viel mehr Speicher bei sonst gleichbleibender Infrastruktur realisieren.

„Der Bedarf an riesigen Datenmengen – sowohl realen als auch synthetisch generierten – ist für den Fortschritt der KI von entscheidender Bedeutung. Denn KI-Modelle entwickeln sich ebenso weiter wie die Fähigkeiten und Reichweite von GenAI-basierten Anwendungen“, zitiert Seagates Pressemitteilung Bob O’Donnell, den Präsidenten von TECHnalysis Research.

„Die HAMR-basierten Mozaic-Produkte von Seagate bieten die Skalierbarkeit, Leistung und

Effizienz, die Kunden benötigen, um das Potenzial ihrer Daten auszuschöpfen,“ erklärt wiederum Dave Mosley, Vorsitzender und CEO von Seagate.

Der Konkurrenz einen Schritt voraus

Seagate ist nach wie vor der einzige HDD-Hersteller, der HAMR-Festplatten auf den Markt gebracht hat – und das obwohl die Technik schon reichlich Verspätung hat.

Doch auch bei WD und Toshiba spielt HAMR künftig eine Rolle. WD wurde jüngst konkreter und kündigte seinerseits für den späteren Jahresverlauf seine ersten HDDs mit HAMR-Technik an. Dass diese ebenfalls bis zu 44 TB erreichen sollen (allerdings auf 11 Scheiben), ist womöglich kein Zufall. Die breite Verfügbarkeit wird aber voraussichtlich erst 2027 gegeben sein.

Während Seagate voll und ganz auf HAMR setzt, fährt WD aber vorerst zweigleisig: Parallel werden die PMR-Festplatten (ePMR) weiterentwickelt, aus denen WD noch bis zu 60 TB herauskitzeln will.

Die Redaktion hat Informationen in diesem Artikel von Seagate unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Social Mediavor 3 Wochen

Social Mediavor 3 WochenCommunity Management zwischen Reichweite und Verantwortung

-

Social Mediavor 1 Tag

Social Mediavor 1 TagCommunity Management und Zielgruppen-Analyse: Die besten Insights aus Blog und Podcast

-

Künstliche Intelligenzvor 2 Wochen

Top 10: Die beste kabellose Überwachungskamera im Test – Akku, WLAN, LTE & Solar

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenSyncthing‑Fork unter fremder Kontrolle? Community schluckt das nicht

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenGame Over: JetBrains beendet Fleet und startet mit KI‑Plattform neu

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights